En los últimos años, el costo de capacitación de los modelos de idiomas grandes se ha mantenido alto, lo que se ha convertido en un factor importante que restringe el desarrollo de la IA. Cómo reducir los costos de capacitación y mejorar la eficiencia se ha convertido en el foco de la atención de la industria. Los investigadores de la Universidad de Harvard y Stanford han adoptado un enfoque diferente y han comenzado con la precisión de la capacitación de modelos para explorar un método de capacitación rentable. Descubrieron que al reducir la precisión del modelo, la cantidad de cálculo puede reducirse efectivamente e incluso mejorar el rendimiento del modelo en algunos casos. Este estudio proporciona nuevas ideas para optimizar la capacitación en modelos de idiomas y también señala la dirección para el futuro desarrollo de IA.

En el campo de la inteligencia artificial, cuanto mayor sea la escala, más fuerte es la capacidad. Para buscar un modelo de idioma más poderoso, las principales empresas de tecnología están apilando locamente los parámetros del modelo y los datos de capacitación, pero encuentran que el costo también ha aumentado. ¿No hay una forma rentable y eficiente de entrenar modelos de idiomas?

Investigadores de la Universidad de Harvard y Stanford recientemente publicaron un artículo que descubrieron que la precisión de la capacitación de modelos es como una clave oculta que desbloquea la "contraseña de costo" de la capacitación en modelos de idiomas.

¿Qué es la precisión del modelo? Los modelos tradicionales de aprendizaje profundo generalmente se entrenan utilizando números de puntos flotantes de 32 bits (FP32), pero en los últimos años, con el desarrollo de hardware, use tipos numéricos de precisión más bajo, como números de puntos flotantes de 16 bits (FP16) o 8 bits de 8 bits La capacitación de Integers (INT8) se ha vuelto posible.

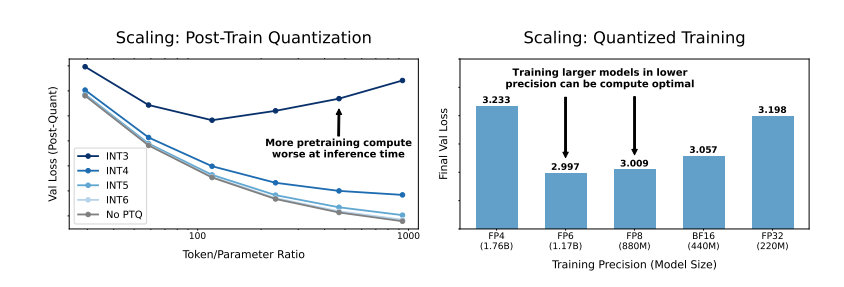

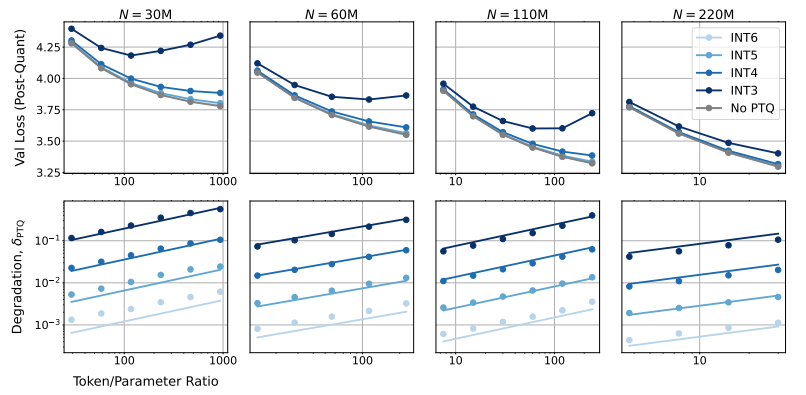

Entonces, ¿qué impacto reducirá la precisión del modelo en el rendimiento del modelo? A través de una gran cantidad de experimentos, los investigadores analizaron los cambios en el costo y el rendimiento de la capacitación e inferencia del modelo con una precisión diferente, y propusieron un nuevo conjunto de reglas de escala de "percepción de precisión".

Descubrieron que el entrenamiento con menor precisión puede reducir efectivamente el "número de parámetros efectivos" del modelo, reduciendo así la cantidad de cálculo requerida para la capacitación. Esto significa que bajo el mismo presupuesto computacional, podemos capacitar a modelos más grandes, o a la misma escala, usar una precisión más baja puede ahorrar muchos recursos informáticos.

¡Aún más sorprendente, los investigadores también encontraron que, en algunos casos, el entrenamiento con menor precisión puede mejorar el rendimiento del modelo! fase, el modelo será más robusto para la reducción en la precisión de la cuantización, mostrando así un mejor rendimiento en la fase de inferencia.

Entonces, ¿qué precisión deberíamos elegir capacitar al modelo?

El entrenamiento tradicional de precisión de 16 bits puede no ser la mejor opción. Su investigación muestra que la precisión de 7-8 bits puede ser una opción más rentable.

No es un movimiento acantilado para perseguir la capacitación de precisión ultra baja (como 4 bits). Debido a que con una precisión extremadamente baja, el número de parámetros efectivos del modelo disminuirá bruscamente, para mantener el rendimiento, necesitamos aumentar significativamente el tamaño del modelo, lo que conducirá a mayores costos informáticos.

La precisión óptima de entrenamiento puede variar para modelos de diferentes tamaños. Para los modelos que requieren una gran cantidad de "sobreentrenamiento", como la serie LLAMA-3 y GEMMA-2, el entrenamiento con mayor precisión puede ser más rentable.

Este estudio proporciona una perspectiva completamente nueva para que podamos comprender y optimizar la capacitación del modelo de idioma. Nos dice que la elección de precisión no es estática, pero debe intercambiarse en función del tamaño específico del modelo, el volumen de datos de capacitación y los escenarios de aplicaciones.

Por supuesto, este estudio también tiene algunas limitaciones. Por ejemplo, el modelo que usan es relativamente pequeño y los resultados experimentales pueden no estar directamente generalizados a modelos más grandes. Además, solo se centraron en la función de pérdida del modelo y no evaluaron el rendimiento del modelo en tareas aguas abajo.

Sin embargo, este estudio es de gran importancia. Revela la compleja relación entre la precisión del modelo y el rendimiento del modelo y los costos de capacitación, y nos proporciona información valiosa para que diseñemos y capacitemos modelos de lenguaje más fuertes y económicos en el futuro.

Documento: https://arxiv.org/pdf/2411.04330

En resumen, este estudio proporciona nuevas ideas y métodos para reducir los costos de capacitación de modelos de idiomas grandes y proporciona un valor de referencia importante para el desarrollo futuro del campo de inteligencia artificial. Aunque existen algunas limitaciones en la investigación, la regla de escala de la "percepción de precisión" que propone y la discusión en profundidad de la relación entre la precisión del modelo y el costo y el rendimiento tienen importantes importancia teórica y práctica de guía.