Beijing Zhipu Huazhang Technology Co., Ltd. ha lanzado el modelo de código abierto Cogvideox V1.5, que ha realizado avances significativos en el campo de la generación de videos. Después de su lanzamiento a principios de agosto, la serie Cogvideox se ha convertido rápidamente en el foco de la industria con su tecnología líder y características amigables para los desarrolladores. Esta actualización ha traído muchas mejoras, que incluyen el apoyo a la generación de videos más largos y de mayor definición, así como una mejora significativa en la calidad y la comprensión semántica del video de generación de imágenes, proporcionando a los usuarios una mejor experiencia de generación de videos de IA. Lo que vale la pena señalar más es que la nueva versión integra la plataforma Qingying y el modelo de efecto de sonido Cogsound, mejorando aún más el ecosistema de generación de videos.

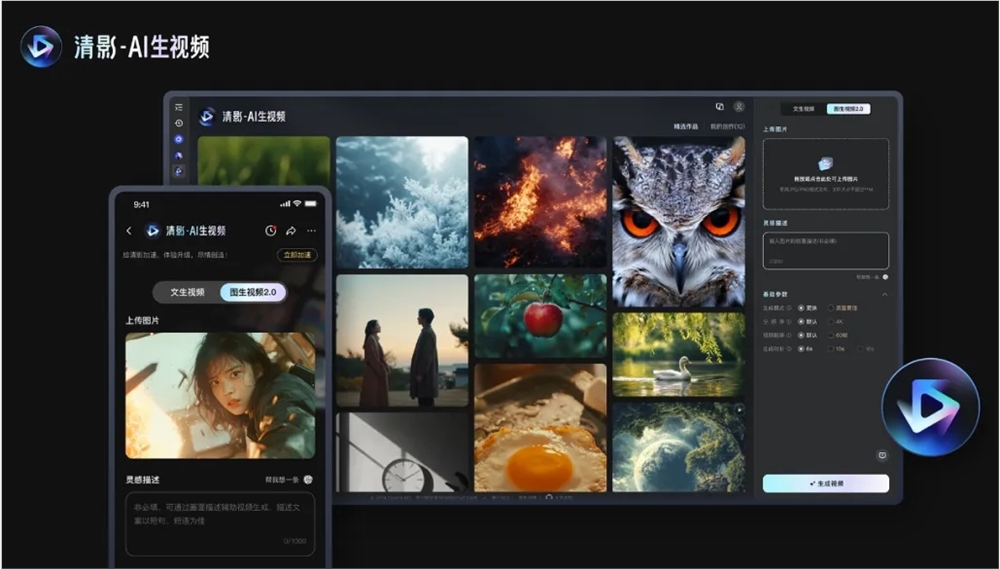

El contenido de este código abierto incluye dos modelos: Cogvideox V1.5-5b y Cogvideox V1.5-5b-I2V. La nueva versión también se lanzará en la plataforma Qingying simultáneamente, y se combinará con el modelo de efecto de sonido Cogsound recientemente lanzado para proporcionar una mejora de la calidad, soporte de resolución de ultra alta definición, proporciones variables para adaptarse a diferentes escenarios de reproducción, canal múltiple, múltiples canales, salida y videos de IA con efectos de sonido.

A nivel técnico, Cogvideox V1.5 filtra datos de video que carece de conectividad dinámica a través de un marco de filtrado automatizado, y utiliza un modelo de comprensión de video de extremo a extremo, con la aplicación de COGVLM2 para generar descripciones precisas de contenido de video, mejorar la comprensión de texto y el cumplimiento de la instrucción capacidades. Además, la nueva versión adopta un autoencoder de variacional tridimensional (VAE 3D) eficiente para resolver el problema de la coherencia de contenido y desarrolla independientemente una arquitectura de transformador que integra texto, tiempo y espacio tridimensionales, cancele el módulo de atención cruzada tradicional tradicional y la tecnología de normalización de la capa adaptativa experta optimiza la utilización de la información de paso de tiempo en el modelo de difusión.

En términos de entrenamiento, Cogvideox V1.5 construye un marco de entrenamiento de modelo de difusión eficiente y logra un entrenamiento rápido de secuencias de video largas a través de una variedad de técnicas de informática y optimización de tiempo paralelas. La compañía dijo que han verificado la efectividad de la ley de escala en el campo de la generación de videos y planea expandir el volumen de datos y la escala de modelos en el futuro, explorar las arquitecturas de modelos innovadoras para comprimir de manera más eficiente la información de video e integrar mejor el texto y el contenido de video.

Código: https://github.com/thudm/cogvideo

Modelo: https://huggingface.co/thudm/cogvideox1.5-5b-sat

El código abierto de Cogvideox V1.5 proporciona un nuevo impulso para el desarrollo de la tecnología de generación de videos y proporciona a los desarrolladores herramientas más poderosas. La innovación tecnológica continua y el espíritu de código abierto de Zhipu Huazhang son dignos de reconocimiento, y vale la pena esperar las perspectivas de aplicaciones futuras de este modelo. Esperamos aplicaciones más innovadoras basadas en COGVideox V1.5.