El equipo de Shanghai AI Lab ha abierto la fuente de la versión de LLAMA del proyecto O1, que es un proyecto de réplica de código abierto para la herramienta de resolución de problemas Operai Olympiad O1. El proyecto utiliza tecnologías avanzadas como la búsqueda de árboles de Monte Carlo y el aprendizaje de refuerzo para lograr resultados notables en responder preguntas de la Olimpiada Matemática, y su rendimiento incluso excede el de algunas soluciones comerciales de código cerrado. El código abierto del proyecto proporciona a los desarrolladores recursos de aprendizaje valiosos y una base de investigación, y también promueve el desarrollo adicional de la aplicación de la inteligencia artificial en el campo de las matemáticas. Este proyecto incluye conjuntos de datos previamente capacitados, modelos previamente capacitados y códigos de capacitación de aprendizaje de refuerzo, etc., y utiliza una variedad de tecnologías de optimización, incluidos Lora y PPO, con el objetivo de mejorar la capacidad del modelo en el razonamiento matemático.

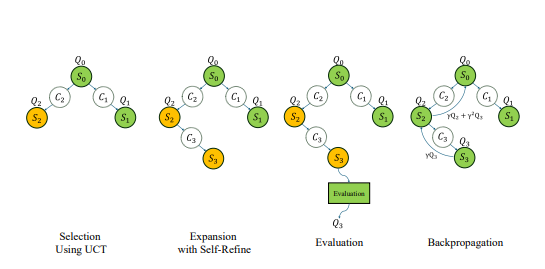

Recientemente, el equipo de Shanghai AI Lab lanzó la versión LLAMA del Proyecto O1, con el objetivo de replicar la herramienta de resolución de problemas Olympiad de Openai O1. El proyecto adopta una variedad de tecnologías avanzadas, que incluyen la búsqueda de árboles de Monte Carlo, el aprendizaje de refuerzo de auto juego, PPO y el paradigma de doble estrategia de Alphago Zero, que ha atraído la atención generalizada de la comunidad de desarrolladores.

Mucho antes del lanzamiento de la serie O1 de Operai, el equipo de laboratorio de Shanghai AI comenzó a explorar el uso de la búsqueda de árboles de Monte Carlo para mejorar la capacidad matemática de los modelos grandes. Después del lanzamiento de O1, el equipo actualizó aún más el algoritmo, se centró en el problema de la Olimpiada de Matemáticas, y lo desarrolló como una versión de código abierto del proyecto Operai Strawberry.

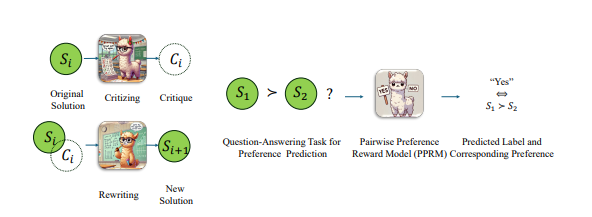

Para mejorar el rendimiento del modelo de LLAMA en problemas de la Olimpiada Matemática, el equipo adoptó una estrategia de optimización emparejada, es decir, no dar directamente el puntaje absoluto de la respuesta, sino comparar las ventajas y desventajas relativas de las dos respuestas. Con este enfoque, han hecho un progreso significativo en los puntos de referencia AIME2024 más difíciles. Entre las 30 preguntas de prueba, el modelo optimizado se realizó correctamente 8, mientras que el modelo original de instrucciones LLAMA-3.1-8B se realizó correctamente 2. Este logro supera a otras soluciones comerciales de código cerrado además de la previa O1 y O1-Mini.

A finales de octubre, el equipo anunció un progreso significativo en la replicación de OpenAI O1 basada en la arquitectura Alphago Zero, permitiendo con éxito que el modelo obtenga una capacidad de pensamiento avanzada a través de la interacción con el árbol de búsqueda durante el proceso de aprendizaje sin anotación manual. En menos de una semana, se abrió el proyecto.

En la actualidad, el contenido de código abierto de la versión O1 de LLAMA incluye: conjuntos de datos previamente capacitados, modelos previamente capacitados y código de entrenamiento de aprendizaje de refuerzo. Entre ellos, el conjunto de datos "OpenLongCot-Pretrain" contiene más de 100,000 datos de cadena de pensamiento de larga data, cada datos contiene un proceso completo de razonamiento de problemas matemáticos, que incluye contenido de pensamiento, resultados de puntuación, descripción del problema, coordenadas de gráficos, proceso de cálculo, deducción de conclusión y otro Los enlaces de inferencia completos, así como la crítica y la verificación de cada paso de inferencia, proporcionan evaluación y orientación para el proceso de inferencia. Después de continuar previamente en este conjunto de datos, el modelo puede leer y generar procesos de cadena de pensamiento larga como O1.

Aunque el proyecto se llama Llama-O1, el modelo previamente capacitado actualmente proporcionado por el funcionario se basa en Gemma2 de Google. Según el modelo previamente capacitado, los desarrolladores pueden continuar realizando la capacitación en aprendizaje de refuerzo. El proceso de capacitación incluye: la búsqueda de árboles de árbol de Monte Carlo para generar experiencia en un búfer de reproducción de experiencia prioritaria; Algunas tecnologías clave también se utilizan en el código de entrenamiento, incluido el uso de LORA para el ajuste fino de los parámetros eficientes, el uso del algoritmo PPO como un método de optimización de estrategia, implementando el algoritmo GAE para calcular funciones ventajosas y usar la reproducción de experiencia prioritaria para mejorar la eficiencia de la capacitación.

Vale la pena señalar que el código LLAMA-O1 se publicó en la cuenta GitHub llamada SimpleBerry. De otras cuentas relacionadas con SimpleBerry e información oficial del sitio web, solo se puede ver que su naturaleza es un laboratorio de investigación, pero no se divulga más información sobre la dirección de la investigación.

Además de Llama-O1, otro proyecto de réplica O1 de progreso público es O1-Journey del equipo de la Universidad de Shanghai Jiaotong. El equipo publicó su primer informe de progreso a principios de octubre, presentando el innovador paradigma de aprendizaje de viaje y el primer modelo para integrar con éxito la búsqueda y el aprendizaje en el razonamiento matemático. El equipo de desarrollo central de O1-Journey está compuesto principalmente por estudiantes universitarios junior y senior en la Universidad de Shanghai Jiaotong, así como a los estudiantes de doctorado de primer año del Laboratorio de Investigación de Inteligencia General (Laboratorio General de Investigación de Inteligencia Artificial). en la Universidad de Shanghai Jiaotong.

Dirección en papel: https://arxiv.org/pdf/2410.02884

https://arxiv.org/pdf/2406.07394

El código abierto de la versión de LLAMA O1 marca un progreso importante en el campo de la resolución de problemas de IA Matemáticas y también proporciona una base sólida para futuras investigaciones y aplicaciones. Esperamos tener logros más innovadores basados en este proyecto en el futuro.