US Startup Sense Sensors ha lanzado un modelo de reconocimiento de voz de código abierto llamado Moonshine, con el objetivo de mejorar la eficiencia del procesamiento de datos de audio. En comparación con el Whisper de OpenAI, Moonshine es más económico en la computación de los recursos y ha aumentado la velocidad de procesamiento en cinco veces, especialmente para el hardware y las aplicaciones en tiempo real con recursos. Su arquitectura flexible y su ajuste dinámico del tiempo de procesamiento de acuerdo con la longitud de audio lo hacen sobresaliente al procesar clips de audio cortos y reducir efectivamente la sobrecarga de procesamiento. Moonshine proporciona dos versiones, pequeñas y base, con parámetros de 27.1 millones y 61.5 millones, respectivamente, que son mejores que el rendimiento de modelos similares en la utilización de recursos.

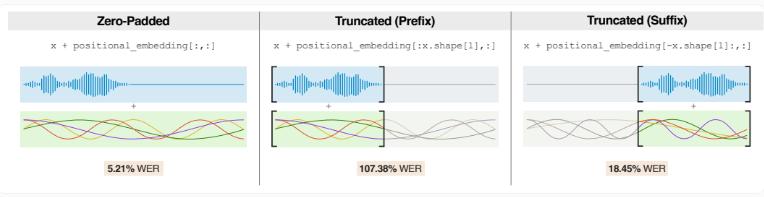

A diferencia de Whisper que divide el audio en clips fijos de 30 segundos, Moonshine ajusta el tiempo de procesamiento de acuerdo con la longitud real de audio. Esto hace que funcione bien al manejar clips de audio más cortos, reduciendo la sobrecarga de procesamiento debido al acolchado cero.

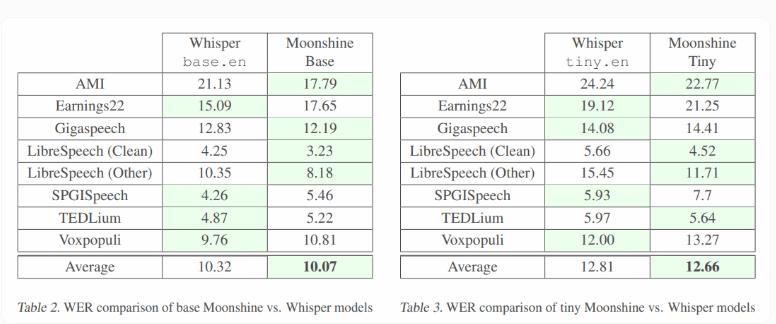

Moonshine tiene dos versiones: la pequeña versión pequeña tiene un volumen de parámetros de 27.1 millones, y la versión base grande tiene un volumen de parámetros de 61.5 millones. En contraste, los parámetros modelo similares de OpenAI son más grandes, con Whisper Tiny.en es 37.8 millones y la base es de 72.6 millones.

Los resultados de las pruebas muestran que el pequeño modelo de Moonshine es comparable a Whisper en términos de precisión y consume menos recursos informáticos. Ambas versiones de Moonshine son más bajas que susurros en la tasa de error de palabras (WER) para varios niveles de audio y ruido de fondo, mostrando un rendimiento fuerte.

El equipo de investigación señaló que Moonshine todavía tiene margen de mejora al procesar chips de audio extremadamente cortos (menos de un segundo). Estos audios breves representan una pequeña proporción de datos de capacitación, y el aumento de la capacitación de dichos clips de audio puede mejorar el rendimiento del modelo.

Además, las capacidades fuera de línea de Moonshine abren nuevos escenarios de aplicación, y las aplicaciones que anteriormente no estaban disponibles debido a limitaciones de hardware ahora son factibles. A diferencia de Whisper, que requiere un mayor consumo de energía, Moonshine es adecuado para correr en teléfonos inteligentes y pequeños dispositivos como Raspberry Pi. Los sensores útiles es usar Moonshine para desarrollar su traductor de inglés-español Torre.

El código de Moonshine se ha lanzado en GitHub, y los usuarios deben tener en cuenta que los sistemas de transcripción de IA como Whisper pueden experimentar errores. Algunos estudios han demostrado que Whisper tiene un 1,4% de posibilidades de información falsa al generar contenido, especialmente para personas con barreras lingüísticas, con tasas de error más altas.

Entrada del proyecto: https://github.com/useefussensors/moonshine

Puntos clave:

Moonshine es un modelo de reconocimiento de voz de código abierto que procesa cinco veces más rápido que el susurro de Operai.

Este modelo puede ajustar el tiempo de procesamiento de acuerdo con la longitud de audio, especialmente adecuada para clips de audio cortos.

Moonshine admite la operación fuera de línea y es adecuado para su uso con recursos limitados.

En resumen, Moonshine aporta nuevas posibilidades a la tecnología de reconocimiento de voz con su velocidad de procesamiento eficiente, arquitectura flexible y baja demanda de recursos, especialmente en dispositivos con recursos y escenarios de aplicaciones en tiempo real. Sus características de código abierto también facilitan a los desarrolladores mejorar y aplicar, y vale la pena prestar atención y esperamos.