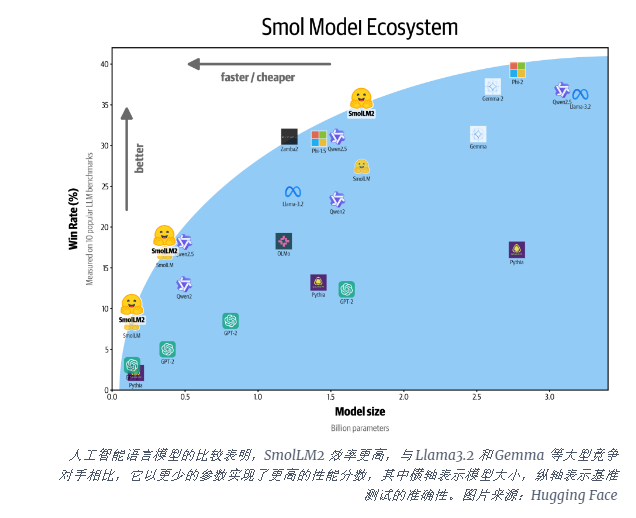

Hugging Face ha lanzado un nuevo modelo de idioma compacto, SMollM2, que es un gran avance. SMOLLM2 tiene tres versiones de tamaño de parámetro diferentes que proporcionan un rendimiento potente incluso en dispositivos con recursos limitados, lo cual es de gran importancia para las aplicaciones de informática y dispositivos móviles de borde. Se destaca en múltiples puntos de referencia, superando modelos similares, demostrando sus ventajas en el razonamiento científico y las tareas de sentido común. La licencia de código abierto y Apache 2.0 de SMOLLM2 también facilitan el acceso y aplicar.

Hugging Face lanzó hoy SMOLLM2, un nuevo conjunto de modelos de lenguaje compacto que logran un rendimiento impresionante y requieren mucho menos recursos informáticos que los modelos grandes. El nuevo modelo se lanza bajo la licencia Apache 2.0 y viene en tres tamaños: parámetros de 135m, 360m y 1.7b) adecuados para la implementación en teléfonos inteligentes y otros dispositivos de borde con potencia y memoria de procesamiento limitadas.

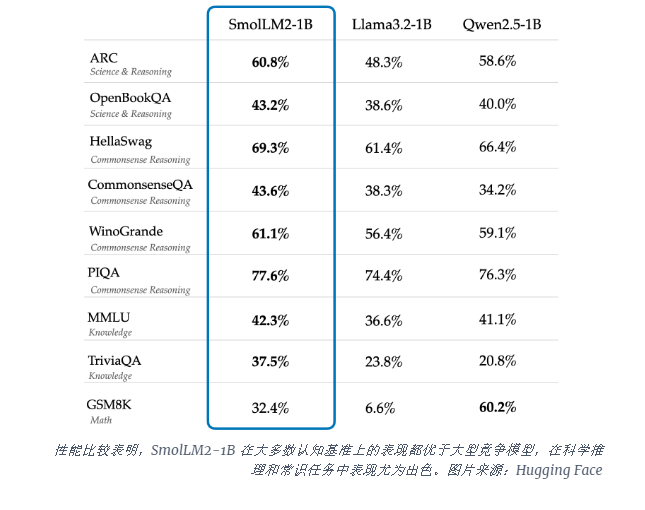

El modelo SMOLLM2-1B supera al modelo Meta Llama1B en varios puntos de referencia clave, especialmente en el razonamiento científico y las tareas de sentido común. Este modelo supera a los grandes modelos competitivos en la mayoría de los puntos de referencia cognitivos, utilizando una combinación diversa de conjuntos de datos que incluyen FineWeb-EDU y conjuntos de datos de codificación especializados.

El lanzamiento de SMOLLM2 llega en un momento crítico cuando la industria de la IA está luchando por hacer frente a las necesidades informáticas para ejecutar modelos de idiomas grandes (LLM). Si bien compañías como OpenAI y Anthrope continúan empujando los límites del tamaño del modelo, existe un reconocimiento creciente de la necesidad de una IA eficiente y liviana que pueda funcionar localmente en los dispositivos.

SMOLLM2 ofrece un enfoque diferente para llevar capacidades de IA potentes directamente a los dispositivos personales, señalando el futuro donde más usuarios y empresas pueden usar herramientas de IA avanzadas, no solo gigantes tecnológicos con grandes centros de datos. Estos modelos admiten una gama de aplicaciones, incluidas reescrituras de texto, resumen y llamadas de funciones, adecuadas para la implementación en escenarios donde las restricciones de privacidad, latencia o conexión hacen que las soluciones de IA basadas en la nube sean poco prácticas.

Si bien estos modelos más pequeños todavía tienen limitaciones, representan parte de una tendencia amplia en modelos de IA más eficientes. El lanzamiento de SMOLLM2 muestra que el futuro de la inteligencia artificial puede no solo pertenecer a modelos más grandes, sino a arquitecturas más eficientes que pueden proporcionar un rendimiento poderoso con menos recursos.

La aparición de SMOLLM2 ha abierto nuevas posibilidades para aplicaciones de IA livianas, lo que indica que la tecnología de IA se utilizará más ampliamente en varios dispositivos y escenarios, lo que brinda a los usuarios una experiencia más conveniente y eficiente. Sus características de código abierto también han promovido el mayor desarrollo e innovación de la comunidad de IA. En el futuro, se espera que veamos modelos de IA más eficientes y compactos emergentes, promoviendo la popularización y el avance de las tecnologías de IA.