Los equipos de investigación de Meta Fair, UC Berkeley y la Universidad de Nueva York han colaborado en el desarrollo de una nueva tecnología llamada Optimización de preferencias de pensamiento (TPO) para mejorar significativamente el cumplimiento de las instrucciones y la calidad de la respuesta en modelos de idiomas grandes (LLM). A diferencia de los LLM tradicionales que dan respuestas directamente, la tecnología TPO permite que los modelos piensen y reflexionen internamente antes de responder, generando así respuestas más precisas y coherentes. Esta innovación guía el modelo para optimizar su proceso de pensamiento sin mostrar al usuario los pasos intermedios, mejorando en última instancia la calidad de las respuestas a través de un método de razonamiento mejorado de pensamiento en cadena (COT).

El núcleo de la tecnología TPO es el método de razonamiento mejorado de pensamiento en cadena (COT). Este enfoque alienta a los modelos a "pensar y responder" durante la capacitación, ayudándoles a construir un proceso de pensamiento interno más organizado antes de proporcionar la respuesta final. Las señales tradicionales de cuna a veces pueden conducir a una precisión reducida y son bastante difíciles de entrenar debido a la falta de pasos de pensamiento claros. Y TPO supera con éxito estos desafíos al permitir que los modelos optimicen y simplifiquen su proceso de pensamiento sin exponer los pasos intermedios a los usuarios.

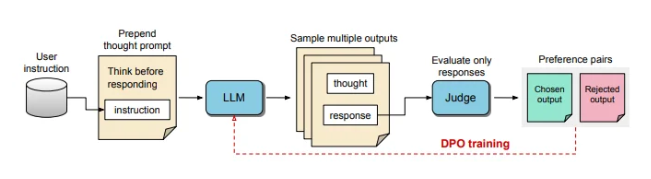

Durante el proceso de capacitación de TPO, primero solicite al modelo de idioma grande que genere múltiples ideas y luego resuelva la respuesta final. Luego, estas salidas son evaluadas por un modelo de "jueces" para elegir las respuestas de mejor rendimiento y peor de rendimiento. Estos resultados de la evaluación se utilizan como pares de "elección" y "rechazar" para la optimización directa de preferencias (DPO) para mejorar continuamente la calidad de respuesta del modelo.

Al ajustar las indicaciones de capacitación, TPO alienta al modelo a pensar internamente antes de responder. Este proceso guía el modelo para optimizar sus respuestas para que sea más clara y más relevante. En última instancia, la evaluación es realizada por un modelo de juicio basado en LLM que solo obtiene la respuesta final, lo que ayuda al modelo a mejorar la calidad de las respuestas independientemente de los pasos de pensamiento oculto. TPO también utiliza la optimización de preferencia directa para crear respuestas preferidas y de rechazo que contienen pensamiento oculto, y después de múltiples rondas de entrenamiento, refine aún más el proceso interno del modelo.

En puntos de referencia para Alpacaeval y Arena-Hard, el método TPO superó a la línea de base de respuesta tradicional y fue mejor que el modelo LLAMA-3-8B-Instructo de "consejos de pensamiento". El entrenamiento iterativo de este método optimiza las capacidades de generación de pensamiento, superando en última instancia múltiples modelos de referencia. Vale la pena mencionar que TPO no solo es adecuado para tareas lógicas y matemáticas, sino que también hace grandes esfuerzos en campos creativos, como las instrucciones de marketing y de salud para seguir las tareas.

El experto en AI y la robótica, Karan Verma, compartieron sus puntos de vista sobre el concepto de "pensamiento LLM" en la plataforma social X, diciendo que estaba muy entusiasmado y esperaba el potencial de esta innovación en aplicaciones médicas que pueden traer más pacientes terapéuticos. .

Este proceso de pensamiento interno estructurado permite que el modelo procese instrucciones complejas de manera más efectiva, ampliando aún más su aplicación en áreas que requieren razonamiento de niveles múltiples y una comprensión meticulosa sin la necesidad de que los humanos proporcionen datos de pensamiento específicos. Este estudio muestra que TPO tiene el potencial de hacer que los modelos de lenguaje grandes sean más flexibles y eficientes en diversos contextos, adecuados para áreas donde existen altos requisitos para la flexibilidad y la profundidad de la generación de respuesta.

Los avances innovadores en la tecnología TPO han traído una mayor inferencia y capacidades de comprensión a los grandes modelos de idiomas, abriendo nuevas posibilidades para su aplicación en varios campos, especialmente en tareas que requieren procesos de pensamiento complejos, vale la pena esperar el desarrollo futuro.