Meta AI, junto con investigadores de la Universidad de California, Berkeley y la Universidad de Nueva York, ha desarrollado un nuevo enfoque llamado Optimización de preferencias de pensamiento (TPO) que tiene como objetivo mejorar significativamente la calidad de respuesta de los modelos de idiomas grandes (LLM). A diferencia de los métodos tradicionales que se centran solo en la respuesta final, TPO permite que el modelo piense internamente antes de generar la respuesta, lo que resulta en una respuesta más precisa y coherente. Este método de razonamiento de la cadena de pensamiento mejorado tecnología (COT) supera las deficiencias de la baja precisión y la dificultad del método de COT anterior en la capacitación a través de la optimización y la racionalización del proceso de pensamiento interno del modelo, y finalmente genera respuestas de mayor calidad y de muchas maneras excelentes. cada prueba de referencia.

A diferencia de los modelos tradicionales que se centran solo en la respuesta final, el método TPO permite que el modelo piense internamente antes de generar una respuesta, lo que resulta en respuestas más precisas y coherentes.

Esta nueva tecnología combina un método de razonamiento mejorado de pensamiento (cot). Durante el proceso de capacitación, el método alienta al modelo a "pensar" antes de responder, ayudándolo a construir un proceso de pensamiento interno más sistemático. Las indicaciones de cuna directas anteriores a veces reducen la precisión, y el proceso de capacitación es difícil debido a la falta de pasos de pensamiento claros. TPO supera estas limitaciones al permitir que el modelo optimice y optimice su proceso de pensamiento, y no muestra pasos de pensamiento intermedios frente al usuario.

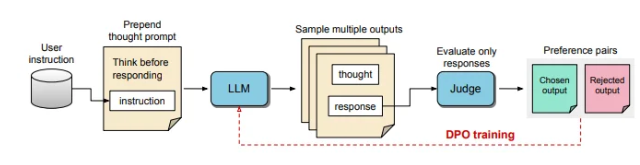

En el proceso de TPO, se solicita a los modelos de lenguaje grandes que generen múltiples procesos de pensamiento, y luego estas salidas se muestrean y evalúan antes de formar la respuesta final. Luego, un modelo de evaluación obtendrá la salida para determinar las respuestas óptimas y peores. Al usar estas salidas como elección y rechazo para la optimización de preferencia directa (DPO), este método de entrenamiento iterativo mejora la capacidad del modelo para generar respuestas más relevantes y de alta calidad, mejorando así los resultados generales.

En este método, se ajustan las indicaciones de capacitación, alentando al modelo a pensar internamente antes de responder. La respuesta final evaluada es calificada por un modelo de evaluación basado en LLM, que permite al modelo mejorar la calidad basada únicamente en la efectividad de la respuesta sin considerar los pasos de pensamiento implícitos. Además, TPO utiliza la optimización directa de preferencias para crear respuestas de preferencia y rechazo que contienen un pensamiento implícito, y refina aún más el proceso interno del modelo a través de múltiples ciclos de entrenamiento.

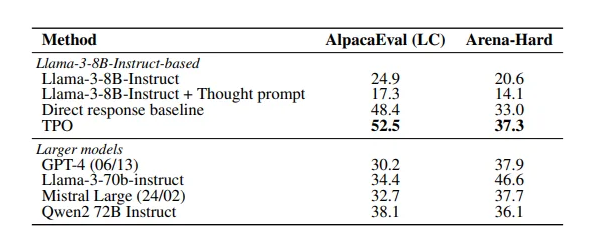

Los resultados del estudio muestran que el método TPO funcionó bien en múltiples puntos de referencia, superando una variedad de modelos existentes. Este enfoque no solo se aplica a tareas lógicas y matemáticas, sino que también muestra potencial en campos creativos como tareas de seguimiento de comandos de marketing y salud.

Documento: https://arxiv.org/pdf/2410.10630

Puntos clave:

La tecnología TPO mejora la capacidad de pensamiento de los grandes modelos de idiomas antes de generar respuestas, asegurando que las respuestas sean más precisas.

A través del razonamiento mejorado de la cadena de pensamiento, el modelo puede optimizar y optimizar su proceso de pensamiento interno y mejorar la calidad de la respuesta.

TPO es adecuado para una variedad de campos, no solo para tareas lógicas y matemáticas, sino también para creatividad y salud.

En resumen, el método TPO proporciona una nueva idea para la mejora del rendimiento de los modelos de idiomas grandes. Los enlaces en papel son convenientes para que los lectores obtengan información sobre sus detalles técnicos y resultados experimentales.