Los últimos procesadores de la serie Strix Point APU de AMD muestran ventajas significativas en las aplicaciones de AI Big Language Model (LLM) y superan la serie Intel Lunar Lake. Diseñada para plataformas móviles, la serie de procesadores está diseñada para proporcionar un mayor rendimiento y una menor latencia para satisfacer la creciente demanda de cargas de trabajo de IA. AMD enfatiza el rendimiento sobresaliente de los procesadores Ryzen AI en el manejo de las tareas LLM, y lanza herramientas LM Studio para simplificar el uso de modelos de idiomas grandes y los umbrales de usuario más bajos.

Recientemente, AMD lanzó su última serie Strix Point APU, enfatizando el excelente rendimiento de esta serie en aplicaciones de AI Big Language Model (LLM), que excede con creces los procesadores de la Serie Lunar Lake de Intel. Con la creciente demanda de cargas de trabajo de IA, la competencia por el hardware se está volviendo cada vez más feroz. Para hacer frente al mercado, AMD ha lanzado procesadores AI diseñados para plataformas móviles, diseñados para un mayor rendimiento y menor latencia.

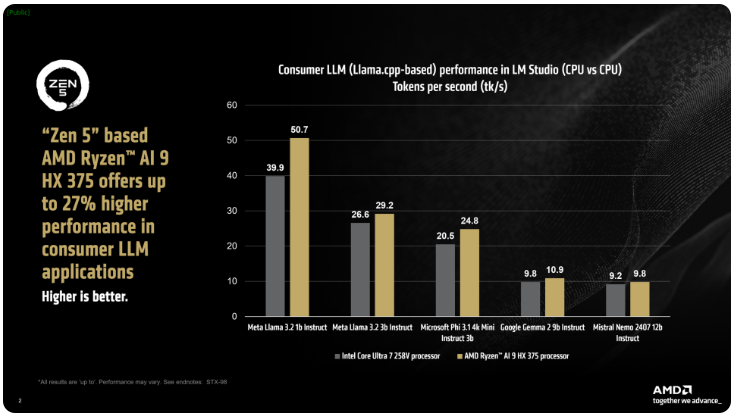

AMD dijo que los procesadores Ryzen AI300 de la serie IX Point pueden aumentar significativamente el número de tokens procesados por segundo cuando procesan tareas de AI LLM, y el Ryzen AI9375 tiene una mejora del rendimiento del 27% en comparación con el Core Ultra258V de Intel. Si bien el Core Ultra7V no es el modelo más rápido en la familia L Lake, su recuento de hilos y núcleo está cerca de los procesadores de lago lunar de gama alta, que muestra la competitividad de los productos AMD en esta área.

La herramienta LM Studio de AMD es una aplicación orientada al consumidor basada en el marco Llama.CPP, diseñada para simplificar el uso de modelos de idiomas grandes. Este marco optimiza el rendimiento de X86CPUS, y aunque no requiere que una GPU ejecute LLM, el uso de GPU puede acelerar aún más las velocidades de procesamiento. Según las pruebas, el Ryzen AI9HX375 puede lograr una latencia 35 veces menor en el modelo Meta Llama3.21b de instrucciones y procesar 50.7 tokens por segundo.

No solo eso, la APU de Strix Point también está equipada con una potente tarjeta gráfica integrada de Radeon basada en RDNA3.5, que descarga tareas a la IGPU a través de la API Ulkan, mejorando aún más el rendimiento de LLM. Utilizando la tecnología Change Graphics Memory (VGM), el procesador Ryzen AI300 puede optimizar la asignación de memoria, mejorar la eficiencia energética y, en última instancia, lograr una mejora del rendimiento de hasta el 60%.

En las pruebas de comparación, AMD utilizó la misma configuración en la plataforma Intel AI Playground y descubrió que el Ryzen AI9HX375 fue 87% más rápido en Microsoft Phi3.1 que el Core Ultra7258V y 13% más rápido en el modelo Mistral7B Instruct0.3. Sin embargo, los resultados serán aún más interesantes si se comparan con el núcleo insignia Ultra9288V en la gama Lunar Lake. Actualmente, AMD se centra en hacer que el uso de modelos de idiomas grandes sea más popular a través de LM Studio, con el objetivo de facilitar que comiencen más usuarios no técnicos.

Puntos clave:

AMD Strix Point APU mejora el rendimiento en un 27% sobre Intel Lunar Lake en aplicaciones AI LLM.

El Ryzen AI9HX375 realiza una latencia 3.5 veces menor en el modelo Meta Llama3.2.

La herramienta LM Studio está diseñada para hacer que el uso de modelos de idiomas grandes sea más fácil y adecuado para usuarios no técnicos.

En resumen, el fuerte rendimiento de la serie AMD Strix Point APU en el campo de aplicaciones de AI LLM y las herramientas de estudio LM fácil de usar indican el diseño y competitividad activos de AMD en el mercado de hardware de IA, lo que trae a los consumidores un más conveniente y experiencia eficiente de IA.