Rakuten Group lanzó su primer modelo de lenguaje grande japonés (LLM) Rakuten AI2.0 y el modelo de lenguaje pequeño (SLM) Rakuten AI2.0mini, con el objetivo de promover el desarrollo de la inteligencia artificial en Japón. Rakuten AI2.0 adopta una arquitectura de experto híbrido (MOE) y tiene ocho modelos expertos con 7 mil millones de parámetros. Rakuten AI2.0mini es un modelo compacto con 1,5 mil millones de parámetros, diseñados para la implementación del dispositivo de borde, teniendo en cuenta la rentabilidad y la facilidad de la aplicación. Ambos modelos son de código abierto y proporcionan versiones ajustadas y optimizadas por preferencias para admitir varias tareas de generación de texto.

Rakuten Group anunció el lanzamiento de su primer modelo de idioma grande japonés (LLM) y el modelo de lenguaje pequeño (SLM), llamado Rakuten AI2.0 y Rakuten AI2.0 Mini.

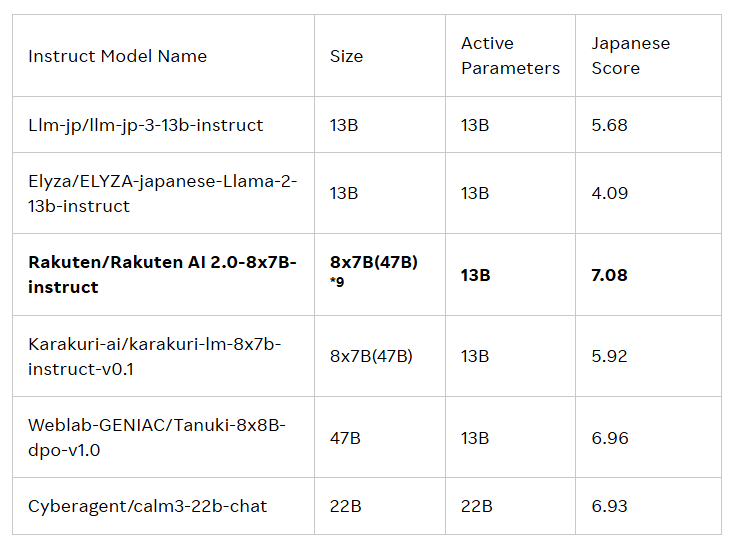

El lanzamiento de estos dos modelos está destinado a impulsar el desarrollo de la inteligencia artificial (IA) en Japón. Rakuten AI2.0 se basa en la arquitectura híbrida experta (MOE) y es un modelo de 8x7b que consta de ocho modelos con 7 mil millones de parámetros, cada uno que sirve como experto. Cada vez que se procesa el token de entrada, el sistema lo enviará a los dos expertos más relevantes, y el enrutador es responsable de seleccionarlo. Estos expertos y enrutadores entrenan constantemente juntos a través de una gran cantidad de datos bilingües japoneses e ingleses de alta calidad.

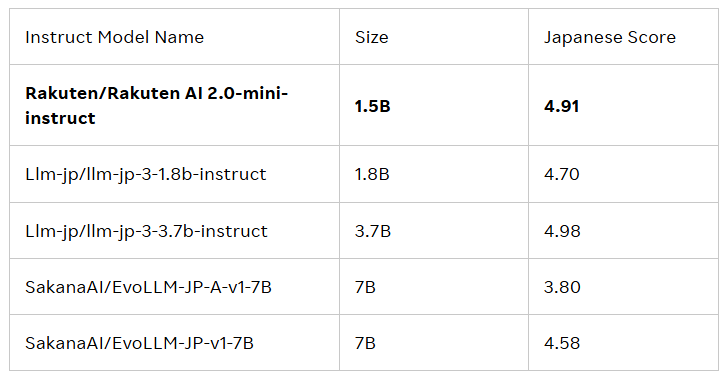

Rakuten AI2.0mini es un nuevo modelo denso con un volumen de parámetros de 1.500 millones, diseñado para la implementación de dispositivos de borde rentable y adecuado para escenarios de aplicación específicos. También está capacitado en datos mixtos en Japón y el Reino Unido, con el objetivo de proporcionar una solución conveniente. Ambos modelos han sido ajustados y preferidos, y han lanzado modelos básicos y modelos de instrucciones para apoyar a las empresas y profesionales en el desarrollo de aplicaciones de IA.

Todos los modelos están bajo el acuerdo de licencia Apache2.0, que los usuarios pueden obtener en la biblioteca oficial de abrazos de Rakuten Group incluyen la generación de texto, el resumen de contenido, la pregunta y la respuesta, la comprensión de texto y la construcción del sistema de diálogo. Además, estos modelos también pueden servir como base para otros modelos, que facilitan un mayor desarrollo y aplicación.

Cai Ting, Director de IA y Data en Rakuten Group, dijo: “Estoy extremadamente orgulloso de cómo nuestro equipo combina datos, ingeniería y ciencia para lanzar Rakuten AI2.0. Las empresas toman decisiones inteligentes, aceleran la realización del valor y abren nuevas posibilidades. "

Blog oficial: https://global.rakuten.com/corp/news/press/2025/0212_02.html

Puntos clave:

Rakuten Group lanza su primer modelo de idioma grande japonés (LLM) y el modelo de lenguaje pequeño (SLM), llamado Rakuten AI2.0 y Rakuten AI2.0 Mini.

Rakuten AI2.0 se basa en una arquitectura experta híbrida y tiene ocho modelos expertos con 7 mil millones de parámetros, comprometidos a procesar eficientemente datos bilingües japoneses e ingleses.

Todos los modelos están disponibles en la Biblioteca oficial de Face Rakuten, adecuado para una variedad de tareas de generación de texto y sirven como base para otros modelos.

En resumen, el lanzamiento de Rakuten AI2.0 y Rakuten AI2.0mini marcan otro progreso importante en Japón en el campo de los modelos de idiomas grandes. a su futura aplicación e impacto.