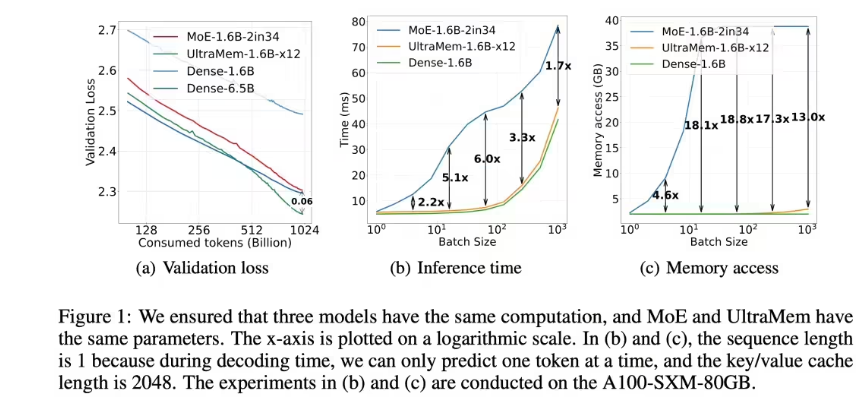

El equipo de Big Model Big Bytedance ha hecho un gran avance recientemente y ha desarrollado con éxito una nueva arquitectura de modelo escaso Ultramem. Esta arquitectura resuelve de manera innovadora el problema del acceso a la memoria de alto valor en la inferencia del modelo MOE, mejorando significativamente la velocidad y la eficiencia de la inferencia, y reduciendo el costo de inferencia. Si bien garantiza el efecto del modelo, Ultramem ha aumentado la velocidad de inferencia en 2-6 veces en comparación con MOE, y el costo de inferencia puede reducirse hasta en un 83%, proporcionando una nueva solución para la inferencia eficiente de modelos grandes y establecer las bases para la construcción de la construcción Modelos a gran escala.

Bytedance DoBao Big Model Team anunció hoy que ha desarrollado con éxito una nueva arquitectura de modelo escaso ultramem. que eso en MOE. Este avance innovador abre nuevas rutas para una inferencia eficiente de modelos grandes.

Con la premisa de garantizar el efecto del modelo, la arquitectura Ultramem resolvió con éxito el cuello de botella de acceso a la memoria en la inferencia de la arquitectura MOE. Los resultados experimentales muestran que bajo los mismos parámetros y condiciones de activación, Ultramem no solo tiene el efecto modelo mejor que el MOE, sino que también aumenta la velocidad de inferencia en 2-6 veces. Además, en la escala de tamaño de lote común, el costo de acceso a la memoria de Ultramem es casi equivalente al del modelo denso con el mismo volumen computacional, reduciendo significativamente el costo de inferencia.

El equipo de investigación capacitó al modelo Ultramem con una escala del valor de 20 millones. Este resultado verifica las excelentes características de escala de la arquitectura Ultramem y establece las bases técnicas para construir miles de millones de modelos de valor o expertos.

A medida que la escala de los grandes modelos continúa expandiéndose, el costo de la inferencia y la velocidad se han convertido en los factores clave que restringen su aplicación. Aunque la arquitectura MOE ha implementado el desacoplamiento computacional de los parámetros, su alta demanda de recuperación de memoria durante la inferencia da como resultado un aumento en la latencia. La propuesta de arquitectura ultramem resuelve efectivamente este problema y proporciona nuevas opciones técnicas para la aplicación a gran escala de modelos grandes.

El desarrollo exitoso de la arquitectura Ultramem marca un progreso significativo en la tecnología de inferencia de grandes modelos, proporciona un fuerte soporte técnico para la aplicación generalizada de grandes modelos en el futuro, y también indica que la efectividad de la gran modelo está a punto de llegar. Su excelente rendimiento y rentabilidad impulsarán la aplicación y el desarrollo de grandes modelos en más campos.