Según el relato oficial oficial del equipo modelo Big Doubao, bajo la investigación conjunta de la Universidad de Beijing Jiaotong y la Universidad de Ciencia y Tecnología de China, el modelo experimental de generación de videos "VideoWorld" propuesto por el equipo de modelos Big Doubao se abrió oficialmente recientemente.

Lo más destacado de este modelo es que ya no se basa en los modelos de idiomas tradicionales, sino que puede reconocer y comprender el mundo basado solo en información visual. Esta investigación innovadora se inspiró en el concepto del profesor Li Feifei de que "los niños pequeños pueden entender el mundo real sin confiar en el lenguaje" mencionado en su discurso TED.

"VideoWorld" realiza capacidades complejas de inferencia, planificación y toma de decisiones mediante el análisis y el procesamiento de grandes cantidades de datos de video. Los experimentos del equipo de investigación mostraron que el modelo logró resultados significativos con solo 300 m de parámetros. A diferencia de los modelos existentes que dependen de los datos del lenguaje o la etiqueta, VideoWorld puede aprender de forma independiente el conocimiento, especialmente en tareas complejas como origami y lazos de arco, que pueden proporcionar un método de aprendizaje más intuitivo.

Para verificar la efectividad de este modelo, el equipo de investigación estableció dos entornos experimentales: GO Battle y Robot Simulation Control. Como un juego altamente estratégico, GO puede evaluar de manera efectiva la capacidad de aprendizaje y razonamiento de reglas del modelo, mientras que las tareas de robot examinan el rendimiento del modelo en control y planificación. Durante la etapa de entrenamiento, el modelo establece gradualmente la capacidad de predecir imágenes futuras viendo una gran cantidad de datos de demostración de video.

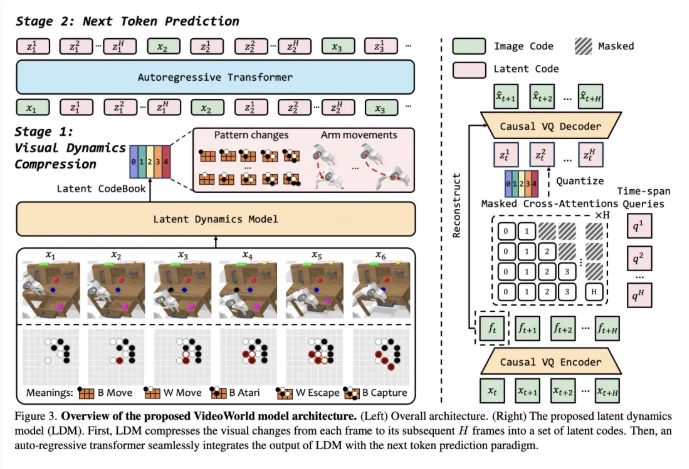

Para mejorar la eficiencia del aprendizaje de video, el equipo introdujo un modelo dinámico potencial (LDM) diseñado para comprimir los cambios visuales entre los marcos de video para extraer información crítica. Este método no solo reduce la información redundante, sino que también mejora la eficiencia de aprendizaje del modelo del conocimiento complejo. A través de esta innovación, VideoWorld demuestra habilidades sobresalientes en las tareas robóticas y incluso alcanza el nivel de GO profesional de cinco etapas.

Enlace en papel: https://arxiv.org/abs/2501.09781

Enlace del código: https://github.com/bytedance/videoworld

Página de inicio del proyecto: https://maverickren.github.io/videoworld.github.io

Puntos clave:

El modelo "VideoWorld" puede realizar el aprendizaje de conocimiento basado solo en la información visual y no depende de los modelos de idiomas.

El modelo demuestra excelentes capacidades de razonamiento y planificación en tareas de simulación de Robot y Robot.

El código y el modelo del proyecto han sido de origen abierto, y las personas de todos los ámbitos de la vida pueden participar en la experiencia y el intercambio.