Los investigadores y socios académicos de Meta AI han desarrollado un sistema innovador, MILS (solucionador multimodal iterativo de LLM), que enseña grandes modelos de idiomas para procesar imágenes, videos y audio sin capacitación especializada. MILS se basa en la capacidad natural de resolución de problemas de los modelos de lenguaje en lugar de grandes cantidades de entrenamiento de datos, que muestra sus ventajas únicas.

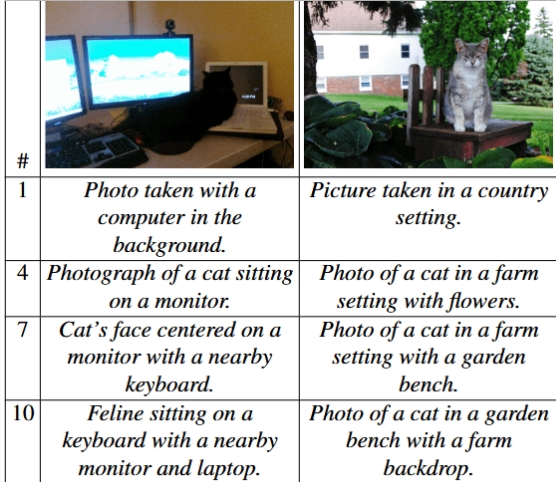

MILS funciona emparejando dos modelos de IA para realizar soluciones de tareas: uno es un "generador", responsable de proponer soluciones de tareas, y el otro es un "RatingR", utilizado para evaluar la efectividad de la solución generada. Los comentarios proporcionados por el anotador pueden ayudar al generador a optimizar continuamente la respuesta hasta que alcance un resultado satisfactorio. Por ejemplo, en la tarea de descripción de la imagen, MILS puede refinar gradualmente las descripciones de imágenes, describiendo así con precisión los detalles de la imagen en diferentes niveles.

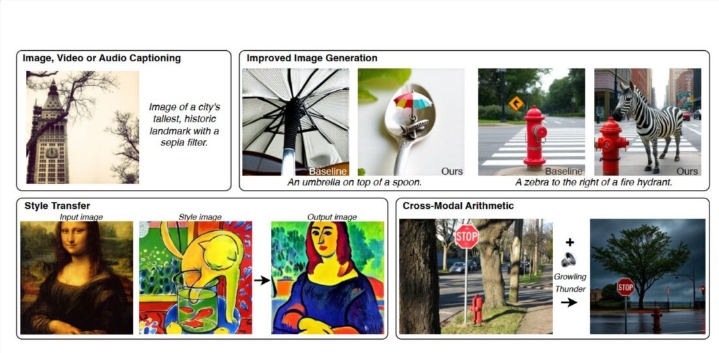

MILS funciona particularmente bien en la descripción de la imagen. Al usar el modelo LLAMA-3.1-8B como generador y el modelo de clip como anotador, MILS puede crear descripciones de imágenes comparables a las de los métodos principales actuales, aunque el clip no está capacitado específicamente para tareas de descripción de imagen. Además, MILS también mejora las capacidades de generación de texto a imagen al ajustar las indicaciones de texto, y pueden combinar indicaciones generadas por IA con herramientas de procesamiento de imágenes para manejar tareas de edición de imágenes como la conversión de estilo.

La precisión de la descripción de la imagen aumenta con el número de pasos entre el generador y el anotador. | Foto: Ashutosh, etc.

Las capacidades de MILS no se limitan a las imágenes, también se extiende a los campos de video y audio. Cuando se prueba utilizando el conjunto de datos de video MSR-VTT, MILS supera a los modelos existentes en la descripción del contenido de video. Dado que MILS no modifica los parámetros del modelo durante la operación, puede convertir diferentes tipos de datos en texto legible, lo que respalda la fusión y la conversión de información de múltiples fuentes, como imágenes y audio, en el formato deseado, lo que hace que las aplicaciones convergentes de información multimodal abran nuevas posibilidades.

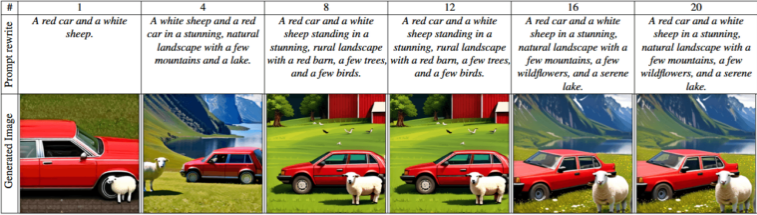

Las pruebas muestran que el uso de generadores más grandes y modelos de puntuación puede producir resultados más precisos, y aumentar el número de soluciones potenciales puede mejorar significativamente el rendimiento. Los investigadores también encontraron que extenderse a un modelo de lenguaje más grande no solo mejora la calidad de los resultados, sino que también mejora significativamente el rendimiento.

Los paisajes evolucionan de descripciones básicas simples a representaciones de paisajes complejos con detalles más precisos y elementos más naturales. | Foto: Ashutosh, etc.

Esta estrategia innovadora adoptada por MILS está en línea con la tendencia actual del campo de la inteligencia artificial hacia capacidades de razonamiento más inteligentes. El equipo de Meta también dijo que MILS puede mostrar un gran potencial en el futuro en los campos como el procesamiento de datos 3D, promoviendo aún más el desarrollo de IA multimodal.

Con el rápido desarrollo de GPT-4 de OpenAI y otras alternativas de código abierto, como Meta's Llama 3.2, Mistral's Pixtral y Janus Pro de Deepseek, estos sistemas de IA multimodales emergentes están acelerando su aplicación a la vida cotidiana. Desarrollo de inteligencia artificial.