En los últimos años, con el rápido desarrollo de modelos de idiomas grandes, los modelos de mejora de la inferencia también han desencadenado amplias discusiones sobre sus tasas de alucinación al tiempo que mejoran las capacidades de procesamiento de tareas complejas. El Equipo de Aprendizaje Autor de Vatarara realizó recientemente un estudio en profundidad de los modelos de la serie Deepseek, revelando diferencias significativas en el modelo de mejora de la inferencia en términos de tasas de alucinación.

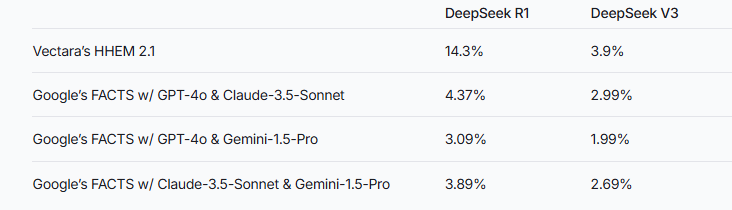

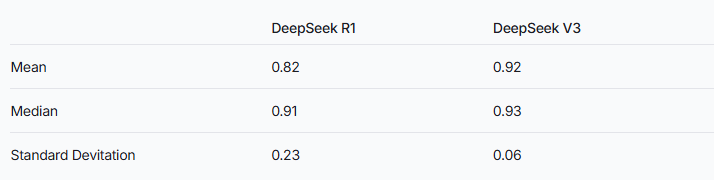

Recientemente, el equipo de aprendizaje automático de Vectara realizó pruebas de alucinación en profundidad en dos modelos de la serie Deepseek. V3. Esto sugiere que Deepseek-R1 produce más inexacto o inconsistente con la información original durante el proceso de aumento del razonamiento. Este resultado desencadena una amplia discusión sobre la tasa de alucinación del modelo de lenguaje grande mejorado por inferencia (LLM).

Notas de fuente de imagen: La imagen es generada por AI y el proveedor de servicios autorizado de imagen MidJourney

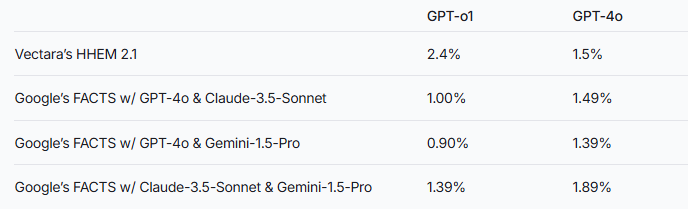

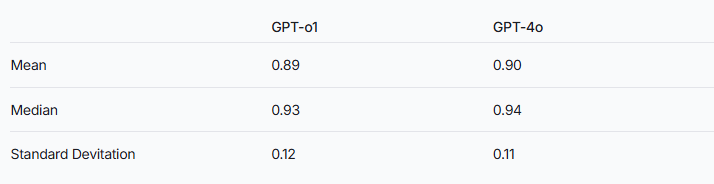

El equipo de investigación señaló que los modelos de aumento de inferencia pueden ser más propensos a las alucinaciones que los modelos de idiomas grandes comunes. Este fenómeno es particularmente evidente en la comparación de la serie Deepseek con otros modelos de mejora de inferencia. Tomando la serie GPT como ejemplo, la diferencia en la tasa de alucinación entre el GPT-O1 mejorado por el razonamiento y la versión normal de GPT-4O también verifica esta especulación.

Para evaluar el rendimiento de estos dos modelos, los investigadores utilizaron el modelo HHEM de Vacerara y el método de hechos de Google para emitir juicios. Como herramienta especializada de detección de alucinación, HHEM exhibe una mayor sensibilidad al capturar el aumento de la tasa de alucinación de Deepseek-R1, mientras que el modelo de datos funciona relativamente mal a este respecto. Esto nos recuerda que HHEM puede ser más efectivo que LLM como estándar.

Vale la pena señalar que Deepseek-R1, a pesar de su excelente rendimiento en el razonamiento, se acompaña de una mayor tasa de alucinación. Esto puede estar relacionado con la lógica compleja requerida para procesar modelos de mejora de inferencia. A medida que aumenta la complejidad del razonamiento del modelo, la precisión del contenido generado puede verse afectado. El equipo de investigación también enfatizó que si Deepseek puede centrarse más en reducir las alucinaciones durante la fase de entrenamiento, puede ser posible lograr un buen equilibrio entre la capacidad de razonamiento y la precisión.

Si bien los modelos mejorados por inferencia generalmente exhiben alucinaciones más altas, esto no significa que no tengan una ventaja en otros aspectos. Para la serie Deepseek, todavía es necesario resolver alucinaciones en la investigación y optimización posteriores para mejorar el rendimiento general del modelo.

Referencia: https://www.vectara.com/blog/deepseek-r1-hallucinates-more-thandeepseek-v3

Con la evolución continua de modelos de idiomas grandes, cómo reducir las tasas de alucinación al tiempo que mejorar las capacidades de razonamiento se convertirá en una dirección importante para futuras investigaciones. Los resultados de las pruebas de la serie Deepseek nos proporcionan una valiosa referencia para promover la industria para optimizar aún más el rendimiento del modelo.