Con el rápido desarrollo de la tecnología de inteligencia artificial, los modelos de idiomas se están volviendo cada vez más ampliamente utilizados en múltiples campos. Sin embargo, un nuevo estudio de OpenAI reveló que a estos modelos les fue muy frecuente a las expectativas al responder preguntas objetivas, lo que provocó un replanteamiento de la capacidad de la IA para adquirir conocimiento.

Un estudio reciente de OpenAI muestra que a pesar del rápido desarrollo de la tecnología de inteligencia artificial, los modelos de lenguaje más avanzados actuales tienen tasas de éxito mucho más bajas para responder preguntas objetivas.

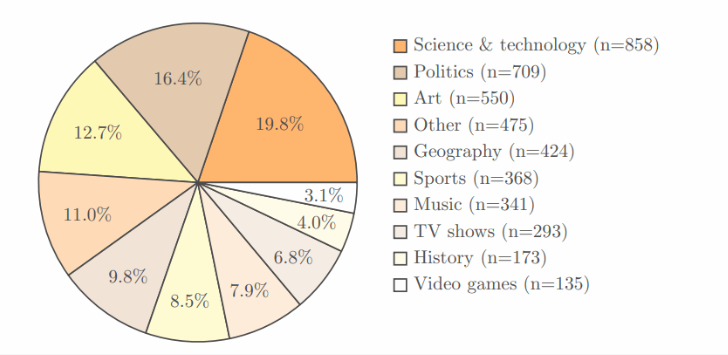

El estudio adoptó la propia prueba de referencia SimpleQA de Openai, que contiene 4.326 áreas, que cubre múltiples campos como ciencia, política y arte, y cada pregunta tiene una respuesta clara y correcta.

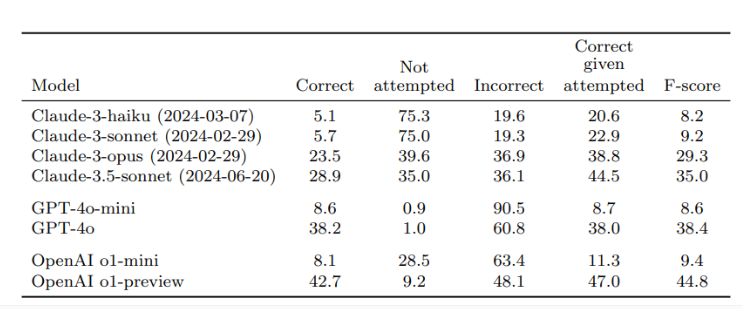

Después de la verificación de dos revisores independientes, los resultados mostraron que la tasa de precisión de la revisión de O1, el mejor modelo de OpenAI, fue solo del 42.7%, mientras que GPT-4O fue ligeramente menor, solo 38.2%. En cuanto al GPT-4O-Mini más pequeño, la tasa de precisión es incluso solo del 8,6%. En contraste, el modelo Claude de Anthrope funcionó peor, con la tasa de precisión de Claude-3.5-Sonnet fue solo el 28.9%.

La clave de este estudio es el diseño de la prueba, no solo para probar el rendimiento de la IA, sino también hacer que todos se den cuenta de las limitaciones de los modelos de IA en términos de adquisición de conocimiento. Los investigadores enfatizan que al usar estos modelos, los usuarios deben considerarlos como herramientas de procesamiento de información en lugar de depender completamente de las fuentes de conocimiento. Para obtener respuestas más precisas, es mejor proporcionar datos confiables para la IA en lugar de confiar únicamente en su conocimiento incorporado.

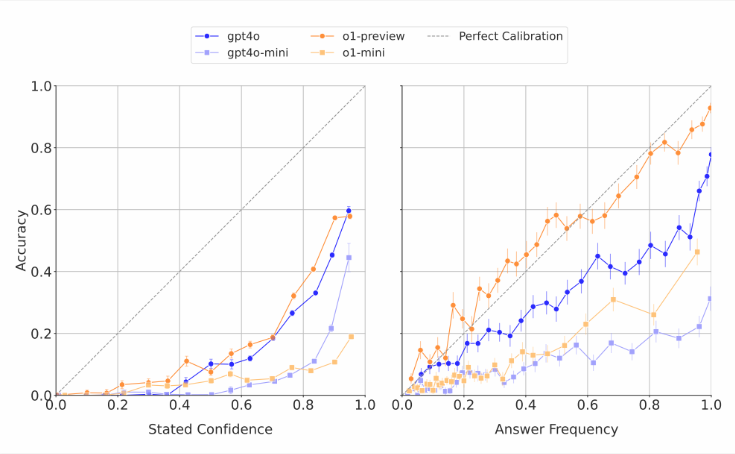

Vale la pena señalar que los modelos de IA a menudo estiman sus propias habilidades. Los investigadores encontraron que cuando se pidió a estos modelos que obtuvieran confianza en sus respuestas, generalmente daban un puntaje de precisión exagerado. En las pruebas que responden repetidamente la misma pregunta, incluso si el modelo da la misma respuesta varias veces, su tasa de éxito real sigue siendo más baja que la precisión de su autoevaluación. Esto es consistente con la crítica del mundo exterior que a menudo produce respuestas absurdas a los modelos de idiomas, pero parece seguro.

Los investigadores creen que existe una clara brecha en la precisión objetiva de los sistemas de IA actuales y que necesitan una mejora con urgencia. Al mismo tiempo, también hicieron una pregunta abierta: si el rendimiento de la IA al responder preguntas de hecho breves puede predecir cómo funciona cuando se trata de respuestas más largas y más complejas. Para apoyar el desarrollo de modelos de idiomas más confiables, OpenAI ha publicado datos sobre puntos de referencia SimpleQA públicamente en Github.

Puntos clave:

Operai Research muestra que los modelos de idiomas más avanzados tienen bajas tasas de éxito al responder preguntas objetivas, con una tasa de éxito máxima de solo 42.7%.

Estos modelos de IA a menudo sobreestiman sus habilidades y sus puntajes de confianza generalmente son exagerados.

Operai ha hecho público SimpleQA Benchmark para ayudar a investigar modelos de idiomas más confiables.

Este estudio nos recuerda que a pesar del progreso significativo en la tecnología de IA, sus limitaciones deben tratarse con precaución en aplicaciones prácticas y continuar promoviendo mejoras tecnológicas.