Las últimas investigaciones en el campo de la inteligencia artificial revelan una sorprendente similitud entre los modelos de idiomas grandes (LLM) y las estructuras cerebrales humanas. A través del análisis en profundidad del espacio de activación de LLM, los científicos del MIT descubrieron que su estructura interna tiene una correspondencia significativa con los niveles micro, meso y macro del cerebro humano. Este descubrimiento no solo proporciona una nueva perspectiva para que comprendamos cómo funciona la IA, sino que también sienta las bases para el desarrollo futuro de los sistemas de IA más inteligentes.

¡La IA en realidad ha comenzado a "hacer crecer tu cerebro"?

Este estudio utilizó la tecnología de autoencoder escasa para realizar un análisis en profundidad del espacio de activación de LLM y descubrió tres niveles de características estructurales, lo cual fue sorprendente:

Primero, a nivel microscópico, los investigadores descubrieron la existencia de una estructura "cristal". Las caras de estos "cristales" están compuestas de paralelogramas o trapecios, similares a las analogías de vocabulario familiares como "Man: Women: King: Queen".

Lo que es aún más sorprendente es que estas estructuras "de cristal" se vuelven más claras después de eliminar algunos factores de interferencia irrelevantes (como la longitud de las palabras) a través de técnicas de análisis discriminantes lineales.

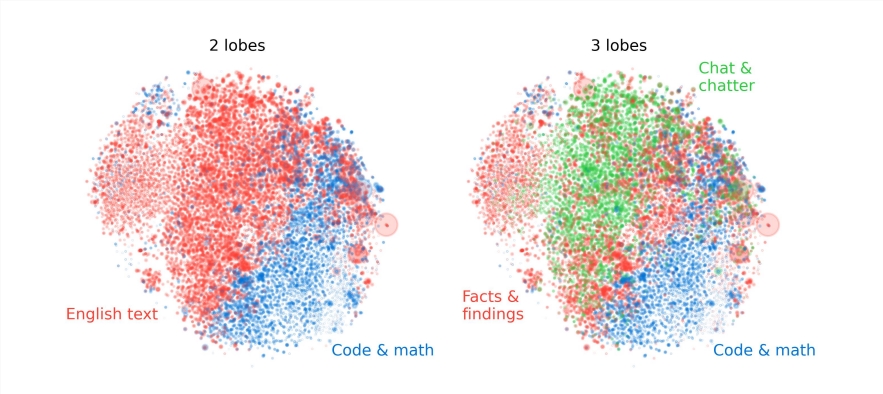

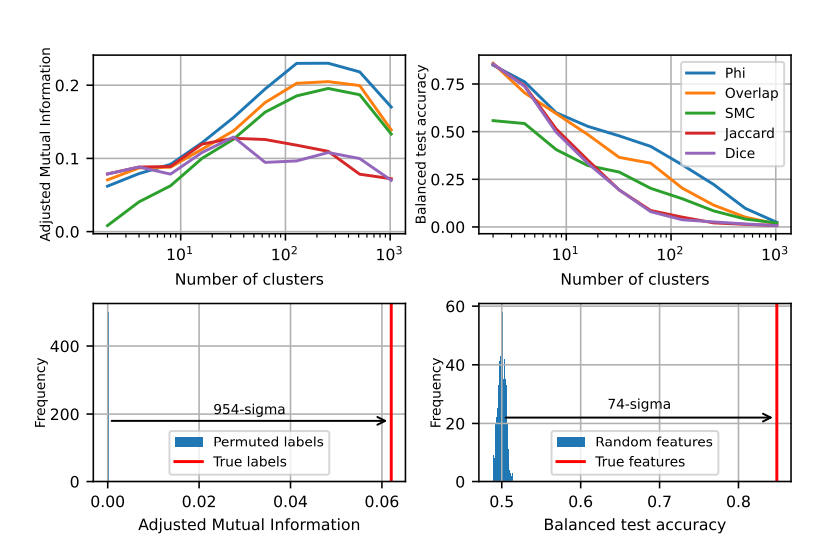

En segundo lugar, a nivel de meso, los investigadores encontraron que el espacio de activación de LLM tiene una estructura modular similar a la partición funcional del cerebro humano.

Por ejemplo, las características relacionadas con las matemáticas y el código se reunirán para formar un "lóbulo cerebral" similar al lóbulo funcional del cerebro humano. A través del análisis cuantitativo por múltiples indicadores, los investigadores confirmaron la localidad espacial de estos "lóbulos cerebrales", lo que indica que las características concurrentes también están más concentradas espacialmente, superando con creces las expectativas de distribución aleatoria.

A nivel macro, los investigadores encontraron que la estructura general de la nube de puntos de características de LLM no es isotrópica, pero muestra una distribución de valor propio de la ley de potencia, y esta distribución es más obvia en la capa intermedia.

Los investigadores también cuantificaron la entropía de agrupación en diferentes niveles y descubrieron que la entropía de agrupación de la capa intermedia era menor, lo que indica que la representación de la característica estaba más concentrada, mientras que la entropía de agrupación de las capas tempranas y tardías fue mayor, lo que indica que la representación de la característica estaba más disperso.

Este estudio proporciona una nueva perspectiva para que comprendamos los mecanismos internos de los modelos de idiomas grandes y sienta las bases para el desarrollo futuro de sistemas AI más potentes y más inteligentes.

Este estudio no solo revela la similitud entre la IA y el cerebro humano, sino que también proporciona una nueva dirección para el desarrollo futuro de la tecnología de IA, lo que indica que la IA se volverá más inteligente y más eficiente.