Con el rápido desarrollo de modelos de lenguaje grande (MLLM) multimodales (MLLM), las tareas relacionadas con la imagen y el video han introducido avances sin precedentes, especialmente en los campos de las preguntas y la respuesta visuales, la generación narrativa y la edición interactiva. Sin embargo, a pesar del progreso significativo en estas tecnologías, lograr la comprensión de contenido de video de grano fino sigue siendo un problema difícil de resolver. Este desafío implica no solo la segmentación y el seguimiento de los niveles de píxeles con descripciones del lenguaje, sino también tareas complejas, como preguntas y respuestas visuales en indicaciones de video específicas.

Aunque los modelos actuales de percepción de video de última generación funcionan bien en las tareas de segmentación y seguimiento, todavía son inadecuados en la comprensión del lenguaje abierto y las capacidades de diálogo. Los MLLM de video, aunque funcionan bien en la comprensión de video y las tareas de preguntas y respuestas, aún no pueden manejar tareas perceptivas y señales visuales. Esta limitación limita su uso en una gama más amplia de escenarios.

Las soluciones existentes se dividen principalmente en dos categorías: modelos de lenguaje grande multimodal (MLLMS) y sistemas de segmentación de referencia. MLLMS inicialmente se centró en mejorar los métodos de fusión multimodal y los extractores de características, y se convirtió gradualmente en un marco para el ajuste de instrucciones en LLM, como Llava. Recientemente, los investigadores han tratado de unificar imágenes, videos y análisis de múltiples imágenes en un solo marco, como Llava-Anevision. Al mismo tiempo, el sistema de segmentación de referencia también ha sufrido una transformación de módulos de fusión básicos a segmentación y seguimiento integrados. Sin embargo, estas soluciones aún tienen deficiencias en la integración integral de las capacidades de percepción y comprensión del lenguaje.

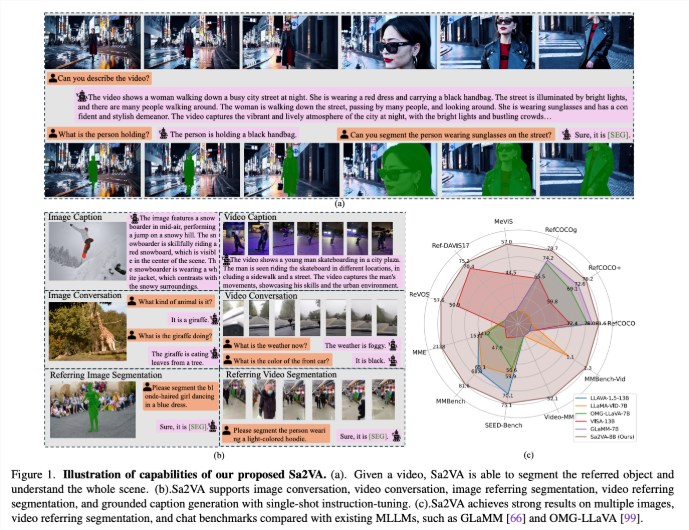

Los investigadores de UC Merced, el equipo de semillas de bytedance, la Universidad de Wuhan y la Universidad de Pekín han propuesto SA2VA, un modelo unificado innovador diseñado para lograr una comprensión básica intensiva de imágenes y videos. Este modelo supera las limitaciones de los modelos de lenguaje grande multimodal existentes al minimizar la sintonización de instrucciones únicas y el soporte de una amplia gama de tareas de imagen y video.

SA2VA integra innovativamente SAM-2 con Llava para unificar texto, imágenes y video en un espacio de token LLM compartido. Además, los investigadores han lanzado un extenso conjunto de datos de anotación automática llamado Ref-SAV, que contiene expresiones de objetos en más de 72k escenarios de video complejos y objetos de video de 2K verificados manualmente para garantizar capacidades de evaluación comparativa robustas.

La arquitectura de SA2VA se compone principalmente de dos partes: un modelo similar a Llava y SAM-2, y adopta un nuevo diseño de desacoplamiento. El componente tipo LLAVA incluye un codificador visual que procesa imágenes y videos, una capa de proyección visual y un LLM para la predicción del token de texto. El sistema adopta un método de desacoplamiento único que permite a SAM-2 operar junto al modelo LLAVA previamente capacitado sin el intercambio de token directo, manteniendo así la eficiencia computacional y permitiendo complementos y desconcertaciones con diversas MLLMS Connects.

Los resultados de la investigación muestran que SA2VA logró resultados de última generación en la tarea de segmentación de citas, con su modelo SA2VA-8B que tiene puntajes CIOU en Refcoco, Refcoco+ y Refcocog, respectivamente, superando los sistemas anteriores como GLAMM-7B. En términos de capacidades de diálogo, SA2VA logró excelentes resultados de 2128, 81.6 y 75.1 en MME, Mmbench y semillas, respectivamente.

Además, el rendimiento de SA2VA en los puntos de referencia de video superó significativamente el estado anterior, Visa-13b de la artista, que muestra su eficiencia y efectividad en las tareas de comprensión de imagen y video.

Documento: https://arxiv.org/abs/2501.04001

Modelo: https://huggingface.co/collections/byedance/sa2va-model-zoo-677e3084d71b5f108d00e093

Puntos clave:

SA2VA es un nuevo marco de IA unificado que logra una comprensión profunda de imágenes y videos y supera las limitaciones de los modelos multimodales existentes.

El modelo ha logrado resultados de última generación en varios puntos de referencia, como las capacidades de segmentación de citas y diálogo, que muestran un rendimiento sobresaliente.

El diseño de SA2VA integra efectivamente las capacidades de comprensión visual y del lenguaje a través de un método de desacoplamiento, que admite una amplia gama de tareas de imagen y video.