Chine | 한국어 | 日本語 | Russe | allemand | Français | espagnol | Portugais | Turc | Tiếng Việt | العربية

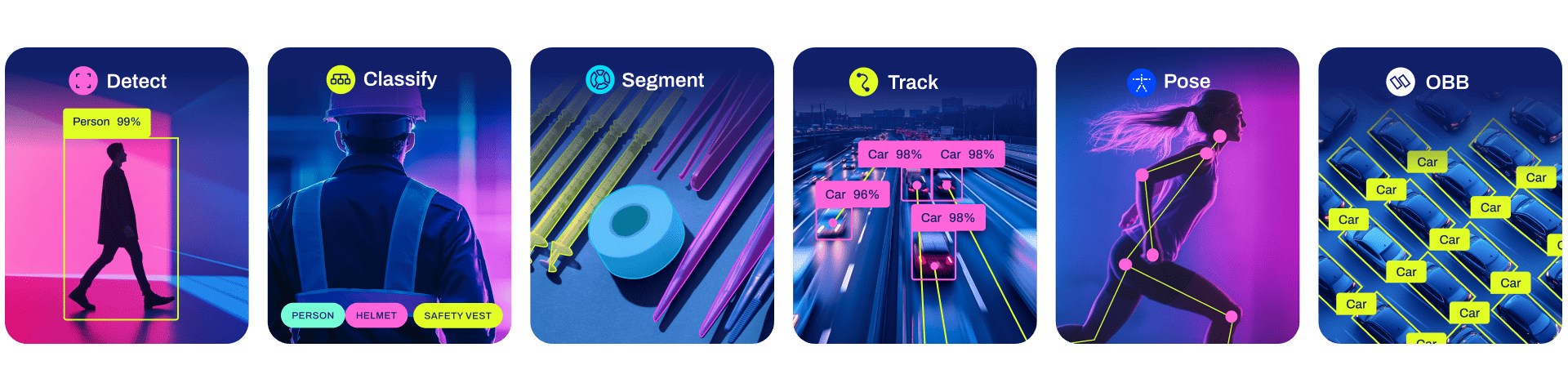

Ultralytics YOLO11 est un modèle de pointe (SOTA) qui s'appuie sur le succès des versions précédentes de YOLO et introduit de nouvelles fonctionnalités et améliorations pour améliorer encore les performances et la flexibilité. YOLO11 est conçu pour être rapide, précis et facile à utiliser, ce qui en fait un excellent choix pour un large éventail de tâches de détection et de suivi d'objets, de segmentation d'instances, de classification d'images et d'estimation de pose.

Nous espérons que les ressources ici vous aideront à tirer le meilleur parti de YOLO. Veuillez parcourir la documentation Ultralytics pour plus de détails, soulever un problème sur GitHub pour obtenir de l'aide, des questions ou des discussions, devenez membre du Discord Ultralytics, de Reddit et des forums !

Pour demander une licence d'entreprise, veuillez remplir le formulaire sur Ultralytics Licensing.

Documentation

Voir ci-dessous pour un démarrage rapide des exemples d'installation et d'utilisation, et consultez nos documents pour une documentation complète sur la formation, la validation, la prédiction et le déploiement.

Pip installe le package ultralytics incluant toutes les exigences dans un environnement Python>=3.8 avec PyTorch>=1.8 .

pip installer les ultralytiques

Pour d'autres méthodes d'installation, notamment Conda, Docker et Git, veuillez vous référer au Guide de démarrage rapide.

YOLO peut être utilisé directement dans l'interface de ligne de commande (CLI) avec une commande yolo :

yolo prédire model=yolo11n.pt source='https://ultralytics.com/images/bus.jpg'

yolo peut être utilisé pour une variété de tâches et de modes et accepte des arguments supplémentaires, c'est-à-dire imgsz=640 . Voir la documentation YOLO CLI pour des exemples.

YOLO peut également être utilisé directement dans un environnement Python et accepte les mêmes arguments que dans l'exemple CLI ci-dessus :

à partir de l'importation ultralytique YOLO# Charger un modelmodel = YOLO("yolo11n.pt")# Former le modeltrain_results = model.train( data="coco8.yaml", # chemin vers l'ensemble de données YAML epochs=100, # nombre d'époques d'entraînement imgsz= 640, # taille de l'image d'entraînement device="cpu", # périphérique sur lequel s'exécuter, c'est-à-dire périphérique = 0 ou périphérique = 0,1,2,3 ou device=cpu)# Évaluer les performances du modèle sur la validation setmetrics = model.val()# Effectuer une détection d'objet sur une imageresults = model("path/to/image.jpg")results[0].show()# Exporter le modèle vers ONNX formatpath = model.export(format="onnx") # chemin de retour vers le modèle exportéVoir YOLO Python Docs pour plus d'exemples.

Modèles

Les modèles YOLO11 Detect, Segment et Pose pré-entraînés sur l'ensemble de données COCO sont disponibles ici, ainsi que les modèles YOLO11 Classify pré-entraînés sur l'ensemble de données ImageNet. Le mode Track est disponible pour tous les modèles Detect, Segment et Pose.

Tous les modèles sont téléchargés automatiquement à partir de la dernière version d'Ultralytics lors de la première utilisation.

Consultez la documentation de détection pour obtenir des exemples d'utilisation avec ces modèles formés sur COCO, qui incluent 80 classes pré-entraînées.

| Modèle | taille (pixels) | val.carte 50-95 | Vitesse Processeur ONNX (MS) | Vitesse Tenseur T4RT10 (MS) | paramètres (M) | FLOP (B) |

|---|---|---|---|---|---|---|

| YOLO11n | 640 | 39,5 | 56,1 ± 0,8 | 1,5 ± 0,0 | 2.6 | 6.5 |

| YOLO11 | 640 | 47,0 | 90,0 ± 1,2 | 2,5 ± 0,0 | 9.4 | 21,5 |

| YOLO11min | 640 | 51,5 | 183,2 ± 2,0 | 4,7 ± 0,1 | 20.1 | 68,0 |

| YOLO11l | 640 | 53.4 | 238,6 ± 1,4 | 6,2 ± 0,1 | 25.3 | 86,9 |

| YOLO11x | 640 | 54,7 | 462,8 ± 6,7 | 11,3 ± 0,2 | 56,9 | 194,9 |

Les valeurs mAP val concernent un modèle unique, une échelle unique sur l'ensemble de données COCO val2017.

Reproduire par yolo val detect data=coco.yaml device=0

Vitesse moyenne sur les images COCO val à l'aide d'une instance Amazon EC2 P4d.

Reproduire par yolo val detect data=coco.yaml batch=1 device=0|cpu

Voir Segmentation Docs pour des exemples d'utilisation avec ces modèles formés sur COCO-Seg, qui incluent 80 classes pré-entraînées.

| Modèle | taille (pixels) | boîte CARTE 50-95 | masque CARTE 50-95 | Vitesse Processeur ONNX (MS) | Vitesse Tenseur T4RT10 (MS) | paramètres (M) | FLOP (B) |

|---|---|---|---|---|---|---|---|

| YOLO11n-seg | 640 | 38,9 | 32,0 | 65,9 ± 1,1 | 1,8 ± 0,0 | 2.9 | 10.4 |

| YOLO11s-seg | 640 | 46,6 | 37,8 | 117,6 ± 4,9 | 2,9 ± 0,0 | 10.1 | 35,5 |

| YOLO11 min-segment | 640 | 51,5 | 41,5 | 281,6 ± 1,2 | 6,3 ± 0,1 | 22.4 | 123.3 |

| YOLO11l-seg | 640 | 53.4 | 42,9 | 344,2 ± 3,2 | 7,8 ± 0,2 | 27.6 | 142.2 |

| YOLO11x-seg | 640 | 54,7 | 43,8 | 664,5 ± 3,2 | 15,8 ± 0,7 | 62.1 | 319,0 |

Les valeurs mAP val concernent un modèle unique, une échelle unique sur l'ensemble de données COCO val2017.

Reproduire par yolo val segment data=coco-seg.yaml device=0

Vitesse moyenne sur les images COCO val à l'aide d'une instance Amazon EC2 P4d.

Reproduire par yolo val segment data=coco-seg.yaml batch=1 device=0|cpu

Consultez les documents de classification pour obtenir des exemples d'utilisation avec ces modèles formés sur ImageNet, qui incluent 1 000 classes pré-entraînées.

| Modèle | taille (pixels) | acc top1 | acc top5 | Vitesse Processeur ONNX (MS) | Vitesse Tenseur T4RT10 (MS) | paramètres (M) | FLOP (B) à 640 |

|---|---|---|---|---|---|---|---|

| YOLO11n-cls | 224 | 70,0 | 89,4 | 5,0 ± 0,3 | 1,1 ± 0,0 | 1.6 | 3.3 |

| YOLO11s-cls | 224 | 75,4 | 92,7 | 7,9 ± 0,2 | 1,3 ± 0,0 | 5.5 | 12.1 |

| YOLO11m-cls | 224 | 77.3 | 93,9 | 17,2 ± 0,4 | 2,0 ± 0,0 | 10.4 | 39.3 |

| YOLO11l-cls | 224 | 78.3 | 94,3 | 23,2 ± 0,3 | 2,8 ± 0,0 | 12.9 | 49.4 |

| YOLO11x-cls | 224 | 79,5 | 94,9 | 41,4 ± 0,9 | 3,8 ± 0,0 | 28.4 | 110.4 |

Les valeurs acc sont des précisions de modèle sur l'ensemble de validation de l'ensemble de données ImageNet.

Reproduire par yolo val classify data=path/to/ImageNet device=0

Vitesse moyenne sur les images ImageNet val à l'aide d'une instance Amazon EC2 P4d.

Reproduire par yolo val classify data=path/to/ImageNet batch=1 device=0|cpu

Voir Pose Docs pour des exemples d'utilisation avec ces modèles formés sur COCO-Pose, qui incluent 1 classe pré-formée, personne.

| Modèle | taille (pixels) | pose carte 50-95 | pose carte 50 | Vitesse Processeur ONNX (MS) | Vitesse Tenseur T4RT10 (MS) | paramètres (M) | FLOP (B) |

|---|---|---|---|---|---|---|---|

| YOLO11n-pose | 640 | 50,0 | 81,0 | 52,4 ± 0,5 | 1,7 ± 0,0 | 2.9 | 7.6 |

| YOLO11s-pose | 640 | 58,9 | 86,3 | 90,5 ± 0,6 | 2,6 ± 0,0 | 9.9 | 23.2 |

| YOLO11m-pose | 640 | 64,9 | 89,4 | 187,3 ± 0,8 | 4,9 ± 0,1 | 20.9 | 71,7 |

| YOLO11l-pose | 640 | 66.1 | 89,9 | 247,7 ± 1,1 | 6,4 ± 0,1 | 26.2 | 90,7 |

| YOLO11x-pose | 640 | 69,5 | 91.1 | 488,0 ± 13,9 | 12,1 ± 0,2 | 58,8 | 203.3 |

Les valeurs mAP val concernent un modèle unique et une échelle unique sur l'ensemble de données COCO Keypoints val2017.

Reproduire par yolo val pose data=coco-pose.yaml device=0

Vitesse moyenne sur les images COCO val à l'aide d'une instance Amazon EC2 P4d.

Reproduire par yolo val pose data=coco-pose.yaml batch=1 device=0|cpu

Consultez OBB Docs pour des exemples d'utilisation avec ces modèles formés sur DOTAv1, qui incluent 15 classes pré-entraînées.

| Modèle | taille (pixels) | test MAP 50 | Vitesse Processeur ONNX (MS) | Vitesse Tenseur T4RT10 (MS) | paramètres (M) | FLOP (B) |

|---|---|---|---|---|---|---|

| YOLO11n-obb | 1024 | 78,4 | 117,6 ± 0,8 | 4,4 ± 0,0 | 2.7 | 17.2 |

| YOLO11s-obb | 1024 | 79,5 | 219,4 ± 4,0 | 5,1 ± 0,0 | 9.7 | 57,5 |

| YOLO11m-obb | 1024 | 80,9 | 562,8 ± 2,9 | 10,1 ± 0,4 | 20.9 | 183,5 |

| YOLO11l-obb | 1024 | 81,0 | 712,5 ± 5,0 | 13,5 ± 0,6 | 26.2 | 232,0 |

| YOLO11x-obb | 1024 | 81,3 | 1408,6 ± 7,7 | 28,6 ± 1,0 | 58,8 | 520.2 |

Les valeurs du test mAP concernent un modèle multi-échelle unique sur l'ensemble de données DOTAv1.

Reproduisez par yolo val obb data=DOTAv1.yaml device=0 split=test et soumettez les résultats fusionnés à l'évaluation DOTA.

Vitesse moyenne sur les images val DOTAv1 à l'aide d'une instance Amazon EC2 P4d.

Reproduire par yolo val obb data=DOTAv1.yaml batch=1 device=0|cpu

Intégrations

Nos intégrations clés avec les principales plates-formes d'IA étendent les fonctionnalités des offres d'Ultralytics, en améliorant les tâches telles que l'étiquetage des ensembles de données, la formation, la visualisation et la gestion des modèles. Découvrez comment Ultralytics, en collaboration avec W&B, Comet, Roboflow et OpenVINO, peut optimiser votre flux de travail d'IA.

![]()

![]()

![]()

| HUB Ultralytique ? | W&B | Comète ⭐ NOUVEAU | Magie neuronale |

|---|---|---|---|

| Rationalisez les flux de travail YOLO : étiquetez, formez et déployez sans effort avec Ultralytics HUB. Essayez maintenant ! | Suivez les expériences, les hyperparamètres et les résultats avec les poids et biais | Gratuit pour toujours, Comet vous permet d'enregistrer des modèles YOLO11, de reprendre l'entraînement et de visualiser et déboguer les prédictions de manière interactive. | Exécutez l'inférence YOLO11 jusqu'à 6 fois plus rapidement avec Neural Magic DeepSparse |

HUB Ultralytique

Faites l'expérience d'une IA transparente avec Ultralytics HUB ⭐, la solution tout-en-un pour la visualisation de données, YOLO11 ? formation et déploiement de modèles, sans aucun codage. Transformez les images en informations exploitables et donnez vie à vos visions d'IA en toute simplicité grâce à notre plate-forme de pointe et à notre application Ultralytics conviviale. Commencez votre voyage gratuitement dès maintenant !

Contribuer

Nous aimons votre contribution ! Ultralytics YOLO ne serait pas possible sans l'aide de notre communauté. Veuillez consulter notre Guide de contribution pour commencer et remplir notre sondage pour nous envoyer des commentaires sur votre expérience. Merci ? à tous nos contributeurs !

Licence

Ultralytics propose deux options de licence pour s'adapter à divers cas d'utilisation :

Licence AGPL-3.0 : Cette licence open source approuvée par l'OSI est idéale pour les étudiants et les passionnés, favorisant la collaboration ouverte et le partage des connaissances. Voir le fichier LICENSE pour plus de détails.

Licence Entreprise : conçue pour un usage commercial, cette licence permet une intégration transparente des logiciels Ultralytics et des modèles d'IA dans les biens et services commerciaux, en contournant les exigences open source d'AGPL-3.0. Si votre scénario implique l'intégration de nos solutions dans une offre commerciale, contactez Ultralytics Licensing.

Contact

Pour les rapports de bogues Ultralytics et les demandes de fonctionnalités, veuillez visiter les problèmes GitHub. Devenez membre d'Ultralytics Discord, Reddit ou des forums pour poser des questions, partager des projets, apprendre des discussions ou pour obtenir de l'aide sur tout ce qui concerne Ultralytics !