Important

À propos de ce dépôt. Il s'agit d'une plate-forme permettant d'obtenir les dernières recherches sur différents types de chefs d'attention de LLM. Nous avons également publié une enquête basée sur ces œuvres fantastiques.

Si vous souhaitez citer nos travaux , voici notre entrée bibtex : CITATION.bib.

Si vous souhaitez uniquement voir la liste des documents associés, veuillez accéder directement ici.

Si vous souhaitez contribuer à ce dépôt, référez-vous à ici.

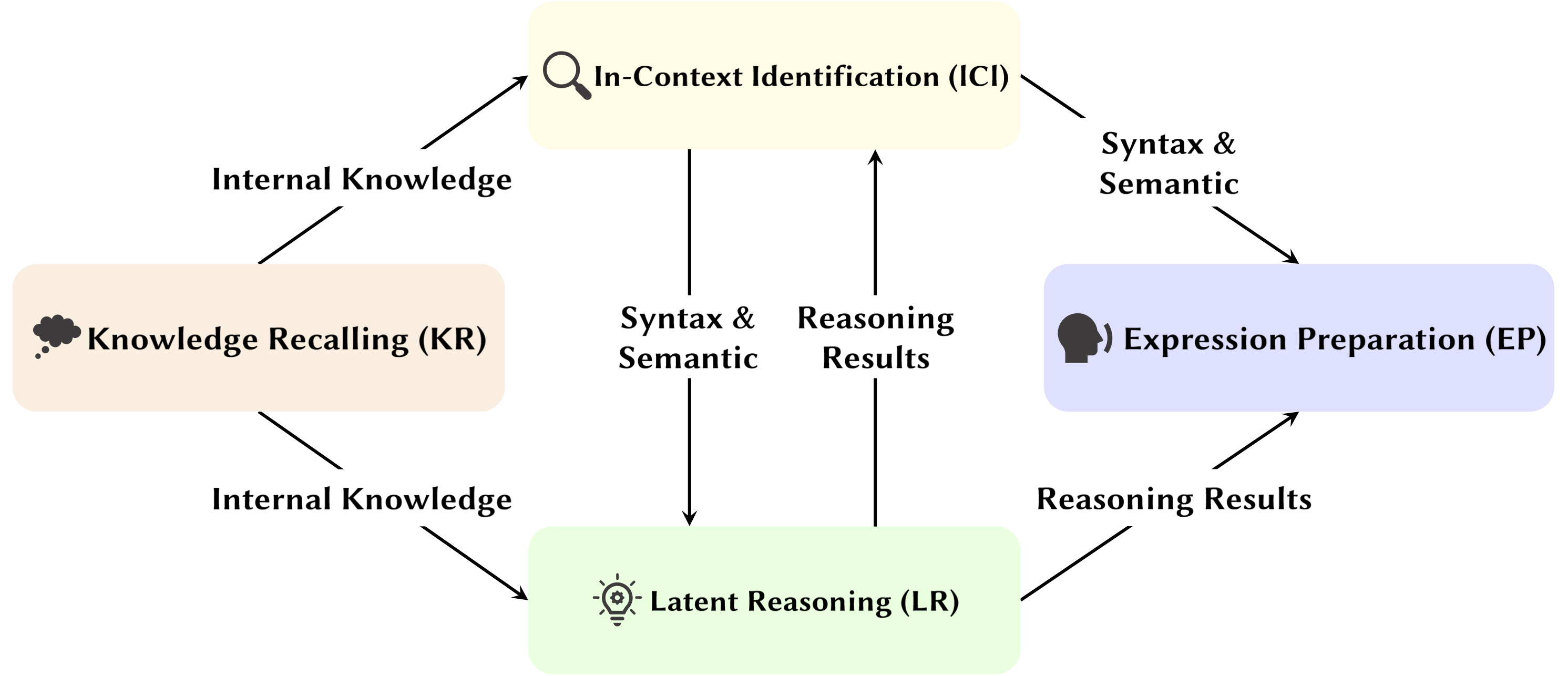

Avec le développement des Large Language Models (LLM), leur structure de réseau sous-jacente, le Transformer, fait l'objet d'études approfondies. La recherche sur la structure du Transformer nous aide à améliorer notre compréhension de cette « boîte noire » et à améliorer l’interprétabilité du modèle. Récemment, de plus en plus de travaux suggèrent que le modèle contient deux partitions distinctes : les mécanismes d'attention utilisés pour le comportement, l'inférence et l'analyse, et les réseaux Feed-Forward (FFN) pour le stockage des connaissances. Le premier est crucial pour révéler les capacités fonctionnelles du modèle, conduisant à une série d’études explorant diverses fonctions au sein des mécanismes d’attention, que nous avons appelées Attention Head Mining .

Dans cette enquête, nous approfondissons les mécanismes potentiels par lesquels les têtes d'attention dans les LLM contribuent au processus de raisonnement.

Points forts:

Les articles ci-dessous sont classés par date de publication :

Année 2024

| Date | Article et résumé | Balises | Links |

| 2024-11-15 | SEEKR : Rétention des connaissances guidée par l'attention sélective pour l'apprentissage continu de grands modèles de langage | ||

| • Propose SEEKR, une méthode sélective de rétention des connaissances guidée par l'attention pour un apprentissage continu dans les LLM, en se concentrant sur les principales têtes d'attention pour une distillation efficace. • Évalué sur les critères d'apprentissage continu TRACE et SuperNI. • SEEKR a atteint des performances comparables ou supérieures avec seulement 1 % de données de relecture par rapport à d'autres méthodes. | |||

| 2024-11-06 | Comment les transformateurs résolvent les problèmes de logique propositionnelle : une analyse mécaniste | ||

| • Identifie les circuits d'attention spécifiques dans les transformateurs qui résolvent des problèmes de logique propositionnelle, en se concentrant sur les mécanismes de « planification » et de « raisonnement ». • Analyse de petits transformateurs et de Mistral-7B, en utilisant des correctifs d'activation pour découvrir les voies de raisonnement. • Trouvé des chefs d'attention distincts spécialisés dans la localisation des règles, le traitement des faits et la prise de décision dans le raisonnement logique. | |||

| 2024-11-01 | Attention Tracker : Détection des attaques par injection rapide dans les LLM | ||

| • Proposition d'Attention Tracker, un système de protection simple mais efficace, sans formation, qui détecte les attaques par injection rapide en fonction des points importants identifiés. • Identifié les têtes importantes en utilisant simplement un petit ensemble de phrases aléatoires générées par LLM combinées à une attaque naïve d'ignorance. • Attention Tracker est efficace sur les petits et grands LM, répondant à une limitation significative des précédentes méthodes de détection sans formation. | |||

| 2024-10-28 | Arithmétique sans algorithmes : les modèles de langage résolvent les mathématiques avec un sac d'heuristiques | ||

| • Identifié un sous-ensemble du modèle (un circuit) qui explique la plupart du comportement du modèle pour la logique arithmétique de base et examiné sa fonctionnalité. • Analyse des modèles d'attention à l'aide d'invites arithmétiques à deux opérandes avec des chiffres arabes et les quatre opérateurs de base (+, −, ×, ÷). • Pour l'addition, la soustraction et la division, 6 têtes d'attention donnent une fidélité élevée (97 % en moyenne), alors que la multiplication nécessite 20 têtes pour dépasser 90 % de fidélité. | |||

| 2024-10-21 | Une évaluation psycholinguistique de la sensibilité des modèles linguistiques aux rôles d'argumentation | ||

| • Tête de sujet observée dans un cadre plus généralisé. • Analyse des modèles d'attention sous la condition des arguments d'échange et des arguments de remplacement. • Bien qu'ils soient capables de distinguer les rôles, les modèles peuvent avoir du mal à utiliser correctement les informations sur les rôles d'argument, car le problème réside dans la manière dont ces informations sont codées dans les représentations verbales, ce qui entraîne une sensibilité aux rôles plus faible. | |||

| 2024-10-17 | Têtes d'attention actives-dormantes : démystification mécanique des phénomènes symboliques extrêmes dans les LLM | ||

| • Démontré que les phénomènes symboliques extrêmes résultent d'un mécanisme actif-dormant dans les têtes d'attention, couplé à un mécanisme de renforcement mutuel pendant le pré-entraînement. • Utilisation de transformateurs simples entraînés sur la tâche Bigram-Backcopy (BB) pour analyser les phénomènes de jetons extrêmes et l'étendre aux LLM pré-entraînés. • De nombreuses propriétés statiques et dynamiques des phénomènes extrêmes prédits par la tâche BB s'alignent sur les observations dans les LLM pré-entraînés. | |||

| 2024-10-17 | Sur le rôle des responsables de l'attention dans la sécurité des grands modèles linguistiques | ||

| • Proposition d'une nouvelle mesure adaptée à l'attention de plusieurs têtes, le Safety Head ImPortant Score (Navires), pour évaluer les contributions de chaque tête à la sécurité du modèle. • Réalisation d'analyses sur la fonctionnalité de ces têtes d'attention de sécurité, en explorant leurs caractéristiques et leurs mécanismes. • Certaines têtes d'attention sont cruciales pour la sécurité, les têtes de sécurité se chevauchent sur des modèles affinés et l'ablation de ces têtes a un impact minime sur l'utilité. | |||

| 2024-10-14 | DuoAttention : Inférence LLM efficace à contexte long avec têtes de récupération et de streaming | ||

| • Introduction de DuoAttention, un framework qui réduit à la fois le décodage et le pré-remplissage de la mémoire et la latence de LLM sans compromettre ses capacités de contexte long, basé sur la découverte des têtes de récupération et des têtes de streaming au sein de LLM. • Testez l'impact du framework sur les performances de LLM dans les tâches à contexte court et à contexte long, ainsi que son efficacité d'inférence. • En appliquant un cache KV complet uniquement aux têtes de récupération, DuoAttention réduit considérablement l'utilisation de la mémoire et la latence pour le décodage et le pré-remplissage dans les applications à contexte long. | |||

| 2024-10-14 | Verrouillage de la sécurité des LLM affinés | ||

| • Introduction de SafetyLock, une méthode nouvelle et efficace pour maintenir la sécurité de grands modèles de langage affinés à travers différents niveaux de risque et scénarios d'attaque, basée sur la découverte des responsables de sécurité au sein de LLM. • Évaluer l'efficacité de SafetyLock pour améliorer la sécurité du modèle et l'efficacité de l'inférence. • En appliquant des vecteurs d'intervention aux têtes de sécurité, SafetyLock peut modifier les activations internes du modèle pour les rendre inoffensives lors de l'inférence, obtenant ainsi un alignement de sécurité précis avec un impact minimal sur la réponse. | |||

| 2024-10-11 | Le même mais différent : similitudes structurelles et différences dans la modélisation du langage multilingue | ||

| • Réalisation d'une étude approfondie des composants spécifiques sur lesquels s'appuient les modèles multilingues lors de l'exécution de tâches nécessitant des processus morphologiques spécifiques à la langue. • Étudier les différences fonctionnelles des composants du modèle interne lors de l'exécution de tâches en anglais et en chinois. • La tête de copie a une fréquence d'activation similaire dans les deux langues, alors que la tête au passé n'est fréquemment activée qu'en anglais. | |||

| 2024-10-08 | Nous tournons en rond ! Qu’est-ce qui rend les codages positionnels rotatifs utiles ? | ||

| • Fourni une analyse approfondie des composants internes d'un modèle Gemma 7B entraîné pour comprendre comment RoPE est utilisé au niveau mécanique. • Compréhension de l'utilisation de différentes fréquences dans les requêtes et les clés. • Nous avons découvert que les fréquences les plus élevées de RoPE sont intelligemment utilisées par Gemma 7B pour construire des têtes d'attention « positionnelles » spéciales (têtes diagonales, tête de jeton précédent), tandis que les basses fréquences sont utilisées par la tête d'apostrophe. | |||

| 2024-10-06 | Revisiter le circuit d'inférence d'apprentissage en contexte dans les grands modèles de langage | ||

| • Proposition d'un circuit d'inférence complet en 3 étapes pour caractériser le processus d'inférence d'ICL. • Divisez ICL en trois étapes : Résumer, Fusionner la sémantique et Récupérer et copier les fonctionnalités, en analysant le rôle que joue chaque étape dans ICL et son mécanisme opérationnel. • Nous avons constaté qu'avant les têtes d'induction, les têtes de jetons Forerunner fusionnent d'abord les représentations textuelles de démonstration du jeton précurseur dans leurs jetons d'étiquette correspondants, de manière sélective en fonction de la compatibilité entre la démonstration et la sémantique de l'étiquette. | |||

| 2024-10-01 | Décomposition d'attention clairsemée appliquée au traçage de circuits | ||

| • Introduit la décomposition de l'attention sparse, utilisant SVD sur les matrices de têtes d'attention pour tracer les chemins de communication dans les modèles GPT-2. • Appliqué au traçage de circuits dans GPT-2 small pour la tâche d'identification indirecte d'objets (IOI). • Identification de signaux de communication clairsemés et fonctionnellement significatifs entre les têtes d'attention, améliorant ainsi l'interprétabilité. | |||

| 2024-09-09 | Dévoilement des têtes à induction : dynamique de formation prouvable et apprentissage des fonctionnalités dans les transformateurs | ||

| • L'article présente un mécanisme de tête d'induction généralisé, expliquant comment les composants du transformateur collaborent pour effectuer un apprentissage en contexte (ICL) sur des chaînes de Markov n-grammes. • Il analyse un transformateur à deux couches d'attention avec un flux gradient pour prédire les jetons dans les chaînes de Markov. • Le flux gradient converge, permettant l'ICL grâce à un mécanisme de tête à induction appris et basé sur des fonctionnalités. | |||

| 2024-08-16 | Une interprétation mécaniste du raisonnement syllogistique dans les modèles linguistiques auto-régressifs | ||

| • L'étude introduit une interprétation mécaniste du raisonnement syllogistique dans les LM, identifiant des circuits de raisonnement indépendants du contenu. • Découverte de circuits pour le raisonnement et l'investigation de la contamination des biais de croyance dans les têtes d'attention. • Identifié un circuit de raisonnement nécessaire, transférable à travers les schémas syllogistiques, mais susceptible d'être contaminé par des connaissances du monde pré-entraînées. | |||

| 2024-08-01 | Améliorer la cohérence sémantique des grands modèles de langage grâce à l'édition de modèles : une approche axée sur l'interprétabilité | ||

| • Introduit une approche d'édition de modèle rentable en se concentrant sur les têtes d'attention pour améliorer la cohérence sémantique dans les LLM sans modifications importantes des paramètres. • Analyse des têtes d'attention, injection de biais et tests sur les ensembles de données NLU et NLG. • Améliorations notables de la cohérence sémantique et de la performance des tâches, avec une forte généralisation à des tâches supplémentaires. | |||

| 2024-07-31 | Corriger les biais négatifs dans les grands modèles linguistiques grâce à l'alignement des scores d'attention négative | ||

| • Introduction du score d'attention négative (NAS) pour quantifier et corriger les préjugés négatifs dans les modèles linguistiques. • Identification des responsables de l'attention biaisée négativement et proposition d'alignement du score d'attention négative (NASA) pour un réglage précis. • La NASA a effectivement réduit l'écart précision-rappel tout en préservant la généralisation dans les tâches de décision binaire. | |||

| 2024-07-29 | Détecter et comprendre les vulnérabilités des modèles de langage via l'interprétabilité mécaniste | ||

| • Présente une méthode utilisant l'interprétabilité mécanistique (MI) pour détecter et comprendre les vulnérabilités des LLM, en particulier les attaques contradictoires. • Analyse GPT-2 Small pour détecter les vulnérabilités liées à la prédiction des acronymes à 3 lettres. • Identifie et explique avec succès les vulnérabilités spécifiques du modèle liées à la tâche. | |||

| 2024-07-22 | RazorAttention : compression efficace du cache KV via les têtes de récupération | ||

| • Introduction de RazorAttention, une technique de compression de cache KV sans formation utilisant des têtes de récupération et des jetons de compensation pour préserver les informations critiques des jetons. • Évaluation de RazorAttention sur des modèles de langage étendus (LLM) pour en vérifier l'efficacité. • Réduction de la taille du cache de plus de 70 % en KV sans impact notable sur les performances. | |||

| 2024-07-21 | Répondre, assembler, réussir : comprendre comment les transformateurs répondent aux questions à choix multiples | ||

| • L'article introduit la projection de vocabulaire et les correctifs d'activation pour localiser les états cachés qui prédisent les réponses correctes au MCQA. • Identifier les principaux responsables de l'attention et les couches responsables de la sélection des réponses dans les transformateurs. • Les têtes d'attention de niveau intermédiaire sont cruciales pour une prédiction précise des réponses, avec un ensemble clairsemé de têtes jouant des rôles uniques. | |||

| 2024-07-09 | Les têtes à induction comme mécanisme essentiel pour la correspondance de modèles dans l'apprentissage en contexte | ||

| • L'article identifie les têtes d'induction comme étant cruciales pour la mise en correspondance de modèles dans l'apprentissage en contexte (ICL). • Évaluation de Llama-3-8B et InternLM2-20B sur la reconnaissance de formes abstraites et les tâches PNL. • L'ablation des têtes d'induction réduit les performances de l'ICL jusqu'à environ 32 %, ce qui les rend presque aléatoires pour la reconnaissance des formes. | |||

| 2024-07-02 | Interprétation du mécanisme arithmétique dans les grands modèles de langage grâce à l'analyse comparative des neurones | ||

| • Présente l'analyse comparative des neurones (CNA) pour cartographier les mécanismes arithmétiques dans les têtes d'attention des grands modèles de langage. • Analyse de la capacité arithmétique, élagage du modèle pour les tâches arithmétiques et édition du modèle pour réduire les préjugés sexistes. • Identifié des neurones spécifiques responsables de l'arithmétique, permettant d'améliorer les performances et d'atténuer les biais grâce à une manipulation ciblée des neurones. | |||

| 2024-07-01 | Pilotage de grands modèles linguistiques pour la recherche d'informations multilingues | ||

| • Présente la récupération multilingue pilotée par activation (ASMR), utilisant des activations de pilotage pour guider les LLM afin d'améliorer la recherche d'informations multilingues. • Identifier les chefs d'attention dans les LLM affectant l'exactitude et la cohérence du langage, et appliquer les activations de pilotage. • ASMR a atteint des performances de pointe sur les benchmarks CLIR tels que XOR-TyDi QA et MKQA. | |||

| 2024-06-25 | Comment les transformateurs apprennent la structure causale avec la descente de gradient | ||

| • Fourni une explication de la façon dont les transformateurs apprennent les structures causales grâce à des algorithmes de formation basés sur le gradient. • Analyser les performances de transformateurs à deux couches sur une tâche appelée séquences aléatoires à structure causale. • La descente de gradient sur un transformateur simplifié à deux couches apprend à résoudre cette tâche en codant le graphe causal latent dans la première couche d'attention. Dans un cas particulier, lorsque des séquences sont générées à partir de chaînes de Markov en contexte, les transformateurs apprennent à développer une tête d'induction. | |||

| 2024-06-21 | MoA : mélange d'attention éparse pour la compression automatique de grands modèles de langage | ||

| • Le document présente le Mixture of Attention (MoA), qui adapte des configurations distinctes d'attention clairsemée pour différentes têtes et couches, optimisant ainsi les compromis entre mémoire, débit et précision-latence. • MoA profile les modèles, explore les configurations d'attention et améliore la compression LLM. • MoA augmente la longueur effective du contexte de 3,9×, tout en réduisant l'utilisation de la mémoire GPU de 1,2 à 1,4×. | |||

| 2024-06-19 | Sur la difficulté d'un raisonnement fidèle en chaîne de pensée dans les grands modèles de langage | ||

| • Introduction de nouvelles stratégies d'apprentissage en contexte, de réglage fin et d'édition d'activation pour améliorer la fidélité du raisonnement en chaîne de pensée (CoT) dans les LLM. • Testé ces stratégies sur plusieurs critères pour évaluer leur efficacité. • Nous n'avons trouvé qu'un succès limité dans l'amélioration de la fidélité au CoT, soulignant le défi de parvenir à un raisonnement véritablement fidèle dans les LLM. | |||

| 2024-06-04 | Tête d'itération : une étude mécaniste de la chaîne de pensée | ||

| • Présente des « têtes d'itération », des têtes d'attention spécialisées qui permettent un raisonnement itératif dans les transformateurs pour les tâches de chaîne de pensée (CoT). • Analyse des mécanismes d'attention, suivi de l'émergence du CoT et test de la transférabilité des compétences CoT entre les tâches. • Les têtes d'itération prennent en charge efficacement le raisonnement CoT, améliorant l'interprétabilité du modèle et l'exécution des tâches. | |||

| 2024-06-03 | LoFiT : mise au point localisée sur les représentations LLM | ||

| • Présente un réglage fin localisé sur les représentations LLM (LoFiT), un cadre en deux étapes pour identifier les chefs d'attention importants d'une tâche donnée et apprendre des vecteurs de décalage spécifiques à la tâche pour intervenir sur les représentations des chefs identifiés. • Identifier des ensembles clairsemés de points d'attention importants pour améliorer la précision en aval sur la véracité et le raisonnement. • LoFiT a surpassé les autres méthodes d'intervention de représentation et a atteint des performances comparables aux méthodes PEFT sur TruthfulQA, CLUTRR et MQuAKE, bien qu'il n'intervienne que sur 10 % du total des têtes d'attention dans les LLM. | |||

| 2024-05-28 | Circuits de connaissances dans les transformateurs pré-entraînés | ||

| • Introduction de « circuits de connaissances » dans les transformateurs, révélant comment des connaissances spécifiques sont codées à travers l'interaction entre les chefs d'attention, les chefs de relation et les MLP. • Analyse de GPT-2 et TinyLLAMA pour identifier les circuits de connaissances ; évalué les techniques d’édition des connaissances. • Démontré comment les circuits de connaissances contribuent à modéliser des comportements comme les hallucinations et l'apprentissage en contexte. | |||

| 2024-05-23 | Relier l'apprentissage en contexte dans les transformateurs à la mémoire épisodique humaine | ||

| • Relie l'apprentissage en contexte dans les modèles Transformer à la mémoire épisodique humaine, en soulignant les similitudes entre les têtes d'induction et le modèle de maintenance et de récupération contextuelles (CMR). • Analyse de LLM basés sur Transformer pour démontrer un comportement de type CMR dans les têtes d'attention. • Des têtes de type CMR émergent dans des couches intermédiaires, reflétant les biais de la mémoire humaine. | |||

| 2024-05-07 | Comment GPT-2 prédit-il les acronymes ? Extraire et comprendre un circuit via l'interprétabilité mécaniste | ||

| • Première étude d'interprétabilité mécaniste sur GPT-2 pour prédire des acronymes multi-tokens à l'aide de têtes d'attention. • Identifié et interprété un circuit de 8 têtes d'attention responsables de la prédiction des acronymes. • Démontré que ces 8 têtes (~5% du total) concentrent la fonctionnalité de prédiction d'acronymes. | |||

| 2024-05-02 | Interprétation et amélioration de grands modèles de langage dans le calcul arithmétique | ||

| • Présente une enquête détaillée sur les mécanismes internes des LLM à travers des tâches mathématiques, en suivant le pipeline « identifier-analyser-affiner ». • Analyser la capacité du modèle à effectuer des tâches arithmétiques impliquant deux opérandes, telles que l'addition, la soustraction, la multiplication et la division. • Nous avons constaté que les LLM impliquent fréquemment une petite fraction (< 5 %) des têtes d'attention, qui jouent un rôle central en se concentrant sur les opérandes et les opérateurs pendant les processus de calcul. | |||

| 2024-05-02 | Que doit faire une tête à induction ? Une étude mécaniste des circuits d'apprentissage en contexte et de leur formation | ||

| • Introduction d'un cadre causal inspiré de l'optogénétique pour étudier la formation de têtes d'induction (IH) dans les transformateurs. • Analyse de l'émergence de l'IH dans les transformateurs à l'aide de données synthétiques et identification de trois sous-circuits sous-jacents responsables de la formation de l'IH. • Découverte que ces sous-circuits interagissent pour piloter la formation d'IH, ce qui coïncide avec un changement de phase dans la perte du modèle. | |||

| 2024-04-24 | La tête de récupération explique mécaniquement la réalité du contexte long | ||

| • Identification des « têtes de récupération » dans les modèles de transformateur responsables de la récupération d'informations dans des contextes longs. • Enquête systématique sur les têtes de récupération à travers divers modèles, y compris l'analyse de leur rôle dans le raisonnement en chaîne de pensée. • L'élagage des têtes de récupération conduit à des hallucinations, tandis que l'élagage des têtes de non-récupération n'affecte pas la capacité de récupération. | |||

| 2024-03-27 | Intervention temporelle d'inférence non linéaire : améliorer la véracité du LLM | ||

| • Introduction de l'intervention temporelle d'inférence non linéaire (NL-ITI), améliorant la véracité du LLM par un sondage et une intervention multi-jetons sans réglage fin. • Évaluation de NL-ITI sur des ensembles de données à choix multiples, y compris TruthfulQA. • Nous avons obtenu une amélioration relative de 16 % de la précision du MC1 sur TruthfulQA par rapport à l'ITI de base. | |||

| 2024-02-28 | Comment penser étape par étape : une compréhension mécaniste du raisonnement en chaîne de pensée | ||

| • Fourni une analyse approfondie du raisonnement médié par CoT dans les LLM en termes de composants fonctionnels neuronaux. • Disséquer le raisonnement basé sur CoT sur le raisonnement fictif comme une composition d'un nombre fixe de sous-tâches qui nécessitent une prise de décision, une copie et un raisonnement inductif, en analysant leur mécanisme séparément. • Nous avons découvert que les têtes d'attention effectuent un mouvement d'information entre des jetons ontologiquement liés (ou négativement liés), ce qui donne lieu à des représentations distinctement identifiables pour ces paires de jetons. | |||

| 2024-02-28 | Couper la tête met fin au conflit : un mécanisme pour interpréter et atténuer les conflits de connaissances dans les modèles linguistiques | ||

| • Présente la méthode PH3 pour élaguer les têtes d'attention conflictuelles, atténuant les conflits de connaissances dans les modèles de langage sans mise à jour des paramètres. • Application de PH3 pour contrôler la dépendance des LM à l'égard de la mémoire interne par rapport au contexte externe et test de son efficacité sur des tâches d'assurance qualité en domaine ouvert. • PH3 a amélioré l'utilisation de la mémoire interne de 44,0 % et l'utilisation du contexte externe de 38,5 %. | |||

| 2024-02-27 | Itinéraires de flux d'informations : interprétation automatique des modèles de langage à grande échelle | ||

| • Introduit les « itinéraires de flux d'informations » utilisant l'attribution pour l'interprétation graphique des modèles de langage, évitant ainsi l'application de correctifs d'activation. • Expériences avec Llama 2, identifiant les principales têtes d'attention et les modèles de comportement dans différents domaines et tâches. • Composants de modèles spécialisés découverts ; identifié des rôles cohérents pour les chefs d'attention, tels que la gestion des jetons de la même partie du discours. | |||

| 2024-02-20 | Identifier les têtes d'induction sémantique pour comprendre l'apprentissage en contexte | ||

| • Identifie et étudie les « têtes d'induction sémantique » dans les grands modèles de langage (LLM) qui sont en corrélation avec les capacités d'apprentissage en contexte. • Analyse des têtes d'attention pour l'encodage des dépendances syntaxiques et des relations entre les graphes de connaissances. • Certains chefs d'attention améliorent les logits de sortie en rappelant les jetons pertinents, cruciaux pour comprendre l'apprentissage en contexte dans les LLM. | |||

| 2024-02-16 | L'évolution des têtes d'induction statistique : les chaînes de Markov d'apprentissage en contexte | ||

| • Présente une tâche de modélisation de séquences de chaînes de Markov pour analyser comment les capacités d'apprentissage en contexte (ICL) émergent dans les transformateurs, formant des « têtes d'induction statistiques ». • Enquête empirique et théorique sur la formation multiphasée des transformateurs sur les tâches de la chaîne de Markov. • Démontre les transitions de phase des prédictions unigrammes aux prédictions bigrammes, influencées par les interactions des couches de transformateur. | |||

| 2024-02-11 | Résumer les faits : mécanismes additifs derrière le rappel factuel dans les LLM | ||

| • Identifie et explique le « motif additif » dans le rappel factuel, où les LLM utilisent de multiples mécanismes indépendants qui interfèrent de manière constructive pour rappeler les faits. • Attribution logit directe étendue pour analyser les têtes d'attention et décompresser le comportement des têtes mixtes. • Démontré que le rappel factuel dans les LLM résulte de la somme de contributions multiples et indépendamment insuffisantes. | |||

| 2024-02-05 | Comment les grands modèles linguistiques apprennent-ils en contexte ? Les requêtes et les matrices clés des têtes en contexte sont deux tours pour l'apprentissage métrique | ||

| • Introduit le concept selon lequel les matrices de requêtes et de clés dans les têtes en contexte fonctionnent comme « deux tours » pour l'apprentissage des métriques, facilitant le calcul de similarité entre les caractéristiques des étiquettes. • Analyser les mécanismes d'apprentissage en contexte; a identifié des sujets d’attention spécifiques cruciaux pour l’ICL. • Réduction de la précision de l'ICL de 87,6 % à 24,4 % en intervenant sur seulement 1 % de ces têtes. | |||

| 2024-01-23 | Apprentissage des langues en contexte : architectures et algorithmes | ||

| • Introduction de « têtes n-gram », des têtes d'attention spécialisées pour Transformer, améliorant l'apprentissage du langage en contexte (ICLL) grâce à la prédiction de jetons conditionnelle à l'entrée. • Évaluation de modèles neuronaux sur des langages réguliers à partir d'automates finis aléatoires. • Les têtes n-gram câblées ont amélioré la perplexité de 6,7 % sur l'ensemble de données SlimPajama. | |||

| 2024-01-16 | La base mécaniste de la dépendance aux données et de l'apprentissage brutal dans une tâche de classification en contexte | ||

| • L'article modélise la base mécaniste de l'apprentissage en contexte (ICL) via la formation abrupte de têtes d'induction dans des réseaux d'attention uniquement. • Tâches ICL simulées à l'aide de données d'entrée simplifiées et d'un réseau basé sur l'attention à deux couches. • La formation de têtes d'induction entraîne la transition abrupte vers l'ICL, tracée à travers des non-linéarités imbriquées. | |||

| 2024-01-16 | Réutilisation des composants de circuit entre les tâches dans les modèles de langage Transformer | ||

| • L'article démontre que des circuits spécifiques dans GPT-2 peuvent se généraliser à différentes tâches, remettant en question la notion selon laquelle de tels circuits sont spécifiques à une tâche. • Il examine la réutilisation des circuits de la tâche d'identification indirecte d'objets (IOI) dans la tâche Objets colorés. • L'ajustement de quatre têtes d'attention augmente la précision de 49,6 % à 93,7 % dans la tâche Objets colorés. | |||

| 2024-01-16 | Têtes successeurs : têtes d'attention récurrentes et interprétables dans la nature | ||

| • L'article présente les « têtes de successeur », des têtes d'attention dans les LLM qui incrémentent les jetons avec un ordre naturel, comme les jours ou les nombres. • Il analyse la formation des têtes successeurs sur différentes tailles de modèles et architectures, telles que GPT-2 et Llama-2. • Les têtes successives se retrouvent dans des modèles allant de 31M à 12B paramètres, révélant des représentations numériques abstraites et récurrentes. | |||

| 2024-01-16 | Vecteurs de fonctions dans les grands modèles de langage | ||

| • L'article présente les « vecteurs de fonctions (FV) », des représentations causales compactes de tâches au sein de modèles de transformateurs autorégressifs. • Les FV ont été testés sur diverses tâches, modèles et couches d'apprentissage en contexte (ICL). • Les FV peuvent être additionnés pour créer des vecteurs qui déclenchent de nouvelles tâches complexes, démontrant la composition vectorielle interne. | |||

| Date | Article et résumé | Balises | Links |

| 2023-12-23 | Recherche des faits : tentative de rétro-ingénierie du rappel factuel au niveau des neurones | ||

| • Enquête sur la manière dont les premières couches MLP de Pythia 2.8B codent le rappel factuel à l'aide de circuits distribués, en se concentrant sur la superposition et l'intégration de plusieurs jetons. • Exploration de la recherche factuelle dans les couches MLP, test d'hypothèses sur les mécanismes de détokenisation et de hachage. • Le rappel factuel fonctionne comme une table de recherche distribuée sans mécanismes internes facilement interprétables. | |||

| 2023-11-07 | Vers une continuation de séquence interprétable : analyse de circuits partagés dans de grands modèles de langage | ||

| • Démontré l'existence de circuits partagés pour des tâches de continuation de séquence similaires. • Circuits analysés et comparés pour des tâches de continuation de séquences similaires, qui incluent des séquences croissantes de chiffres arabes, de mots numériques et de mois. • Les séquences sémantiquement liées s'appuient sur des sous-graphes de circuits partagés avec des rôles analogues et sur la découverte de sous-circuits similaires dans des modèles dotés de fonctionnalités analogues. | |||

| 2023-10-23 | Représentations linéaires du sentiment dans les grands modèles linguistiques | ||

| • L'article identifie une direction linéaire dans l'espace d'activation qui capture la représentation des sentiments dans les grands modèles linguistiques (LLM). • Ils ont isolé cette direction de sentiment et l'ont testée sur des tâches telles que Stanford Sentiment Treebank. • L'ablation de cette direction de sentiment entraîne une réduction de 76 % de la précision de la classification, soulignant ainsi son importance. | |||

| 2023-10-06 | Suppression de copie : comprendre globalement un responsable de l'attention | ||

| • L'article introduit le concept de suppression de copie dans une petite tête d'attention GPT-2 (L10H7), qui réduit la copie naïve de jetons, améliorant ainsi l'étalonnage du modèle. • L'article étudie et explique le mécanisme de suppression des copies et son rôle dans l'auto-réparation . • 76,9 % de l'impact de L10H7 dans GPT-2 Small est expliqué, ce qui en fait la description la plus complète du rôle d'un responsable de l'attention. | |||

| 2023-09-22 | Intervention en temps d'inférence : obtenir des réponses véridiques à partir d'un modèle de langage | ||

| • Introduction de l'intervention en temps d'inférence (ITI) pour améliorer la véracité du LLM en ajustant les activations du modèle dans certaines têtes d'attention. • Amélioration des performances du modèle LLaMA sur le benchmark TruthfulQA. • ITI a augmenté la véracité du modèle Alpaca de 32,5 % à 65,1 %. | |||

| 2023-09-22 | Naissance d'un transformateur : un point de vue mémoire | ||

| • L'article présente une perspective basée sur la mémoire sur les transformateurs, mettant en évidence les mémoires associatives dans les matrices de poids et leur apprentissage basé sur les gradients. • Analyse empirique de la dynamique d'entraînement sur un modèle de transformateur simplifié avec données synthétiques. • Découverte de l'apprentissage rapide des bigrammes globaux et de l'émergence plus lente d'une « tête d'induction » pour les bigrammes en contexte. | |||

| 2023-09-13 | Chutes soudaines de perte : acquisition de syntaxe, transitions de phase et biais de simplicité dans les MLM | ||

| • Identifie la structure d'attention syntaxique (SAS) comme une propriété émergente naturellement dans les modèles de langage masqué (MLM) et son rôle dans l'acquisition de la syntaxe. • Analyse le SAS pendant la formation et le manipule pour étudier son effet causal sur les capacités grammaticales. • SAS est nécessaire au développement de la grammaire, mais sa suppression brève améliore les performances du modèle. | |||

| 2023-07-18 | L’interprétabilité de l’analyse de circuit est-elle évolutive ? Preuve des capacités à choix multiples chez Chinchilla | ||

| • Analyse de circuits évolutive appliquée à un modèle de langage Chinchilla 70B pour comprendre les réponses aux questions à choix multiples. • Attribution de logit, visualisation des modèles d'attention et correctifs d'activation pour identifier et catégoriser les principaux responsables de l'attention. • Identification de la fonctionnalité "Nième élément d'une énumération" dans les têtes d'attention, bien qu'il ne s'agisse que d'une explication partielle. | |||

| 2023-02-02 | Interprétabilité à l'état sauvage : un circuit pour l'identification indirecte d'objets dans GPT-2 small | ||

| • L'article présente une explication détaillée de la manière dont GPT-2 small effectue l'identification indirecte d'objets (IOI) à l'aide d'un grand circuit impliquant 28 têtes d'attention regroupées en 7 classes. • Ils ont procédé à une ingénierie inverse de la tâche IOI dans GPT-2 small en utilisant des interventions et des projections causales. • L'étude démontre que l'interprétabilité mécaniste des grands modèles de langage est réalisable. | |||

| Date | Article et résumé | Balises | Links |

| 2022-03-08 | Responsables de l'apprentissage et de l'intégration en contexte | ||

| • L'article identifie des « têtes d'induction » dans les modèles Transformer, qui permettent un apprentissage en contexte en reconnaissant et en copiant des modèles dans des séquences. • Analyse les modèles d'attention et les têtes d'induction à travers différentes couches dans différents modèles de Transformer. • Nous avons découvert que les têtes à induction sont essentielles pour permettre aux Transformers de généraliser et d'effectuer efficacement des tâches d'apprentissage en contexte. | |||

| 2021-12-22 | Un cadre mathématique pour les circuits de transformateur | ||

| • Présente un cadre mathématique pour procéder à l'ingénierie inverse de petits transformateurs d'attention uniquement, en se concentrant sur la compréhension des têtes d'attention en tant que composants indépendants et additifs. • Analyse des transformateurs zéro, une et deux couches pour identifier le rôle des têtes d'attention dans le mouvement et la composition de l'information. • Découverte des « têtes d'induction », cruciales pour l'apprentissage en contexte dans les transformateurs à deux couches. | |||

| 2021-05-18 | L'hypothèse des chefs : une approche statistique unificatrice pour comprendre l'attention multidirectionnelle dans BERT | ||

| • L'article propose une nouvelle méthode appelée « Sparse Attention » qui réduit la complexité informatique des mécanismes d'attention en se concentrant sélectivement sur les jetons importants. • La méthode a été évaluée sur des tâches de traduction automatique et de classification de textes. • Le modèle d'attention clairsemée atteint une précision comparable à celle d'une attention dense tout en réduisant considérablement le coût de calcul. | |||

| 2021-04-01 | Les chefs d'attention du BERT ont-ils appris la grammaire de circonscription ? | ||

| • L'étude introduit une méthode de distance syntaxique pour analyser la grammaire de circonscription dans les têtes d'attention BERT et RoBERTa. • La grammaire des circonscriptions a été extraite et analysée avant et après le réglage des tâches SMS et NLI. • Les tâches NLI augmentent la capacité d'induction de la grammaire de circonscription, tandis que les tâches SMS la diminuent dans les couches supérieures. | |||

| 2019-11-27 | Les chefs d'attention dans BERT suivent-ils les dépendances syntaxiques ? | ||

| • L'article étudie si les têtes d'attention individuelles dans BERT capturent les dépendances syntaxiques, en utilisant des poids d'attention pour extraire les relations de dépendance. • Analysé les têtes d'attention de Bert en utilisant des poids d'attention maximale et des arbres couvrant maximum, en les comparant aux arbres de dépendance universels. • Certaines têtes d'attention suivent mieux les dépendances syntaxiques spécifiques que les lignes de base, mais aucune tête ne fait de l'analyse holistique nettement mieux. | |||

| 2019-11-01 | Transformers clairsemés de manière adaptative | ||

| • Introduit le transformateur clairsemé de manière adaptative à l'aide d'Alpha-entmax pour permettre une rareté flexible et dépendante du contexte dans les têtes d'attention. • Appliqué aux ensembles de données de traduction automatique pour évaluer l'interprétabilité et la diversité de la tête. • A réalisé diverses distributions d'attention et amélioré l'interprétabilité sans compromettre la précision. | |||

| 2019-08-01 | Que regarde Bert? Une analyse de l'attention de Bert | ||

| • L'article introduit des méthodes pour analyser les mécanismes d'attention de Bert, révélant des modèles qui s'alignent sur les structures linguistiques comme la syntaxe et la coreférence. • Analyse des têtes d'attention, identification des modèles syntaxiques et coreférentiels et développement d'un classificateur de sondage basé sur l'attention. • Les têtes d'attention de Bert capturent des informations syntaxiques substantielles, en particulier dans les tâches comme l'identification des objets directs et de la coréférence. | |||

| 2019-07-01 | Analyse de l'auto-attention à plusieurs têtes: les têtes spécialisées font le gros levage, le reste peut être taillé | ||

| • Le document introduit une nouvelle méthode d'élagage pour l'auto-atténuer de la tête qui élimine sélectivement les têtes moins importantes sans perte de performances majeure. • Analyse des têtes d'attention individuelles, identification de leurs rôles spécialisés et application d'une méthode d'élagage sur le modèle de transformateur. • L'élagage 38 des 48 têtes dans l'encodeur n'a conduit qu'à une baisse de score de 0,15 BLEU. | |||

| 2018-11-01 | Une analyse des représentations d'encodeur dans la traduction automatique basée sur les transformateurs | ||

| • Cet article analyse les représentations internes des couches d'encodeur de transformateur, en se concentrant sur les informations syntaxiques et sémantiques apprises par les têtes d'auto-agencement. • Probandation de tâches, extraction de la relation de dépendance et scénario d'apprentissage du transfert. • Les couches inférieures capturent la syntaxe, tandis que les couches plus élevées codent plus d'informations sémantiques. | |||

| 2016-03-21 | Incorporer le mécanisme de copie dans l'apprentissage de séquence à séquence | ||

| • introduit un mécanisme de copie dans les modèles de séquence à séquence pour permettre la copie directe des jetons d'entrée, améliorant la manipulation de mots rares. • Appliqué aux tâches de traduction et de résumé machine. • a réalisé des améliorations substantielles de la précision de la traduction, en particulier sur la traduction de mots rares, par rapport aux modèles de séquence à séquence standard. | |||

Modèle d'émission:

Title: [paper's title]

Head: [head name1] (, [head name2] ...)

Published: [arXiv / ACL / ICLR / NIPS / ...]

Summary:

- Innovation:

- Tasks:

- Significant Result: