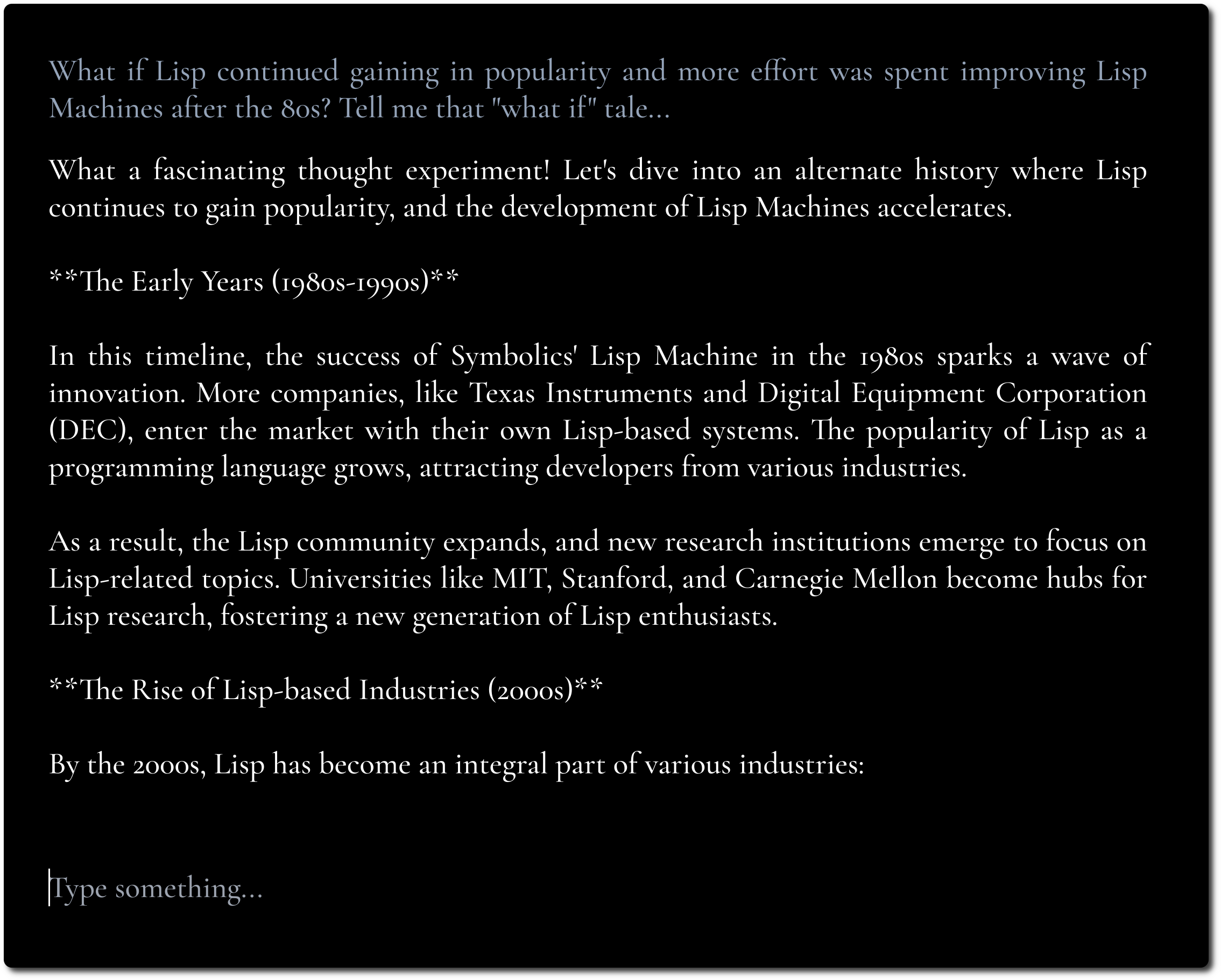

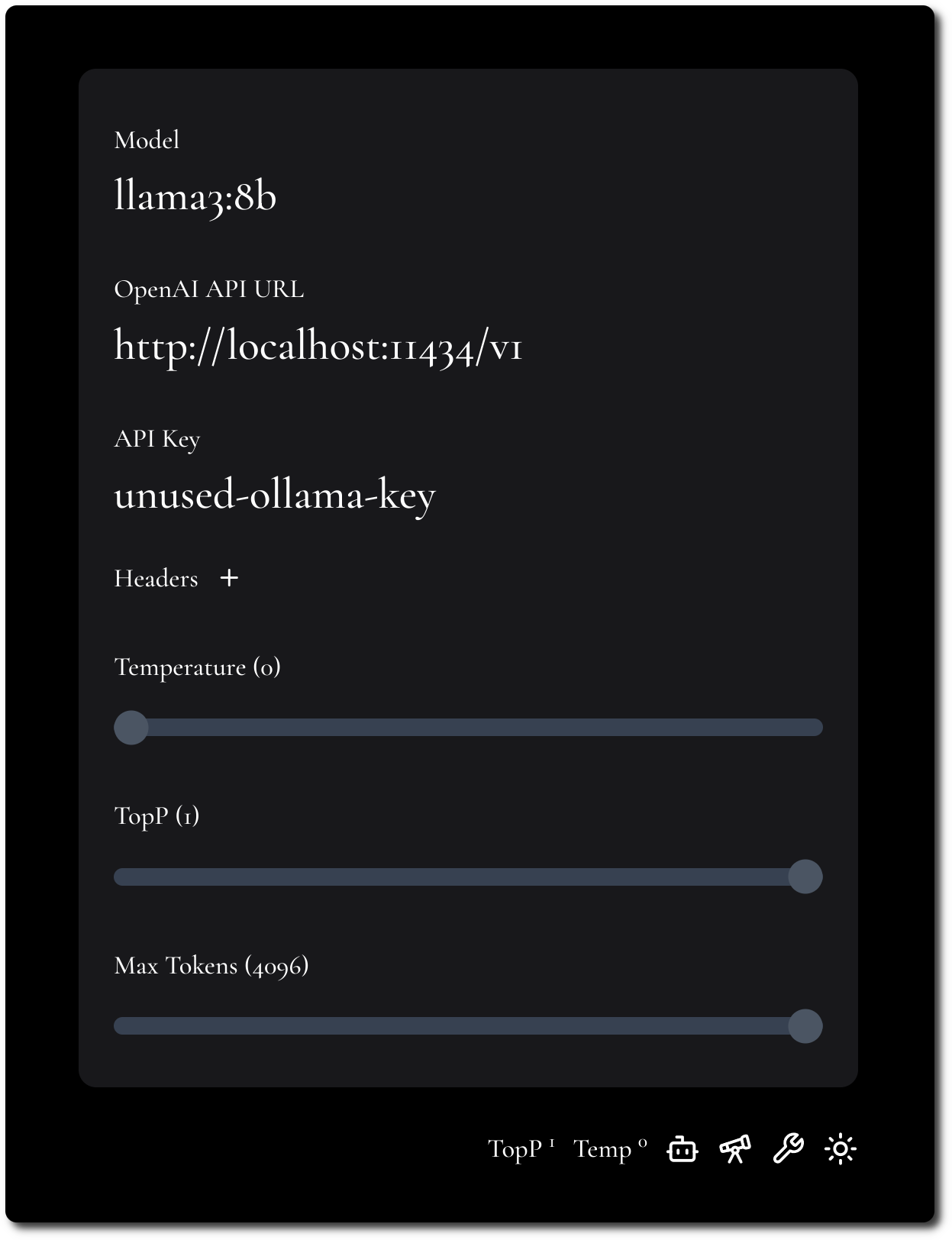

Une interface utilisateur de chat LLM minimaliste, inspirée de Fooocus et Pi.

Si vous disposez d'un point de terminaison d'API compatible CORS à utiliser, vous pouvez l'essayer ici.

L’objectif est de se concentrer sur le contenu et de cacher autant de bricolages et d’ajustements que possible.

Nous mettons l'accent sur le contenu en utilisant une typographie audacieuse et un design minimaliste.

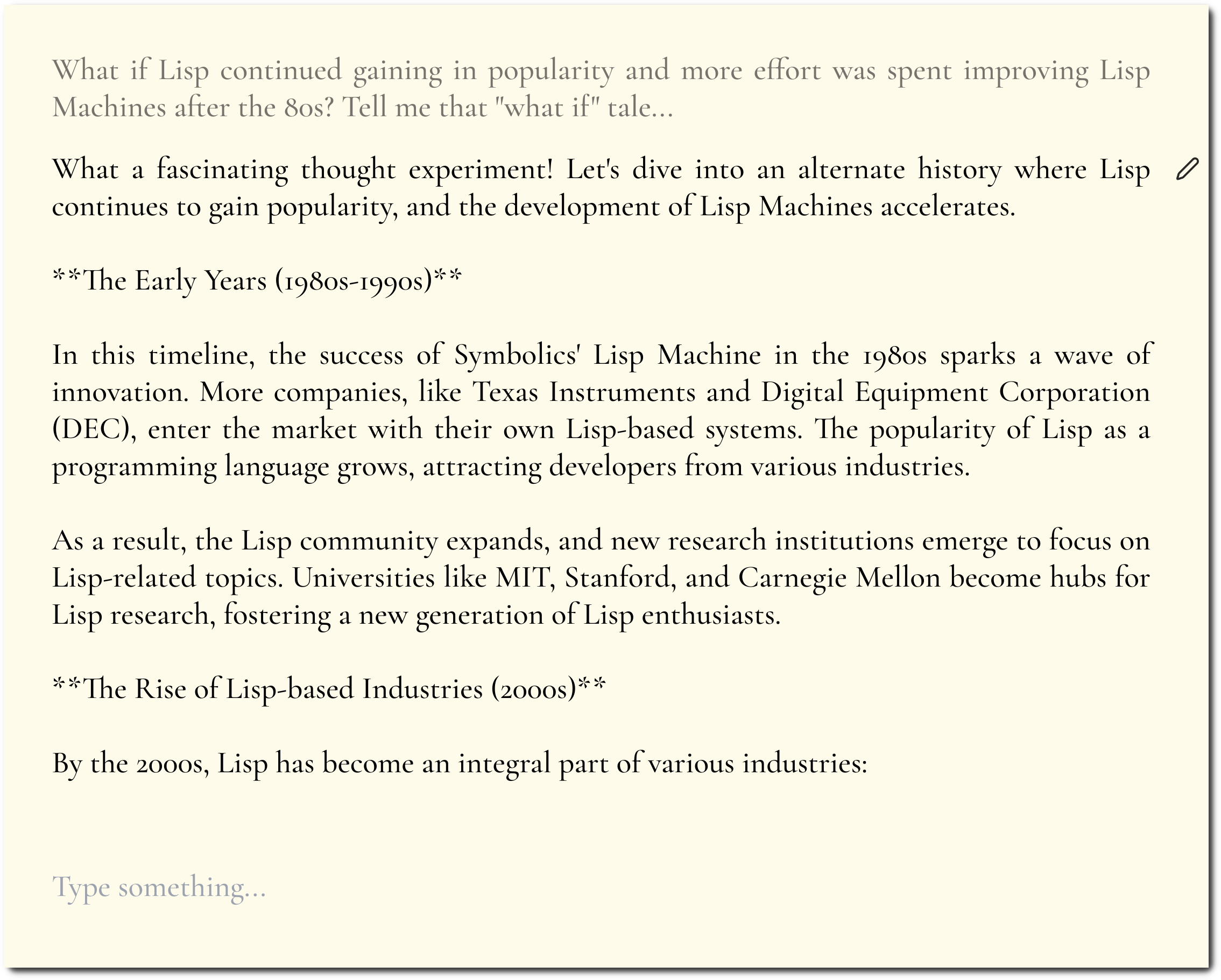

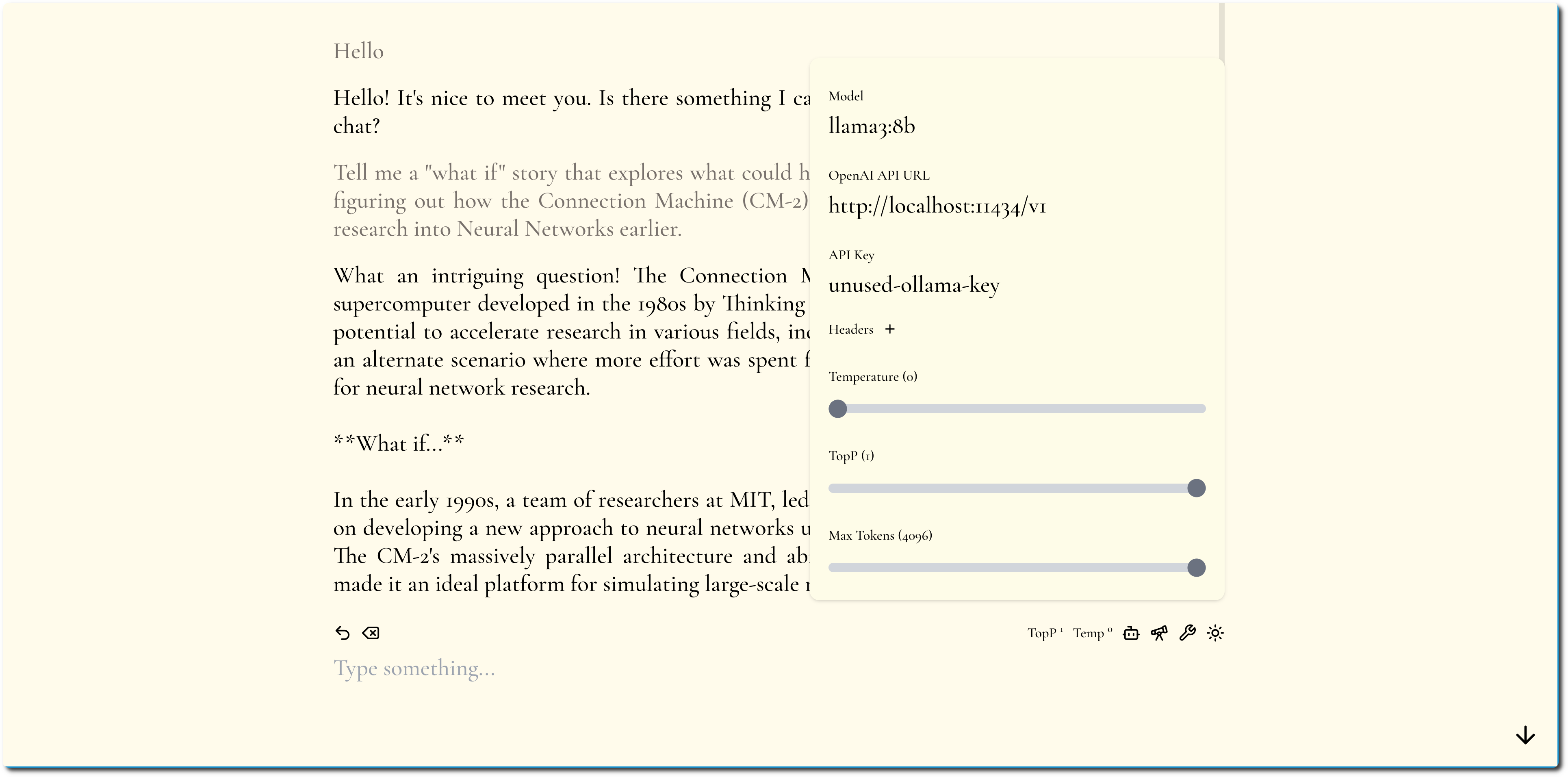

Nous essayons de garder une configuration minimale mais flexible.

MiniChat prend en charge les API compatibles OpenAI, consultez la section Docker Compose pour exécuter MiniChat avec divers fournisseurs de modèles en tirant parti de passerelles telles que Portkey.

Vous pouvez exécuter MiniChat avec Docker, l'image fait moins de 2 Mo.

docker run -p 3216:3216 ghcr.io/functorism/minichat:master

Courir

docker compose -f docker-compose-ollama.yml up

docker exec minichat-ollama-1 ollama pull llama3:8b

Paramètres de l'interface utilisateur :

Courir

docker compose -f docker-compose-portkey.yml up

Paramètres de l'interface utilisateur :

Courir

docker compose -f docker-compose-tf-tgi.yml up

Paramètres de l'interface utilisateur :