Une application développée sur UniAI et inspirée de KimiChat , offrant une intégration avec plusieurs modèles d'IA.

中文说明

Nous nous inspirons de Moonshot et de son produit, KimiChat. Cela nous a amené à développer et à rendre open source LeChat Pro , une plateforme d'analyse de documents et de chat de questions-réponses basée sur des modèles d'IA génératifs et des graphiques de connaissances. LeChat Pro prend en charge l'analyse d'une suite complète de documents Office, de PDF, d'images et bien plus encore, présentés dans un format de discussion similaire à ChatGPT.

Notre projet est simple et axé sur la communauté, s'appuyant sur des contributions open source pour améliorer les fonctionnalités. Nous vous invitons à nous rejoindre pour mettre à niveau LeChat !

Bien que nous manquions de ressources pour former nos propres grands modèles de langage, cela nous offre une flexibilité dans le choix du modèle, permettant l'intégration avec n'importe quel modèle. Actuellement, LeChat Pro prend en charge :

Vous pouvez connecter des modèles supplémentaires en contribuant à notre autre projet open source, UniAI, qui est la bibliothèque principale pour la prise en charge multimodèle de LeChat.

Si vous préférez les modèles open source aux modèles commerciaux, nous proposons la prise en charge du modèle GLM. Pour le déploiement, veuillez suivre les instructions sur https://github.com/uni-openai/GLM-API, puis configurer les variables d'environnement backend pour ajouter l'adresse GLM_API .

Faites-en l'expérience ici :

https://lechat.cas-ll.cn

Dépôt backend open source :

https://github.com/uni-openai/uniai-maas

Bibliothèque principale UniAI :

https://github.com/uni-openai/uniai

Référentiel de mini-programmes :

https://github.com/uniai-lab/lechat-miniapp-v1

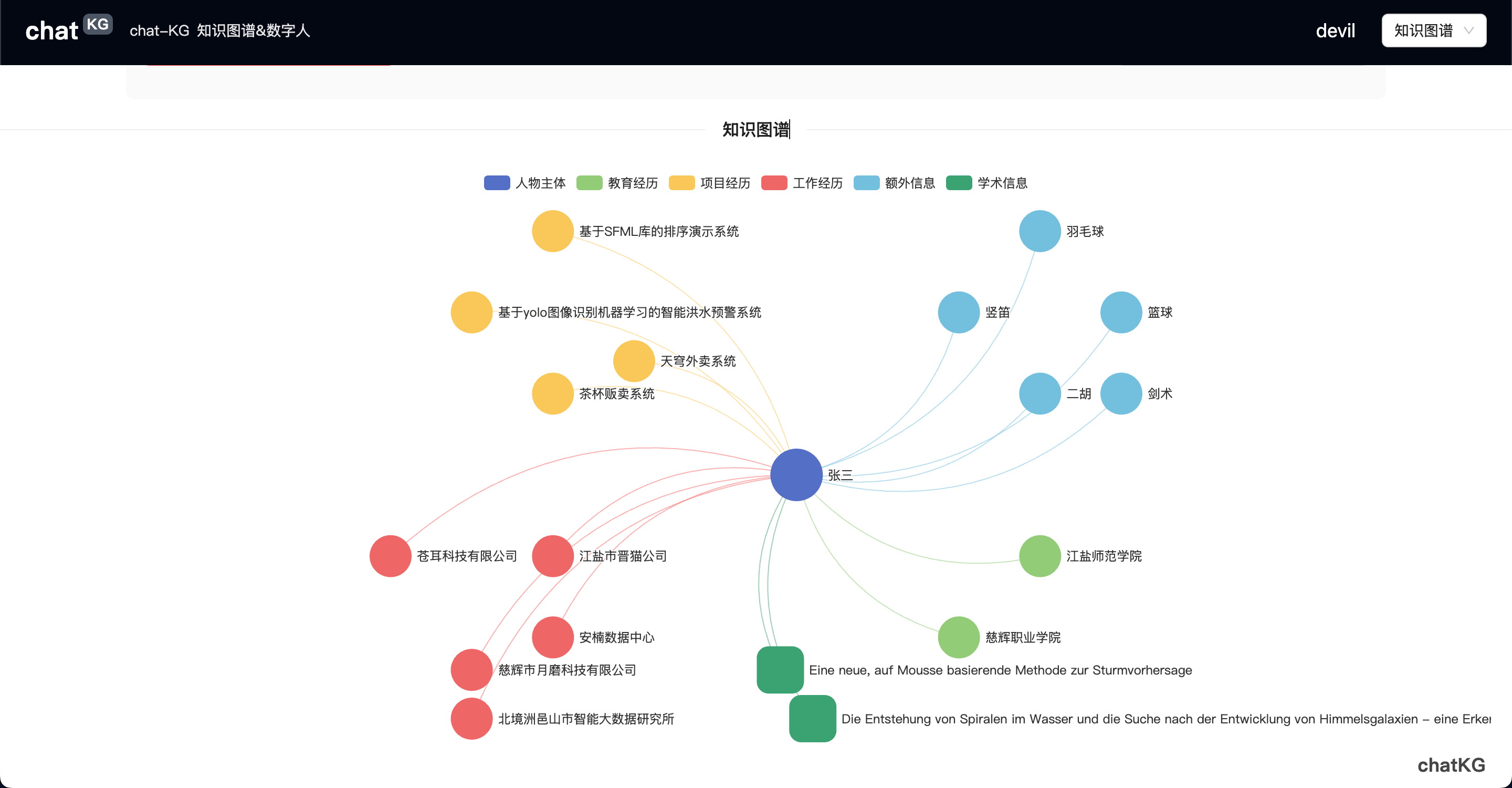

Nous développons une fonctionnalité innovante de chat basée sur des graphiques de connaissances : ChatKG .

Remarque : ce projet nécessite le framework backend UniAI. Déployez-le ici.

Avant de commencer, assurez-vous que Node.js est installé. Sinon, téléchargez-le ici.

Une fois configuré, accédez au répertoire racine du projet et exécutez les commandes suivantes pour démarrer :

npm install

npm run devOu

yarn

yarn devEn cas de succès, vous verrez généralement un résultat similaire à :

VITE v3.2.5 ready in 294 ms

➜ Local: http://localhost:5173/

➜ Network: use --host to expose Maintenez Ctrl ou Command et cliquez sur le lien Local pour ouvrir le projet dans votre navigateur. Vous pouvez vous connecter avec un code QR ou un code de vérification mobile pour commencer à utiliser l'application.

Si vous envisagez de packager le projet pour un déploiement local, voir ici.

Weilong Yu

Youwei Huang

Ce projet est sous licence MIT.