"C'est comme si AutoGPT avait une brew install ", rendue possible par Kurtosis.

REMARQUE : Cela fonctionne désormais avec la version 0.4.0 qui supprime la prise en charge de Milvus, Weaviate et PineCone. Vous pouvez exécuter Kurtosis contre 0.3.1 en effectuant kurtosis run github.com/kurtosis-tech/[email protected] avec les arguments souhaités

YOUR_API_KEY_HERE par votre clé API OpenAI) kurtosis run github.com/kurtosis-tech/autogpt-package --enclave autogpt ' {"OPENAI_API_KEY": "YOUR_API_KEY_HERE"} 'kurtosis service shell autogpt autogpt --exec " python -m autogpt "

YOUR_API_KEY_HERE par votre clé API OpenAI) kurtosis run github.com/kurtosis-tech/autogpt-package --enclave autogpt ' {"OPENAI_API_KEY": "YOUR_API_KEY_HERE"} 'kurtosis service shell autogpt autogptpuis dans l'invite :

> python -m autogpt kurtosis enclave rm -f autogpt

Pour transmettre l'une des valeurs de configuration AutoGPT répertoriées ici, transmettez l'argument en tant que propriété de l'objet JSON que vous transmettez à Kurtosis, tout comme vous l'avez transmis dans OPENAI_API_KEY .

Par exemple, voici comment transmettre l'indicateur RESTRICT_TO_WORKSPACE :

kurtosis run github.com/kurtosis-tech/autogpt-package --enclave autogpt ' {"OPENAI_API_KEY": "YOUR_API_KEY_HERE", "RESTRICT_TO_WORKSPACE": "False"} ' REMARQUE : ce package lance AutoGPT en utilisant le backend local par défaut. D'autres backends sont disponibles en définissant le paramètre MEMORY_BACKEND dans l'objet JSON que vous transmettez lorsque vous exécutez la commande kurtosis run ci-dessus.

Par exemple, pour définir le backend de la mémoire redis :

kurtosis run github.com/kurtosis-tech/autogpt-package --enclave autogpt ' {"OPENAI_API_KEY": "YOUR_API_KEY_HERE", "MEMORY_BACKEND": "redis"} 'REMARQUE : Redis ne fonctionne pas avec la version 0.4.0 pour l'instant

Pour exécuter avec une image différente de celle codée en dur dans main.star utilisez

kurtosis run github.com/kurtosis-tech/autogpt-package --enclave autogpt ' {"OPENAI_API_KEY": "YOUR_API_KEY_HERE", "AUTOGPT_IMAGE": "significantgravitas/auto-gpt:v0.4.0"} ' Kurtosis prend en charge l'indicateur de configuration ALLOWLISTED_PLUGINS fourni avec AutoGPT. Par exemple, pour exécuter le plugin AutoGPTTwitter procédez comme suit :

kurtosis run github.com/kurtosis-tech/autogpt-package --enclave autogpt ' {"OPENAI_API_KEY": "YOUR_API_KEY_HERE", "ALLOWLISTED_PLUGINS": "AutoGPTTwitter"} 'Pour faire fonctionner plusieurs plugins en même temps ; séparez-les par des virgules sans espaces comme ceci :

kurtosis run github.com/kurtosis-tech/autogpt-package --enclave autogpt '{"OPENAI_API_KEY": "YOUR_API_KEY_HERE", "ALLOWLISTED_PLUGINS": "AutoGPTTwitter,AutoGPTEmailPlugin"}'

Sous le capot, Kurtosis téléchargera et installera le package pour vous.

À partir de maintenant, les plugins suivants sont pris en charge :

Pour ajouter la prise en charge de plus de plugins, créez simplement un problème ou créez un PR en ajoutant une entrée à plugins.star .

Nous comprenons qu’OpenAI peut coûter cher à certaines personnes ; de plus en plus, certaines personnes pourraient essayer de l'utiliser avec leurs propres modèles. AutoGPT-Package prend en charge l'exécution d'AutoGPT sur un modèle GPT4All qui s'exécute via LocalAI . Pour utiliser un modèle local -

kurtosis run github.com/kurtosis-tech/autogpt-package ' {"GPT_4ALL": true} ' Ceci utilise la valeur par défaut du modèle https://gpt4all.io/models/ggml-gpt4all-j.bin

Pour utiliser un modèle différent, essayez le paramètre MODEL_URL comme -

kurtosis run github.com/kurtosis-tech/autogpt-package ' {"GPT_4ALL": true, "MODEL_URL": "https://gpt4all.io/models/ggml-gpt4all-l13b-snoozy.bin"} ' Pour développer sur ce package, clonez ce dépôt et exécutez ce qui suit :

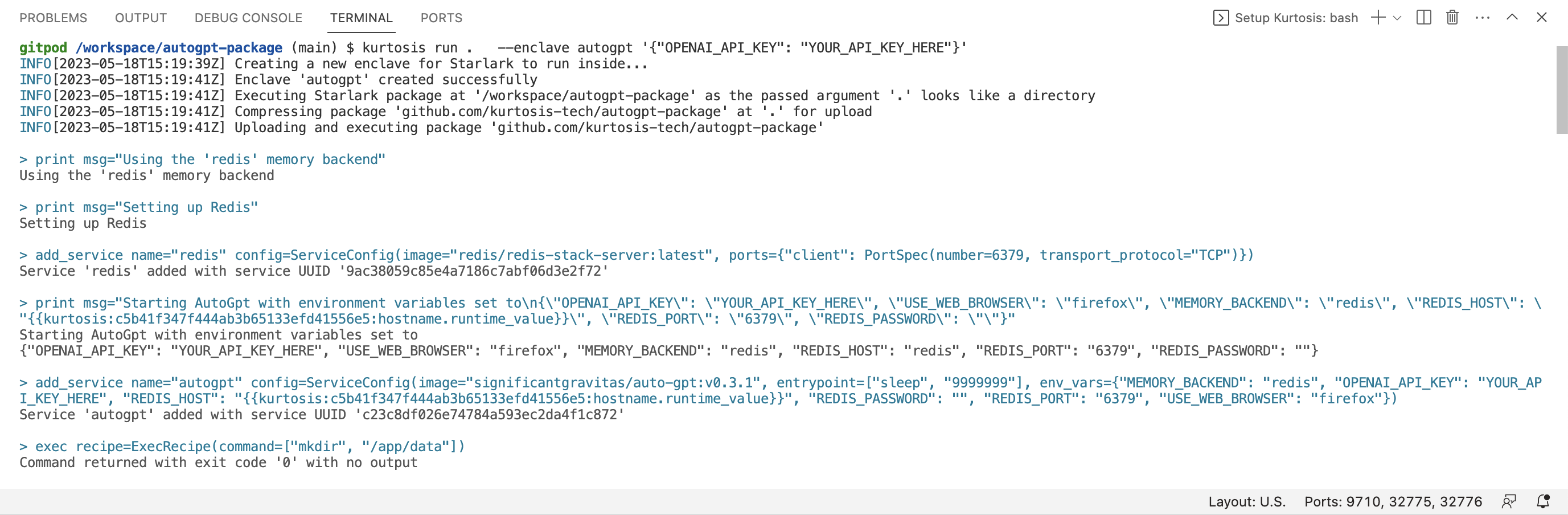

kurtosis run . --enclave autogpt ' {"OPENAI_API_KEY": "YOUR_API_KEY_HERE"} ' Notez le . - cela indique à Kurtosis d'utiliser la version du package sur votre machine locale (plutôt que la version sur Github).

Kurtosis dispose également d'une extension disponible sur le marché VSCode qui fournit la coloration syntaxique et la saisie semi-automatique pour le Starlark qui compose ce package.

Faites-le-nous savoir sur notre Discord ou sur Twitter @KurtosisTech !

N'hésitez pas à créer un problème sur GitHub si vous avez des bugs ou des demandes de fonctionnalités.