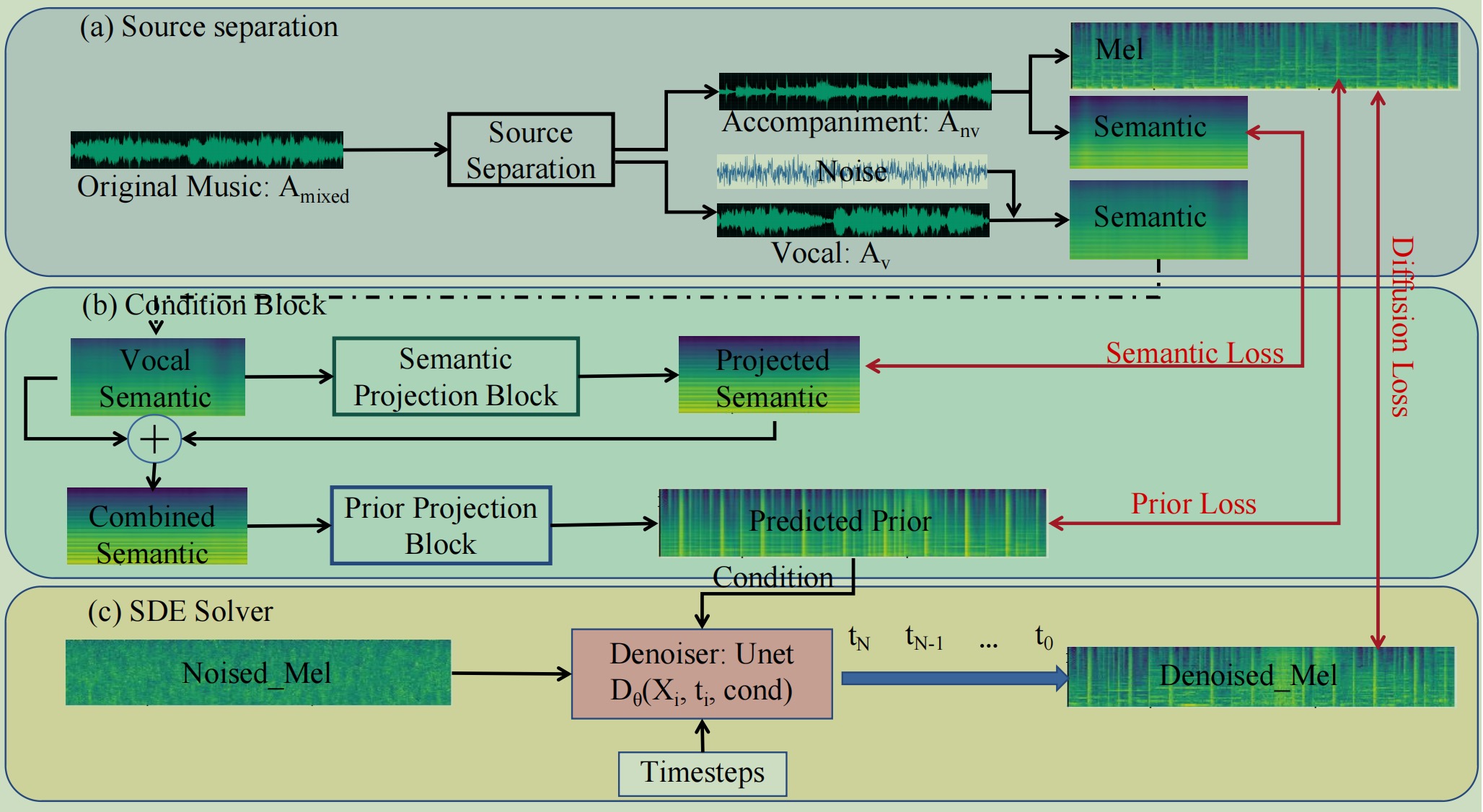

Il s'agit d'une implémentation PyTorch/GPU de l'article IJCAI 2024 FastSAG : Towards Fast Non-Autoregressive Singing Accompaniment Generation. La page de démonstration peut être trouvée sur démo.

@article{chen2024fastsag,

title={FastSAG: Towards Fast Non-Autoregressive Singing Accompaniment Generation},

author={Chen, Jianyi and Xue, Wei and Tan, Xu and Ye, Zhen and Liu, Qifeng and Guo, Yike},

journal={arXiv preprint arXiv:2405.07682},

year={2024}

}Téléchargez ce code :

git clone https://github.com/chenjianyi/fastsag/ cd fastsag

Téléchargez le point de contrôle fastsag à partir d'ici et mettez tous les poids dans fastsag/weights

Les points de contrôle BigvGAN peuvent être téléchargés depuis BigvGAN. Le point de contrôle que nous avons utilisé est "bigvgan_24khz_100band". Je mets à niveau BigvGAN vers BigvGAN-v2 et les points de contrôle seront téléchargés automatiquement.

Les points de contrôle pré-entraînés MERT seraient téléchargés automatiquement à partir de Huggingface. Veuillez vous assurer que votre serveur peut accéder à Huggingface.

Séparation des sources :

cd preprocessing python3 demucs_processing.py # you may need to change root_dir and out_dir in this file

découpage à 10 s et filtrage des clips saillants

python3 clip_to_10s.py # change src_root and des_root for your dataset

cd ../sde_diffusion python3 train.py --data_dir YOUR_TRAIN_DATA --data_dir_testset YOUR_TEST_DATA --results_folder RESULTS

python3 generate.py --ckpt TRAINED_MODEL --data_dir DATA_DIR --result_dir OUTPUT

Diplômé-TTS.

CoMoDiscours