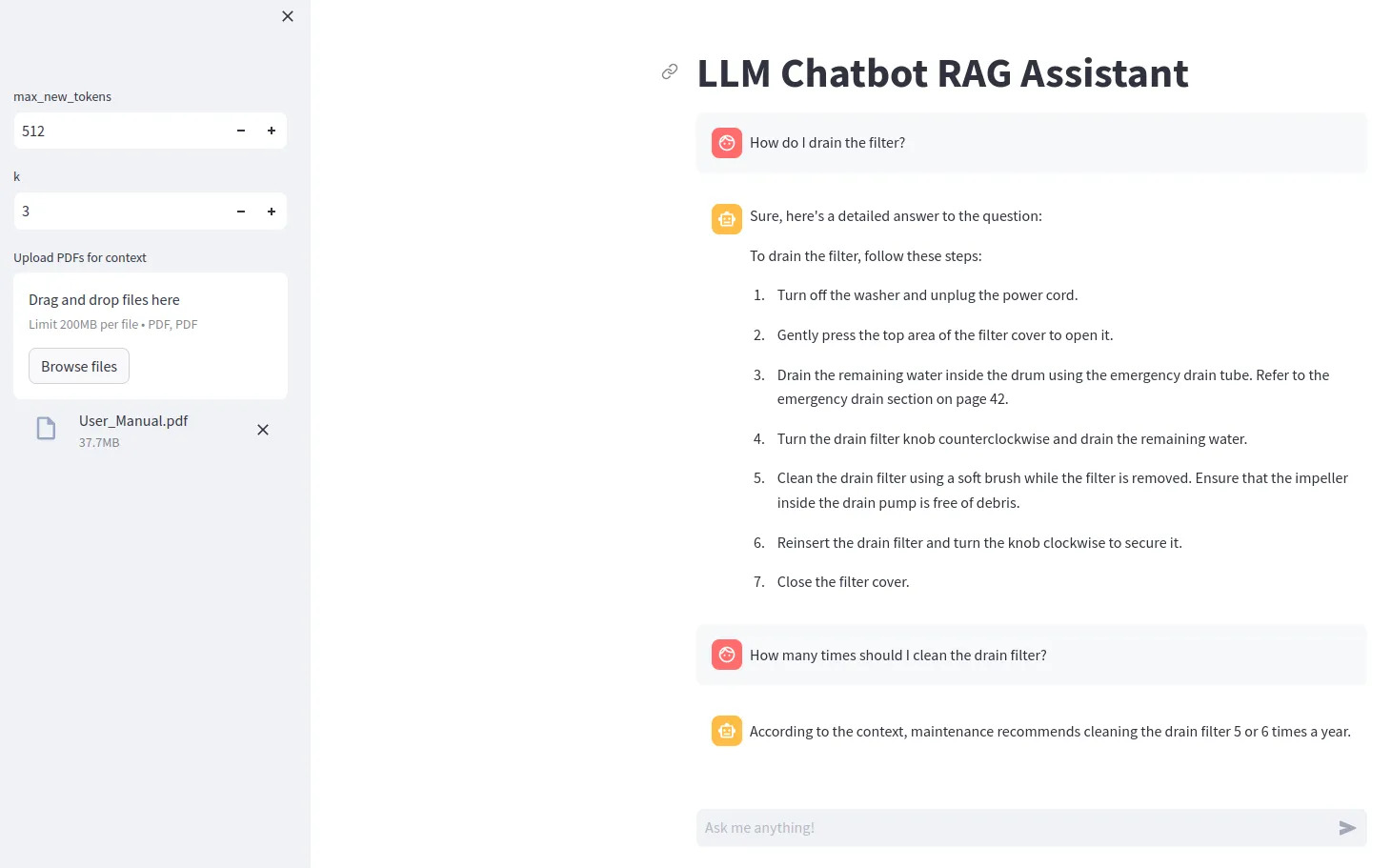

llm chatbot rag

1.0.0

Pour utiliser certains modèles LLM (comme Gemma), vous devez créer un fichier .env contenant la ligne ACCESS_TOKEN=<your hugging face token>

Installez les dépendances avec pip install -r requirements.txt

Exécuter avec streamlit run src/app.py

Pour utiliser la quantification bitsandbytes, un GPU Nvidia est requis. Assurez-vous d'installer d'abord NVIDIA Toolkit, puis PyTorch.

Vous pouvez vérifier si votre GPU est disponible en Python avec

import torch

print(torch.cuda.is_available())

Si vous ne disposez pas d'un GPU compatible, essayez de définir device="cpu" pour le modèle et supprimez la configuration de quantification.