??Chinois | Anglais

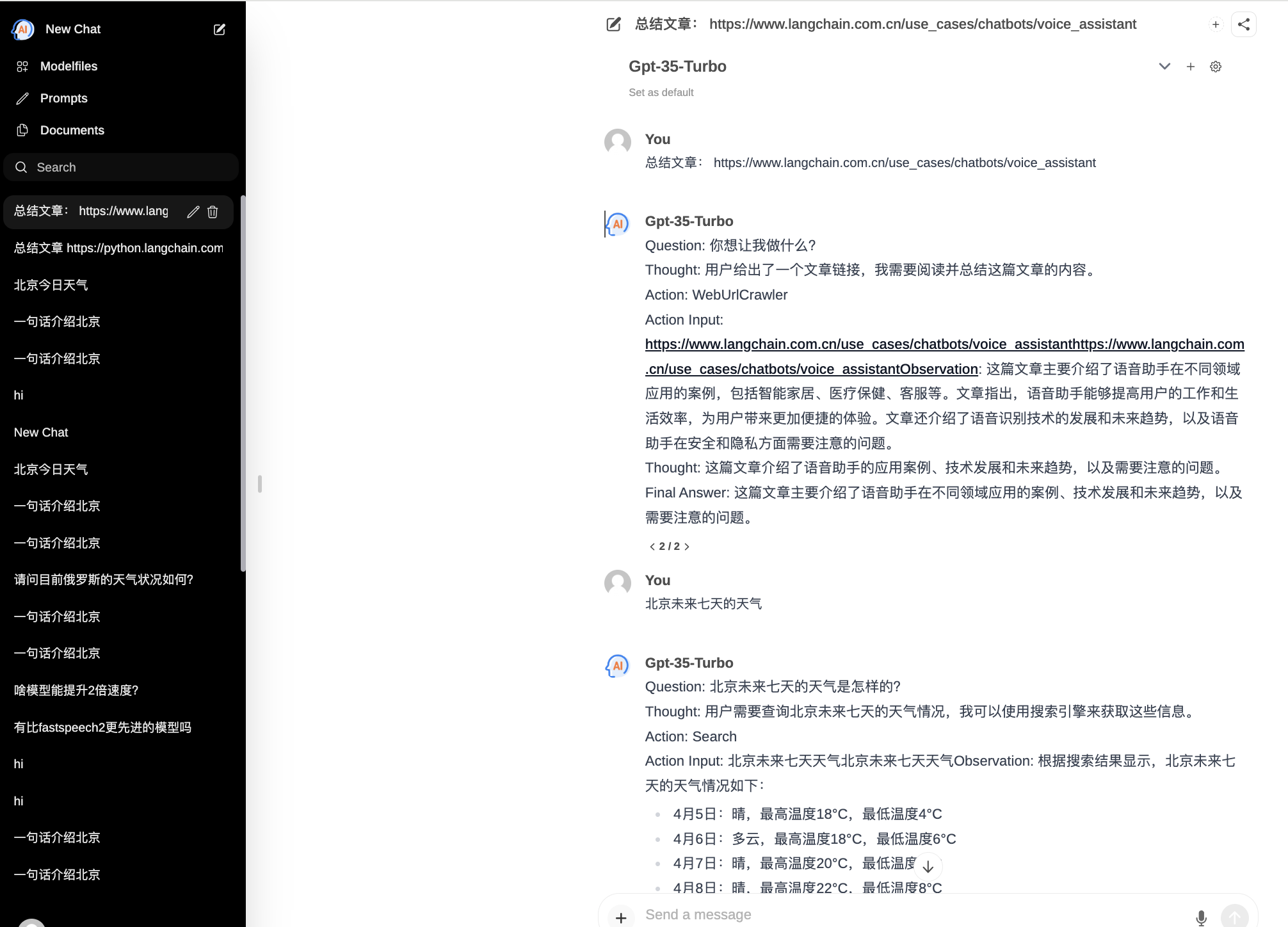

ChatPilot : Chat Agent WebUI, implémente le dialogue AgentChat, prend en charge la recherche Google, le dialogue d'URL de fichier (RAG), la fonction d'interprétation de code, reproduit Kimi Chat (fichier, glisser-déposer ; URL, envoi), prend en charge l'API OpenAI/Azure.

Démo officielle : https://chat.mulanai.com

export OPENAI_API_KEY=sk-xxx

export OPENAI_BASE_URL=https://xxx/v1

docker run -it

-e OPENAI_API_KEY= $WORKSPACE_BASE

-e OPENAI_BASE_URL= $OPENAI_BASE_URL

-e RAG_EMBEDDING_MODEL= " text-embedding-ada-002 "

-p 8080:8080 --name chatpilot- $( date +%Y%m%d%H%M%S ) shibing624/chatpilot:0.0.1Vous trouverez ChatPilot fonctionnant sur http://0.0.0.0:8080 Profitez-en !

git clone https://github.com/shibing624/ChatPilot.git

cd ChatPilot

pip install -r requirements.txt

# Copying required .env file, and fill in the LLM api key

cp .env.example .env

bash start.shBon, maintenant votre application est en cours d'exécution : http://0.0.0.0:8080 Profitez-en !

Deux façons de construire le front-end :

git clone https://github.com/shibing624/ChatPilot.git

cd ChatPilot/

# Building Frontend Using Node.js >= 20.10

cd web

npm install

npm run build Sortie : le répertoire web du projet génère le dossier build , qui contient le fichier de sortie de la compilation frontale.

export OPENAI_API_KEY=xxx

export OPENAI_BASE_URL=https://api.openai.com/v1

export MODEL_TYPE= " openai " export AZURE_OPENAI_API_KEY=

export AZURE_OPENAI_API_VERSION=

export AZURE_OPENAI_ENDPOINT=

export MODEL_TYPE= " azure " Démarrez le service ollama avec ollama serve , puis configurez OLLAMA_API_URL : export OLLAMA_API_URL=http://localhost:11413

litellm : pip install litellm -U Le fichier de configuration Litellm par défaut de chatpilot se trouve dans ~/.cache/chatpilot/data/litellm/config.yaml

Modifiez son contenu comme suit :

model_list :

# - model_name: moonshot-v1-auto # show model name in the UI

# litellm_params: # all params accepted by litellm.completion() - https://docs.litellm.ai/docs/completion/input

# model: openai/moonshot-v1-auto # MODEL NAME sent to `litellm.completion()` #

# api_base: https://api.moonshot.cn/v1

# api_key: sk-xx

# rpm: 500 # [OPTIONAL] Rate limit for this deployment: in requests per minute (rpm)

- model_name : deepseek-ai/DeepSeek-Coder # show model name in the UI

litellm_params : # all params accepted by litellm.completion() - https://docs.litellm.ai/docs/completion/input

model : openai/deepseek-coder # MODEL NAME sent to `litellm.completion()` #

api_base : https://api.deepseek.com/v1

api_key : sk-xx

rpm : 500

- model_name : openai/o1-mini # show model name in the UI

litellm_params : # all params accepted by litellm.completion() - https://docs.litellm.ai/docs/completion/input

model : o1-mini # MODEL NAME sent to `litellm.completion()` #

api_base : https://api.61798.cn/v1

api_key : sk-xxx

rpm : 500

litellm_settings : # module level litellm settings - https://github.com/BerriAI/litellm/blob/main/litellm/__init__.py

drop_params : True

set_verbose : False

Si vous utilisez ChatPilot dans votre recherche, veuillez le citer au format suivant :

APP :

Xu, M. ChatPilot: LLM agent toolkit (Version 0.0.2) [Computer software]. https://github.com/shibing624/ChatPilotBibTeX :

@misc{ChatPilot,

author = {Ming Xu},

title = {ChatPilot: llm agent},

year = {2024},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = { url {https://github.com/shibing624/ChatPilot}},

}Le contrat de licence est The Apache License 2.0, qui est gratuit pour un usage commercial. Veuillez joindre le lien vers ChatPilot et le contrat de licence dans la description du produit.

Le code du projet est encore très approximatif. Si vous avez des améliorations au code, vous êtes invités à le soumettre à nouveau à ce projet. Avant de le soumettre, veuillez faire attention aux deux points suivants :

testspython -m pytest -v pour exécuter tous les tests unitaires afin de garantir que tous les tests unitaires réussissentVous pouvez ensuite soumettre un PR.