KServe

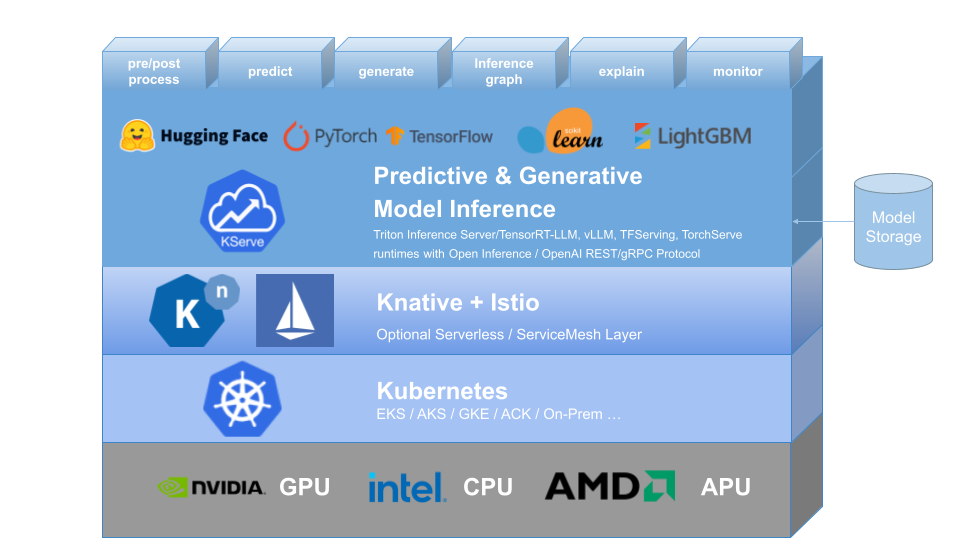

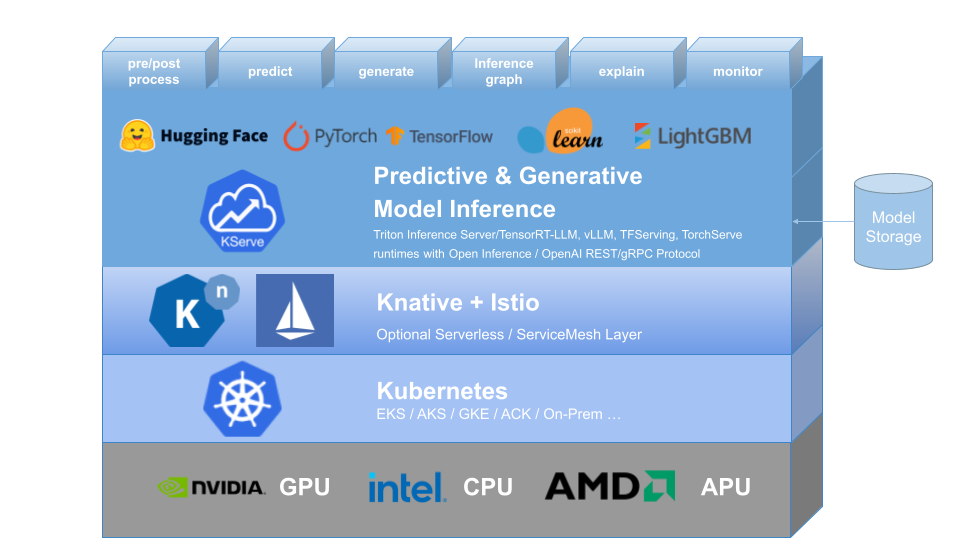

KServe fournit une définition de ressource personnalisée Kubernetes pour servir des modèles d'apprentissage automatique (ML) prédictifs et génératifs. Il vise à résoudre les cas d'utilisation de modèles de production en fournissant des interfaces à haute abstraction pour les modèles Tensorflow, XGBoost, ScikitLearn, PyTorch, Huggingface Transformer/LLM à l'aide de protocoles de plan de données standardisés.

Il résume la complexité de la mise à l'échelle automatique, de la mise en réseau, de la vérification de l'état et de la configuration du serveur pour apporter des fonctionnalités de service de pointe telles que la mise à l'échelle automatique du GPU, la mise à l'échelle jusqu'à zéro et les déploiements Canary à vos déploiements de ML. Il permet une histoire simple, connectable et complète pour Production ML Serving, y compris la prédiction, le pré-traitement, le post-traitement et l'explicabilité. KServe est utilisé dans diverses organisations.

Pour plus de détails, visitez le site Web de KServe.

KFServing a été rebaptisé KServe depuis la v0.7.

Pourquoi KServe ?

- KServe est une plateforme d'inférence de modèles standard et indépendante du cloud, destinée à servir des modèles d'IA prédictifs et génératifs sur Kubernetes, conçue pour des cas d'utilisation hautement évolutifs.

- Fournit un protocole d'inférence performant et standardisé dans les frameworks ML, y compris la spécification OpenAI pour les modèles génératifs.

- Prenez en charge la charge de travail d'inférence sans serveur moderne avec une mise à l'échelle automatique basée sur les requêtes, y compris une mise à l'échelle jusqu'à zéro sur le CPU et le GPU .

- Fournit une évolutivité élevée, un regroupement de densité et un routage intelligent à l’aide de ModelMesh .

- Production simple et enfichable servant à l'inférence , au pré/post-traitement , au suivi et à l'explicabilité .

- Déploiements avancés pour le déploiement Canary , le pipeline et les ensembles avec InferenceGraph .

Apprendre encore plus

Pour en savoir plus sur KServe, comment utiliser les différentes fonctionnalités prises en charge et comment participer à la communauté KServe, veuillez suivre la documentation du site Web de KServe. De plus, nous avons compilé une liste de présentations et de démos pour approfondir divers détails.

Installation

Installation autonome

- Installation sans serveur : KServe installe par défaut Knative pour un déploiement sans serveur pour InferenceService.

- Installation avec déploiement brut : par rapport à l'installation sans serveur, il s'agit d'une installation plus légère . Toutefois, cette option ne prend pas en charge le déploiement Canary et la mise à l'échelle automatique basée sur les demandes avec mise à l'échelle jusqu'à zéro.

- Installation de ModelMesh : vous pouvez éventuellement installer ModelMesh pour permettre des cas d'utilisation de modèles à grande échelle , à haute densité et en constante évolution .

- Installation rapide : Installez KServe sur votre machine locale.

Installation de Kubeflow

KServe est un composant complémentaire important de Kubeflow, veuillez en savoir plus dans la documentation Kubeflow KServe. Consultez les guides suivants pour l'exécution sur AWS ou sur OpenShift Container Platform.

? Créez votre premier InferenceService

Feuille de route

Référence de l'API InferenceService

? Guide du développeur

✍️ Guide du contributeur

? Adoptants