ContrôleAnimer

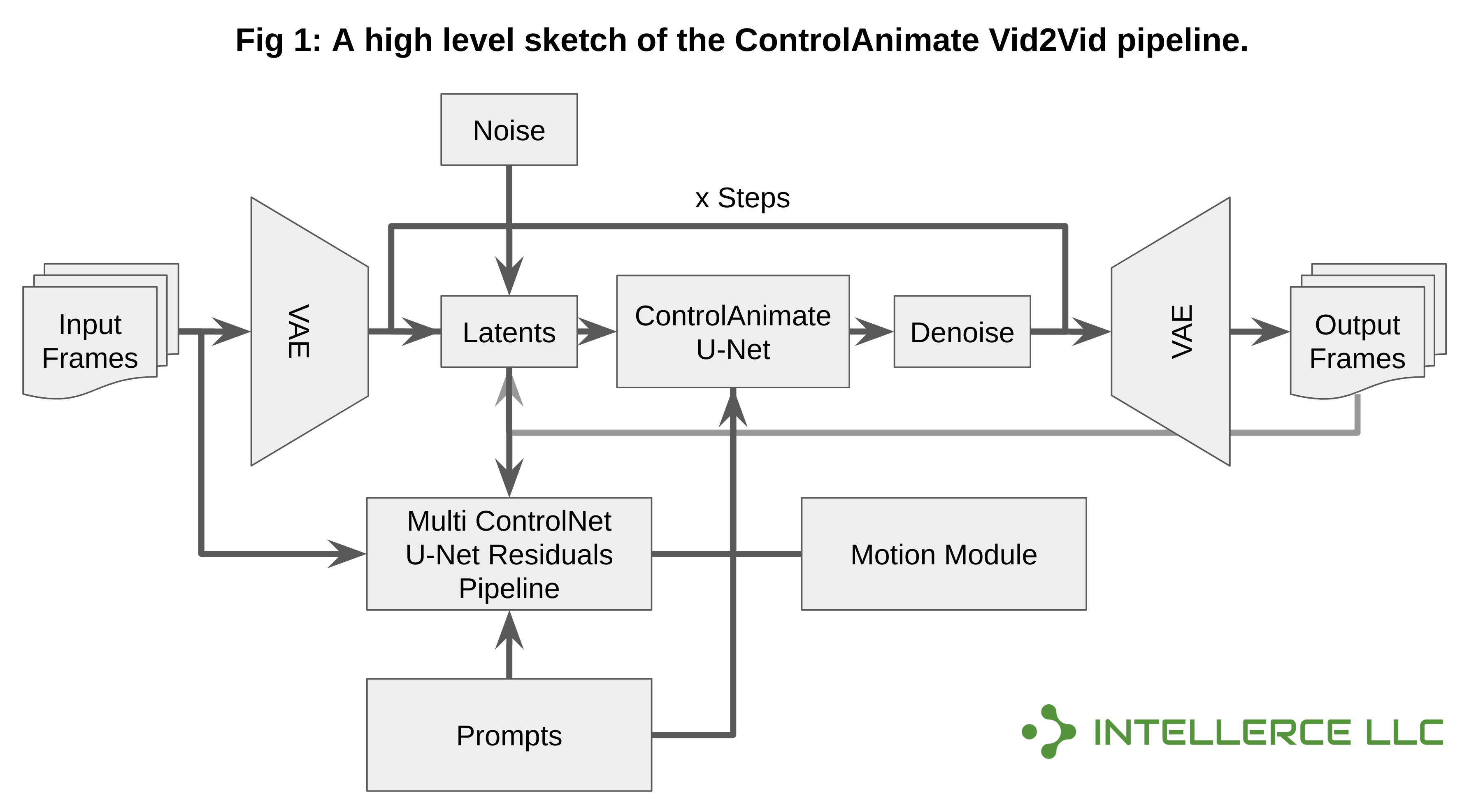

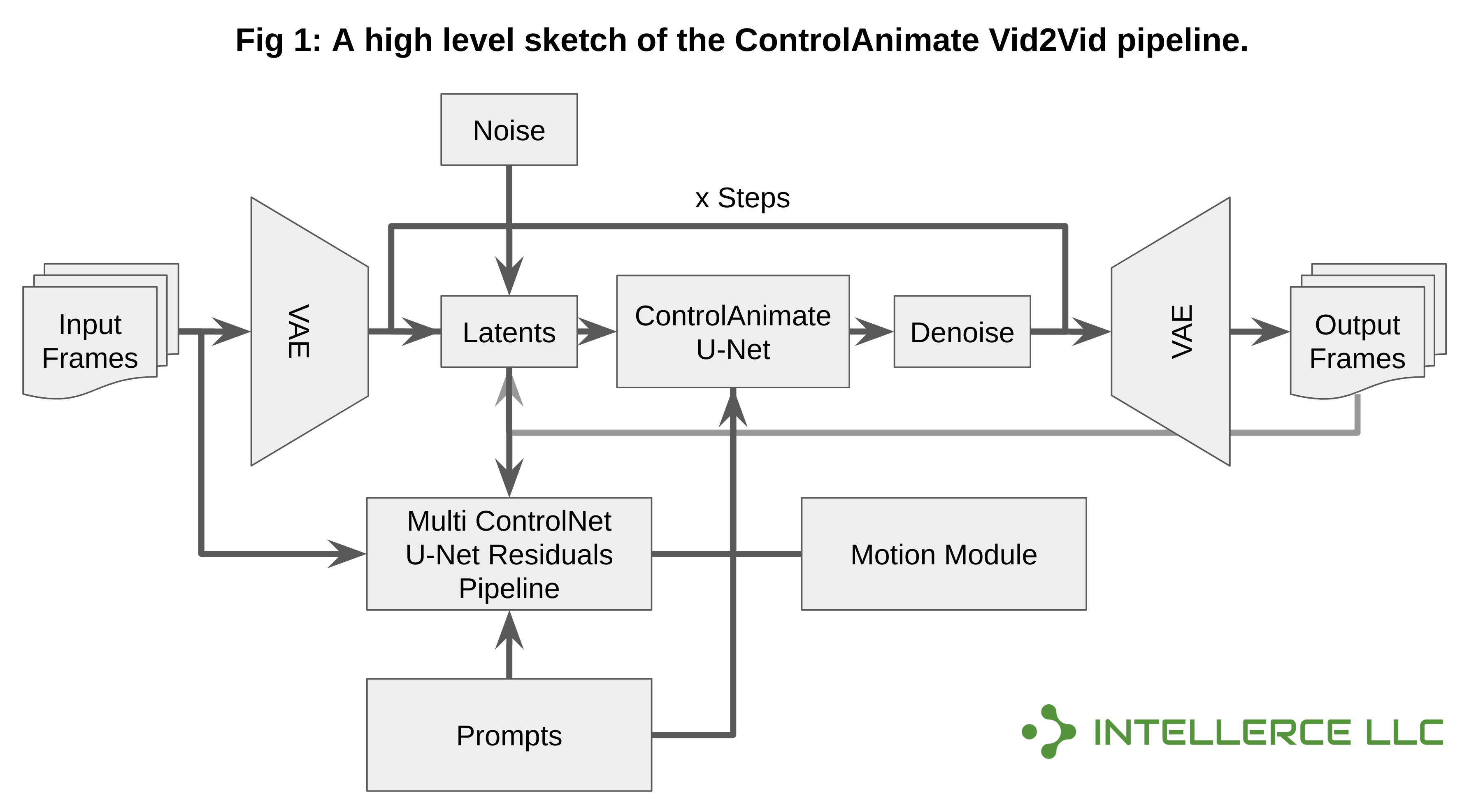

- Combinaison d'AnimateDiff avec Multi-ControlNet et Img2Img pour les applications Vid2Vid. Cette petite bibliothèque est particulièrement axée sur les applications Vid2Vid en utilisant ControlNet (ou Multi-ControlNet) pour guider la génération vidéo et AnimateDiff pour la cohérence.

- De plus, il utilise Img2Img pour créer des vidéos plus cohérentes (après la première époque). Semblable à AnimateDiff, il permet l'utilisation de modèles DreamBooth/LoRA en plus du modèle de base Stable Diffusion 1.5.

- Il s'agit d'une version initiale, alors attendez-vous à des problèmes et bugs potentiels. Les commentaires, suggestions et demandes de fonctionnalités sont les bienvenus.

Nouvelles

- 20 novembre 2023 - Prise en charge désormais de l'adaptateur IP, des xformers et de la correspondance des couleurs !

- 12 novembre 2023 - Prise en charge désormais de LCM-LoRA et ControlNet pour toutes les combinaisons !

- 7 novembre 2023 – Prise en charge désormais du modèle de cohérence latente (LCM) – Obtenez un gain de performances 10 fois supérieur !

Fonctionnalités prises en charge

- ? Adaptateur IP (utilisé pour augmenter la similarité des lots de trames AnimateDiff)

- ? Modèle de cohérence latente LoRA (LCM-LoRA)

- ? Modèle de cohérence latente (LCM) natif

- ? Multi-ControlNet peut être combiné avec LCM, etc.

- ? Pondération des invites et invites longues (Compel)

- ? DreamBooth et LoRA

- ? Interpolation FFMPEG

- ? Correspondance des couleurs entre les lots pour une meilleure cohérence

- ? Chevauchement latent (Img2Img et ControlNet) et chevauchement de trames (mélange)

- ? Amélioration du visage et mise à l'échelle (GFPGAN et RealESRGAN)

- ? Fréquence d'images, durée et résolution arbitraires de la vidéo d'entrée

- ? xformers activés

Compatibilité et exigences

- Cette base de code a été testée sous Linux (Ubuntu 22.04) uniquement. Il a été testé sur une machine Intel avec NVIDIA Gefore RTX 3090 (24 Go de VRAM) et nécessite au moins 16 Go de RAM.

Installation

- Assurez-vous qu'Anaconda est installé (https://www.anaconda.com/download).

- Assurez-vous également que FFMPEG est correctement installé et configuré (vous pouvez suivre ces guides pour l'installation : "Guide 1" et si des problèmes persistent, ceci : "Guide 2" - Vous pouvez définir le chemin FFMPEG dans les configurations/invites yaml fichiers)

git clone [email protected]:intellerce/controlanimate.git

cd ControlAnimate

bash download.sh

conda env create -f env.yml

Vid2Vid

- Après avoir défini le fichier de configuration « configs/prompts/SampleConfig.yaml », exécutez simplement ce qui suit (n'oubliez pas de pointer vers un fichier vidéo d'entrée valide) :

conda activate controlanimate

bash start.sh

Testé sur une machine avec un seul RTX 3090.

Pondération rapide

- La pondération rapide est basée sur Compel. Vous pouvez utiliser + ou (...)+ pour l'importance ou ajouter des poids comme ceci : (cat)1.2 De même, vous pouvez utiliser le signe négatif (-) pour réduire le poids ou utiliser des poids inférieurs à 1. Veuillez vous référer à https:// github.com/damian0815/compel/blob/main/Reference.md pour plus d'informations.

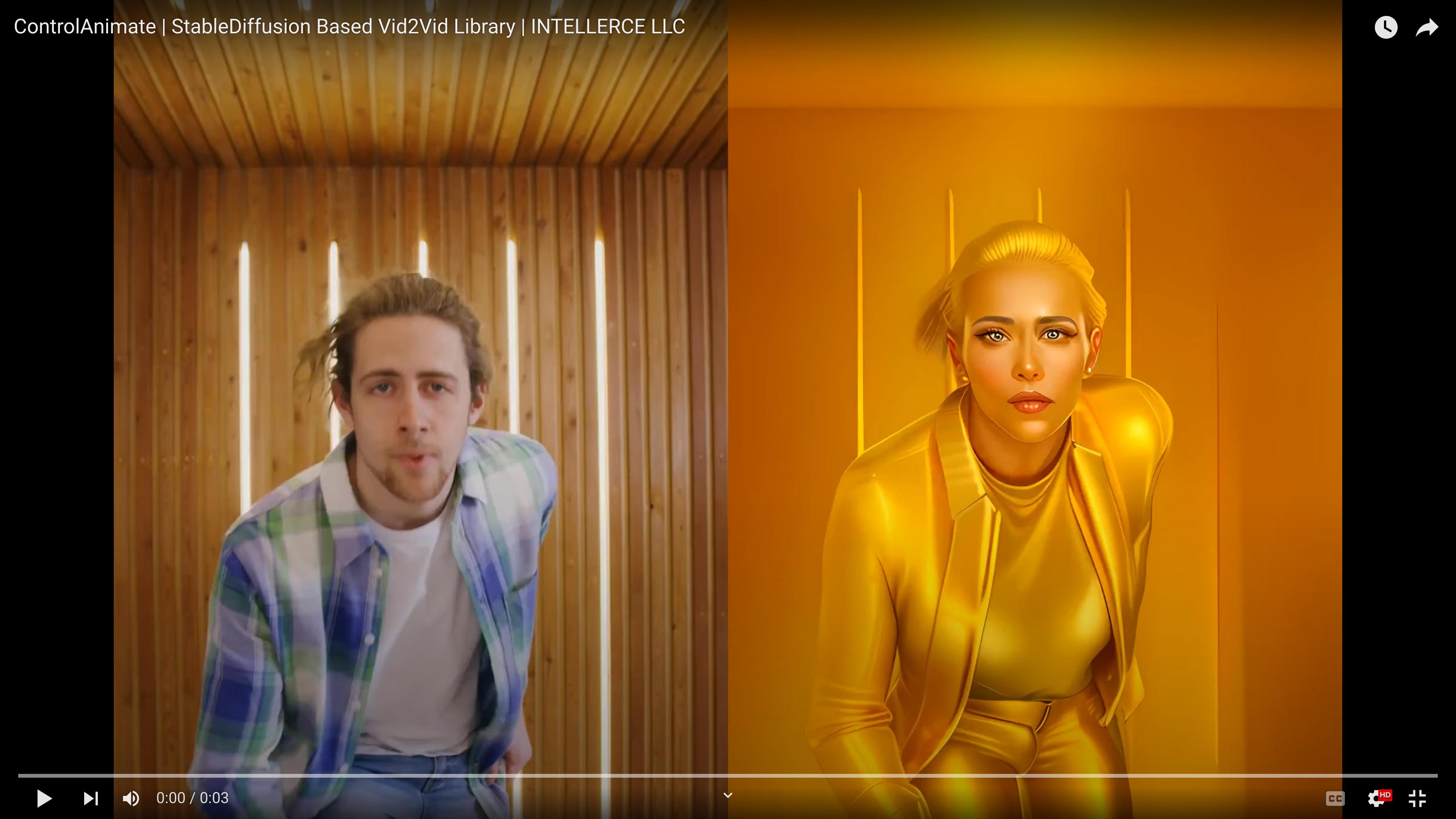

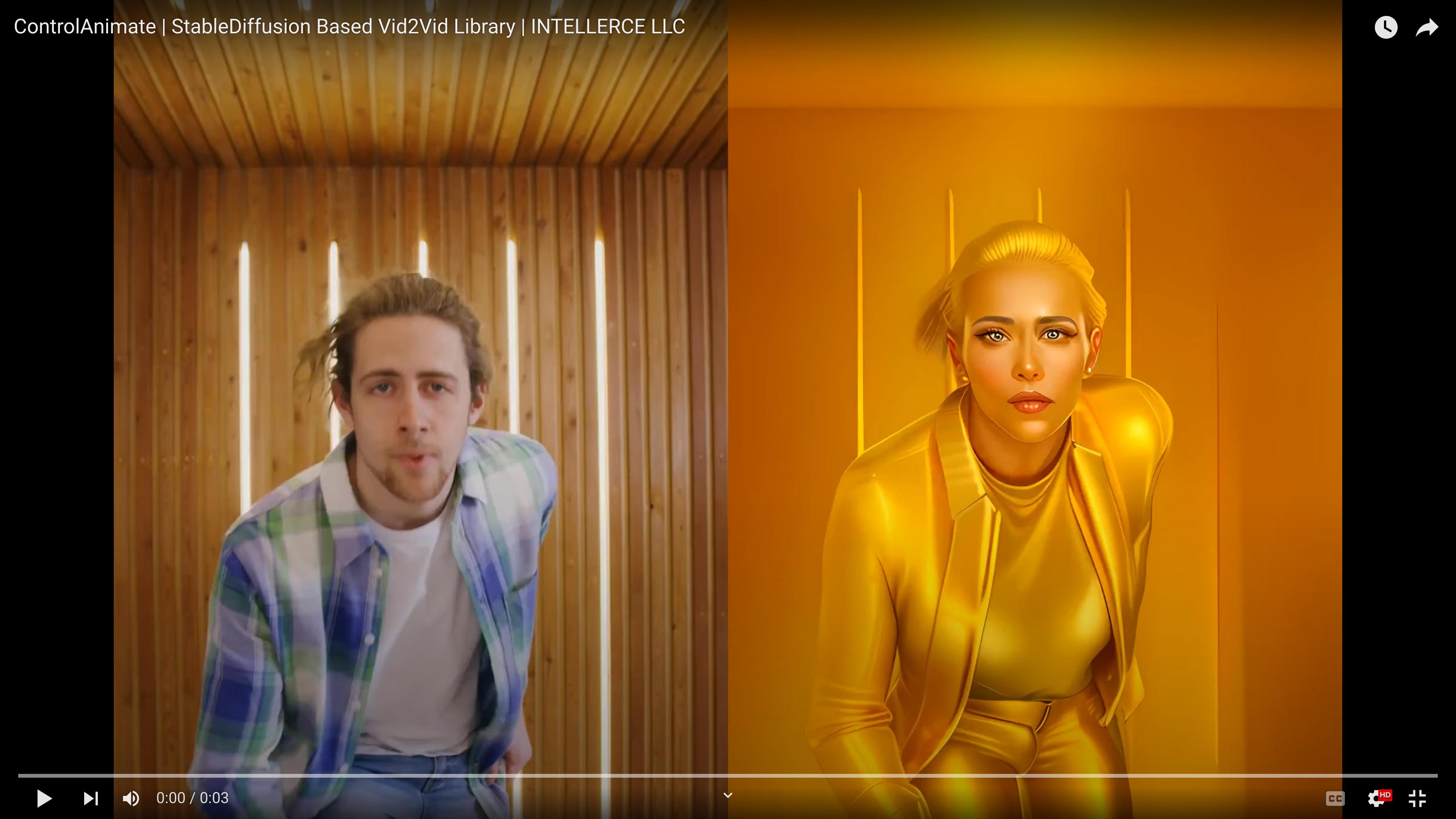

Résultats

- Quatre ControlNets et chevauchement latent (configs/prompts/SampleConfig.yaml)

- LCM (pas de ControlNet) (configs/prompts/SampleConfigLCM.yaml)

- LCM-LoRA + Multi-ControlNet (configs/invites/SampleConfigLCMLoRA.yaml)

- Adaptateur IP + LCM-LoRA + Multi-ControlNet (configs/invites/SampleConfigIPAdapter.yaml)

Faire

Contactez-nous

Hamed Omidvar, Ph.D. : [email protected]

Vahideh Akhlaghi, Ph.D. : [email protected]

Licence

Cette base de code est publiée sous la licence Apache v2.0. Pour les licences des bases de code sur lesquelles ce référentiel est basé, veuillez vous référer à leurs pages Github/Website correspondantes.

Remerciements

Cette base de code a été construite sur et/ou inspirée par les référentiels suivants : AnimateDiff Diffusers IP-Adapter Video2Video Color Matcher

Les auteurs tiennent à remercier Kalin Ovtcharov (Extropolis Corp.) pour ses précieux commentaires et suggestions.