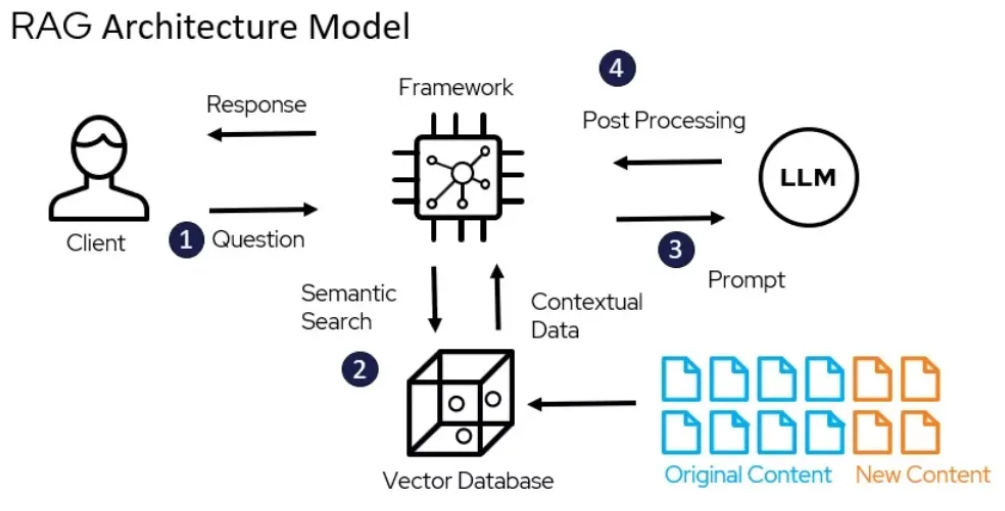

Comme nous le savons, les LLM comme Gemini ne disposent pas d'informations spécifiques à l'entreprise. Mais ces dernières informations sont disponibles via des PDF, des fichiers texte, etc... Désormais, si nous pouvons connecter notre LLM à ces sources, nous pouvons créer une bien meilleure application.

À l'aide du framework LangChain, j'ai construit un système de génération augmentée de récupération (RAG) qui peut utiliser la puissance de LLM comme Gemini 1.5 Pro pour répondre aux questions de l'article « Leave No Context Behind » publié par Google le 10 avril 2024. Dans ce processus, des experts externes Les données (c'est-à-dire le document Leave No Context Behind) sont récupérées puis transmises au LLM lors de l'étape de génération.

Vous pouvez trouver le document ici.

Trouvez l’implémentation complète du code ici.