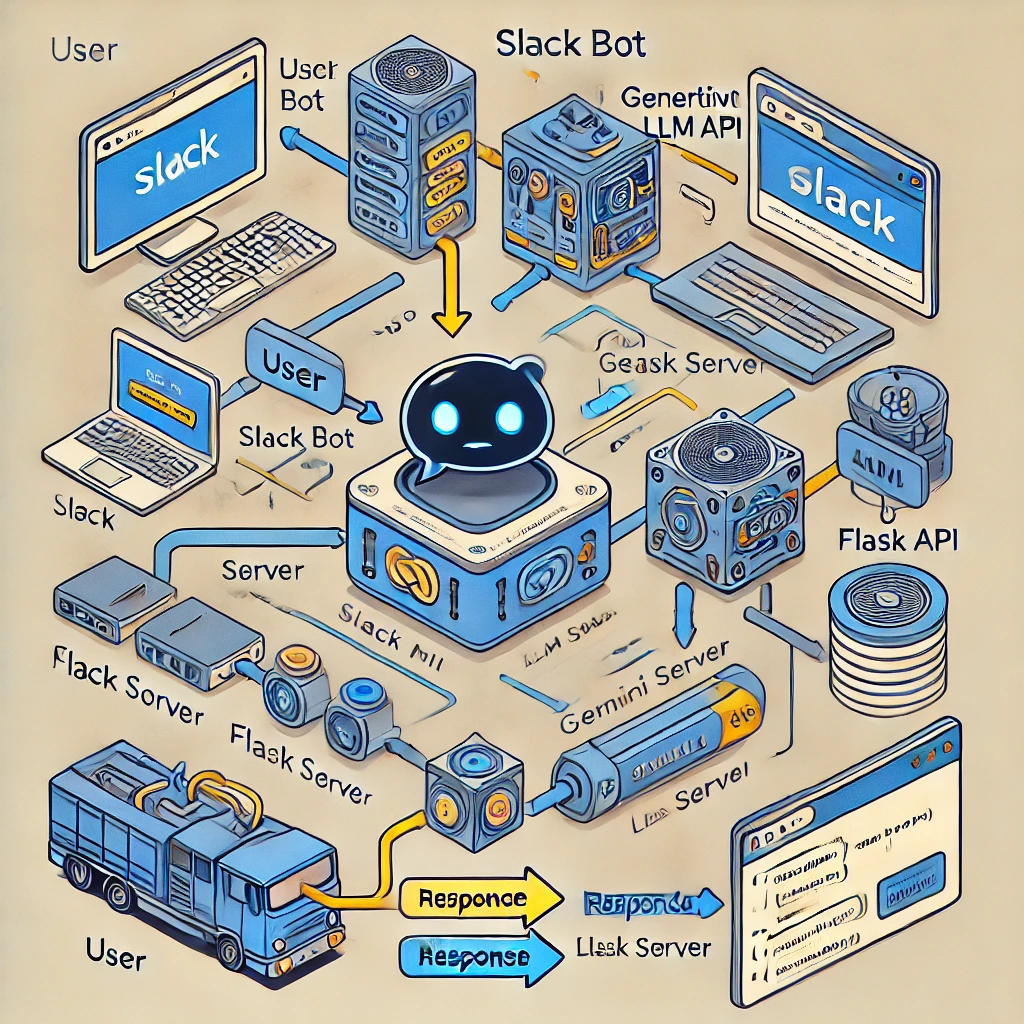

Ce projet montre comment intégrer un bot Slack à un chatbot basé sur le Large Language Model (LLM) à l'aide du modèle Gemini de Google. L'intégration permet une communication intelligente et contextuelle directement dans Slack.

Le bot Slack est construit à l'aide de Python et Flask et est intégré à un chatbot alimenté par LLM utilisant le modèle Gemini. Cette configuration permet au bot de traiter les entrées des utilisateurs dans les canaux Slack et de répondre intelligemment en fonction des dernières informations d'ingénierie des données.

Bibliothèques utilisées : slack_sdk, slack_bolt Fonctionnalité : le bot écoute les événements app_mention déclenchés lorsque quelqu'un mentionne le bot dans un canal Slack. Configuration : les jetons et les secrets sont chargés en toute sécurité à partir d'un fichier .env à l'aide de variables d'environnement

Flask App: The Flask app handles incoming HTTP requests from Slack.

Event Processing: Slack events are processed through Flask using SlackRequestHandler from the slack_bolt.adapter.flask module.

Gemini Model: The Gemini model, provided by Google's Generative AI platform, processes and responds to queries.

Python Package: The google.generativeai package is used to interact with the Gemini model, allowing for prompt-based queries.

Configuration: Tokens are securely loaded from a .env file using environment variables for geminiai api.

Utilisation de ngrok : ngrok fournit une URL publique qui transmet les requêtes à l'application Flask locale, permettant à Slack de communiquer avec le bot. Commande d'installation : ngrok http 6060 est utilisé pour exposer l'application Flask à Internet.

L'intégration aboutit à un robot Slack capable d'effectuer une analyse avancée des données et de répondre intelligemment aux requêtes des utilisateurs dans Slack.