nvidia llm

1.0.0

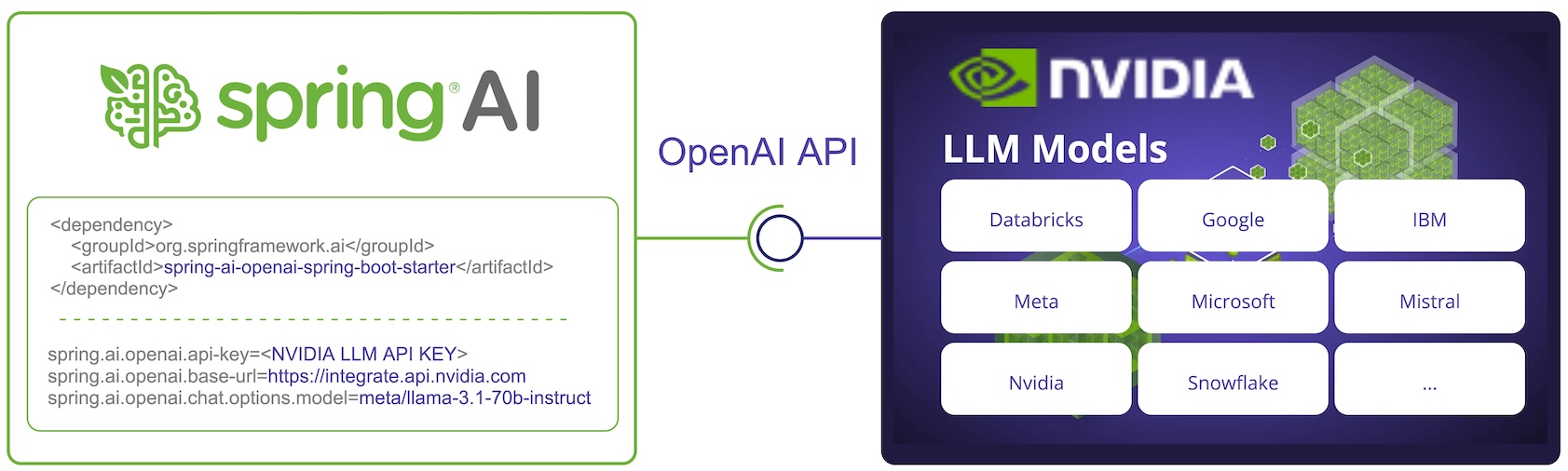

L'API NVIDIA LLM est un moteur d'inférence d'IA proxy offrant une large gamme de modèles provenant de divers fournisseurs.

Spring AI s'intègre à l'API NVIDIA LLM en réutilisant le client Spring AI OpenAI existant.

Pour cela, vous devez définir l'URL de base sur https://integrate.api.nvidia.com , sélectionnez l'un des https://docs.api.nvidia.com/nim/reference/llm-apis#model[ Modèles LLM] et obtenez une api-key pour cela.

REMARQUE : L'API NVIDIA LLM nécessite que le paramètre max-token soit explicitement défini, sinon une erreur de serveur sera générée.

Pour en savoir plus, consultez la documentation de référence SpringAI/NVIDIA : https://docs.spring.io/spring-ai/reference/api/chat/nvidia-chat.html