Évaluateur de classement coté

Le Rated Ranking Evaluator (RRE) est un outil d'évaluation de la qualité de la recherche qui, comme son nom l'indique, évalue la qualité des résultats provenant d'une infrastructure de recherche.

Links

- Évaluation de la qualité de la recherche : le point de vue du développeur

- RRE à Haystack EU, Londres, 2018

- RRE au Fosdem 2019

- Tests de pertinence pratiques de l'évaluateur de classement coté (RRE) @Chorus, 2021

- Rated Ranking Evaluator Enterprise : la nouvelle génération d'outils gratuits d'évaluation de la qualité de la recherche, Padoue, 2021

- Le wiki du projet, situé sur https://github.com/SeaseLtd/rated-ranking-evaluator/wiki

- Liste de diffusion RRE-User : https://groups.google.com/g/rre-user

Pour le moment, Apache Solr et Elasticsearch sont pris en charge (voir la documentation pour les versions prises en charge).

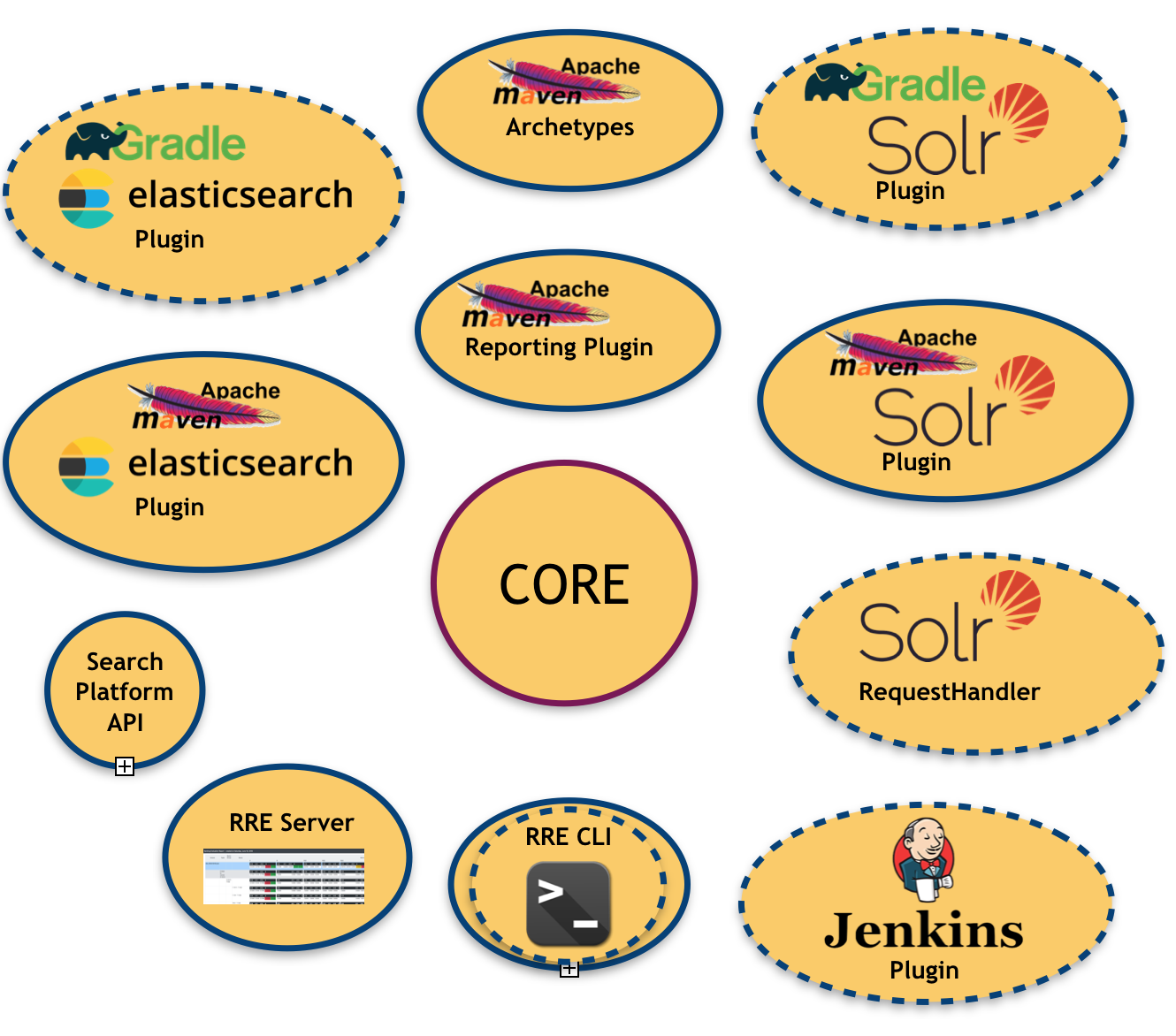

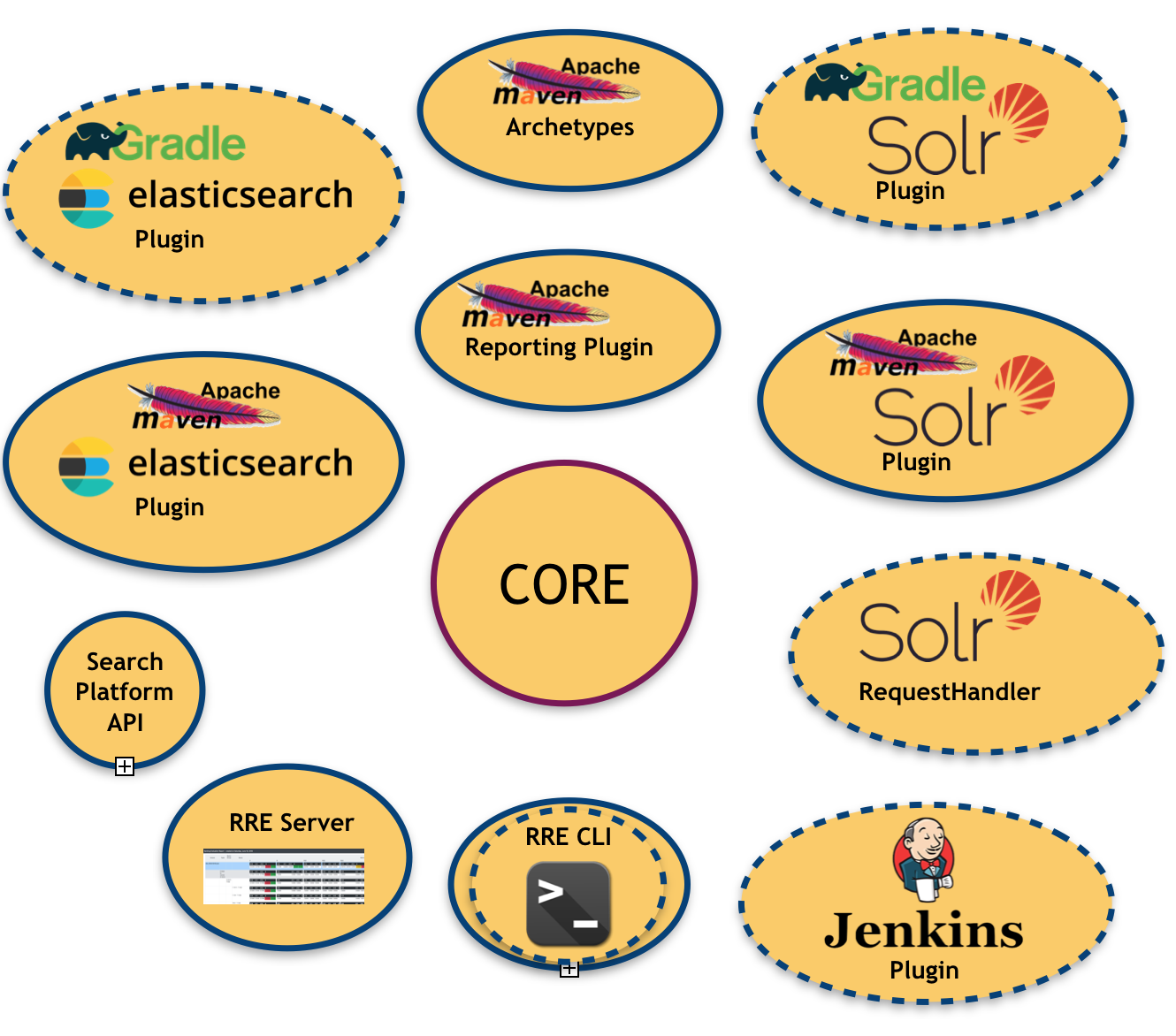

L'image suivante illustre l'écosystème RRE :

Comme vous pouvez le constater, il y a beaucoup de modules déjà en place et prévus (ceux avec la bordure en pointillés)

- un noyau , c'est à dire la bibliothèque centrale qui est chargée de produire les résultats de l'évaluation

- une API de plateforme de recherche : pour extraire (et lier) la plateforme de recherche sous-jacente

- un ensemble de liaisons de plateforme de recherche : comme dit ci-dessus, nous avons actuellement deux liaisons disponibles (Apache Solr et Elasticsearch)

- un plugin Apache Maven pour chaque liaison de plateforme de recherche disponible : qui permet d'injecter RRE dans un système de build basé sur Maven

- un plugin de reporting Apache Maven : pour produire des rapports d'évaluation dans un format lisible par l'homme (par exemple PDF, Excel), utile pour cibler les utilisateurs non techniques

- un serveur RRE : un simple panneau de contrôle basé sur le Web où les résultats d'évaluation sont mis à jour en temps réel après chaque cycle de construction.

L'ensemble du système a été construit comme un cadre dans lequel les métriques peuvent être configurées/activées et même branchées (bien sûr, cette option nécessite un certain développement). Les métriques qui font partie de la version actuelle de RRE sont :

- Précision : la fraction de documents récupérés qui sont pertinents.

- Rappel : la fraction des documents pertinents récupérés.

- Précision à 1 : cette métrique indique si le premier résultat de la liste est pertinent ou non.

- Précision à 2 : idem que ci-dessus mais on considère les deux premiers résultats.

- Précision à 3 : idem que ci-dessus mais on considère les trois premiers résultats.

- Précision à 10 : cette métrique mesure le nombre de résultats pertinents dans les 10 premiers résultats de recherche.

- Rang réciproque : c'est l'inverse multiplicatif du rang de la première réponse « correcte » : 1 pour la première place, 1/2 pour la deuxième place, 1/3 pour la troisième et ainsi de suite.

- Rang réciproque attendu (ERR) Une extension du rang réciproque avec une pertinence graduée, mesure la durée réciproque attendue que l'utilisateur mettra pour trouver un document pertinent.

- Précision moyenne : l'aire sous la courbe précision-rappel.

- NDCG à 10 : Gain cumulatif actualisé normalisé à 10 ; voir : https://en.wikipedia.org/w/index.php?title=Discounted_cumulative_gain§ion=4#Normalized_DCG

- F-Measure : elle mesure l'efficacité de la récupération par rapport à un utilisateur qui attache β fois plus d'importance au rappel qu'à la précision. RRE fournit les trois instances F-Measure les plus populaires : F0.5, F1 et F2.

En plus de ces métriques « feuilles », qui sont calculées au niveau de la requête, RRE fournit un modèle de données imbriqué riche, dans lequel la même métrique peut être agrégée à plusieurs niveaux. Par exemple, les requêtes sont regroupées dans des groupes de requêtes et les groupes de requêtes sont regroupés dans des rubriques. Cela signifie que les mêmes mesures répertoriées ci-dessus sont également disponibles aux niveaux supérieurs en utilisant la moyenne arithmétique comme critère d'agrégation. En conséquence, RRE fournit également les métriques suivantes :

- Mean Average Precision : la moyenne des précisions moyennes calculées au niveau de la requête.

- Mean Reciprocal Rank : la moyenne des classements réciproques calculés au niveau de la requête.

- toutes les autres mesures énumérées ci-dessus regroupées par leur moyenne arithmétique.

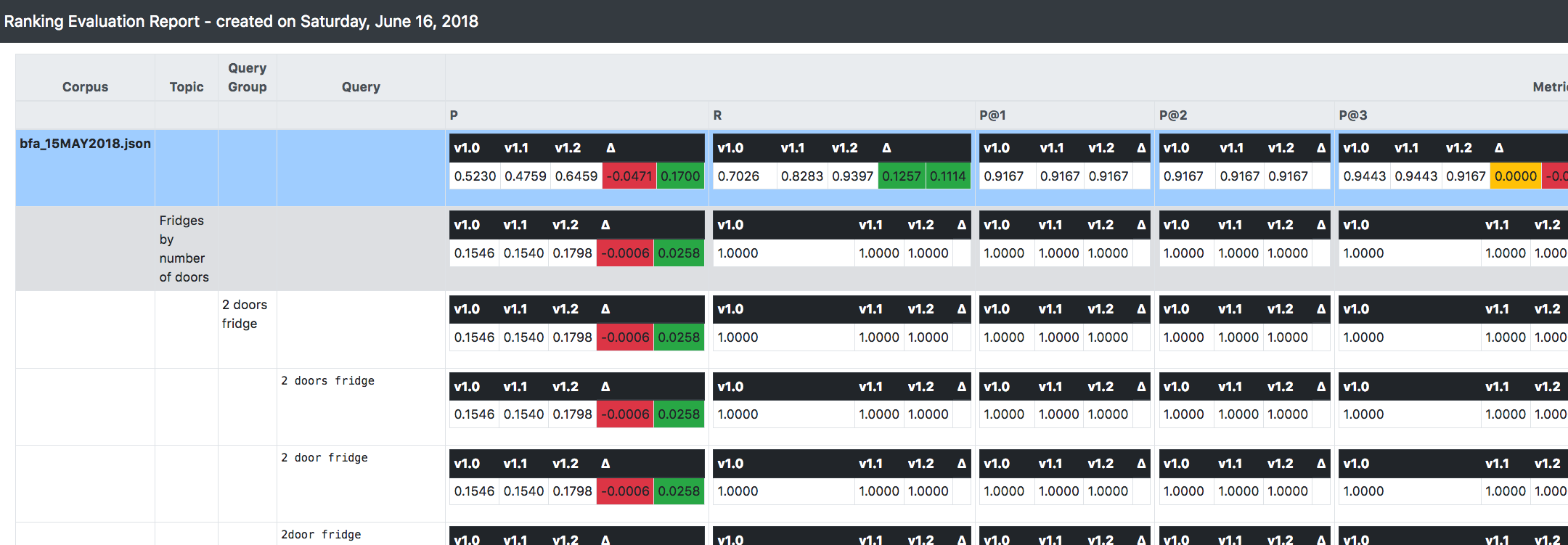

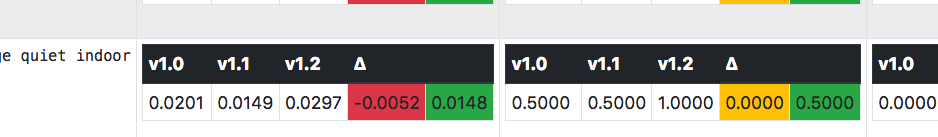

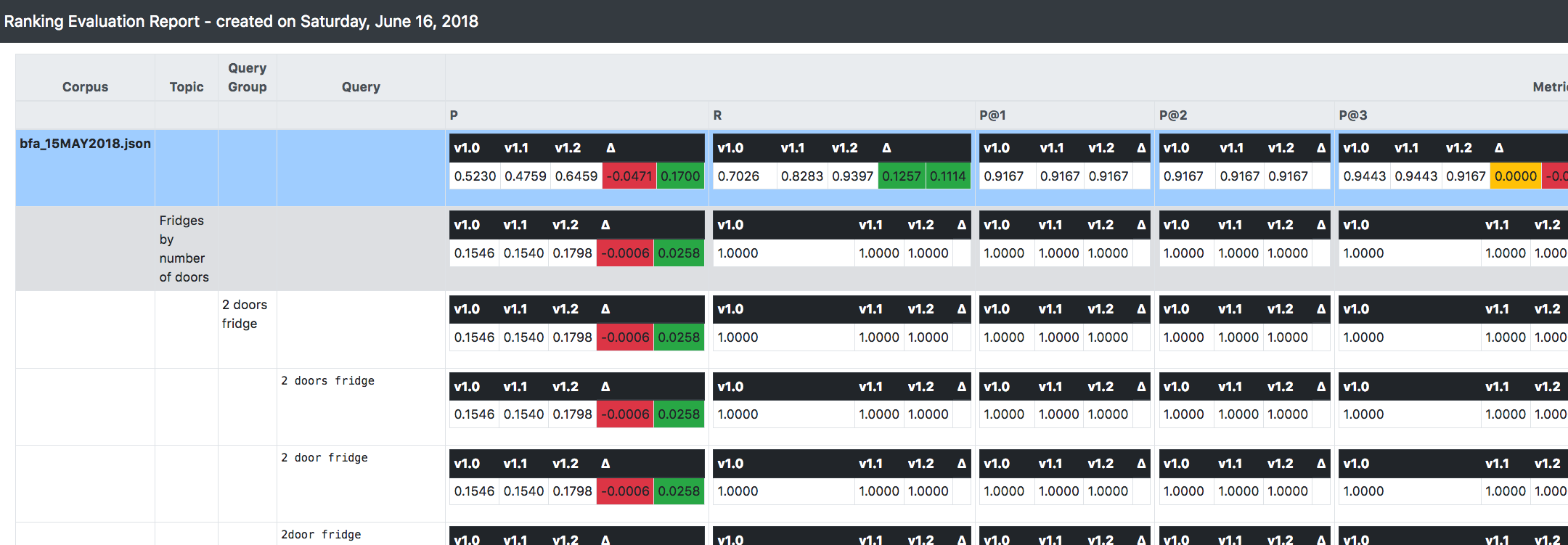

L'une des choses les plus importantes que vous pouvez voir dans la capture d'écran ci-dessus est que RRE est capable de suivre (et de faire des comparaisons) entre plusieurs versions du système en cours d'évaluation.

Il encourage une approche incrémentielle/itérative/immuable lors du développement et de l'évolution d'un système de recherche : en supposant que vous partez de la version 1.0, lorsque vous appliquez des modifications pertinentes à votre configuration, au lieu de modifier cette version, il est préférable de la cloner et d'appliquer le modifications apportées à la nouvelle version (appelons-la 1.1).

De cette façon, lorsque la construction du système aura lieu, RRE calculera tout ce qui est expliqué ci-dessus (c'est-à-dire les métriques) pour chaque version disponible.

De plus, il fournira le delta/tendance entre les versions suivantes, afin que vous puissiez immédiatement obtenir la direction générale vers laquelle va le système, en termes d'améliorations de pertinence.