Pour accéder à la fonctionnalité de recherche, postulez pour accéder à la version bêta de la mosaïque

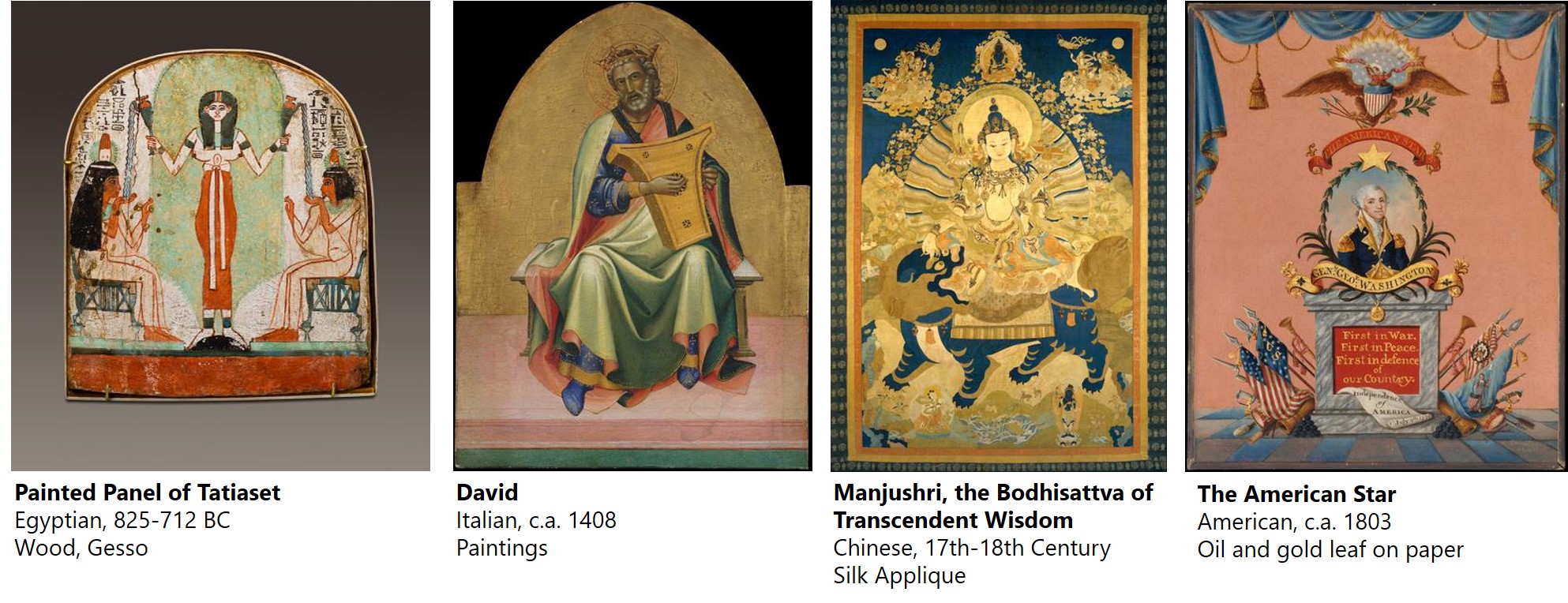

L'art est l'une des rares langues qui transcende les barrières du pays, de la culture et du temps. Notre objectif est de créer un algorithme qui puisse aider à découvrir les éléments sémantiques communs de l'art, même entre n'importe quelle culture, média, artiste ou collection au sein des œuvres combinées du Metropolitan Museum of Art et du Rijksmusem.

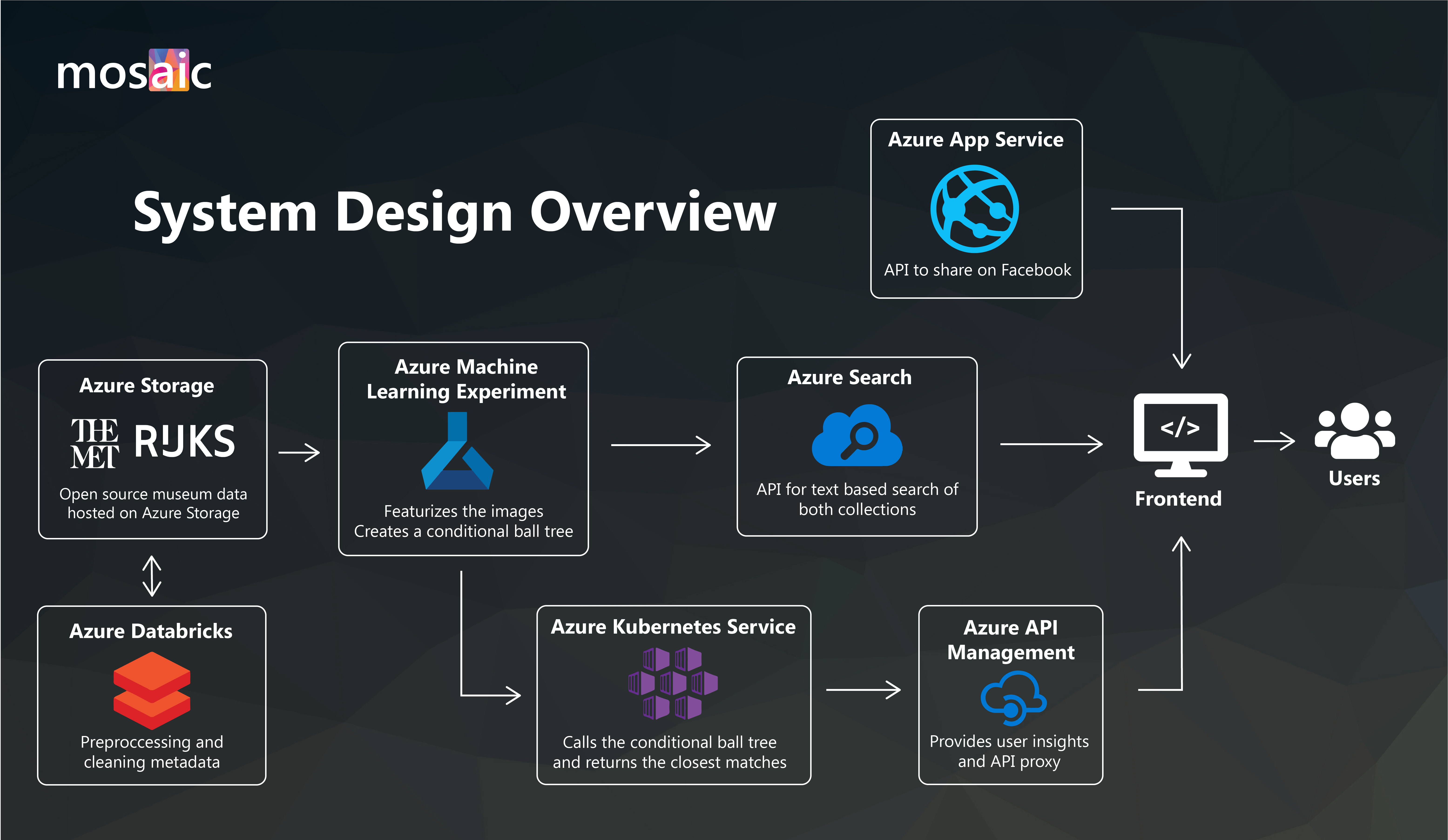

Les systèmes de récupération d'images permettent aux individus de trouver des images sémantiquement similaires à une image de requête. Cela constitue l’épine dorsale des moteurs de recherche d’images inversées et de nombreux moteurs de recommandation de produits. Nous présentons une nouvelle méthode pour spécialiser les systèmes de récupération d’images appelée récupération d’images conditionnelle. Lorsqu’elle est appliquée à de vastes ensembles de données artistiques, la récupération d’images conditionnelles fournit des analogies visuelles qui mettent en lumière des liens cachés entre différents artistes, cultures et médias. Les systèmes de récupération d’images conditionnelles peuvent trouver efficacement une sémantique partagée entre des œuvres de médias et d’origine culturelle très différents. Notre article présente de nouvelles variantes des algorithmes K-Nearest Neighbour qui prennent en charge la spécialisation à la volée sur des sous-ensembles particuliers de collections d’images.

Pour trouver des œuvres d'art avec une structure sémantique similaire, nous exploitons les « fonctionnalités » des réseaux de vision profonde formés sur ImageNet. Ces réseaux cartographient les images dans un espace de grande dimension où la distance a un sens sémantique. Ici, les requêtes du voisin le plus proche ont tendance à agir comme des « moteurs de recherche d'images inversées » et les objets similaires partagent souvent une structure commune.

Pour en savoir plus sur ce projet, veuillez rejoindre notre webinaire en direct le 30/07/2020 à 10h PST.

Pour citer ce travail, veuillez utiliser ce qui suit :

@article{hamilton2020conditional,

title={Conditional Image Retrieval},

author={Hamilton, Mark and Fu, Stephanie and Freeman, William T and Lu, Mindren},

journal={arXiv preprint arXiv:2007.07177},

year={2020}

}

Veuillez consulter notre guide du développeur pour créer le projet par vous-même.

Représentations partagées de révérence sur 3000 ans :

Comment assortir votre montre à votre tenue et à votre vaisselle :

Un merci spécial à tous les contributeurs qui ont contribué à faire de ce projet une réalité !

Les externes du MIT x MSFT ont joué un rôle essentiel dans la transformation de ce projet de recherche en un site Web fonctionnel. En seulement un mois, l’équipe a construit et conçu le site Internet mosaïque. Stephanie Fu et Mindren Lu ont également contribué à la publication « Conditional Image Retrieval » en évaluant l'effet de différents réseaux pré-entraînés sur le transfert de style non paramétrique.

Ce projet doit un grand merci à l'équipe MSFT Garage. Ce sont des créateurs passionnés qui cherchent à incuber de nouveaux projets et à inspirer les nouvelles générations d'ingénieurs. Leur soutien et leur mentorat sur ce projet sont sincèrement appréciés.

Ce projet accueille les contributions et suggestions. La plupart des contributions nécessitent que vous acceptiez un contrat de licence de contributeur (CLA) déclarant que vous avez le droit de nous accorder, et que vous nous accordez effectivement, le droit d'utiliser votre contribution. Pour plus de détails, visitez https://cla.opensource.microsoft.com.

Lorsque vous soumettez une pull request, un robot CLA déterminera automatiquement si vous devez fournir un CLA et décorera le PR de manière appropriée (par exemple, vérification du statut, commentaire). Suivez simplement les instructions fournies par le bot. Vous n’aurez besoin de le faire qu’une seule fois pour tous les dépôts utilisant notre CLA.

Ce projet a adopté le code de conduite Microsoft Open Source. Pour plus d’informations, consultez la FAQ sur le code de conduite ou contactez [email protected] pour toute question ou commentaire supplémentaire.