GPT-2 est un modèle de langage appris à bien prédire le mot suivant dans un texte donné et optimisé pour la génération de phrases. KoGPT2 est un modèle de langage decoder coréen appris avec plus de 40 Go de texte pour surmonter les performances insuffisantes de la langue coréenne.

|

Formé avec Character BPE tokenizer du package tokenizers .

La taille du dictionnaire est de 51 200 et la capacité de reconnaissance des jetons a été augmentée en ajoutant des émoticônes et des emojis, tels que ceux fréquemment utilisés dans les conversations, comme indiqué ci-dessous.

?, ?, ?, ?, ?, .. ,

:-),:),-),(-:...

De plus, les jetons inutilisés tels que <unused0> à <unused99> ont été définis afin qu'ils puissent être librement définis et utilisés en fonction de la tâche requise.

> from transformers import PreTrainedTokenizerFast

> tokenizer = PreTrainedTokenizerFast . from_pretrained ( "skt/ KoGPT2 -base-v2" ,

bos_token = '</s>' , eos_token = '</s>' , unk_token = '<unk>' ,

pad_token = '<pad>' , mask_token = '<mask>' )

> tokenizer . tokenize ( "안녕하세요. 한국어 GPT-2 입니다.?:)l^o" )

[ '▁안녕' , '하' , '세' , '요.' , '▁한국어' , '▁G' , 'P' , 'T' , '-2' , '▁입' , '니다.' , '?' , ':)' , 'l^o' ]| Modèle | # de paramètres | Taper | # de couches | # de têtes | ffn_dim | caché_dims |

|---|---|---|---|---|---|---|

KoGPT2 -base-v2 | 125M | Décodeur | 12 | 12 | 3072 | 768 |

> import torch

> from transformers import GPT2LMHeadModel

> model = GPT2LMHeadModel . from_pretrained ( 'skt/ KoGPT2 -base-v2' )

> text = '근육이 커지기 위해서는'

> input_ids = tokenizer . encode ( text , return_tensors = 'pt' )

> gen_ids = model . generate ( input_ids ,

max_length = 128 ,

repetition_penalty = 2.0 ,

pad_token_id = tokenizer . pad_token_id ,

eos_token_id = tokenizer . eos_token_id ,

bos_token_id = tokenizer . bos_token_id ,

use_cache = True )

> generated = tokenizer . decode ( gen_ids [ 0 ])

> print ( generated )

근육이 커지기 위해서는 무엇보다 규칙적인 생활습관이 중요하다 .

특히 , 아침식사는 단백질과 비타민이 풍부한 과일과 채소를 많이 섭취하는 것이 좋다 .

또한 하루 30 분 이상 충분한 수면을 취하는 것도 도움이 된다 .

아침 식사를 거르지 않고 규칙적으로 운동을 하면 혈액순환에 도움을 줄 뿐만 아니라 신진대사를 촉진해 체내 노폐물을 배출하고 혈압을 낮춰준다 .

운동은 하루에 10 분 정도만 하는 게 좋으며 운동 후에는 반드시 스트레칭을 통해 근육량을 늘리고 유연성을 높여야 한다 .

운동 후 바로 잠자리에 드는 것은 피해야 하며 특히 아침에 일어나면 몸이 피곤해지기 때문에 무리하게 움직이면 오히려 역효과가 날 수도 있다 ...| NSMC (acc) | KorSTS(lancier) | |

|---|---|---|

| KoGPT2 2.0 | 89,1 | 77,8 |

En plus de Wikipédia coréen, diverses données telles que les actualités et le corpus v1.0 de chacun ont été utilisées pour entraîner le modèle.

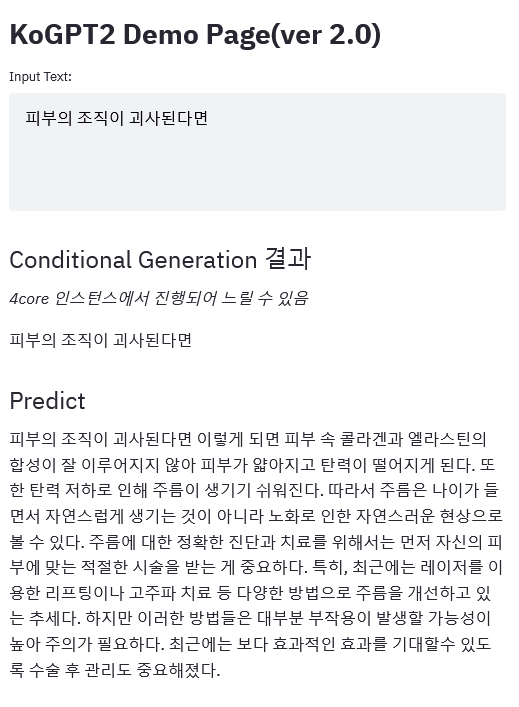

lien de démonstration

|

Veuillez publier les problèmes liés à KoGPT2 ici.

KoGPT2 est publié sous la licence CC-BY-NC-SA 4.0. Veuillez respecter les termes de la licence lorsque vous utilisez des modèles et des codes. La licence complète se trouve dans le fichier LICENSE.