Algorithmes d'audit impressionnants

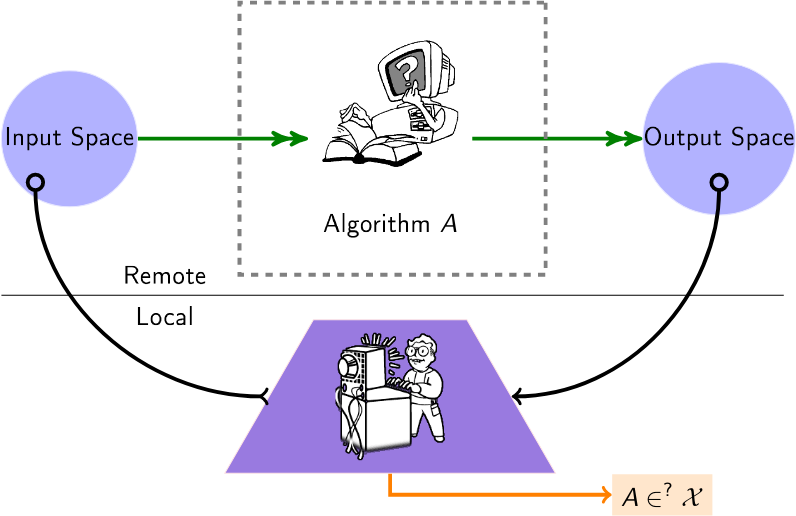

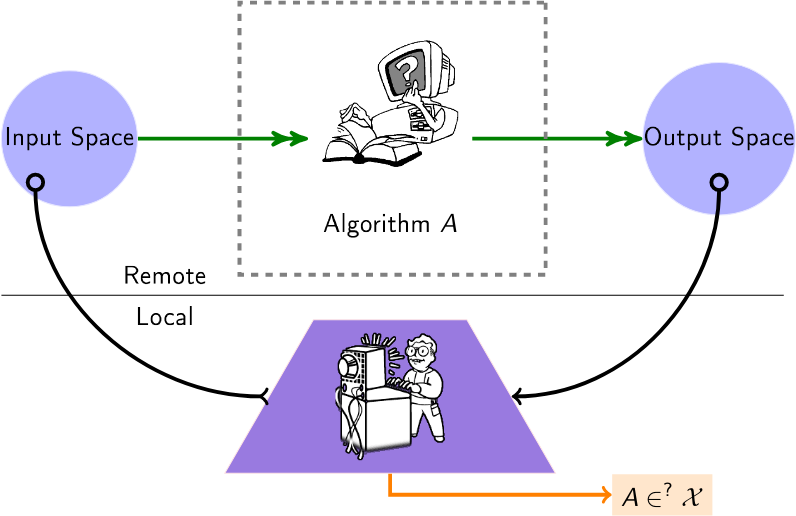

Une liste organisée d'algorithmes pour auditer les algorithmes de boîte noire. De nos jours, de nombreux algorithmes (recommandation, notation, classification) sont exploités chez des fournisseurs tiers, sans que les utilisateurs ou les institutions n'aient la moindre idée de la manière dont ils opèrent sur leurs données. Les algorithmes d'audit de cette liste s'appliquent donc à cette configuration, appelée configuration de « boîte noire », dans laquelle un auditeur souhaite avoir un aperçu de ces algorithmes distants.

Un utilisateur interroge un algorithme distant (par exemple, via les API disponibles), pour déduire des informations sur cet algorithme.

Contenu

- Papiers

- Événements connexes (conférences/ateliers)

Papiers

2024

- L'audit des explications locales est difficile - (NeurIPS) Donne la complexité (prohibitive) des requêtes d'audit des explications.

- Les LLM hallucinent aussi les graphiques : une perspective structurelle - (réseaux complexes) Interroge les LLM pour rechercher des graphiques connus et étudie les hallucinations topologiques. Propose un rang d’hallucination structurelle.

- Audit d'équité avec collaboration multi-agents - (ECAI) considère plusieurs agents travaillant ensemble, chacun auditant la même plate-forme pour des tâches différentes.

- Cartographie du domaine de l'audit d'algorithmes : une revue systématique de la littérature identifiant les tendances de recherche, les disparités linguistiques et géographiques - (Arxiv) Revue systématique des études d'audit d'algorithmes et identification des tendances dans leurs approches méthodologiques.

- FairProof : équité confidentielle et certifiable pour les réseaux de neurones - (Arxiv) Propose un paradigme alternatif à l'audit traditionnel en utilisant des outils cryptographiques tels que les preuves à connaissance nulle ; propose un système appelé FairProof pour vérifier l'équité des petits réseaux de neurones.

- Sous manipulations, certains modèles d’IA sont-ils plus difficiles à auditer ? - (SATML) Relie la difficulté des audits boîte noire à la capacité des modèles ciblés, en utilisant la complexité Rademacher.

- Attaques d'inférence d'adhésion améliorées contre les modèles de classification linguistique - (ICLR) Présente un cadre pour exécuter des attaques d'inférence d'appartenance contre un classificateur, en mode audit.

- Audit de l'équité par les paris - (Neurips) [Code] Méthodes séquentielles qui permettent la surveillance continue des données entrantes provenant d'un classificateur ou d'un régresseur boîte noire.

2023

- Audit de confidentialité avec une (1) exécution de formation - (NeurIPS - meilleur article) Un système d'audit des systèmes d'apprentissage automatique différentiellement privés avec une seule exécution de formation.

- Auditer l'équité sans le savoir grâce à un raisonnement contrefactuel - (Traitement et gestion de l'information) Montre comment dévoiler si un modèle de boîte noire, conforme à la réglementation, est toujours biaisé ou non.

- XAudit : Un regard théorique sur l'audit avec explications - (Arxiv) Formalise le rôle des explications dans l'audit et étudie si et comment les explications du modèle peuvent aider les audits.

- Suivre les modèles de langage : interaction robustesse-biais dans les données et les modèles NLI - (Arxiv) Propose un moyen de prolonger la durée de conservation des ensembles de données d'audit en utilisant les modèles de langage eux-mêmes ; trouve également des problèmes avec les mesures actuelles d'audit des biais et propose des alternatives - ces alternatives soulignent que la fragilité du modèle a augmenté superficiellement les scores de biais précédents.

- Audit d'équité en ligne par raffinement itératif - (KDD) Fournit un processus adaptatif qui automatise l'inférence de garanties probabilistes associées à l'estimation des mesures d'équité.

- Voler les algorithmes de décodage des modèles de langage - (CCS) Voler le type et les hyperparamètres des algorithmes de décodage d'un LLM.

- Modélisation de terriers de lapin sur YouTube - (SNAM) Modélise la dynamique de piégeage des utilisateurs dans des terriers de lapin sur YouTube et fournit une mesure de cet enclos.

- Audit de l'algorithme de recommandation de YouTube pour les bulles de filtre de désinformation - (Transactions sur les systèmes de recommandation) Ce qu'il faut pour « éclater la bulle », c'est-à-dire retirer l'enceinte à bulles des recommandations.

- Audit du classement des entreprises et des recommandations d'examen de Yelp à travers le prisme de l'équité - (Arxiv) Audite l'équité des systèmes de classement des entreprises et de recommandation d'avis de Yelp, avec la parité démographique, l'exposition et des tests statistiques tels que la régression linéaire et logistique quantile.

- Confidentiel-PROFITT : CONFIDENTIAL PROof of FaIr Training of Trees - (ICLR) Propose des algorithmes d'apprentissage d'arbres de décision équitables ainsi que des protocoles de preuve de connaissance nulle pour obtenir une preuve d'équité sur le serveur audité.

- SCALE-UP : une détection efficace de porte dérobée au niveau de l'entrée de la boîte noire via l'analyse de la cohérence des prédictions à l'échelle - (ICLR) prend en compte la détection de porte dérobée dans le cadre du paramètre de boîte noire dans les applications d'apprentissage automatique en tant que service (MLaaS).

2022

- Two-Face : Audit contradictoire des systèmes commerciaux de reconnaissance faciale - (ICWSM) Effectue un audit contradictoire sur plusieurs API et ensembles de données de systèmes, en faisant un certain nombre d'observations préoccupantes.

- Augmenter les audits des moteurs de recherche : informations pratiques pour l'audit des algorithmes - (Journal of Information Science) (Code) Audite plusieurs moteurs de recherche à l'aide d'un comportement de navigation simulé avec des agents virtuels.

- Un zeste de citron vert : vers des distances de modèles indépendantes de l'architecture - (ICLR) Mesure la distance entre deux modèles distants à l'aide de LIME.

- Active Fairness Auditing - (ICML) Études d'algorithmes d'audit basés sur des requêtes qui peuvent estimer la parité démographique des modèles ML de manière efficace en matière de requêtes.

- Regardez l'écart ! Explications efficaces de la boîte noire avec analyse de sensibilité basée sur Sobol - (NeurIPS) Les indices Sobol fournissent un moyen efficace de capturer les interactions d'ordre supérieur entre les régions d'image et leurs contributions à la prédiction d'un réseau neuronal (boîte noire) à travers le prisme de la variance.

- Vos échos sont entendus : suivi, profilage et ciblage publicitaire dans l'écosystème de haut-parleurs intelligents d'Amazon - (arxiv) Déduit un lien entre le système Amazon Echo et l'algorithme de ciblage publicitaire.

2021

- Quand l'arbitre est également un acteur : biais dans les recommandations de produits de marque privée sur les marchés de commerce électronique - (FAccT) Les produits de marque privée d'Amazon reçoivent-ils une part injuste des recommandations et sont-ils donc avantagés par rapport aux produits tiers ?

- Audit d'algorithmes quotidiens : Comprendre le pouvoir des utilisateurs quotidiens dans la détection de comportements algorithmiques nuisibles - (CHI) plaide en faveur d'un "audit algorithmique quotidien" par les utilisateurs.

- Audit des modèles de prédiction Black-Box pour la conformité de la minimisation des données - (NeurIPS) Mesure le niveau de minimisation des données satisfait par le modèle de prédiction à l'aide d'un nombre limité de requêtes.

- Remettre les pendules à l'heure sur le Shadow Banning - (INFOCOM) (Code) considère la possibilité de shadow banning sur Twitter (c'est-à-dire l'algorithme de la boîte noire de modération) et mesure la probabilité de plusieurs hypothèses.

- Extraction de données de formation à partir de grands modèles linguistiques - (USENIX Security) Extrayez des séquences de texte textuelles à partir des données de formation du modèle GPT-2.

- FairLens : Audit des systèmes d'aide à la décision clinique en boîte noire - (Traitement et gestion de l'information) Présente un pipeline pour détecter et expliquer les problèmes d'équité potentiels dans le DSS clinique, en comparant différentes mesures de disparité de classification multi-étiquettes.

- Audit des biais algorithmiques sur Twitter - (WebSci).

- Exécution d'un algorithme bayésien : estimation des propriétés calculables des fonctions de boîte noire à l'aide d'informations mutuelles - (ICML) Une procédure d'optimisation bayésienne à budget limité pour extraire les propriétés d'un algorithme de boîte noire.

2020

- Black-Box Ripper : Copie de modèles de boîte noire à l'aide d'algorithmes évolutifs génératifs - (NeurIPS) Reproduit la fonctionnalité d'un modèle neuronal de boîte noire, mais sans limite sur le nombre de requêtes (via un schéma enseignant/élève et une recherche évolutive) .

- Audit des voies de radicalisation sur - (FAT*) Étudie l'accessibilité des chaînes radicales les unes par rapport aux autres, en utilisant des marches aléatoires sur les recommandations de chaînes statiques.

- Extraction de modèles contradictoires sur les réseaux de neurones graphiques - (Atelier AAAI sur l'apprentissage profond sur les graphiques : méthodologies et applications) Présente l'extraction de modèles GNN et présente une approche préliminaire pour cela.

- L'explicabilité à distance fait face au problème du videur - (Nature Machine Intelligence volume 2, pages 529-539) (Code) Montre l'impossibilité (avec une seule demande) ou la difficulté de repérer les mensonges sur les explications d'une décision d'IA à distance.

- GeoDA : un cadre géométrique pour les attaques contradictoires en boîte noire - (CVPR) (Code) Crée des exemples contradictoires pour tromper les modèles, dans une configuration pure boîte noire (pas de dégradés, classe déduite uniquement).

- Le jeu d'imitation : sélection d'algorithmes en exploitant le système de recommandation Black-Box - (Netys) (Code) Paramétrer un algorithme de recommandation local en imitant la décision d'un algorithme distant et mieux formé.

- Audit des systèmes de conservation des actualités : une étude de cas examinant la logique algorithmique et éditoriale dans Apple News - (ICWSM) Étude d'audit d'Apple News en tant que système de conservation des actualités sociotechniques (section des articles tendances).

- Algorithmes d'audit : sur les leçons apprises et les risques de minimisation des données - (AIES) Un audit pratique pour une application de recommandation de bien-être développée par Telefónica (principalement sur la base de biais).

- Extraction de données de formation à partir de grands modèles de langage - (arxiv) Effectue une attaque d'extraction de données de formation pour récupérer des exemples de formation individuels en interrogeant le modèle de langage.

2019

- Adversarial Frontier Stitching pour le filigrane de réseau neuronal à distance - (informatique neuronale et applications) (implémentation alternative) Vérifiez si un modèle d'apprentissage automatique à distance est une "fuite": via des requêtes API standard adressées à un modèle distant, extrayez (ou non) un zéro- filigrane de bits, qui a été inséré pour filigraner des modèles précieux (par exemple, de grands réseaux de neurones profonds).

- Knockoff Nets : Voler la fonctionnalité des modèles de boîte noire - (CVPR) Demandez dans quelle mesure un adversaire peut voler la fonctionnalité de tels modèles de "victimes" en se basant uniquement sur les interactions de la boîte noire : entrée d'image, prédictions sortantes.

- Ouvrir la boîte noire : audit de l'algorithme des Top Stories de Google - (Flairs-32) Audit du panneau Top Stories de Google qui fournit des informations sur ses choix algorithmiques pour la sélection et le classement des éditeurs d'actualités

- Rendre les attaques ciblées d'évasion de boîte noire efficaces et efficientes - (arXiv) étudie comment un adversaire peut utiliser de manière optimale son budget de requêtes pour des attaques d'évasion ciblées contre des réseaux neuronaux profonds.

- Apprentissage en ligne pour mesurer la compatibilité des incitations dans les enchères publicitaires - (WWW) Mesure les mécanismes (regrets) compatibles avec les incitations (IC) des plateformes d'enchères en boîte noire.

- TamperNN : Détection efficace de la falsification des réseaux neuronaux déployés - (ISSRE) Algorithmes pour créer des entrées capables de détecter la falsification d'un modèle de classificateur exécuté à distance.

- Attaques d'extraction de modèle de réseau neuronal dans les appareils de périphérie en entendant des conseils architecturaux - (arxiv) Grâce à l'acquisition d'événements d'accès à la mémoire à partir de la surveillance du bus, à l'identification de la séquence de couches par le modèle LSTM-CTC, à la connexion de la topologie des couches en fonction du modèle d'accès à la mémoire et à l'estimation des dimensions des couches sous contraintes de volume de données, cela démontre que l'on peut récupérer avec précision une architecture réseau similaire comme point de départ de l'attaque

- Voler des connaissances à partir de réseaux neuronaux profonds protégés à l'aide de données composites non étiquetées - (ICNN) Méthode composite qui peut être utilisée pour attaquer et extraire les connaissances d'un modèle de boîte noire même s'il dissimule complètement sa sortie softmax.

- Inversion du réseau neuronal dans un contexte adverse via l'alignement des connaissances de base - (CCS) Approche d'inversion de modèle dans le contexte adverse basée sur la formation d'un modèle d'inversion qui agit comme l'inverse du modèle d'origine. Sans connaissance complète des données d'entraînement d'origine, une inversion précise est toujours possible en entraînant le modèle d'inversion sur des échantillons auxiliaires tirés d'une distribution de données plus générique.

2018

- Explications contrefactuelles sans ouvrir la boîte noire : les décisions automatisées et le RGPD - (Harvard Journal of Law & Technology) Pour expliquer une décision sur x, trouvez un contrefactuel : le point le plus proche de x qui modifie la décision.

- Distiller et comparer : Audit des modèles de boîte noire à l'aide de la distillation de modèles transparents - (AIES) Traite les modèles de boîte noire comme des enseignants, formant des modèles d'étudiants transparents pour imiter les scores de risque attribués par les modèles de boîte noire.

- Vers des réseaux de neurones en boîte noire de rétro-ingénierie - (ICLR) (Code) Déduire des hyperparamètres internes (par exemple, nombre de couches, type d'activation non linéaire) d'un modèle de réseau neuronal distant en analysant ses modèles de réponse à certaines entrées.

- Attaques exploratoires basées sur les données contre les classificateurs boîte noire dans des domaines contradictoires - (Neuroinformatique) Rétro-ingénierie de modèles de classificateurs à distance (par exemple, pour éviter un test CAPTCHA).

- xGEMs : Générer des exemples pour expliquer les modèles de boîte noire - (arXiv) Recherche les biais dans le modèle de boîte noire en entraînant un modèle génératif implicite non supervisé. Ensuite, nous résumons quantitativement le comportement du modèle de boîte noire en perturbant les échantillons de données le long de la variété de données.

- Réseaux d'apprentissage à partir de similarités de nœuds basées sur la marche aléatoire - (NIPS) Inversion des graphiques en observant certains temps de trajet à pied aléatoires.

- Identification de la famille d'apprentissage automatique à partir de modèles de boîte noire - (CAEPIA) Détermine quel type de modèle d'apprentissage automatique se cache derrière les prédictions renvoyées.

- Voler des réseaux de neurones via des canaux latéraux de synchronisation - (arXiv) Voler/rapprocher un modèle via des attaques de synchronisation à l'aide de requêtes.

- Copycat CNN : Voler des connaissances en persuadant des aveux avec des données aléatoires non étiquetées - (IJCNN) (Code) Voler des connaissances sur des modèles de boîtes noires (CNN) en les interrogeant avec des images naturelles aléatoires (ImageNet et Microsoft-COCO).

- Audit de la personnalisation et de la composition des pages de résultats des moteurs de recherche à caractère politique - (WWW) Une extension Chrome pour interroger les participants et collecter les pages de résultats des moteurs de recherche (SERP) et les suggestions de saisie semi-automatique, pour étudier la personnalisation et la composition.

2017

- Uncovering Influence Cookbooks : Reverse Engineering the Topological Impact in Peer Ranking Services - (CSCW) Vise à identifier les métriques de centralité utilisées dans un service de classement par les pairs.

- Le visage topologique de la recommandation : modèles et application à la détection des biais - (Réseaux complexes) Propose un cadre de détection des biais pour les éléments recommandés aux utilisateurs.

- Attaques par inférence d'adhésion contre les modèles d'apprentissage automatique - (Symposium sur la sécurité et la confidentialité) Étant donné un modèle d'apprentissage automatique et un enregistrement, déterminez si cet enregistrement a été utilisé ou non dans le cadre de l'ensemble de données de formation du modèle.

- Attaques pratiques de boîte noire contre l'apprentissage automatique - (Asia CCS) Comprenez à quel point un service distant est vulnérable aux attaques de classification contradictoires.

2016

- Transparence algorithmique via l'influence des entrées quantitatives : théorie et expériences avec les systèmes d'apprentissage - (IEEE S&P) Évaluez l'influence individuelle, conjointe et marginale des caractéristiques sur un modèle à l'aide des valeurs Shapley.

- Audit des modèles de boîte noire pour l'influence indirecte - (ICDM) Évaluez l'influence d'une variable sur un modèle de boîte noire en la supprimant « intelligemment » de l'ensemble de données et en examinant l'écart de précision.

- Projection itérative de caractéristiques orthogonales pour diagnostiquer les biais dans les modèles de boîte noire - (Atelier FATML) Effectue un classement des caractéristiques pour analyser les modèles de boîte noire

- Biais sur les marchés indépendants en ligne : preuves de TaskRabbit - (atelier de données) Mesure le classement de l'algorithme de recherche de TaskRabbit.

- Voler des modèles d'apprentissage automatique via des API de prédiction - (Usenix Security) (Code) Vise à extraire des modèles d'apprentissage automatique utilisés par les services distants.

- « Pourquoi devrais-je vous faire confiance ? » Expliquer les prédictions de n'importe quel classificateur - (arXiv) (Code) Explique un modèle de classificateur boîte noire en échantillonnant autour d'instances de données.

- Back in Black : Vers une analyse formelle en boîte noire des désinfectants et des filtres - (Sécurité et confidentialité) Analyse en boîte noire des désinfectants et des filtres.

- Transparence algorithmique via l'influence quantitative des entrées : théorie et expériences avec les systèmes d'apprentissage - (Sécurité et confidentialité) Présente des mesures qui capturent le degré d'influence des entrées sur les sorties du système observé.

- Une analyse empirique de la tarification algorithmique sur Amazon Marketplace - (WWW) (Code) Développe une méthodologie pour détecter la tarification algorithmique et l'utilise de manière empirique pour analyser leur prévalence et leur comportement sur Amazon Marketplace.

2015

- Certifier et supprimer les impacts disparates - (SIGKDD) Propose des méthodes basées sur SVM pour certifier l'absence de biais et des méthodes pour supprimer les biais d'un ensemble de données.

- Peeking Undereath the Hood of Uber - (IMC) Déduire les détails de mise en œuvre de l'algorithme de hausse des prix d'Uber.

2014

- Un coup d'œil dans la boîte noire : explorer les classificateurs par randomisation - (Journal Data Mining and Knowledge Discovery) (code) Trouve des groupes de fonctionnalités qui peuvent être permutés sans changer l'étiquette de sortie des échantillons prédits

- XRay : Amélioration de la transparence du Web grâce à une corrélation différentielle - (USENIX Security) Vérifie quelles données de profil utilisateur ont été utilisées pour cibler une annonce, une recommandation ou un prix particulier.

2013

- Mesure de la personnalisation de la recherche sur le Web - (WWW) Développe une méthodologie pour mesurer la personnalisation des résultats de recherche sur le Web.

- Audit : apprentissage actif avec des coûts de requête dépendants des résultats - (NIPS) Apprend à partir d'un classificateur binaire ne payant que pour les étiquettes négatives.

2012

- Stratégies de requête pour éviter les classificateurs inducteurs convexes - (JMLR) Méthodes d'évasion pour les classificateurs convexes. Prend en compte la complexité de l'évasion.

2008

- Privacy Oracle : un système pour rechercher les fuites d'applications avec des tests différentiels en boîte noire - (CCS) Privacy Oracle : un système qui découvre les fuites d'informations personnelles des applications lors des transmissions vers des serveurs distants.

2005

- Apprentissage contradictoire - (KDD) Ingénierie inverse de classificateurs linéaires distants, à l'aide de requêtes d'adhésion.

Événements connexes

2024

- 1ère Conférence internationale sur l'audit et l'intelligence artificielle

- Atelier ML régulable (RegML'24)

2023

- Soutenir l'engagement des utilisateurs dans les tests, l'audit et la contestation de l'IA (Audit de l'IA des utilisateurs CSCW)

- Atelier sur les audits algorithmiques des algorithmes (WAAA)

- Atelier ML régulable (RegML'23)