Compilation d'IA offensive

Une liste organisée de ressources utiles qui couvrent l’IA offensive.

? Contenu ?

- Abus

- ? Apprentissage automatique contradictoire ?

- ⚡ Attaques ⚡

- Extraction

- ️ Limites ️

- ?️ Actions défensives ?️

- ? Liens utiles ?

- ⬅️ Inversion (ou inférence) ⬅️

- ?️ Actions défensives ?️

- ? Liens utiles ?

- ? Empoisonnement ?

- ? Des portes dérobées ?

- ?️ Actions défensives ?️

- ? Liens utiles ?

- ?♂️ Évasion ?♂️

- ?️ Actions défensives ?️

- ? Liens utiles ?

- Outils

- ? Utiliser ?

- ♂️ Pentest ♂️

- ? Un logiciel malveillant ?

- ?️OSINT ?️

- ? Phishing ?

- ?? IA générative ??

- ? Audio ?

- Outils

- Applications

- ? Détection ?

- ? Image ?

- Outils

- Applications

- ? Détection ?

- ? Vidéo ?

- Outils

- Applications

- ? Détection ?

- ? Texte ?

- Outils

- ? Détection ?

- Applications

- Divers

- Enquêtes

- ? Des contributeurs ?

- ©️ Licence ©️

Abus

Exploiter les vulnérabilités des modèles d’IA.

? Apprentissage automatique contradictoire ?

L'apprentissage automatique contradictoire est chargé d'évaluer leurs faiblesses et de fournir des contre-mesures.

⚡Attaques⚡

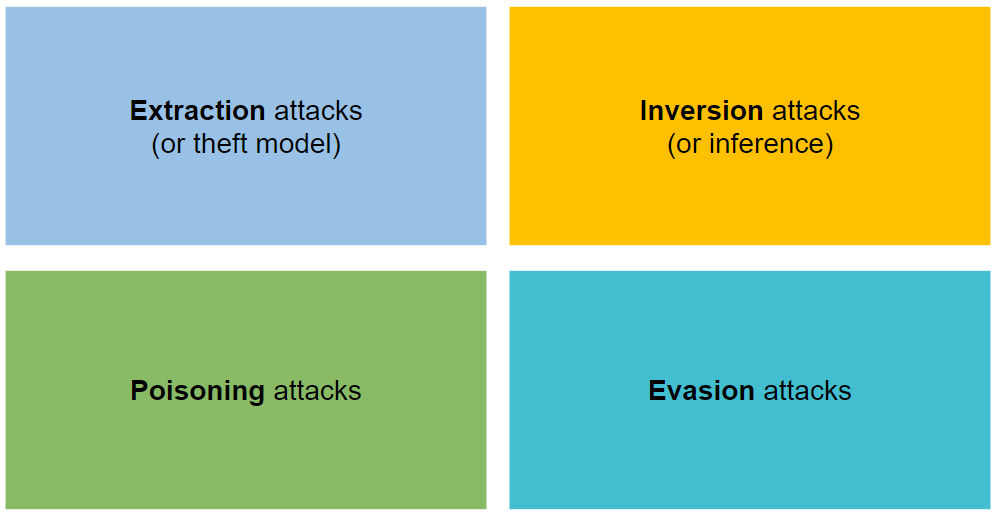

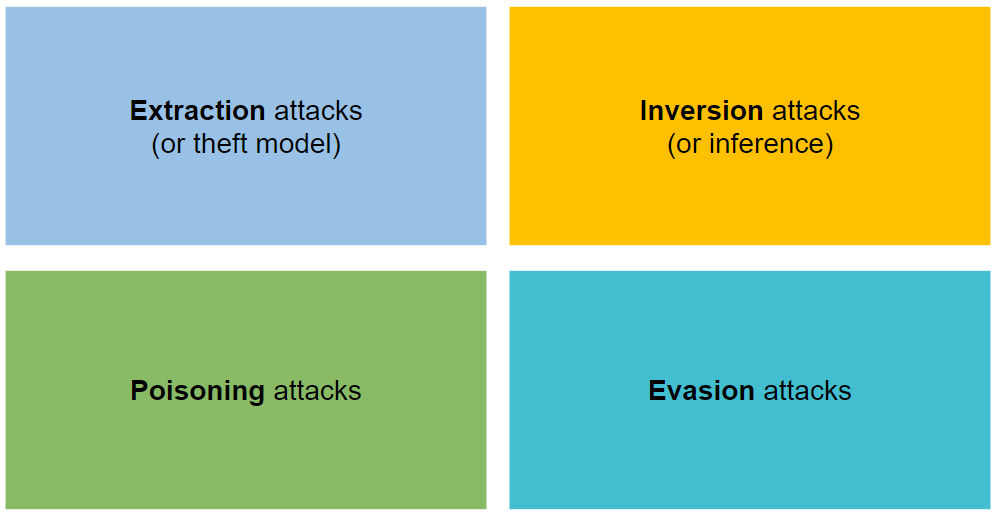

Elle s'organise en quatre types d'attaques : extraction, inversion, empoisonnement et évasion.

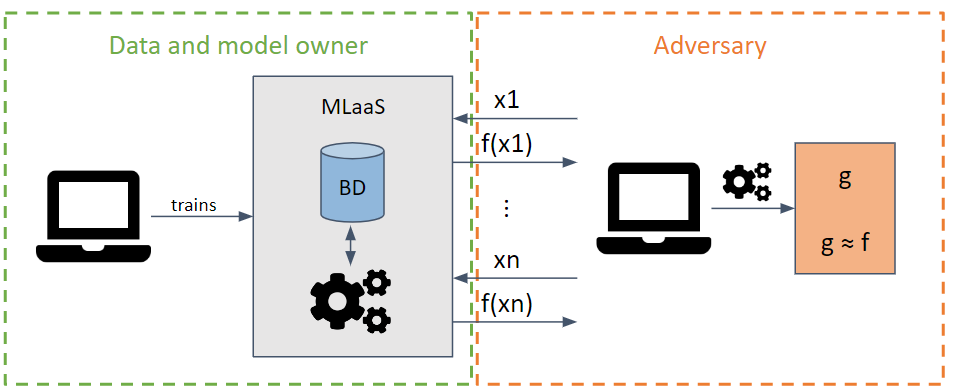

Extraction

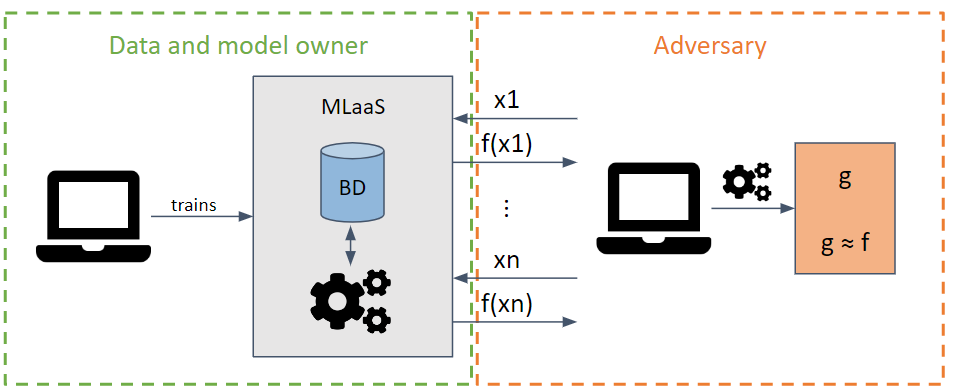

Il tente de voler les paramètres et hyperparamètres d'un modèle en effectuant des requêtes qui maximisent l'extraction d'informations.

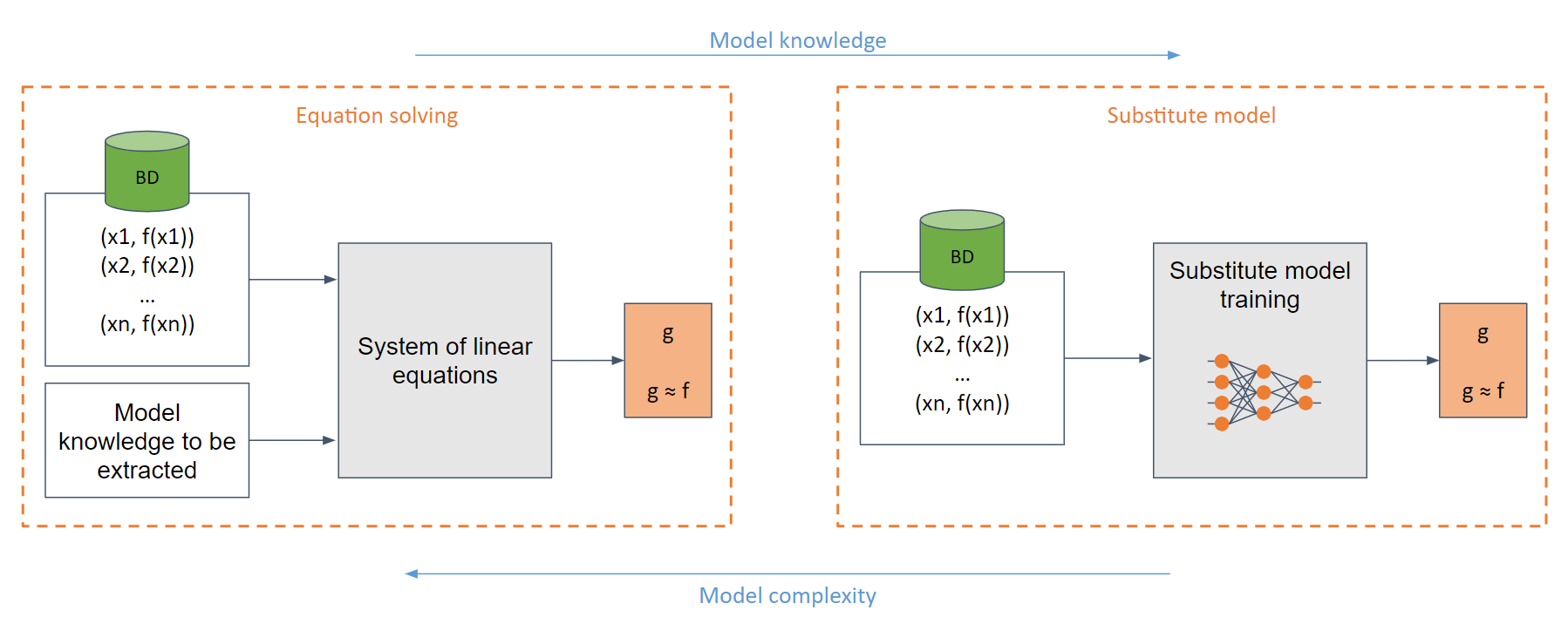

En fonction de la connaissance du modèle de l'adversaire, des attaques en boîte blanche et en boîte noire peuvent être effectuées.

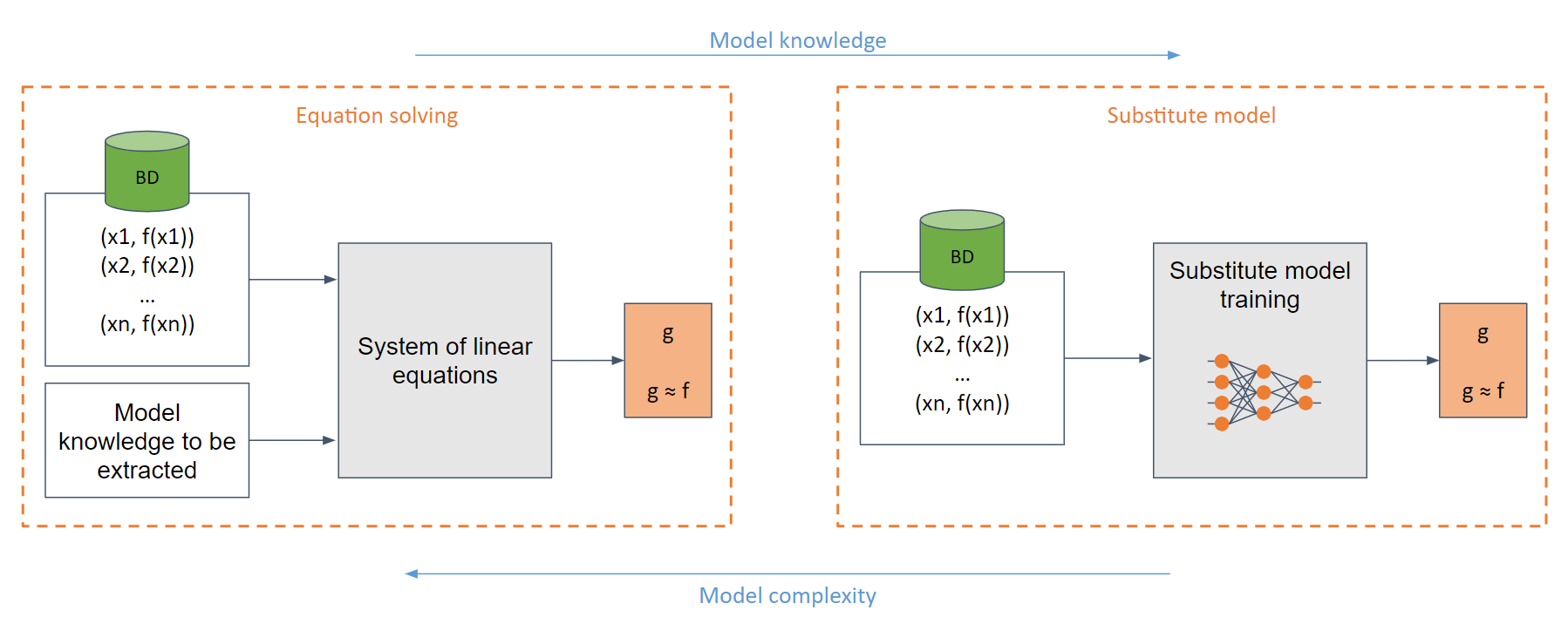

Dans le cas le plus simple de la boîte blanche (lorsque l'adversaire connaît parfaitement le modèle, par exemple une fonction sigmoïde), on peut créer un système d'équations linéaires qui peuvent être facilement résolues.

Dans le cas générique, où la connaissance du modèle est insuffisante, le modèle de substitution est utilisé. Ce modèle est entraîné avec les requêtes faites au modèle d'origine afin d'imiter la même fonctionnalité que celui d'origine.

️ Limites ️

?️ Actions défensives ?️

Arrondi des valeurs de sortie.

Utilisation de la confidentialité différentielle.

Utilisation d'ensembles.

Utilisation de défenses spécifiques

- Architectures spécifiques

- PRADA

- Désinformation adaptative

- ...

? Liens utiles ?

- Voler des modèles d'apprentissage automatique via des API de prédiction

- Voler des hyperparamètres dans l'apprentissage automatique

- Knockoff Nets : fonctionnalité de vol des modèles Black-Box

- Avertissement d’extraction de modèle dans le paradigme MLaaS

- Copycat CNN : voler des connaissances en persuadant des aveux avec des données aléatoires non étiquetées

- Empoisonnement des prédictions : vers des défenses contre les attaques de vol de modèles DNN

- Voler des réseaux de neurones via des canaux latéraux de synchronisation

- Attaques de vol de modèle contre les réseaux de neurones à graphes inductifs

- Extraction de haute précision et haute fidélité de réseaux de neurones

- L’empoisonnement des ensembles de données de formation à l’échelle du Web est pratique

- Extraction cryptanalytique en temps polynomial de modèles de réseaux neuronaux

- Attaques d'empoisonnement spécifiques aux invites sur les modèles génératifs texte-image

- Empoisonnement de données impressionnant et attaques par porte dérobée : une liste organisée d'articles et de ressources liés à l'empoisonnement des données, aux attaques par porte dérobée et aux défenses contre celles-ci.

- BackdoorBox : une boîte à outils Python open source pour les attaques et les défenses par porte dérobée.

- Voler une partie d'un modèle de langage de production

- Extraction cryptanalytique en dur de modèles de réseaux neuronaux

⬅️ Inversion (ou inférence) ⬅️

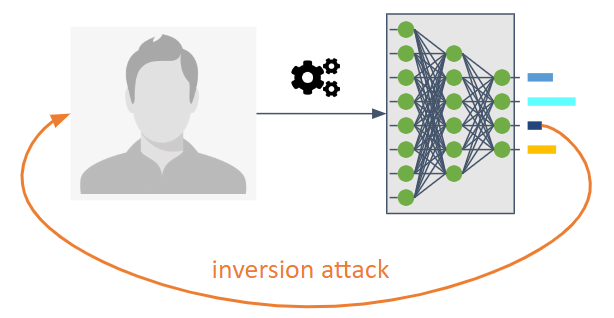

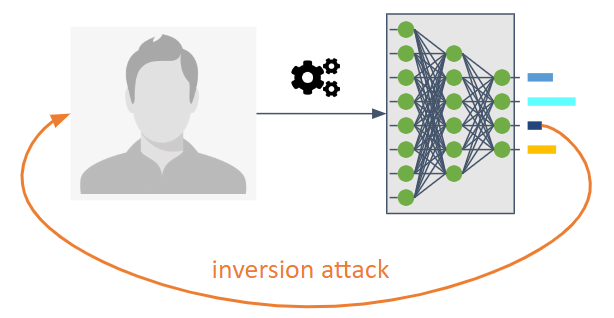

Ils visent à inverser le flux d’informations d’un modèle d’apprentissage automatique.

Ils permettent à un adversaire de connaître le modèle qui n’était pas explicitement destiné à être partagé.

Ils nous permettent de connaître les données ou informations d'entraînement en tant que propriétés statistiques du modèle.

Trois types sont possibles :

Membership Inference Attack (MIA) : un adversaire tente de déterminer si un échantillon a été utilisé dans le cadre de la formation.

Property Inference Attack (PIA) : un adversaire vise à extraire des propriétés statistiques qui n'ont pas été explicitement codées en tant que fonctionnalités lors de la phase d'entraînement.

Reconstruction : Un adversaire tente de reconstruire un ou plusieurs échantillons de l'ensemble d'entraînement et/ou leurs étiquettes correspondantes. Aussi appelé inversion.

?️ Actions défensives ?️

Utilisation de cryptographie avancée. Les contre-mesures incluent la confidentialité différentielle, la cryptographie homomorphe et le calcul multipartite sécurisé.

Utilisation de techniques de régularisation telles que le Dropout en raison de la relation entre le surentraînement et la vie privée.

La compression de modèle a été proposée comme moyen de défense contre les attaques de reconstruction.

? Liens utiles ?

- Attaques d'inférence d'adhésion contre les modèles d'apprentissage automatique

- Attaques d'inversion de modèles qui exploitent des informations de confiance et des contre-mesures de base

- Modèles d'apprentissage automatique qui mémorisent trop de choses

- ML-Leaks : attaques et défenses par inférence d'adhésion indépendantes des modèles et des données sur les modèles d'apprentissage automatique

- Modèles profonds sous le GAN : fuite d'informations provenant du Deep Learning collaboratif

- LOGAN : Attaques d'inférence d'adhésion contre les modèles génératifs

- Surapprentissage, robustesse et algorithmes malveillants : une étude des causes potentielles de risque pour la vie privée dans l'apprentissage automatique

- Analyse complète de la confidentialité du Deep Learning : apprentissage autonome et fédéré sous attaques d'inférence passives et actives en boîte blanche

- Attaques d'inférence contre l'apprentissage collaboratif

- The Secret Sharer : évaluer et tester la mémorisation involontaire dans les réseaux de neurones

- Vers la science de la sécurité et de la confidentialité dans l’apprentissage automatique

- MemGuard : Se défendre contre les attaques d'inférence d'adhésion à la boîte noire via des exemples contradictoires

- Extraction de données de formation à partir de grands modèles de langage

- Attaques par inférence de propriété sur des réseaux de neurones entièrement connectés à l'aide de représentations invariantes par permutation

- Extraction de données de formation à partir de modèles de diffusion

- Reconstruction d'images haute résolution avec des modèles de diffusion latente issus de l'activité cérébrale humaine

- Voler et éviter les classificateurs de logiciels malveillants et les antivirus dans des conditions de faux positifs faibles

- Attaques réalistes de présentation d’empreintes digitales basées sur une approche contradictoire

- Tests contradictoires actifs : accroître la confiance dans les évaluations de robustesse contradictoire.

- Statut du jailbreak GPT : mises à jour sur l'état du jailbreak du modèle de langage OpenAI GPT.

- Accélération de l'ordre de grandeur pour l'inférence d'adhésion au LLM

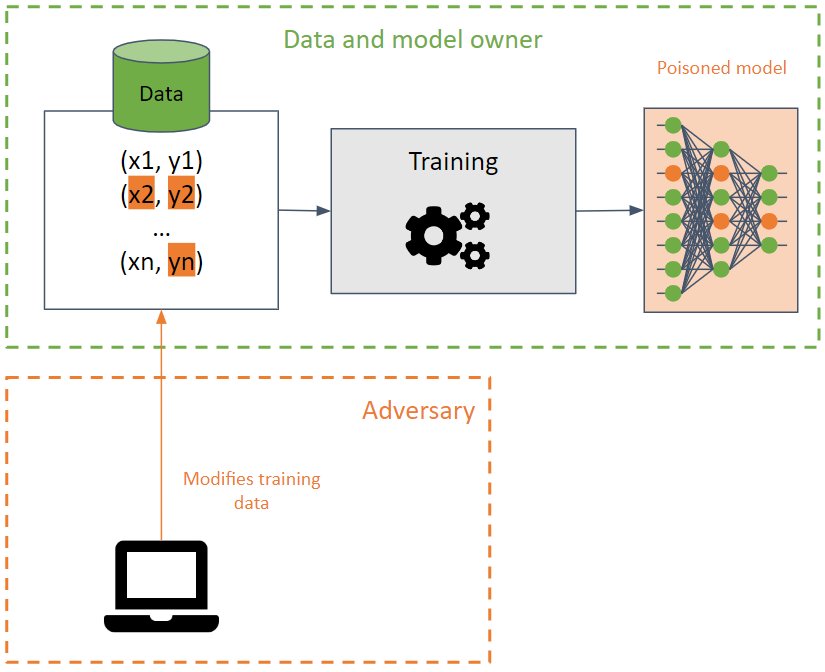

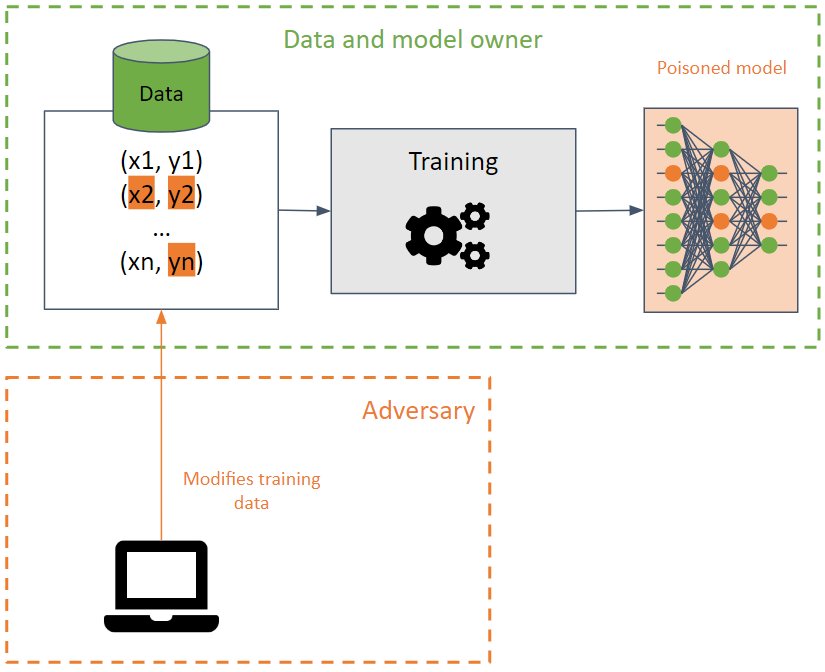

? Empoisonnement ?

Ils visent à corrompre l’ensemble de formation en amenant un modèle d’apprentissage automatique à réduire sa précision.

Cette attaque est difficile à détecter lorsqu'elle est effectuée sur les données d'entraînement, car elle peut se propager entre différents modèles utilisant les mêmes données d'entraînement.

L'adversaire cherche à détruire la disponibilité du modèle en modifiant la limite de décision et, par conséquent, en produisant des prédictions incorrectes ou en créant une porte dérobée dans un modèle. Dans ce dernier cas, le modèle se comporte correctement (renvoyant les prédictions souhaitées) dans la plupart des cas, à l'exception de certaines entrées spécialement créées par l'adversaire qui produisent des résultats indésirables. L’adversaire peut manipuler les résultats des prédictions et lancer de futures attaques.

? Des portes dérobées ?

Les BadNets constituent le type de porte dérobée le plus simple dans un modèle d’apprentissage automatique. De plus, les BadNets sont capables d'être préservés dans un modèle, même s'ils sont à nouveau recyclés pour une tâche différente de celle du modèle d'origine (apprentissage par transfert).

Il est important de noter que les modèles publics pré-entraînés peuvent contenir des portes dérobées .

?️ Actions défensives ?️

Détection des données empoisonnées, ainsi que recours à la désinfection des données.

Des méthodes de formation robustes.

Défenses spécifiques.

- Neural Cleanse : identifier et atténuer les attaques par porte dérobée dans les réseaux de neurones

- STRIP : une défense contre les attaques de chevaux de Troie sur les réseaux de neurones profonds

- Détection des attaques de porte dérobée sur les réseaux de neurones profonds par clustering d'activation

- ABS : analyse des réseaux neuronaux à la recherche de portes dérobées par stimulation cérébrale artificielle

- DeepInspect : un cadre de détection et d'atténuation des chevaux de Troie boîte noire pour les réseaux de neurones profonds

- Défendre les portes dérobées neuronales via la modélisation de distribution générative

- Une enquête complète sur les attaques par porte dérobée et leurs défenses dans les systèmes de reconnaissance faciale

- DataElixir : Purifier un ensemble de données empoisonné pour atténuer les attaques de porte dérobée via des modèles de diffusion

? Liens utiles ?

- Attaques d'empoisonnement contre des machines à vecteurs de support

- Attaques dérobées ciblées sur les systèmes de Deep Learning utilisant l'empoisonnement des données

- Attaque de cheval de Troie sur les réseaux de neurones

- Élagage fin : se défendre contre les attaques de porte dérobée sur les réseaux de neurones profonds

- Grenouilles empoisonnées ! Attaques d’empoisonnement ciblées sur les réseaux neuronaux

- Signatures spectrales dans les attaques par porte dérobée

- Attaques dérobées latentes sur les réseaux de neurones profonds

- Regula Sub-rosa : attaques dérobées latentes sur les réseaux de neurones profonds

- Attaques de porte dérobée à déclencheur caché

- Attaques d’empoisonnement transférables en clean label sur les réseaux neuronaux profonds

- TABOR : une approche très précise pour inspecter et restaurer les portes dérobées des chevaux de Troie dans les systèmes d'IA

- Vers l’empoisonnement des algorithmes d’apprentissage profond avec l’optimisation du back-gradient

- Quand l’apprentissage automatique échoue-t-il ? Transférabilité généralisée pour les attaques d’évasion et d’empoisonnement

- Défenses certifiées contre les attaques d’empoisonnement des données

- Attaque de porte dérobée dynamique sensible aux entrées

- Comment faire un apprentissage fédéré par porte dérobée

- Implanter des portes dérobées indétectables dans les modèles d'apprentissage automatique

- Tromper l'IA ! : Les pirates peuvent utiliser des portes dérobées pour empoisonner les données d'entraînement et amener un modèle d'IA à mal classer les images. Découvrez comment les chercheurs d'IBM peuvent déterminer quand des données ont été empoisonnées, puis deviner quelles portes dérobées ont été cachées dans ces ensembles de données. Pouvez-vous deviner la porte dérobée ?

- Backdoor Toolbox : une boîte à outils compacte pour les attaques et les défenses par porte dérobée.

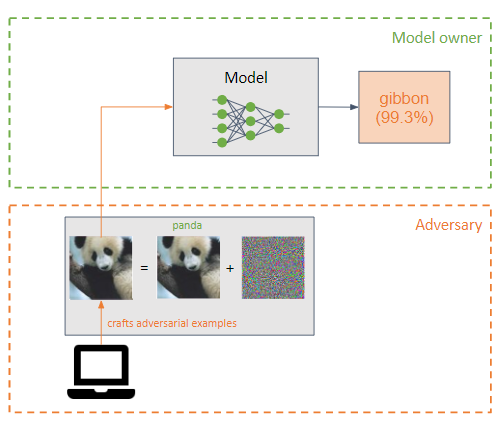

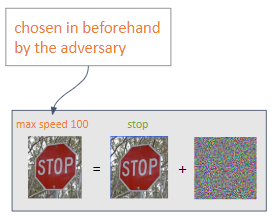

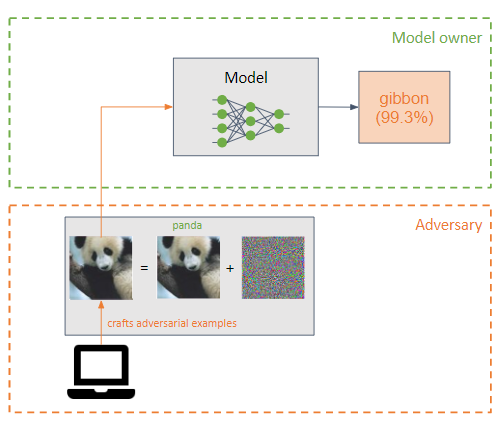

?♂️ Évasion ?♂️

Un adversaire ajoute une petite perturbation (sous forme de bruit) à l'entrée d'un modèle d'apprentissage automatique pour le faire classer incorrectement (exemple d'adversaire).

Elles sont similaires aux attaques d’empoisonnement, mais leur principale différence est que les attaques d’évasion tentent d’exploiter les faiblesses du modèle lors de la phase d’inférence.

Le but de l’adversaire est que les exemples contradictoires soient imperceptibles pour un humain.

Deux types d'attaques peuvent être réalisées en fonction du résultat souhaité par l'adversaire :

Les attaques les plus courantes sont les attaques en boîte blanche :

- L-BFGS

- FGSM

- BIM

- JSMA

- Carlini & Wagner (C&W)

- NewtonImbécile

- EAD

- PAN

?️ Actions défensives ?️

La formation contradictoire, qui consiste à créer des exemples contradictoires pendant la formation pour permettre au modèle d'apprendre les caractéristiques des exemples contradictoires, rendant le modèle plus robuste à ce type d'attaque.

Transformations sur les entrées.

Masquage/régularisation du dégradé. Pas très efficace.

Faibles défenses.

Défenses contre l’injection rapide : toutes les défenses pratiques et proposées contre l’injection rapide.

Référence Lakera PINT : Le test d'injection rapide (PINT) fournit un moyen neutre d'évaluer les performances d'un système de détection d'injection rapide, comme Lakera Guard, sans s'appuyer sur des ensembles de données publiques connues que ces outils peuvent utiliser pour optimiser les performances d'évaluation.

Devil's Inference : une méthode pour évaluer de manière contradictoire le modèle Phi-3 Instruct en observant la répartition de l'attention entre ses têtes lorsqu'elles sont exposées à des entrées spécifiques. Cette approche incite le modèle à adopter la « mentalité du diable », ce qui lui permet de générer des résultats de nature violente.

? Liens utiles ?

- Attaques pratiques de boîte noire contre l'apprentissage automatique

- Les limites du Deep Learning dans des contextes conflictuels

- Vers l'évaluation de la robustesse des réseaux de neurones

- La distillation comme défense contre les perturbations adverses contre les réseaux de neurones profonds

- Exemples contradictoires dans le monde physique

- Entraînement contradictoire d’ensemble : attaques et défenses

- Vers des modèles de Deep Learning résistants aux attaques contradictoires

- Propriétés intrigantes des réseaux de neurones

- Expliquer et exploiter les exemples contradictoires

- Plonger dans les exemples contradictoires transférables et les attaques par boîte noire

- Apprentissage automatique contradictoire à grande échelle

- Attaques contradictoires en boîte noire avec des requêtes et des informations limitées

- Compression des fonctionnalités : détection d'exemples contradictoires dans les réseaux de neurones profonds

- Attaques contradictoires basées sur la décision : attaques fiables contre les modèles d'apprentissage automatique en boîte noire

- Stimuler les attaques adverses avec Momentum

- L’espace des exemples contradictoires transférables

- Contrer les images contradictoires à l'aide de transformations d'entrée

- Defense-GAN : protéger les classificateurs contre les attaques contradictoires à l'aide de modèles génératifs

- Synthétiser des exemples contradictoires robustes

- Atténuer les effets adverses grâce à la randomisation

- Sur la détection des perturbations contradictoires

- Patch contradictoire

- PixelDefend : tirer parti des modèles génératifs pour comprendre et se défendre contre des exemples contradictoires

- Une attaque de pixel pour tromper les réseaux de neurones profonds

- Défenses efficaces contre les attaques adverses

- Attaques robustes du monde physique contre la classification visuelle du Deep Learning

- Perturbations contradictoires contre les réseaux de neurones profonds pour la classification des logiciels malveillants

- Attaques contradictoires 3D au-delà du nuage de points

- Les perturbations contradictoires trompent les détecteurs de Deepfake

- Deepfakes contradictoires : évaluation de la vulnérabilité des détecteurs de Deepfake aux exemples contradictoires

- Un aperçu des vulnérabilités des systèmes à commande vocale

- FastWordBug : une méthode rapide pour générer du texte contradictoire contre les applications PNL

- Le Fantôme de l'ADAS : Sécuriser les systèmes avancés d'aide à la conduite contre les attaques fantômes en une fraction de seconde

- llm-attacks : attaques universelles et transférables contre des modèles de langage alignés.

- Attaques contre les modèles d’IA : injection rapide contre empoisonnement de la chaîne d’approvisionnement

- Attaque par injection rapide contre les applications intégrées à LLM

- garak : scanner de vulnérabilités LLM.

- Transformations contradictoires simples dans PyTorch

- Plugins ChatGPT : exfiltration de données via des images et falsification de demandes de plugins croisés

- Détournements d'images : les images contradictoires peuvent contrôler les modèles génératifs au moment de l'exécution

- Multi-attaques : plusieurs images + la même attaque contradictoire → plusieurs étiquettes cibles

- ACTIF : Vers un camouflage physique 3D hautement transférable pour une évasion universelle et robuste des véhicules

- LLM Red Teaming GPTS : fuite d'invites, fuite d'API, fuite de documents

- Exemples contradictoires pouvant être produits par l'homme

- Défis du jailbreak multilingue dans les grands modèles linguistiques

- Utilisation abusive d'outils dans de grands modèles de langage avec des exemples visuels contradictoires

- AutoDAN : attaques contradictoires interprétables basées sur un gradient sur de grands modèles de langage

- Injection multimodale : (Ab)utilisation d'images et de sons pour l'injection indirecte d'instructions dans les LLM multimodaux.

- JailbreakingLLM : jailbreak de grands modèles de langage Black Box dans vingt requêtes.

- Arbre des attaques : jailbreaker automatiquement les LLM Black-Box

- GPT : fuite des invites de GPT.

- Exploits d’IA : une collection d’exploits d’IA/ML du monde réel pour des vulnérabilités divulguées de manière responsable.

- Les agents LLM peuvent pirater des sites Web de manière autonome

- Cloudflare annonce un pare-feu pour l'IA

- PromptInject : cadre qui assemble les invites de manière modulaire pour fournir une analyse quantitative de la robustesse des LLM face aux attaques d'invites adverses.

- LLM Red Teaming : approches contradictoires, de programmation et linguistiques VS ChatGPT, Claude, Mistral, Grok, LAMA et Gemini

- La hiérarchie des instructions : former les LLM pour donner la priorité aux instructions privilégiées

- Injection rapide / JailBreaking d'un agent LLM bancaire (GPT-4, Langchain)

- Chat copilote GitHub : de l'injection rapide à l'exfiltration de données

- Les exemples contradictoires sont mal alignés dans les variétés du modèle de diffusion

- Jailbreak logique image-texte : votre imagination peut vous aider à tout faire

- Mitigating Skeleton Key, un nouveau type de technique de jailbreak générative de l'IA

- Benchmarking d'obfuscation d'image : ce référentiel contient le code permettant d'évaluer les modèles sur le benchmark d'obfuscation d'image, présenté pour la première fois dans Benchmarking Robustness to Adversarial Image Obfuscations.

- Jailbreaker de grands modèles de langage avec des mathématiques symboliques

Outils

| Nom | Taper | Algorithmes pris en charge | Types d'attaques pris en charge | Attaque/Défense | Frameworks pris en charge | Popularité |

|---|

| Cleverhans | Image | Apprentissage profond | Évasion | Attaque | Tensorflow, Keras, JAX | |

| Boîte à idiots | Image | Apprentissage profond | Évasion | Attaque | Tensorflow, PyTorch, JAX | |

| ART | Tout type (image, données tabulaires, audio,...) | Apprentissage profond, SVM, LR, etc. | Tout (extraction, inférence, empoisonnement, évasion) | Les deux | Tensorflow, Keras, Pytorch, Scikit Learn | |

| Attaque de texte | Texte | Apprentissage profond | Évasion | Attaque | Keras, câlinvisage | |

| Torche publicitaire | Image | Apprentissage profond | Évasion | Les deux | --- | |

| Boîte Adv | Image | Apprentissage profond | Évasion | Les deux | PyTorch, Tensorflow, MxNet | |

| ProfondRobuste | Image, graphique | Apprentissage profond | Évasion | Les deux | PyTorch | |

| Contrefaçon | N'importe lequel | N'importe lequel | Évasion | Attaque | --- | |

| Exemples audio contradictoires | Audio | Discours profond | Évasion | Attaque | --- | |

ART

Adversarial Robustness Toolbox, en abrégé ART, est une bibliothèque open source Adversarial Machine Learning permettant de tester la robustesse des modèles d'apprentissage automatique.

Il est développé en Python et implémente des attaques et des défenses par extraction, inversion, empoisonnement et évasion.

ART prend en charge les frameworks les plus populaires : Tensorflow, Keras, PyTorch, MxNet et ScikitLearn, entre autres.

Cela ne se limite pas à l'utilisation de modèles qui utilisent des images comme entrée, mais prend également en charge d'autres types de données, telles que l'audio, la vidéo, les données tabulaires, etc.

Atelier pour apprendre l'apprentissage automatique contradictoire avec ART ??

Cleverhans

Cleverhans est une bibliothèque permettant d'effectuer des attaques d'évasion et de tester la robustesse d'un modèle d'apprentissage profond sur des modèles d'images.

Il est développé en Python et s'intègre aux frameworks Tensorflow, Torch et JAX.

Il implémente de nombreuses attaques telles que L-BFGS, FGSM, JSMA, C&W, entre autres.

? Utiliser ?

L’IA est utilisée pour accomplir des tâches malveillantes et booster les attaques classiques.

♂️ Pentest ♂️

- GyoiThon : outil de test d'intrusion de nouvelle génération, outil de collecte de renseignements pour serveur Web.

- Deep Exploit : outil de test d'intrusion entièrement automatique utilisant le Deep Reinforcement Learning.

- AutoPentest-DRL : tests d'intrusion automatisés utilisant l'apprentissage par renforcement profond.

- DeepGenerator : générez entièrement automatiquement des codes d'injection pour l'évaluation des applications Web à l'aide d'un algorithme génétique et de réseaux contradictoires génératifs.

- Eyeballer : Eyeballer est destiné aux tests de pénétration de réseau à grande échelle dans lesquels vous devez trouver des cibles "intéressantes" à partir d'un vaste ensemble d'hôtes Web.

- Nebula : assistant de piratage éthique alimenté par l'IA.

- Les équipes d'agents LLM peuvent exploiter les vulnérabilités Zero-Day

- Informations et lacunes actuelles dans les scanners de vulnérabilités LLM open source : une analyse comparative

? Un logiciel malveillant ?

- DeepLocker : Dissimulation des attaques ciblées grâce à la serrurerie IA, par IBM Labs sur BH.

- Un aperçu de l'intelligence artificielle utilisée dans les logiciels malveillants : une liste organisée de ressources sur les logiciels malveillants IA.

- DeepObfusCode : obscurcissement du code source via des réseaux séquence à séquence.

- AutoCAT : apprentissage par renforcement pour l'exploration automatisée des attaques par synchronisation du cache.

- BOTNET BASÉ SUR L'IA : Une approche théorique des jeux pour la défense contre les attaques de botnets basée sur l'IA.

- SECML_Malware : bibliothèque Python pour créer des attaques contradictoires contre les détecteurs de logiciels malveillants Windows.

- Version transcendante : utilisation de l'évaluation conforme pour détecter la dérive des concepts affectant la détection des logiciels malveillants.

?️OSINT ?️

- SNAP_R : générez automatiquement des publications de spear phishing sur les réseaux sociaux.

- SpyScrap : SpyScrap combine des méthodes de reconnaissance faciale pour filtrer les résultats et utilise le traitement du langage naturel pour obtenir des entités importantes du site Web sur lequel l'utilisateur apparaît.

? Phishing ?

- DeepDGA : implémentation de DeepDGA : génération et détection de domaines à réglage contradictoire.

? Renseignement sur les menaces ?

- Des sables aux demeures : permettre la construction automatique de cyberattaques sur tout le cycle de vie avec LLM

? Chaînes secondaires ?

- SCAAML : attaques par canal secondaire assistées par l'apprentissage automatique.

?? IA générative ??

? Audio ?

Outils

- deep-voice-conversion : réseaux de neurones profonds pour la conversion vocale (transfert de style vocal) dans Tensorflow.

- tacotron : une implémentation TensorFlow de la synthèse vocale Tacotron de Google avec un modèle pré-entraîné (non officiel).

- Clonage vocal en temps réel : clonez une voix en 5 secondes pour générer une parole arbitraire en temps réel.

- mimic2 : moteur Text to Speech basé sur l'architecture Tacotron, initialement implémenté par Keith Ito.

- Clonage vocal neuronal avec quelques échantillons : mise en œuvre du clonage vocal neuronal avec quelques échantillons Document de recherche par Baidu.

- Vall-E : Une implémentation PyTorch non officielle du LM audio VALL-E.

- changeur de voix : changeur de voix en temps réel.

- Retrieval-based-Voice-Conversion-WebUI : un cadre de conversion vocale facile à utiliser basé sur VITS.

- Audiocraft : Audiocraft est une bibliothèque de traitement et de génération audio avec apprentissage en profondeur. Il comprend le compresseur/tokenizer audio EnCodec de pointe, ainsi que MusicGen, un LM de génération de musique simple et contrôlable avec conditionnement textuel et mélodique.

- VALL-EX : une implémentation open source du modèle TTS zéro tir VALL-E X de Microsoft.

- OpenVoice : clonage vocal instantané par MyShell.

- MeloTTS : bibliothèque de synthèse vocale multilingue de haute qualité par MyShell.ai. Prise en charge de l'anglais, de l'espagnol, du français, du chinois, du japonais et du coréen.

- VoiceCraft : édition vocale Zero-Shot et synthèse vocale dans la nature.

- Parler-TTS : bibliothèque d'inférence et de formation pour des modèles TTS de haute qualité.

- ChatTTS : un modèle de parole génératif pour le dialogue quotidien.

Applications

- Lip2Wav : générez un discours de haute qualité à partir uniquement des mouvements des lèvres.

- AudioLDM : génération de texte en audio avec des modèles de diffusion latente

- deepvoice3_pytorch : implémentation PyTorch de modèles de synthèse de synthèse texte-parole basés sur des réseaux de neurones convolutifs.

- ? Riffusion : Diffusion stable pour la génération de musique en temps réel.

- murmur.cpp : Port du modèle Whisper d'OpenAI en C/C++.

- TTS : ? - une boîte à outils d'apprentissage profond pour la synthèse vocale, testée en recherche et en production.

- YourTTS : vers une TTS multi-haut-parleurs Zero-Shot et une conversion vocale Zero-Shot pour tout le monde.

- TorToiSe : un système TTS multi-voix formé en mettant l'accent sur la qualité.

- DiffSinger : synthèse de voix chantée via un mécanisme de diffusion peu profonde (SVS et TTS).

- Vocoder WaveNet : implémentation du vocodeur WaveNet, qui peut générer des échantillons de parole brute de haute qualité conditionnés par des caractéristiques linguistiques ou acoustiques.

- Deepvoice3_pytorch : implémentation PyTorch de modèles de synthèse de synthèse texte-parole basés sur des réseaux de neurones convolutifs.

- Synthèse vocale eSpeak NG : eSpeak NG est un synthétiseur vocal open source qui prend en charge plus d'une centaine de langues et d'accents.

- RealChar : créez, personnalisez et parlez à votre personnage/compagnon IA en temps réel (base de code tout-en-un !). Ayez une conversation naturelle et transparente avec l'IA partout (mobile, Web et terminal) en utilisant LLM OpenAI GPT3.5/4, Anthropic Claude2, Chroma Vector DB, Whisper Speech2Text, ElevenLabs Text2Speech.

- Clonage de voix neuronale avec quelques échantillons

- NAUTILUS : un système de clonage vocal polyvalent

- Apprendre à parler couramment une langue étrangère : synthèse vocale multilingue et clonage vocal multilingue

- Quand le bien devient le mal : inférence de frappe avec Smartwatch

- KeyListener : déduire les frappes sur le clavier QWERTY de l'écran tactile via des signaux acoustiques

- Cette voix n'existe pas : sur la synthèse vocale, les deepfakes audio et leur détection

- AudioSep : séparez tout ce que vous décrivez.

- stable-audio-tools : modèles génératifs pour la génération audio conditionnelle.

- GPT-SoVITS-WebUI : 1 minute de données vocales peut également être utilisée pour entraîner un bon modèle TTS ! (quelques clonages de voix).

- Hybrid-Net : séparation des sources audio en temps réel, génération de paroles, d'accords et de rythmes.

- CosyVoice : modèle de génération de voix multilingue à grande échelle, offrant une capacité d'inférence, de formation et de déploiement full-stack.

- EasyVolcap : accélération de la recherche vidéo volumétrique neuronale.

? Détection ?

- détection de fausse voix : utilisation de la convolution temporelle pour détecter les Deepfakes audio.

- Un système robuste de détection d'usurpation de voix utilisant de nouvelles fonctionnalités CLS-LBP et LSTM

- Détecteur d'usurpation de voix : un cadre anti-usurpation unifié

- Sécuriser les interfaces vocales contre les fausses attaques audio (clonées)

- DeepSonar : vers une détection efficace et robuste des fausses voix synthétisées par l'IA

- Combattre l’IA avec l’IA : détection de fausses paroles grâce au Deep Learning

- Un examen des méthodes modernes de détection des deepfakes audio : défis et orientations futures

? Image ?

Outils

- StyleGAN : StyleGAN - Implémentation officielle de TensorFlow.

- StyleGAN2 : StyleGAN2 – Implémentation officielle de TensorFlow.

- stylegan2-ada-pytorch : StyleGAN2-ADA - Implémentation officielle de PyTorch.

- StyleGAN-nada : Adaptation de domaine guidée par CLIP des générateurs d'images.

- StyleGAN3 : implémentation officielle PyTorch de StyleGAN3.

- Imaginaire : Imaginaire est une bibliothèque pytorch qui contient l'implémentation optimisée de plusieurs méthodes de synthèse d'images et de vidéos développées chez NVIDIA.

- ffhq-dataset : ensemble de données Flickr-Faces-HQ (FFHQ).

- DALLE2-pytorch : implémentation de DALL-E 2, le réseau neuronal de synthèse texte-image mis à jour d'OpenAI, dans Pytorch.

- ImaginAIry : l'IA a imaginé des images. Génération pythonique d'images de diffusion stables.

- Lama Cleaner : outil de peinture d'images optimisé par SOTA AI Model. Supprimez tout objet, défaut ou personne indésirable de vos photos ou effacez et remplacez (propulsé par une diffusion stable) tout ce qui se trouve sur vos photos.

- Inversible-Image-Rescaling : Il s'agit de l'implémentation PyTorch du papier : Inversible Image Rescaling.

- DifFace : restauration de visage aveugle avec contraction d'erreur diffuse (PyTorch).

- CodeFormer : vers une restauration robuste des faces aveugles avec Codebook Lookup Transformer.

- Diffusion personnalisée : personnalisation multi-concept de la diffusion texte-image.

- Diffuseurs : ? Diffuseurs : modèles de diffusion de pointe pour la génération d'images et d'audio dans PyTorch.

- Diffusion stable : synthèse d'images haute résolution avec modèles de diffusion latente.

- InvokeAI : InvokeAI est un moteur créatif de premier plan pour les modèles de diffusion stable, permettant aux professionnels, aux artistes et aux passionnés de générer et de créer des médias visuels à l'aide des dernières technologies basées sur l'IA. La solution offre une interface Web de pointe, prend en charge l'utilisation du terminal via une CLI et sert de base à plusieurs produits commerciaux.

- Interface utilisateur Web de diffusion stable : interface utilisateur Web de diffusion stable.

- Stable Diffusion Infinity : Outpainting avec Stable Diffusion sur une toile infinie.

- Diffusion rapide et stable : diffusion rapide et stable + DreamBooth.

- GET3D : un modèle génératif de formes texturées 3D de haute qualité tirées d'images.

- Superbe synthèse d'images artistiques IA : une liste d'outils, d'idées, d'outils d'ingénierie d'invite, de collaborations, de modèles et d'aides géniaux pour le concepteur d'invites jouant avec aiArt et la synthèse d'images. Couvre Dalle2, MidJourney, StableDiffusion et les outils open source.

- Diffusion stable : un modèle de diffusion latent de texte à image.

- Diffusion météorologique : code pour « Restaurer la vision dans des conditions météorologiques défavorables avec des modèles de diffusion de débruitage basés sur des patchs ».

- DF-GAN : une base de référence simple et efficace pour la synthèse texte-image.

- Dall-E Playground : un terrain de jeu pour générer des images à partir de n'importe quelle invite de texte à l'aide de Stable Diffusion (anciennement : à l'aide de DALL-E Mini).

- MM-CelebA-HQ-Dataset : un ensemble de données d'images de visage à grande échelle qui permet la génération de texte en image, la manipulation d'images guidée par texte, la génération d'esquisse en image, les GAN pour la génération et l'édition de visages, la légende d'image et le VQA.

- Deep Daze : outil de ligne de commande simple pour la génération de texte en image à l'aide du CLIP et de Siren (réseau de représentation neuronale implicite) d'OpenAI.

- StyleMapGAN : exploitation des dimensions spatiales latentes dans le GAN pour l'édition d'images en temps réel.

- Kandinsky-2 : Modèle de diffusion latente texte2image multilingue.

- DragGAN : Manipulation interactive basée sur des points sur le collecteur d'images génératives.

- Segment Anything : le référentiel fournit du code pour exécuter l'inférence avec le modèle SegmentAnything (SAM), des liens pour télécharger les points de contrôle du modèle entraîné et des exemples de blocs-notes qui montrent comment utiliser le modèle.

- Segment Anything 2 : le référentiel fournit du code pour exécuter l'inférence avec le Meta Segment Anything Model 2 (SAM 2), des liens pour télécharger les points de contrôle du modèle entraîné et des exemples de blocs-notes qui montrent comment utiliser le modèle.

- MobileSAM : Il s'agit du code officiel du projet MobileSAM qui rend SAM léger pour les applications mobiles et au-delà !

- FastSAM : segmenter rapidement n'importe quoi

- Infinigen : mondes photoréalistes infinis utilisant la génération procédurale.

- DALL·E 3

- StreamDiffusion : une solution au niveau du pipeline pour la génération interactive en temps réel.

- AnyDoor : personnalisation d'image au niveau de l'objet sans prise de vue.

- DiT : Modèles de diffusion évolutifs avec transformateurs.

- BrushNet : un modèle d'inpainting d'image Plug-and-Play avec diffusion décomposée à double branche.

- OOTDiffusion : équipement de diffusion latente basée sur la fusion pour un essai virtuel contrôlable.

- VAR : Imp. officielle. de "Modélisation visuelle autorégressive : génération d'images évolutives via une prédiction à l'échelle suivante".

- Imagine Flash : accélération des modèles de diffusion d'émeu avec distillation vers l'arrière

Applications

- ArtLine : un projet basé sur le Deep Learning pour créer des portraits au trait.

- Depix : récupère les mots de passe à partir de captures d'écran pixelisées.

- Redonner vie à d'anciennes photos : restauration d'anciennes photos (implémentation officielle de PyTorch).

- Réécriture : Outil interactif pour éditer directement les règles d'un GAN pour synthétiser des scènes avec des objets ajoutés, supprimés ou modifiés. Changez StyleGANv2 pour créer des sourcils extravagants ou des chevaux portant des chapeaux.

- Fumseck : outil de préservation de la vie privée contre les systèmes de reconnaissance faciale.

- Pulse : suréchantillonnage de photos auto-supervisé via l'exploration de l'espace latent de modèles génératifs.

- HiDT : référentiel officiel de l'article "Traduction diurne haute résolution sans étiquettes de domaine".

- Inpainting de photos 3D : photographie 3D utilisant l'inpainting en profondeur en couches contextuel.

- SteganoGAN : SteganoGAN est un outil permettant de créer des images stéganographiques à l'aide d'un entraînement contradictoire.

- Stylegan-T : libérer la puissance des GAN pour une synthèse texte-image rapide à grande échelle.

- MegaPortraits : avatars de tête neurale mégapixels uniques.

- eg3d : réseaux contradictoires génératifs 3D efficaces tenant compte de la géométrie.

- TediGAN : implémentation de Pytorch pour TediGAN : génération et manipulation d'images de visages divers guidées par texte.

- DALLE-pytorch : Implémentation/réplication de DALL-E, Text to Image Transformer d'OpenAI, dans Pytorch.

- StyleNeRF : Il s'agit de l'implémentation open source de l'article ICLR2022 « StyleNeRF : A Style-based 3D-Aware Generator for High-resolution Image Synthesis ».

- DeepSVG : code officiel de l'article "DeepSVG : un réseau génératif hiérarchique pour l'animation graphique vectorielle". Inclut une bibliothèque PyTorch pour l'apprentissage en profondeur avec des données SVG.

- NUWA : un pipeline de transformation 3D unifié pour la synthèse visuelle.

- Image-Super-Resolution-via-Iterative-Refinement : implémentation non officielle de Image Super-Resolution via Iterative Refinement par Pytorch.

- Lama : ? LaMa Image Inpainting, Inpainting de grands masques à résolution robuste avec convolutions de Fourier.

- Person_reID_baseline_pytorch : Pytorch ReID : un implémentation pytorch minuscule, conviviale et puissante de référence de réidentification d'objet.

- instruct-pix2pix : implémentation PyTorch d'InstructPix2Pix, un modèle d'édition d'images basé sur des instructions.

- GFPGAN : GFPGAN vise à développer des algorithmes pratiques pour la restauration du visage dans le monde réel.

- DeepVecFont : synthèse de polices vectorielles de haute qualité via un apprentissage à double modalité.

- Stargan v2 Tensorflow : implémentation officielle de Tensorflow.

- Distillation StyleGAN2 : la traduction paire image à image, formée sur les données synthétiques générées par StyleGAN2, surpasse les approches existantes en matière de manipulation d'images.

- Extraction de données de formation à partir de modèles de diffusion

- Mann-E - Mann-E (persan : مانی) est un modèle de générateur d'art basé sur les poids de Stable Diffusion 1.5 et les données recueillies à partir du matériel artistique disponible sur Pinterest.

- Réseaux d'encodage-décodeur CNN formés de bout en bout pour la stéganographie d'images

- Grounded-Segment-Anything : marier Grounding DINO avec Segment Anything & Stable Diffusion & Tag2Text & BLIP & Whisper & ChatBot - Détecter, segmenter et générer automatiquement n'importe quoi avec des entrées d'image, de texte et d'audio.

- AnimateDiff : animez vos modèles de diffusion texte-image personnalisés sans réglage spécifique.

- BasicSR : boîte à outils de restauration d'images et de vidéos Open Source pour la super-résolution, le débruitage, la suppression du flou, etc. Actuellement, elle comprend EDSR, RCAN, SRResNet, SRGAN, ESRGAN, EDVR, BasicVSR, SwinIR, ECBSR, etc. Prend également en charge StyleGAN2 et DFDNet. [](https://github.com/XPixelGroup/BasicSR)

- Real-ESRGAN : Real-ESRGAN vise à développer des algorithmes pratiques pour la restauration générale d'images/vidéos.

- ESRGAN : SRGAN amélioré. Champion PIRM Challenge sur la super-résolution perceptuelle.

- Mixnmatch: démontage multifactor et codage pour la génération d'images conditionnels.

- Clarity-upScaler: augmentation de l'image repensée pour tout le monde.

- Diffusion en une étape avec distillation correspondant à la distribution

- Couper invisible: générer des scènes 3D lisses avec une profondeur de découpage.

- SSR: Reconstruction de scène 3D à vue unique avec forme et texture haute fidélité.

- INVSR: Super-résolution de l'image arbitraire via l'inversion de diffusion.

? Détection?

- STYLEGAN3-détecteur: détection d'image synthétique Stylegan3.

- Stylegan2-projection-images: projeter des images dans un espace latent avec stylegan2.

- Faldetector: détection des visages Photoshopped en scriptant Photoshop.

? Vidéo ?

Outils

- DeepfaceLab: Deepfacelab est le principal logiciel pour créer DeepFakes.

- FACESWAP: logiciel DeepFakes pour tous.

- DOT: La boîte à outils offensive DeepFake.

- SimSwap: un cadre arbitraire d'échange de visage sur les images et les vidéos avec un seul modèle formé!

- FACESWAP-GAN: Autoencoder de débroussage + pertes adversaires et mécanismes d'attention pour l'échange de visage.

- Celeb Deepfakeforrensics: un ensemble de données difficile à grande échelle pour DeepFake Forensics.

- VGEN: un écosystème de génération de vidéos holistique pour la génération de vidéos construisant sur des modèles de diffusion.

- Musev: génération de vidéo humaine virtuelle de longueur infinie et haute fidélité avec débraillé parallèle conditionné visuel.

- Glee: Modèle de fondation d'objet général pour les images et les vidéos à grande échelle.

- T-REX: Vers la détection d'objets génériques via une synergie invite visuelle de texte.

- Dynamicrafter: Animation d'images à domaine ouvert avec des priors de diffusion vidéo.

- Mora: Plus comme Sora pour la génération vidéo généraliste.

Applications

- FACE2FACE-Demo: Demo PIX2PIX qui apprend des repères faciaux et le traduit en un visage.

- FACES-SAWAP-FEEFFAKE-PYTORCH: FACES-SAVE AVEC PYTORCH OU DEATFAKE AVEC PYTORCH.

- Point-E: diffusion de nuages de points pour la synthèse du modèle 3D.

- EGVSR: super-résolution vidéo efficace et générique.

- STIT: Consat It In Time: Gan édition facial de vraies vidéos.

- BackgroundMattingv2: Matting de fond haute résolution en temps réel.

- MODNET: Une solution de tapis de portrait sans TRIMAP en temps réel.

- Matting de fond: Matting d'arrière-plan: le monde est votre écran vert.

- Modèle de premier ordre: ce référentiel contient le code source du modèle de mouvement de premier ordre pour l'animation d'image.

- Animation articulée: Ce référentiel contient le code source des représentations de mouvement de papier CVPR'2021 pour l'animation articulée.

- Suppression en temps réel: retirer les gens d'horizons complexes en temps réel à l'aide de tensorflow.js dans le navigateur Web.

- Style adain: transfert de style arbitraire en temps réel avec une normalisation des instances adaptative.

- Interpolation du cadre: interpolation du cadre pour un grand mouvement.

- Awesome-Image-Colorisation: une collection de papiers de colorisation d'image et de colorisation vidéo basés sur l'apprentissage en profondeur.

- SADTALKER: Apprendre des coefficients de mouvement 3D réalistes pour l'animation de visage parlante unique axée sur l'audio.

- Roop: Deepfake en un clic (échange de visage).

- StableVideo: Édition vidéo de diffusion sensible à la cohérence axée sur le texte.

- Magicedit: Édition vidéo à haute fidélité temporellement cohérente.

- RERENDER_A_VIDEO: traduction vidéo à vidéo guidée par texte zéro.

- DreamEditor: Édition de scène 3D axée sur le texte avec des champs neuronaux.

- DreamEditor: synthèse de vue 4D en temps réel à la résolution 4K.

- AnimateAnyone: synthèse d'image à video cohérente et contrôlable pour l'animation des personnages.

- Moore-animateanyone: Ce référentiel reproduit Animateanyone.

- Audio2Photoreal: de l'audio à l'incarnation photoréale: synthétiser les humains dans les conversations.

- MagicVideo-V2: Génération vidéo à haute esthétique en plusieurs étapes

- LWM: un modèle autorégressif multimodal à usage général à usage général. Il est formé sur un grand ensemble de données de diverses vidéos et livres longues à l'aide de RingTattention et peut effectuer la compréhension et la génération et la génération du langage, de l'image et de la vidéo.

- ANIPORTRAIT: Synthèse axée sur l'audio de l'animation de portrait photoréaliste.

- Champ: animation d'image humaine contrôlable et cohérente avec guidage paramétrique 3D.

- Streamv2v: Streaming Traduction vidéo-vidéo avec les banques de fonctionnalités.

- Deep-Live-Cam: Swap en temps réel et en un clic sur une vidéo en un clic avec une seule image.

- SAPiens: Fondation pour les modèles de vision humaine.

? Détection?

- FACEFORENSICS ++: ensemble de données FACEFORENSICS.

- Détection profonde: vers une détection defake profonde qui fonctionne réellement.

- FakevideoForensics: détecter des vidéos de simulation profonde.

- Détection DeepFake: l'implémentation pytorch de la détection DeepFake basée sur Faceforrensics ++.

- Seqdeepfake: code pytorch pour seqdeepfake: détection et récupération de manipulation séquentielle defake profonde.

- PCL-I2G: Mise en œuvre non officielle: apprentissage de l'auto-cohérence pour la détection des Fake profonds.

- DFDC Deepfake Challenge: une solution primée pour le défi DFDC.

- POI-FORENSIQUE: Détection de la personne d'intérêt audio-visuelle Deepfake.

- Détection standardisante de DeepFakes: pourquoi les experts disent que c'est important

- Vous voulez repérer un Foke Deep? Cherchez les étoiles dans leurs yeux

? Texte ?

Outils

- GLM-130B: un modèle pré-entraîné bilingue ouvert.

- LongterChatexternalSources: GPT-3 Chatbot avec mémoire à long terme et sources externes.

- Sketch: Asid-écriture de code AI qui comprend le contenu des données.

- Langchain: ⚡ Construire des applications avec LLMS via la composabilité ⚡.

- CHATGPT Wrapper: API pour interagir avec Chatgpt à l'aide de Python et de Shell.

- Openai-Python: La bibliothèque Openai Python offre un accès pratique à l'API OpenAI à partir des applications écrites dans la langue Python.

- Beto: version espagnole du modèle Bert.

- GPT-Code-Clippy: GPT-Code-Clippy (GPT-CC) est une version open source de GitHub Copilot, un modèle de langue - basé sur GPT-3, appelé GPT-Codex.

- GPT NEO: une implémentation des modèles de style GPT-2 parallèles parallèles et GPT-3 à l'aide de la bibliothèque Mesh-TensorFlow.

- CTRL: Modèle de langue du transformateur conditionnel pour la génération contrôlable.

- LLAMA: Code d'inférence pour les modèles LLAMA.

- Lama2

- Llama Guard 3

- UL2 20B: un apprenant de la langue unifiée open source

- Burgpt: une extension Burp Suite qui intègre le GPT d'OpenAI pour effectuer une analyse passive supplémentaire pour découvrir des vulnérabilités très sur mesure et permet une analyse basée sur le trafic de tout type.

- OLLAMA: Remontez en marche avec Llama 2 et d'autres modèles de grande langue localement.

- SneakyProrompt: Modèles génératifs de text à l'image jailbreaking.

- Copilot-for-Security: une solution de sécurité générative alimentée par AI qui contribue à augmenter l'efficacité et les capacités des défenseurs pour améliorer les résultats de sécurité à la vitesse et à l'échelle de la machine, tout en restant conforme aux principes d'IA responsables.

- LM Studio: Découvrez, téléchargez et exécutez les LLM locaux

- Contourner GPT: convertir le texte AI en contenu de type humain

- MGM: Le framework soutient une série de modèles dense et MOE de grande langue (LLMS) de 2B à 34b avec la compréhension, le raisonnement et la génération d'image simultanément.

- Secret Llama: chatbot LLM entièrement privé qui s'exécute entièrement avec un navigateur sans serveur nécessaire. Soutient Mistral et Llama 3.

- LLAMA3: Le site officiel de Github Meta Llama 3.

? Détection?

- Détection de faux texte: salle de test du modèle de langue géante.

- Grover: Code pour la défense contre les fausses nouvelles neuronales.

- Rebuff.ai: détecteur d'injection rapide.

- Nouveau classificateur AI pour indiquer un texte écrit sur l'IA

- Découvrez les 4 méthodes magiques pour détecter le texte généré par l'AI (y compris le chatgpt)

- Gptzero

- Détecteur de contenu AI (bêta)

- Un filigrane pour les modèles de grandes langues

- Le texte généré par l'IA peut-il être détecté de manière fiable?

- Les détecteurs GPT sont biaisés contre les écrivains anglais non natifs

- Pour chatter, ou ne pas pour chatter: c'est la question!

- Les linguistes peuvent-ils faire la distinction entre Chatgpt / AI et l'écriture humaine ?: Une étude de l'éthique de la recherche et de l'édition académique

- Chatgpt est des conneries

Applications

- Écriture manuscrite: l'écriture manuscrite génère une police personnalisée en fonction de votre échantillon d'écriture manuscrite.

- GPT Sandbox: L'objectif de ce projet est de permettre aux utilisateurs de créer des démos Web sympas en utilisant l'API OpenAI GPT-3 récemment publié avec seulement quelques lignes de Python.

- Passgan: Une approche d'apprentissage en profondeur pour deviner le mot de passe.

- Index GPT: l'indice GPT est un projet composé d'un ensemble de structures de données conçues pour faciliter l'utilisation de grandes bases de connaissances externes avec LLMS.

- Nanogpt: le référentiel le plus simple et le plus rapide pour la formation / les GPT de taille moyenne de la formation.

- whatsapp-gpt

- Extension Chatgpt Chrome: une extension Chatgpt Chrome. Intègre Chatgpt dans chaque zone de texte sur Internet.

- UNILM: Pré-formation auto-supervisée à grande échelle entre les tâches, les langues et les modalités.

- Mingpt: Une réimplémentation pytorch minimale de la formation Openai GPT (transformateur génératif pré-entraîné).

- Codegeex: un modèle de génération de code multilingue ouvert.

- Openai Cookbook: Exemples et guides pour l'utilisation de l'API OpenAI.

- ? Invites impressionnantes de chatppt: ce repo inclut la conservation de l'invite ChatGpt pour mieux utiliser Chatgpt.

- Alice: donnant un accès à Chatgpt à un vrai terminal.

- Revue du code de sécurité avec chatppt

- Les utilisateurs écrivent-ils plus de code insécurité avec des assistants d'IA?

- Contourner les filtres à spam de Gmail avec chatppt

- Cracker de mot de passe Gans récurrent pour amélioration de la sécurité du mot de passe IoT

- Pentestgpt: un outil de test de pénétration à l'autorisation de GPT.

- Chercheur de GPT: agent autonome basé sur GPT qui fait des recherches complètes en ligne sur un sujet donné.

- Ingénieur GPT: spécifiez ce que vous voulez qu'il construise, l'IA demande des clarifications, puis la construit.

- LocalPilot: Utilisez GitHub Copilot localement sur votre MacBook avec un clic!

- [Wormgpt]) (https://thehackernews.com/2023/07/wormgpt-new-ai-tool-allows.html): un nouvel outil d'IA permet aux cybercriminaux de lancer des cyberattaques sophistiquées

- Poisongpt: Comment nous avons caché un LLM lobotomisé en étreignant le visage pour diffuser de fausses nouvelles

- Passgpt: modélisation de mot de passe et génération (guidée) avec de grands modèles de langue

- Deeppass - Trouver des mots de passe avec l'apprentissage en profondeur

- GPTFUZZ: RED fait équipe de grands modèles de langue avec des invites de jailbreak générées automatiquement.

- Interprète ouvert: l'interprète de code d'Openai dans votre terminal, en cours d'exécution localement.

- Eureka: conception de récompense au niveau de l'homme via le codage de modèles de gros langues.

- Metaclip: démystifier les données de clip.

- LLM OSINT: méthode de preuve de concept d'utilisation de LLMS pour collecter des informations sur Internet, puis effectuer une tâche avec ces informations.

- HackingBuddyGpt: LLMS X Pentesting.

- Chatgpt-Jailbreaks: Jailbreak officiel pour Chatgpt (GPT-3.5). Envoyez un long message au début de la conversation avec Chatgpt pour obtenir des réponses offensives, contraires à l'éthique, agressives et humaines en anglais et en italien.

- MAGIKA: détecter les types de contenu de fichiers avec l'apprentissage en profondeur.

- Jan: Une alternative open source à Chatgpt qui fonctionne à 100% hors ligne sur votre ordinateur.

- Liberchat: Clone Chatgpt amélioré: Fonctionne Openai, Assistants API, Azure, Groq, GPT-4 Vision, Mistral, Bing, Anthropic, OpenRouter, Vertex AI, Gemini, Ai Model Switching Plugins, fonctions OpenAI, système multi-utilisateurs sécurisé, préréglages, entièrement open-source pour l'auto-hébergement.

- Lumina-T2X: un cadre unifié pour le texte à toute génération de modalité.

Divers

- Awesome GPT + Security: une liste organisée d'outils de sécurité impressionnants, de cas expérimental ou d'autres choses intéressantes avec LLM ou GPT.

- Apprentissage du renforcement impressionnant pour la cybersécurité: une liste organisée de ressources dédiées à l'apprentissage du renforcement s'appliquait à la cybersécurité.

- Apprentissage automatique impressionnant pour la cybersécurité: une liste organisée d'outils et de ressources incroyablement impressionnants liés à l'utilisation de l'apprentissage automatique pour la cybersécurité.

- Cours des modèles de diffusion de face étreintes: Matériaux pour le cours de modèle de diffusion de visage étreint.

- Awesome-Aai-Security: une liste organisée des ressources de sécurité de l'IA.

- ML pour les pirates: code accompagnant le livre "Machine Learning for Hackers".

- L'intermédiaire horrible: L'IA horrible est une liste organisée pour suivre les usages effrayants actuels de l'IA - dans l'espoir de sensibiliser.

- NIST AI Risk Management Framework Playbook

- SOK: Apprentissage automatique explicable pour les applications de sécurité informatique

- Qui évalue les évaluateurs? Sur les mesures automatiques pour évaluer les générateurs de code offensifs basés sur l'IA

- Praits de vulnérabilité: une approche de sécurité offensive

- Mitre Atlas ™ (paysage des menaces adversaires pour les systèmes d'intelligence artificielle)

- Une enquête sur la sécurité d'apprentissage du renforcement avec une application à la conduite autonome

- Comment éviter les pièges à apprentissage automatique: un guide pour les chercheurs universitaires

- Une liste organisée des événements de sécurité et de confidentialité de l'IA

- NIST AI 100-2 E2023: apprentissage automatique contradictoire. Une taxonomie et une terminologie des attaques et des atténuations.

- ?? ROODEDCON 2023 - Inteligencia artificiel Ofensiva - ¿Cómo podemos estar preparedos?

- Sécurité des systèmes AI: Fondamentaux - Apprentissage en profondeur adversaire

- Au-delà des garanties: explorer les risques de sécurité de Chatgpt

- La carte de surface d'attaque AI v1.0

- Sur la sécurité impossible des grands modèles d'IA

- Règlement sur la frontière AI: gérer les risques émergents pour la sécurité publique

- Cadre multicouche pour de bonnes pratiques de cybersécurité pour l'IA

- Présentation du cadre d'IA sécurisé de Google

- OWASP Top 10 pour LLM

- Awesome LLM Security: une conservation d'outils, documents et projets impressionnants sur la sécurité LLM.

- Un cadre pour utiliser en toute sécurité les LLM dans les entreprises. Partie 1: Aperçu des risques. Partie 2: Gérer le risque. Partie 3: sécurisation de CHATGPT et COPILOT GHITHUB.

- Une étude sur la robustesse et la fiabilité de la génération de code de modèle de grande langue

- Identification des images générées par l'AI avec synthétique

- Audit de grands modèles de langue: une approche à trois couches

- Résolution de la bataille du risque d'IA à court terme et à long terme

- Fraudegpt: le méchant avatar de Chatgpt

- Risques d'IA - Schneier sur la sécurité

- Utilisation des LLM à des fins illicites: menaces, mesures de prévention et vulnérabilités

- L'équipement rouge de l'IA n'est pas une solution à guichet unique aux dommages AI: recommandations d'utilisation de l'équipe rouge pour la responsabilité de l'IA

- Une taxonomie de fiabilité pour l'intelligence artificielle

- Gérer les risques d'IA à une époque de progrès rapide

- Google - Agissant sur notre engagement à une IA sûre et sécurisée

- Offensive ML Playbook

- Démystifier une IA générative? Les notes d'un chercheur en sécurité

- Genai-Security-Adventures: une initiative open source pour partager des notes, des présentations et une collection diversifiée d'expériences présentées dans des cahiers Jupyter, tous visant à vous aider à saisir les concepts essentiels derrière de grands modèles de langue et à explorer l'intersection intrigante de la sécurité et du naturel traitement du langage.

- L'IA Safety Camp vous relie à une recherche de recherche à collaborer sur un projet - pour voir où votre travail pourrait aider à garantir que l'IA future est sûre.

- Lignes directrices pour le développement du système d'IA sécurisé

- Approche de l'intelligence artificielle et de la cybersécurité. Rapport des meilleures pratiques

- Stanford Safe, Secure et Trustwersin AI EO 14110 Tracker

- Awesome ML Security: une liste organisée de références de sécurité d'apprentissage automatique impressionnantes, de conseils, d'outils, etc.

- Chemin prévisible de l'IA: 7 choses à attendre de l'IA en 2024+

- Intelligence artificielle et cybersécurité (en espagnol ??)

- Vigille: détecter les injections rapides, le jailbreaks et autres entrées de modèle de langue grande potentiellement risquée (LLM).

- Modèles d'IA génératifs - Opportunités et risques pour l'industrie et les autorités

- Déploiement des systèmes d'IA en toute sécurité. Meilleures pratiques pour le déploiement de systèmes d'IA sécurisés et résilients

- NIST AI 600-1: Cadre de gestion des risques d'intelligence artificielle: Profil d'intelligence artificielle générative

- ?? ANSSI: RECOMMANDATIONS DE SÉCURÉ.

- Pyrit: L'outil d'identification du risque Python pour l'IA génératif (Pyrit) est un cadre d'automatisation à accès ouvert pour autonomiser les professionnels de la sécurité et les ingénieurs d'apprentissage automatique pour trouver de manière proactive les risques dans leurs systèmes d'IA génératifs.

- OWASP-Agentic-AI: Travailler pour créer le Top 10 OWASP pour l'agentique AI (AI Agent Security).

- Vers une IA de sécurité garantie: un cadre pour assurer des systèmes d'IA robustes et fiables

- Définir de vrais risques d'IA

- Approche sécurisée de l'IA générative

- Modèles de grande langue en cybersécurité

- Hé, c'est mon modèle! Présentation de Chain & Hash, une technique d'empreinte digitale LLM

- Utilisation générative de l'IA: une taxonomie des tactiques et des idées à partir de données réelles

- Référentiel à risque d'IA

- Revisiter l'IA rouge

- Recommandations allemandes-français pour l'utilisation des assistants de programmation d'IA

- Affaire à l'évolution du filigrane pour identifier

Enquêtes

- La menace d'une IA offensive pour les organisations

- Intelligence artificielle dans le cyber domaine: infraction et défense

- Une enquête sur les attaques et défenses contradictoires

- Apprentissage en profondeur contradictoire: une enquête sur les attaques contradictoires et les mécanismes de défense sur la classification de l'image

- Une enquête sur les attaques de confidentialité dans l'apprentissage automatique

- Vers les menaces de sécurité des systèmes d'apprentissage en profondeur: une enquête

- Une enquête sur les menaces de sécurité et les techniques défensives de l'apprentissage automatique: une vue basée sur les données

- SOK: Sécurité et confidentialité dans l'apprentissage automatique

- Apprentissage automatique contradictoire: l'augmentation du crime compatible AI et son rôle dans l'évasion du filtre à spam

- Menaces, vulnérabilités et contrôles des systèmes basés sur l'apprentissage automatique: une enquête et une taxonomie

- Attaques et défenses contradictoires: une enquête

- Questions de sécurité: une enquête sur l'apprentissage automatique contradictoire

- Une enquête sur les attaques contradictoires pour l'analyse des logiciels malveillants

- Apprentissage automatique contradictoire dans la classification des images: une enquête vers la perspective du défenseur

- Une enquête sur une formation contradictoire robuste en reconnaissance des modèles: fondamental, théorie et méthodologies

- Confidentialité dans les modèles de grande langue: attaques, défenses et orientations futures

? Les mainteneurs?

Miguel Hernández |

José Ignacio Escribano |

© ️ Licence © ️

- Creative Commons Attribution-partage de la même manière 4.0 International