C'est le code du papier

Évaluation des réseaux de neurones profonds pour les systèmes de détection des panneaux de signalisation

Álvaro Arcos-García, Juan Antonio Álvarez-García, Luis M. Soria-Morillo

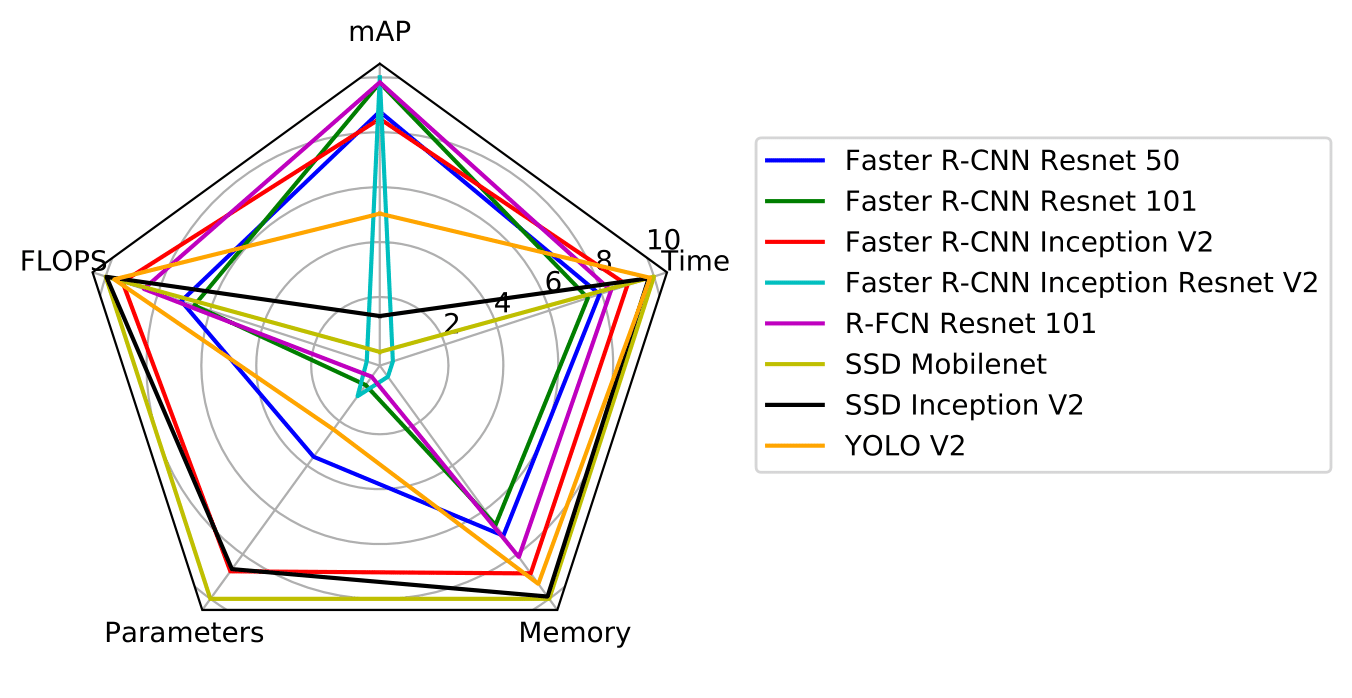

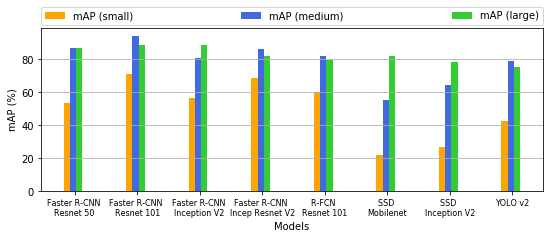

L'article aborde le problème de la détection des panneaux de signalisation en analysant l'état de l'art de plusieurs systèmes de détection d'objets (Faster R-CNN, R-FCN, SSD et YOLO V2) combinés à divers extracteurs de fonctionnalités (Resnet V1 50, Resnet V1 101, Inception V2, Inception Resnet V2, Mobilenet V1 et Darknet-19). Notre objectif est d'explorer les propriétés de ces modèles de détection d'objets qui sont modifiés et spécifiquement adaptés au domaine problématique de la détection des panneaux de signalisation au moyen de l'apprentissage par transfert. En particulier, divers modèles de détection d'objets accessibles au public qui ont été pré-entraînés sur l'ensemble de données Microsoft COCO sont affinés sur l'ensemble de données allemand de référence de détection des panneaux de signalisation. L'évaluation et la comparaison de ces modèles incluent des mesures clés, telles que la précision moyenne moyenne (mAP), l'allocation de mémoire, la durée d'exécution, le nombre d'opérations en virgule flottante, le nombre de paramètres du modèle et l'effet de la taille des images des panneaux de signalisation.

Nous fournissons :

Si vous trouvez ce code utile dans votre recherche, veuillez citer :

"Evaluation of deep neural networks for traffic sign detection systems."

Álvaro Arcos-García, Juan A. Álvarez-García, Luis M. Soria-Morillo. Neurocomputing 316 (2018) 332-344.

[lien][bibtex]

Ce projet est implémenté dans Tensorflow et repose sur deux référentiels : l'API de détection d'objets Tensorflow et darkflow.

Vous pouvez télécharger les TFRecords de l'ensemble de données GTSDB à partir de Google Drive. Décompressez-le dans le dossier gtsdb_data . Vous pouvez télécharger des modèles pré-entraînés depuis Google Drive. Décompressez-les dans le dossier models .

Nos résultats montrent que Faster R-CNN Inception Resnet V2 obtient le meilleur mAP, tandis que R-FCN Resnet 101 offre le meilleur compromis entre précision et temps d'exécution. YOLO V2 et SSD Mobilenet méritent une mention spéciale, dans la mesure où le premier obtient des résultats de précision compétitifs et est le deuxième détecteur le plus rapide, tandis que le second est le modèle le plus rapide et le plus léger en termes de consommation de mémoire, ce qui en fait un choix optimal pour un déploiement dans appareils mobiles et embarqués.

| modèle | carte | paramètres | flops | mémoire_mb | total_exec_millis | accélérateur_exec_millis | cpu_exec_millis |

|---|---|---|---|---|---|---|---|

| R-CNN Resnet 50 plus rapide | 91.52 | 43337242 | 533575386662 | 5256.454615 | 104.0363553 | 75.93395395 | 28.10240132 |

| R-CNN Resnet 101 plus rapide | 95.08 | 62381593 | 625779295782 | 6134.705805 | 123.2729175 | 90.33714433 | 32.9357732 |

| Création R-CNN plus rapide V2 | 90.62 | 12891249 | 120621363525 | 2175.206857 | 58.53338971 | 38.76813971 | 19.76525 |

| Création R-CNN plus rapide Resnet V2 | 95,77 | 59412281 | 1837544257834 | 18250.446008 | 442.2206796 | 366.1586796 | 76062 |

| R-FCN Resnet 101 | 95.15 | 64594585 | 269898731281 | 3509.75153 | 85.45207971 | 52.40321739 | 33.04886232 |

| SSD Mobilenet | 61,64 | 5572809 | 2300721483 | 94.696119 | 15.14525 | 4.021267857 | 11.12398214 |

| Création SSD V2 | 66.10 | 13474849 | 7594247747 | 284.512918 | 23.74428378 | 9.393405405 | 14.35087838 |

| YOLO V2 | 78,83 | 50588958 | 62780021160 | 1318.108256 | 21.4810122 | 18.13923171 | 3.341780488 |

| modèle | petit | moyen | grand |

|---|---|---|---|

| R-CNN Resnet 50 plus rapide | 53.57 | 86,95 | 86,72 |

| R-CNN Resnet 101 plus rapide | 70,89 | 94.17 | 88,87 |

| Création R-CNN plus rapide V2 | 56,72 | 81.02 | 88.53 |

| Création R-CNN plus rapide Resnet V2 | 68,60 | 86,62 | 82.10 |

| R-FCN Resnet 101 | 60.37 | 82.03 | 79.56 |

| SSD Mobilenet | 22.13 | 55.32 | 82.06 |

| Création SSD V2 | 26.85 | 64,71 | 78,76 |

| YOLO V2 | 42,93 | 78,99 | 75,67 |

Nous fournissons un bloc-notes Jupyter avec des instructions pour exécuter nos modèles pré-entraînés sur de nouvelles images.

Les fichiers de configuration nécessaires à l'entraînement de nos modèles sont inclus dans chaque fichier zip que vous pouvez télécharger à partir de la section des modèles pré-entraînés. Des modifications minimes ont été apportées au code source de base de tensorflow et darkflow, vous devriez donc pouvoir reproduire nos résultats en utilisant les dernières versions des référentiels susmentionnés. Par exemple, pour entraîner un modèle SDD Mobilenet, vous pouvez exécuter les lignes de commande suivantes :

cd ~ /tensorflow/models/research

python3 object_detection/train.py --logtostderr --pipeline_config_path models/ssd_mobilenet_v1/ssd_mobilenet_v1_gtsdb3.config --train_dir models/ssd_mobilenet_v1/train/Nous fournissons un Jupyter Notebook avec des instructions pour évaluer les résultats obtenus par nos modèles pré-entraînés.

Le code source de ce projet est principalement basé sur l'API de détection d'objets Tensorflow et darkflow.