Veuillez mettre en vedette CoDA et le partager. Merci

[Papier] [Page du projet]

Yang Cao, Yihan Zeng, Hang Xu, Dan Xu

L'Université des sciences et technologies de Hong Kong

Le laboratoire de l'arche de Noé de Huawei

Mises à jour

☑ En tant que premier travail à introduire l'éclaboussure gaussienne 3D dans la détection d'objets 3D, 3DGS-DET est publié ici !

☑ Notre travail étendu CoDAv2 est sorti, découvrez-le sur arXiv !

☑ Les derniers articles et codes sur la perception du vocabulaire ouvert sont rassemblés ici.

☑ Tous les codes, données et modèles pré-entraînés ont été publiés !

☑ Les codes de formation et de test ont été publiés.

☑ Les modèles pré-entraînés ont été publiés.

☑ Les ensembles de données SUN-RGBD de réglage OV ont été publiés.

☑ Les ensembles de données ScanNet de réglage OV ont été publiés.

☑ Les codes papier LaTeX sont disponibles sur https://scienhub.com/Yang/CoDA.

Notre code est basé sur PyTorch 1.8.1, torchvision==0.9.1, CUDA 10.1 et Python 3.7. Cela peut fonctionner avec d'autres versions.

Veuillez également installer les dépendances Python suivantes :

matplotlib

opencv-python

plyfile

'trimesh>=2.35.39,<2.35.40'

'networkx>=2.2,<2.3'

scipy

Veuillez installer les couches pointnet2 en exécutant

cd third_party/pointnet2 && python setup.py install

Veuillez installer une implémentation cythonisée de gIOU pour une formation plus rapide.

conda install cython

cd utils && python cython_compile.py build_ext --inplace

Pour obtenir le paramètre OV, nous réorganisons le ScanNet et le SUN RGB-D d'origine et adoptons des annotations de plus de catégories. Veuillez télécharger directement les ensembles de données de réglage ov que nous fournissons ici : OV SUN RGB-D et OV ScanNet. Vous pouvez également les télécharger facilement en exécutant :

bash data_download.sh

Exécutez ensuite la recherche du fichier *.tar téléchargé :

bash data_preparation.sh

Téléchargez les modèles pré-entraînés ici. Puis exécutez :

bash test_release_models.sh

bash scripts/coda_sunrgbd_stage1.sh

bash scripts/coda_sunrgbd_stage2.sh

bash run_samples.sh

Si CoDA est utile, veuillez citer :

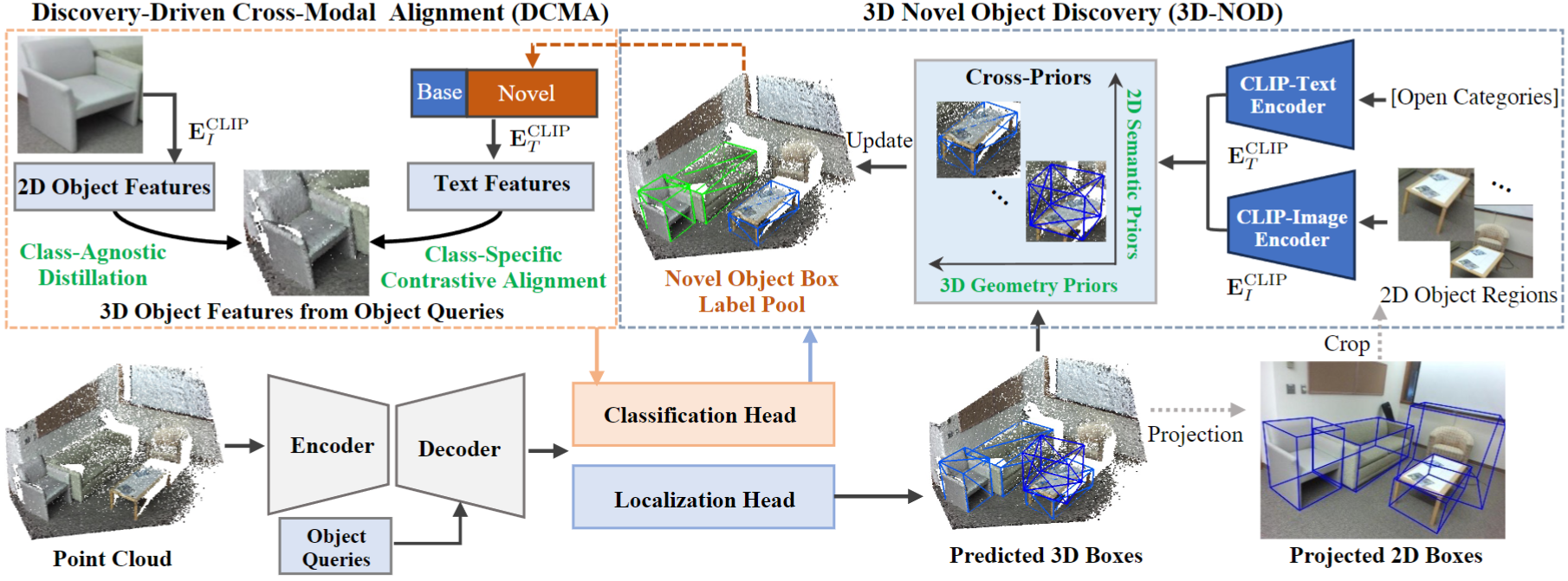

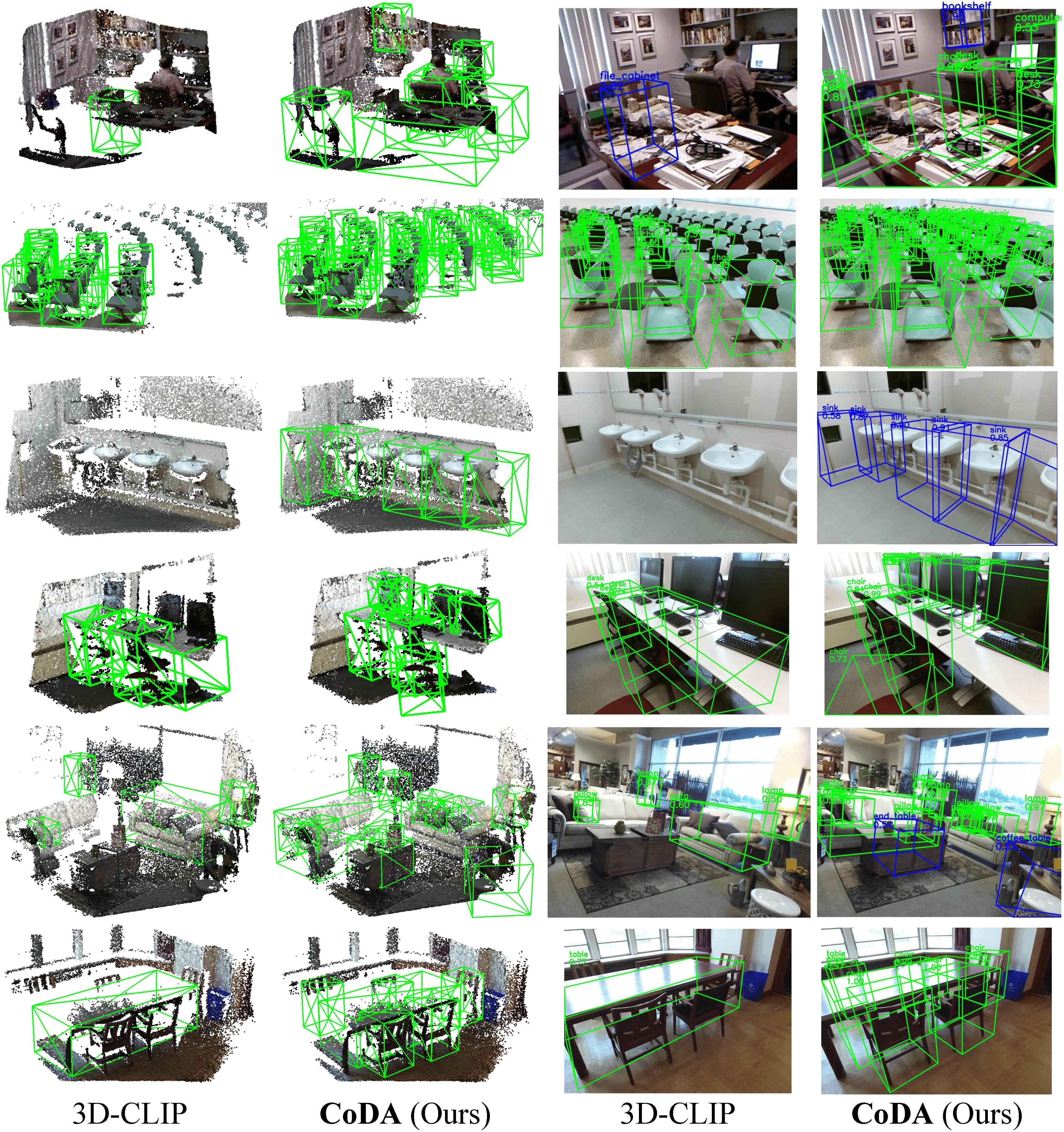

@inproceedings{cao2023coda,

title={CoDA: Collaborative Novel Box Discovery and Cross-modal Alignment for Open-vocabulary 3D Object Detection},

author={Cao, Yang and Zeng, Yihan and Xu, Hang and Xu, Dan},

booktitle={NeurIPS},

year={2023}

}

@misc{cao2024collaborative,

title={Collaborative Novel Object Discovery and Box-Guided Cross-Modal Alignment for Open-Vocabulary 3D Object Detection},

author={Yang Cao and Yihan Zeng and Hang Xu and Dan Xu},

year={2024},

eprint={2406.00830},

archivePrefix={arXiv},

primaryClass={cs.CV},

url={https://arxiv.org/abs/2406.00830},

}

Si vous avez des questions ou un besoin de collaboration (objectif de recherche ou objectif commercial), veuillez envoyer un e-mail [email protected] .

CoDA s'inspire de CLIP et 3DETR. On apprécie leurs bons codes.