Important

2024.10.10: chirurgie, restauration d'urgence du serveur de fichiers fournissant un package WHL

2024.10.8: version 3..90 Ajouter une prise en charge préliminaire de Llama-Idex, la version 3.80 ajoute une fonction de menu secondaire plug-in (voir Wiki pour plus de détails)

2024.5.1: Ajouter la fonction du papier PDF de traduction DOC2X, afficher les détails

2024.3.11: Soutenez pleinement des modèles chinois de grande langue tels que Qwen, GLM, Deepseekcoder! Module de clonage vocal Sovits, affichez les détails 2024.1.17: Lors de l'installation des dépendances, sélectionnez la version spécifiée dans requirements.txt . Commande d'installation: pip install -r requirements.txt . Ce projet est entièrement open source et gratuit.

Si vous aimez ce projet, veuillez lui donner une étoile;

Si vous aimez ce projet, donnez-lui une étoile multi_language.py

Note

1. La fonction de chaque fichier de ce projet est le rapport auto-traduction self_analysis.md . Avec l'itération de la version, vous pouvez également cliquer sur la fiche de fonction pertinente à tout moment pour appeler le rapport d'auto-parenté GPT RE-Génération. Pour des questions courantes, veuillez consulter Wiki.

2. Ce projet est compatible avec et encourage l'essai des grands modèles de base de langue chinoise domestiques tels que Tongyi Qianqian, Wisdom Spectrum GLM, etc. Prise en charge de la coexistence multiple de la touche API, vous pouvez remplir le fichier de configuration, tel que API_KEY="openai-key1,openai-key2,azure-key3,api2d-key4" . Lorsque vous devez remplacer temporairement API_KEY , entrez l' API_KEY temporaire dans la zone d'entrée, puis soumettez-le à la clé de conduite pour prendre effet.

| Fonction (= nouvelles fonctionnalités récentes) | décrire |

|---|---|

| Nouveau modèle | Baidu Qianfan et Wenxin ont dit, Tongyi Qian Qi Qwen, Shanghai Ai-Lab Scholar, Xun Feixing Fire, Llama2, Wisdom Speed GLM4, Dalle3, Deepseekcoder |

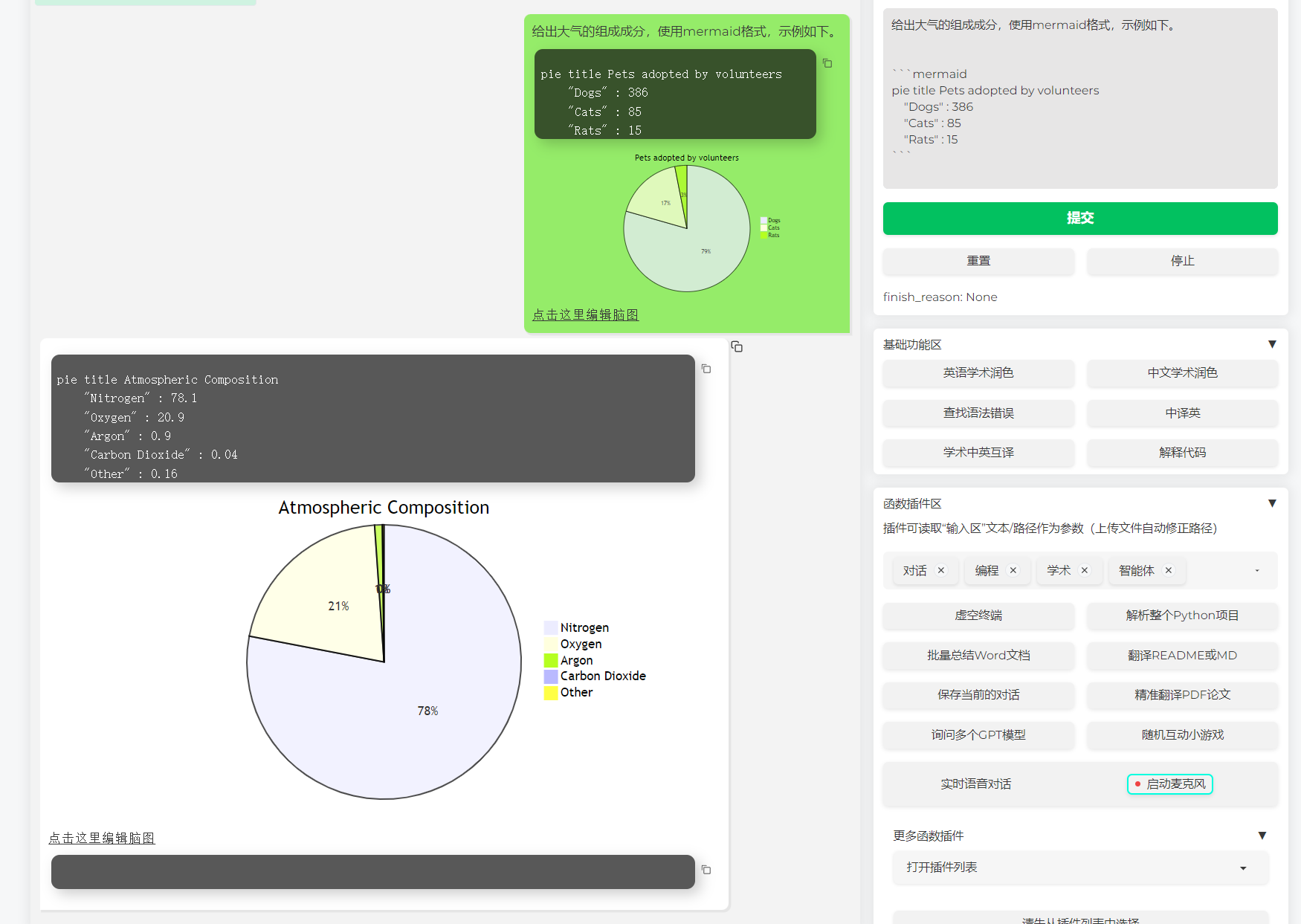

| Soutenir le rendu de l'image sirène | Prise en charge pour permettre à GPT de générer des organigrammes, des diagrammes de transfert d'état, des cartes Gand, des gâteaux, du gitgraph, etc. (version 3.7) |

| Thèse d'Arxiv Traduction (Docker) | [Plug -in] Traduction d'un clic de la thèse ArXIV avec un clic, le meilleur outil de traduction papier actuellement |

| Entrée de la boîte de dialogue vrais du temps | [Plug -in] Audio d'écoute asynchrone, déconnexion automatique de la phrase, trouvez automatiquement le temps de réponse |

| Plugin Multi-Smart Autogen | [Plug -in] Avec l'aide de Microsoft Autogen, explorez la possibilité de l'émergence intelligente de Duo Agent! |

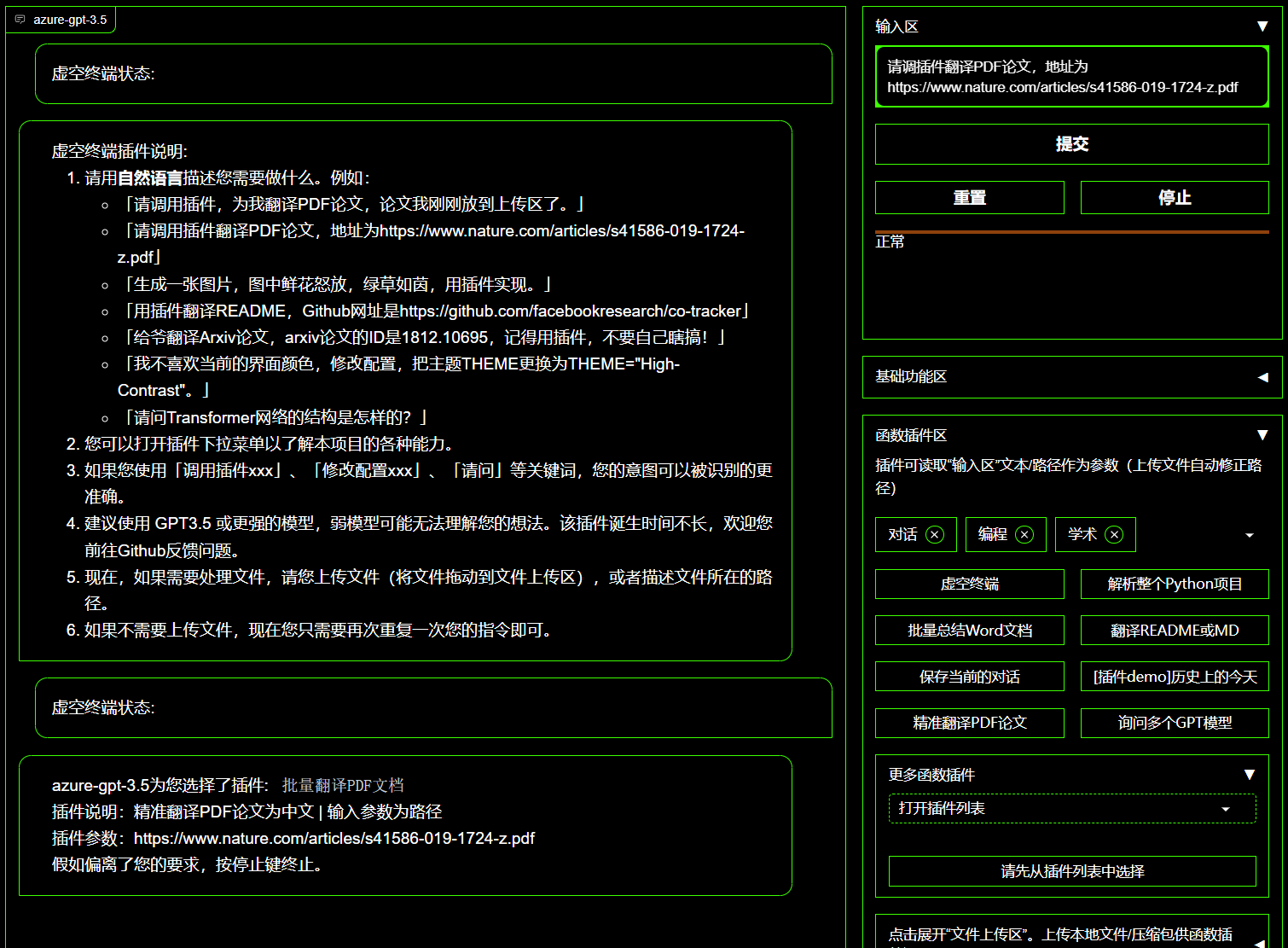

| Plugin terminal void | [Plug -in] peut planifier directement d'autres plug -in dans ce projet en langage naturel |

| Interprétation de la couleur, de la traduction, de l'explication du code | Hydratant un clic, traduction, recherche d'erreurs de grammaire d'articles, code d'interprétation |

| Clé de raccourci personnalisée | Prise en charge des touches de raccourci personnalisées |

| Conception modulaire | Prise en charge des mises à jour HOT MISES À JOUR PLIG-IN PLUS STROG |

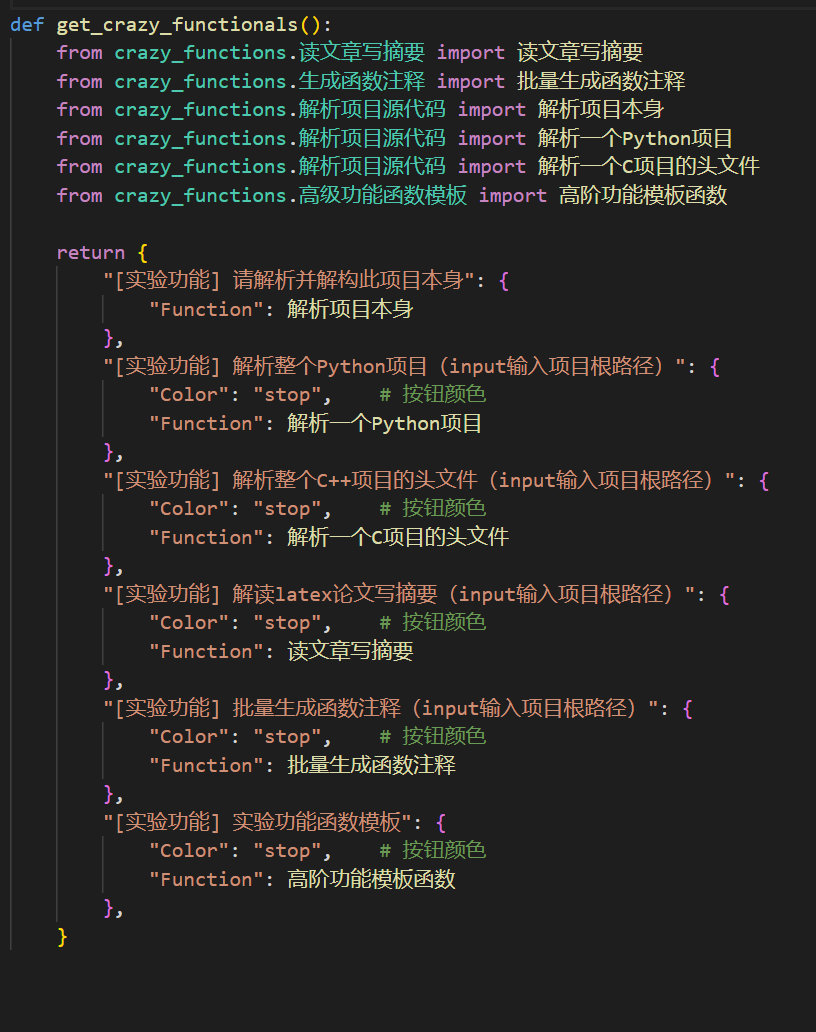

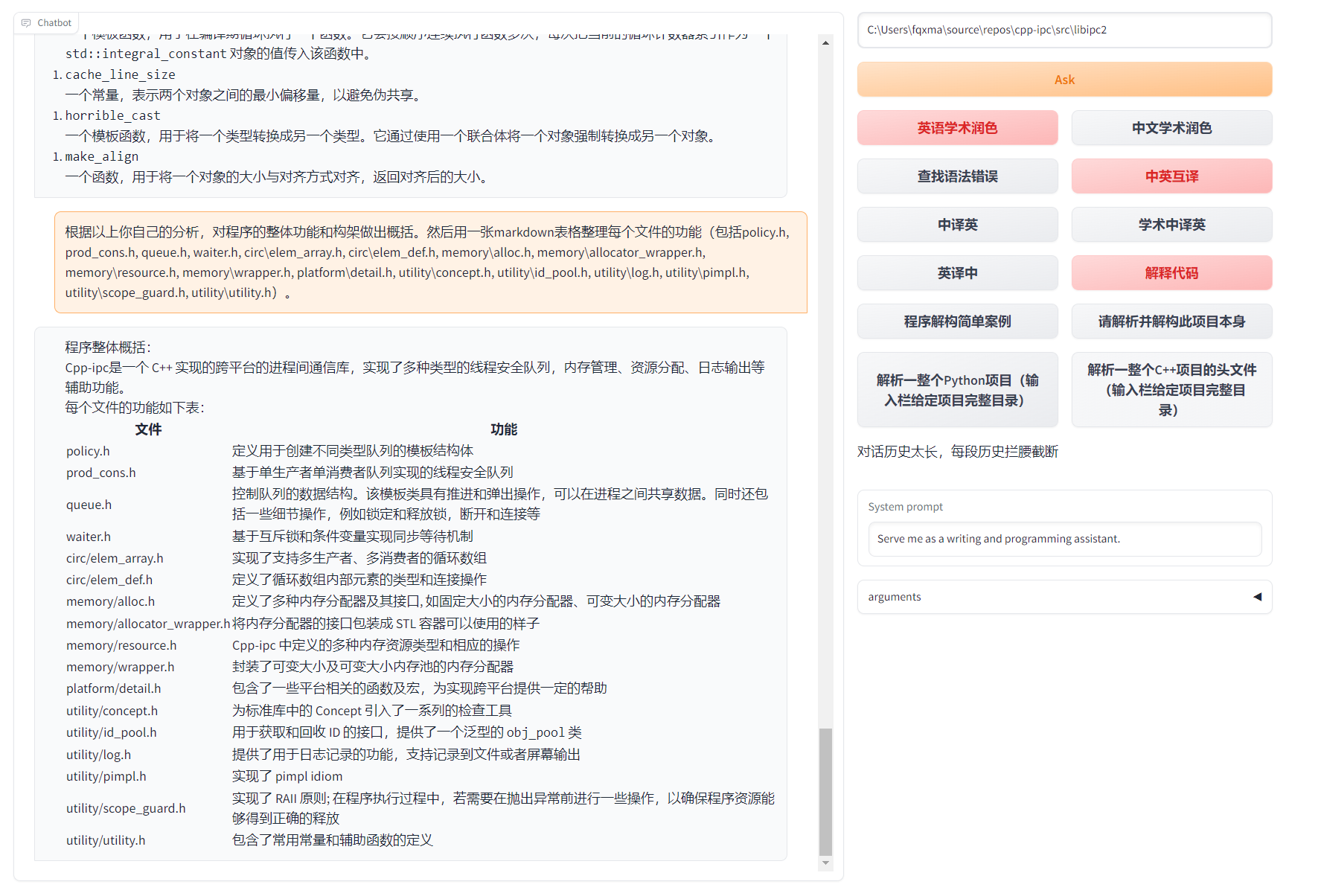

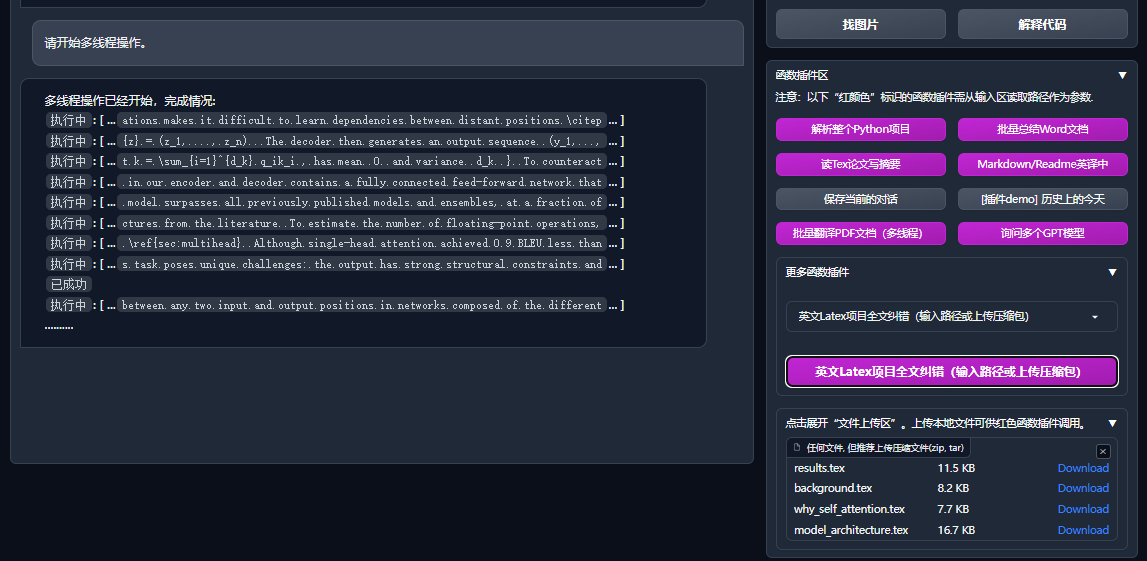

| Analyse du programme | [Plug -in] Analyse des clics de Python / C / C ++ / Java / Lua / ... Arbre de projet ou auto-analyse |

| Lire l'article, traduire la thèse | [Plug -in] Interprétation d'un clic du texte en latex / PDF Texte complet et générant des résumés |

| Traduction en texte complet en latex, hydratant | [Plug -in] Traduction d'un clic ou papier en latex hydratant |

| Annotation par lots | [Plug -in] un lot de clic générer une annotation de la fonction |

| Markdown Traductions mutuelles chinoises et britanniques | [Plug -in] Voyez-vous la langue Read 5? C'est de son écriture |

| Fonction de traduction en texte intégral de papier PDF | [Plug -in] Questions d'extrait de papier PDF et résumé + Traduction Texte intégral (multi-thread) |

| Assistant Arxiv | [Plug -in] Entrez l'URL de l'article Arxiv à One -Click Traduction Résumé + Télécharger PDF |

| Papinons en latex une paire d'école click | [Plug -in] imitation de grammaire à la syntaxe, correction de sorts + contrôle de sortie PDF sur les articles en latex |

| Assistant d'intégration académique Google | [Plug -in] Compte tenu de l'URL de la page de recherche académique de Ren Italie, laissez GPT vous aider à écrire des travaux liés |

| Aggrégation d'informations sur Internet + GPT | [Plug -in] un clic pour permettre à GPT d'obtenir des informations sur Internet et de répondre aux questions, afin que les informations ne soient jamais obsolètes |

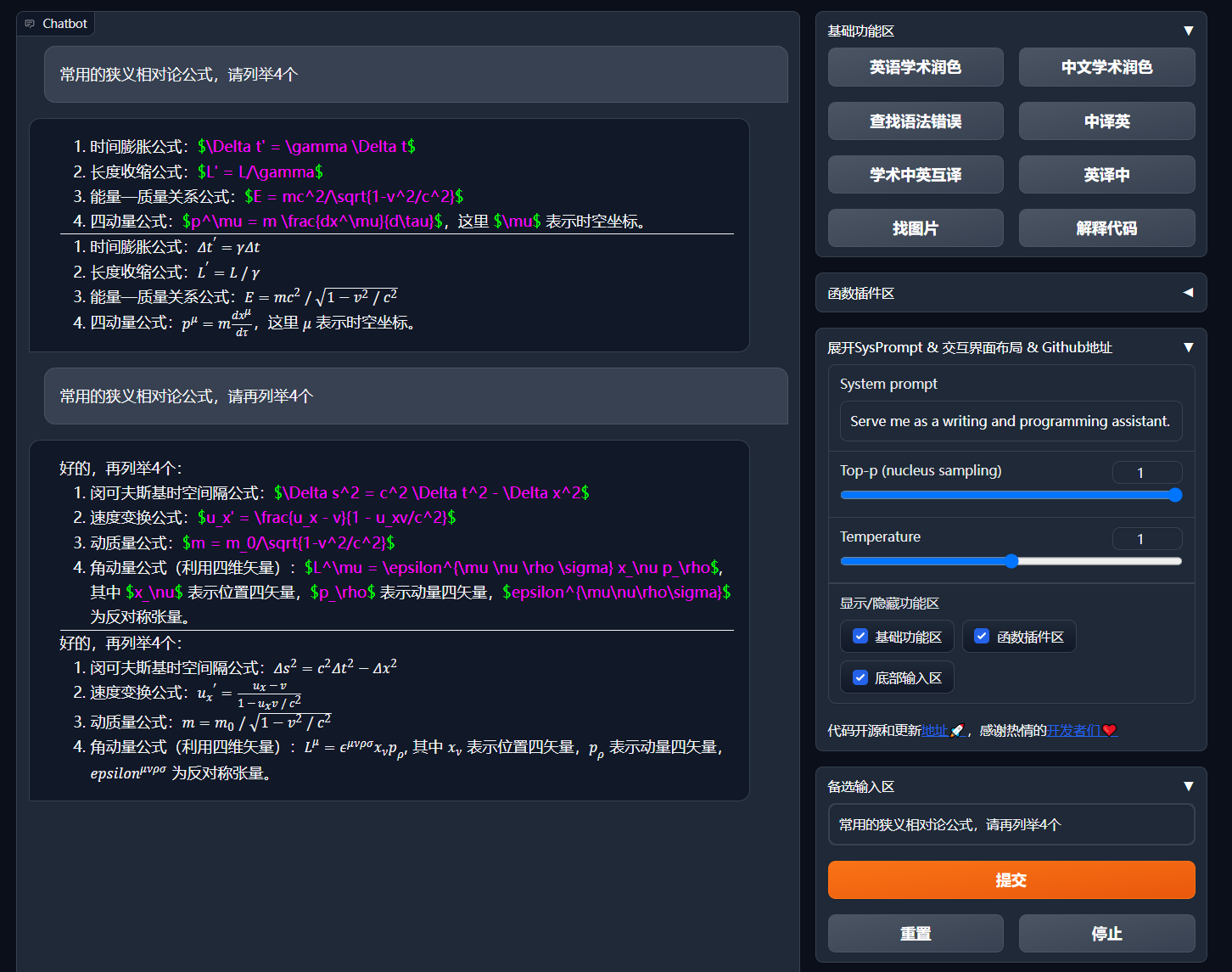

| Formule / image / formulaire Affichage | Vous pouvez afficher la formule et la forme de rendu de la formule en même temps, et prendre en charge la formule et la surmonté du code |

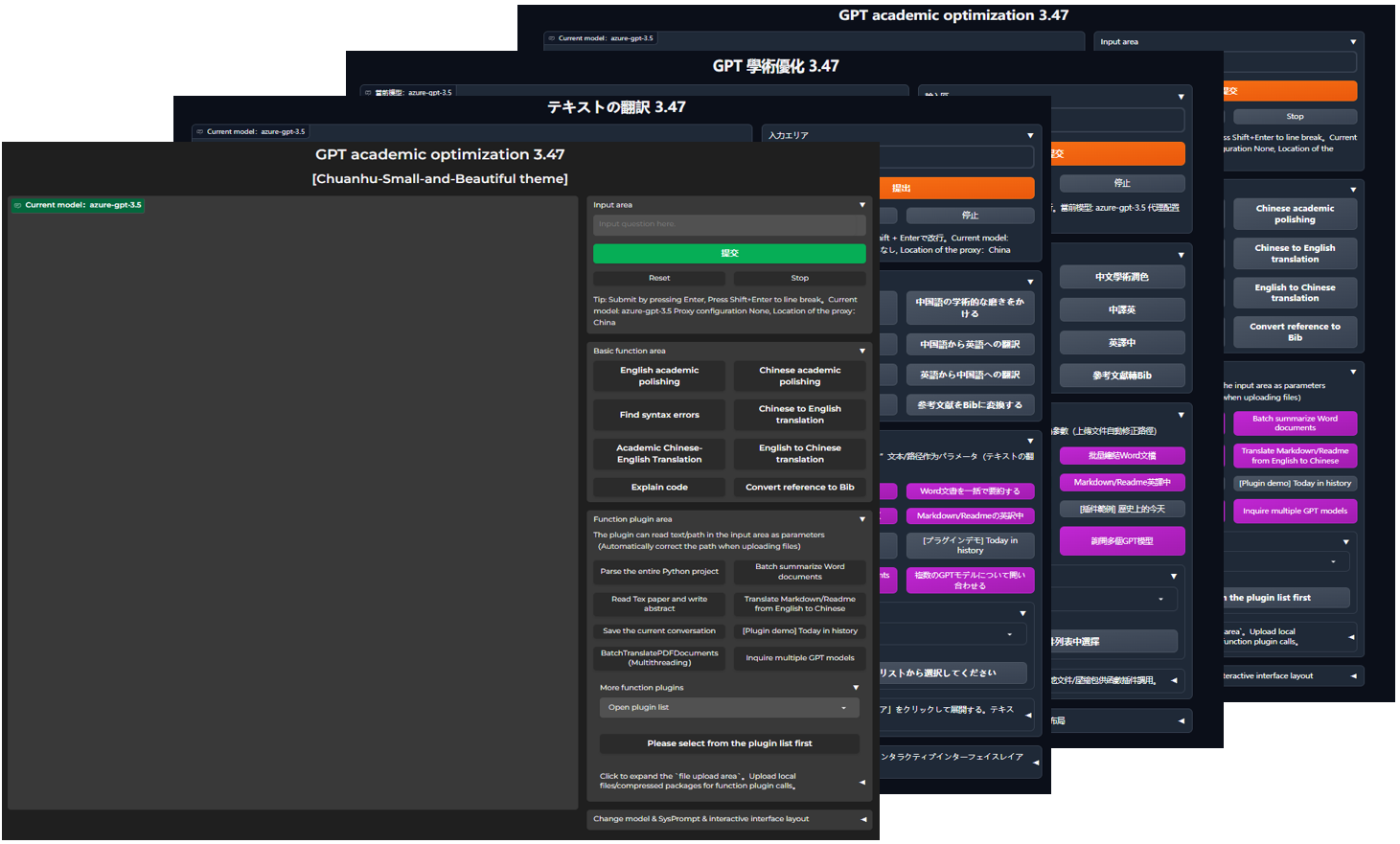

| Démarrer le thème sombre | Add /?__theme=dark après l'URL du navigateur peut changer |

| Prise en charge du modèle Multi LLM | Dans le même temps, le sentiment d'être servi par GPT3.5, GPT4, Tsinghua chatglm2, Fudan Moss doit être très bon? |

| Plus d'accès au modèle LLM, support de déploiement de HuggingFace | Rejoignez l'interface Newbing (New Must), introduisez Tsinghua Jittorllms pour soutenir Llama et Pangu α |

| Ensemble PIP VOID-Terminal | Laissant de l'interface graphique, appelez directement toute la fiche de fonction de l'élément de Python (en cours de développement) |

| Plus d'affichage des fonctionnalités (génération d'images, etc.) ... | Voir la fin de cet article ... |

config.py pour atteindre la commutation "Left-Right Layout" et "Switching supérieur et inférieur")

Organigramme TD

A {"Méthode d'installation"} -> W1 ("i.? Exécuter directement (Windows, Linux ou macOS)"))

W1-> W11 ["1. Python Pip Package Management Dependence"]

W1-> W12 ["2. Anaconda Package Management Dependances (Recommandation)"]]

A -> w2 ["ii.? Utilisez docker (Windows, Linux ou macOS)"]]

W2-> k1 ["1. Grande image miroir déploiement de toutes les capacités (recommandation)"]]

W2-> K2 ["2. Seul modèle en ligne (GPT, GLM4, etc.) Miroir"]

W2-> K3 ["3. Modèle en ligne + grand miroir du latex"]]

A -> w4 ["iv. Autres méthodes de déploiement"]]

W4-> C1 ["1. Windows / macOS One -Click Installation and Run Script (recommandation)"]

W4-> C2 ["2. Huggingface, déploiement à distance de scelos"]]

W4-> C4 ["3. ... Autre ..."]]

Télécharger le projet

git clone --depth=1 https://github.com/binary-husky/gpt_academic.git

cd gpt_academicConfigurer API_KEY et d'autres variables

Dans config.py , configurez des variables telles que la clé API. Méthode de réglage de l'environnement réseau spécial, description de la configuration du projection Wiki.

"Le programme donnera la priorité à vérifier s'il existe un fichier de configuration privé appelé config_private.py et configurer le même nom avec la configuration de config.py . Si vous pouvez comprendre la logique de lecture ci-dessus, nous vous recommandons fortement de créer sous le config_private.py chemin du chemin config.py config_private.py

"Prise en charge de l'élément de configuration环境变量, reportez-vous au fichier docker-compose.yml ou à notre page wiki du format d'écriture de la variable d'environnement. Priorité de lecture de configuration:环境变量> config_private.py > config.py ".

Dépendance à l'installation

# (选择I: 如熟悉python, python推荐版本 3.9 ~ 3.11)备注:使用官方pip源或者阿里pip源, 临时换源方法:python -m pip install -r requirements.txt -i https://mirrors.aliyun.com/pypi/simple/

python -m pip install -r requirements.txt

# (选择II: 使用Anaconda)步骤也是类似的 (https://www.bilibili.com/video/BV1rc411W7Dr):

conda create -n gptac_venv python=3.11 # 创建anaconda环境

conda activate gptac_venv # 激活anaconda环境

python -m pip install -r requirements.txt # 这个步骤和pip安装一样的步骤[Étapes facultatives] Si vous devez prendre en charge Tsinghua ChatGlm3 / Fudan Moss en tant que back-end, vous devez installer plus de dépendances (préalable: familier avec Python + Pytorch + Configuration de l'ordinateur):

# 【可选步骤I】支持清华ChatGLM3。清华ChatGLM备注:如果遇到"Call ChatGLM fail 不能正常加载ChatGLM的参数" 错误,参考如下: 1:以上默认安装的为torch+cpu版,使用cuda需要卸载torch重新安装torch+cuda; 2:如因本机配置不够无法加载模型,可以修改request_llm/bridge_chatglm.py中的模型精度, 将 AutoTokenizer.from_pretrained("THUDM/chatglm-6b", trust_remote_code=True) 都修改为 AutoTokenizer.from_pretrained("THUDM/chatglm-6b-int4", trust_remote_code=True)

python -m pip install -r request_llms/requirements_chatglm.txt

# 【可选步骤II】支持复旦MOSS

python -m pip install -r request_llms/requirements_moss.txt

git clone --depth=1 https://github.com/OpenLMLab/MOSS.git request_llms/moss # 注意执行此行代码时,必须处于项目根路径

# 【可选步骤III】支持RWKV Runner

参考wiki:https://github.com/binary-husky/gpt_academic/wiki/%E9%80%82%E9%85%8DRWKV-Runner

# 【可选步骤IV】确保config.py配置文件的AVAIL_LLM_MODELS包含了期望的模型,目前支持的全部模型如下(jittorllms系列目前仅支持docker方案):

AVAIL_LLM_MODELS = [ " gpt-3.5-turbo " , " api2d-gpt-3.5-turbo " , " gpt-4 " , " api2d-gpt-4 " , " chatglm " , " moss " ] # + ["jittorllms_rwkv", "jittorllms_pangualpha", "jittorllms_llama"]

# 【可选步骤V】支持本地模型INT8,INT4量化(这里所指的模型本身不是量化版本,目前deepseek-coder支持,后面测试后会加入更多模型量化选择)

pip install bitsandbyte

# windows用户安装bitsandbytes需要使用下面bitsandbytes-windows-webui

python -m pip install bitsandbytes --prefer-binary --extra-index-url=https://jllllll.github.io/bitsandbytes-windows-webui

pip install -U git+https://github.com/huggingface/transformers.git

pip install -U git+https://github.com/huggingface/accelerate.git

pip install peftpython main.py Toutes les capacités de déploiement de projets (il s'agit d'un grand miroir contenant CUDA et Latex. Mais si vous avez une vitesse de réseau lente et un petit disque dur, cette méthode n'est pas recommandée pour déployer un élément complet)

# 修改docker-compose.yml,保留方案0并删除其他方案。然后运行:

docker-compose up SEULEMENT CHATGPT + GLM4 + Wenxin a dit + Spark et d'autres modèles en ligne (recommandé par la plupart des gens)

# 修改docker-compose.yml,保留方案1并删除其他方案。然后运行:

docker-compose upSi PS doit s'appuyer sur la fonction du latex Plug -in, voir Wiki. De plus, vous pouvez également utiliser directement le schéma 4 ou le schéma 0 pour obtenir la fonction latex.

Chatgpt + GLM3 + Moss + Llama2 + Tongyi Qianwen (besoin de familiariser avec Nvidia Docker lors de la course)

# 修改docker-compose.yml,保留方案2并删除其他方案。然后运行:

docker-compose upScript d'exécution de Windows One -click . Les utilisateurs de Windows qui ne sont pas familiers avec l'environnement Python peuvent télécharger le script en cours d'exécution One -Clic publié dans la version pour installer une version sans modèles locaux. Source de la contribution du script: oobabooga.

Utilisez une API de troisième partie, Azure, etc., Wen Xinyi, Star Fire, etc., voir la page Wiki

Les serveurs cloud ont déployé à distance les directives pour éviter la fosse. Veuillez visiter le Wiki de déploiement à distance du serveur Cloud Server

Déployer sur d'autres plateformes et déploiement d'URL secondaire

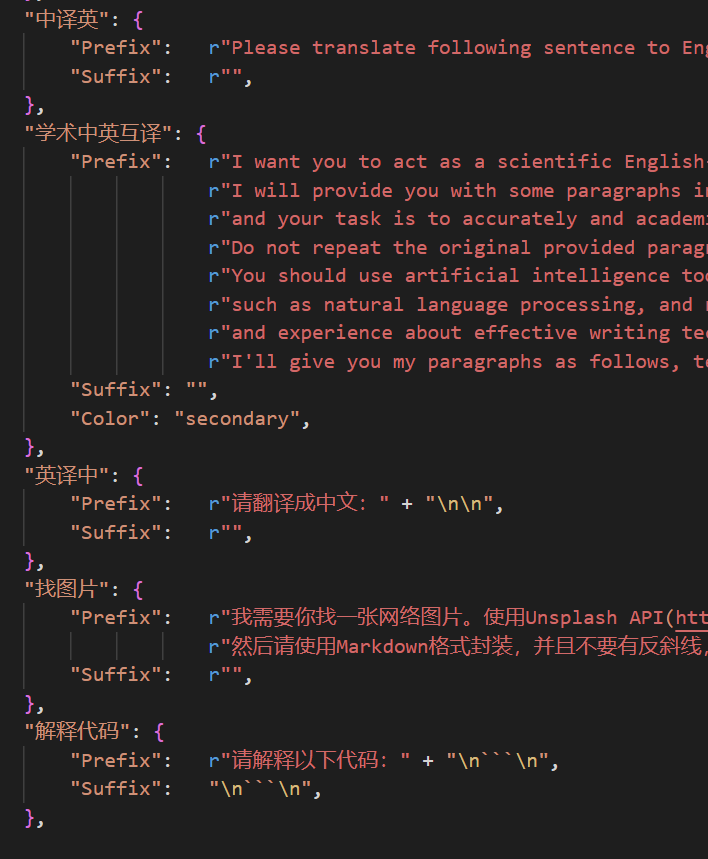

http://localhost/subpath ). Veuillez visiter les instructions d'opération Fastapi Vous pouvez désormais ajouter un nouveau bouton pratique自定义菜单dans le menu界面外观dans l'interface utilisateur. Si vous devez le définir dans le code, utilisez n'importe quel éditeur de texte pour ouvrir core_functional.py , ajoutez les entrées suivantes:

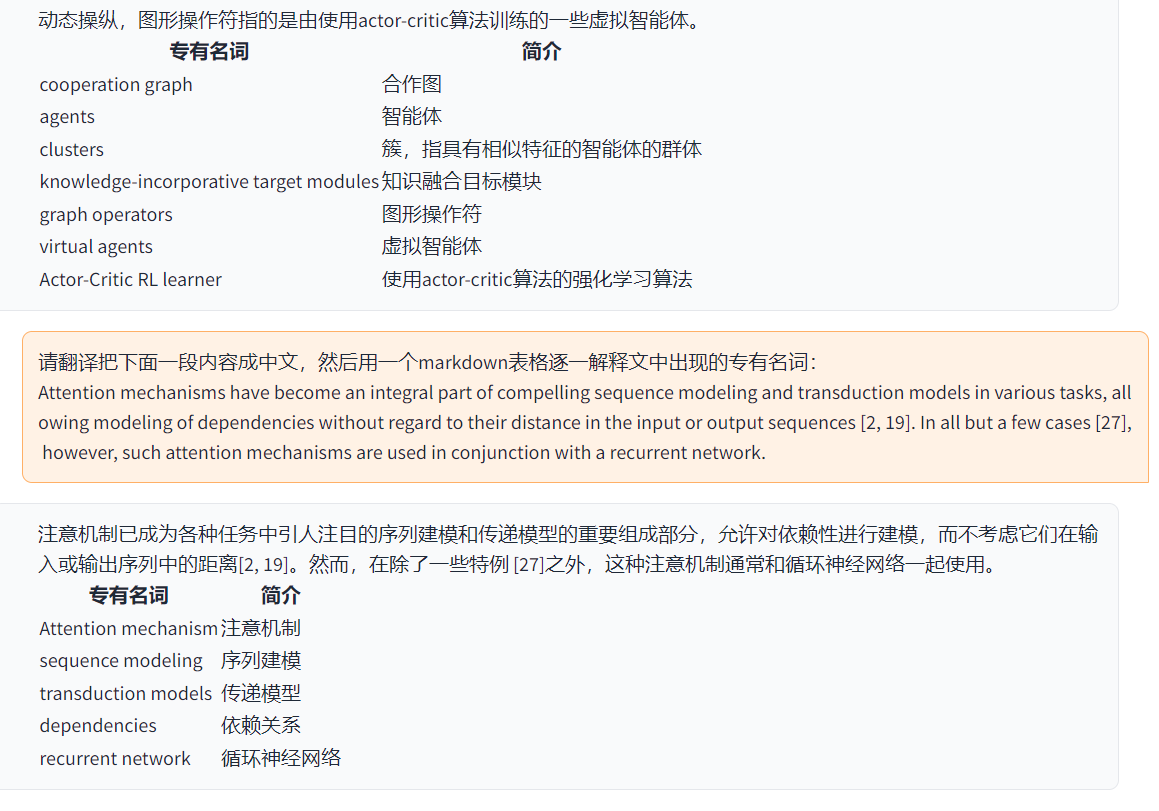

"超级英译中" : {

# 前缀,会被加在你的输入之前。例如,用来描述你的要求,例如翻译、解释代码、润色等等

"Prefix" : "请翻译把下面一段内容成中文,然后用一个markdown表格逐一解释文中出现的专有名词: n n " ,

# 后缀,会被加在你的输入之后。例如,配合前缀可以把你的输入内容用引号圈起来。

"Suffix" : "" ,

},

Écrivez une fiche de fonction puissante -in pour effectuer toutes les tâches que vous souhaitez et de façon inattendue. La fiche et le débogage de ce projet sont très faibles. Pour plus de détails, veuillez consulter le Guide de la fiche de fonction.

保存当前的对话dans la zone de la fiche de fonction pour enregistrer le dialogue actuel en tant que载入对话历史存档HTML recouvrables + récupérables.载入对话历史存档pour restaurer la session précédente. Conseil: si vous ne spécifiez pas le fichier, cliquez载入对话历史存档pour afficher le cache d'archives HTML historique.

===>

===>

config.py )

===>

===>

GPT Academic Developer QQ Group: 610599535

requirement.txt pour installer Gradio Timeline LR

Titre GPT-Academic Project Development Process Section 2.x

1.0 ~ 2.2: Fonction de base: introduire la fonction de fonction modulaire -In: Disposition pliable: Fonction Plug -in prend en charge la charge thermique 2.3 ~ 2.5: Améliorer l'interaction multi-thread: Nouveau PDF Fonction de traduction en texte complet: Nouvelle zone de commutation de la zone d'entrée Fonction: mise à jour 2.6: Reconstruire la structure de la fiche: Amélioration de l'interaction: Ajoutez plus

3.0 ~ 3.1: Prise en charge de ChatGlm: Prise en charge d'autres petits LLM: Prise en charge de plusieurs modèles GPT en même temps: Prise en charge de multiples équilibrage de charge APIKEY 3.2 ~ 3.3: Fonction Plug -in prend en charge plus d'interface de paramètre: Enregistrez la fonction de dialogue: interpréter tout code linguistique: Dans le même temps, demandez n'importe quelle combinaison LLM: Internet Information Fonction complète 3.4: Rejoignez la traduction de la thèse ArXIV: Ajoutez la fonction de correction de thèse de latex 3.44: prend officiellement Azure: interface optimisée facile à utiliser 3.46: Modèle de filtre ChatGLM2 personnalisé: Dialogue vocal réel-temps 3.49: Support Alida Mo Yuan Tongyi Qian Qian: Shanghai Ai-Lab Scholar: Xun Fei Xinghuo: Support Baidu Qianfan Platform & Wenxin A Word 3.50: Void Terminal: Support Classification du plug-in: Améliorer l'interface : Stabilité d'amélioration: résoudre le problème du conflit multi-utilisateurs 3.55: Interprète de code dynamique: reconstruction de l'interface avant -nd: introduction de fenêtres en suspension et barre de menu 3.56: Bouton de fonction de base supplémentaire dynamique: nouveau rapport PDF Summary Page 3.57: GLM3, Star Fire V3: Support Wenxinyi Speaking V4: Correction du bug simultané du modèle local

3.60: Introduction à Autogen

3.70: Introduire le dessin de la sirène: implémentation de fonctions telles que GPT Brain Drawing 3.80 (TODO): Plug Autogen Optimize Vous pouvez changer de thèmes en modifiant le THEME

Chuanhu-Small-and-Beautiful URLmaster Branch: branche principale, version stablefrontier : branche de développement, version de test代码中参考了很多其他优秀项目中的设计,顺序不分先后:

# 清华ChatGLM2-6B:

https://github.com/THUDM/ChatGLM2-6B

# 清华JittorLLMs:

https://github.com/Jittor/JittorLLMs

# ChatPaper:

https://github.com/kaixindelele/ChatPaper

# Edge-GPT:

https://github.com/acheong08/EdgeGPT

# ChuanhuChatGPT:

https://github.com/GaiZhenbiao/ChuanhuChatGPT

# Oobabooga one-click installer:

https://github.com/oobabooga/one-click-installers

# More:

https://github.com/gradio-app/gradio

https://github.com/fghrsh/live2d_demo