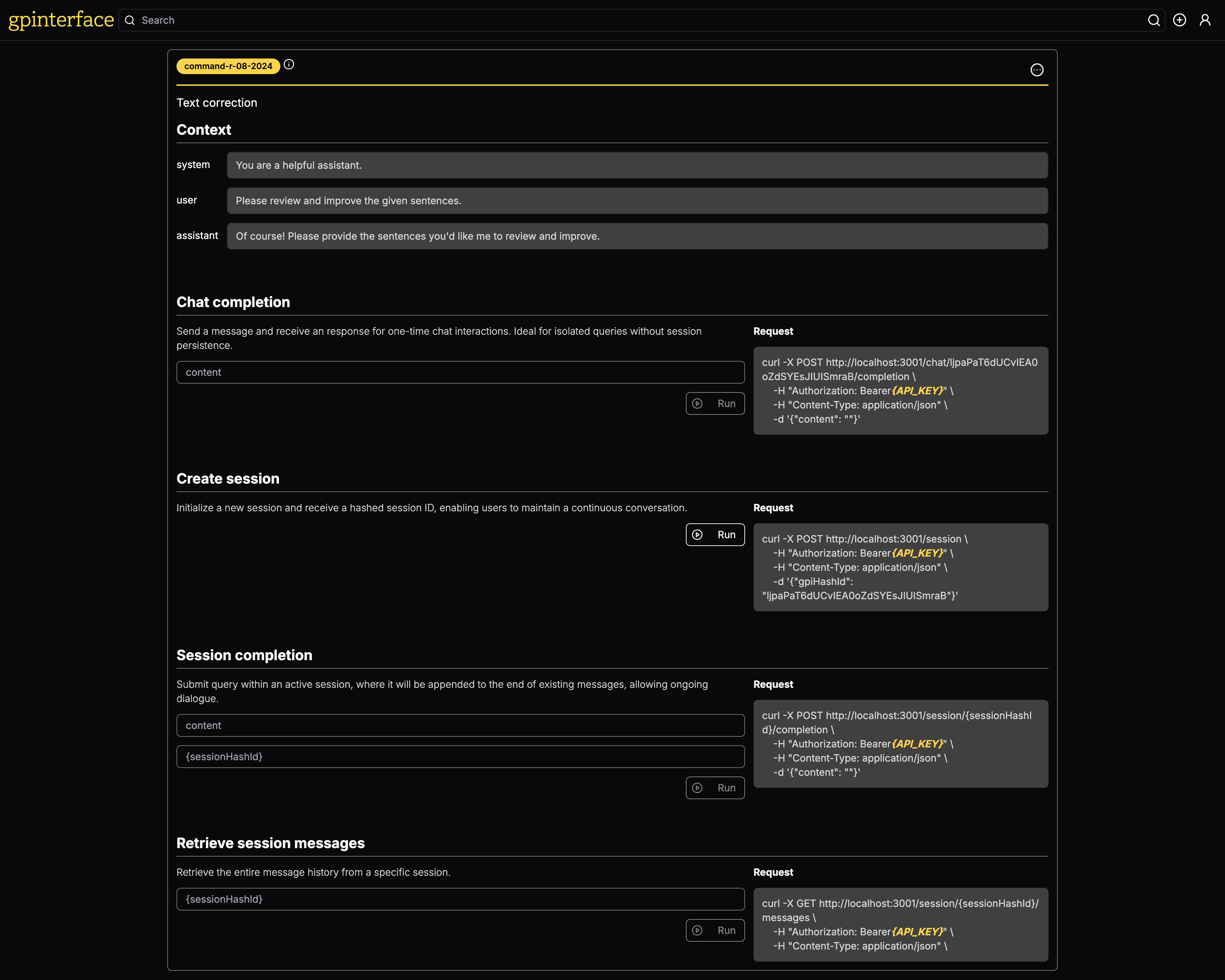

Avec gpinterface , vous pouvez facilement créer une API pour vos invites.

Une démo en direct est disponible sur gpinterface.com.

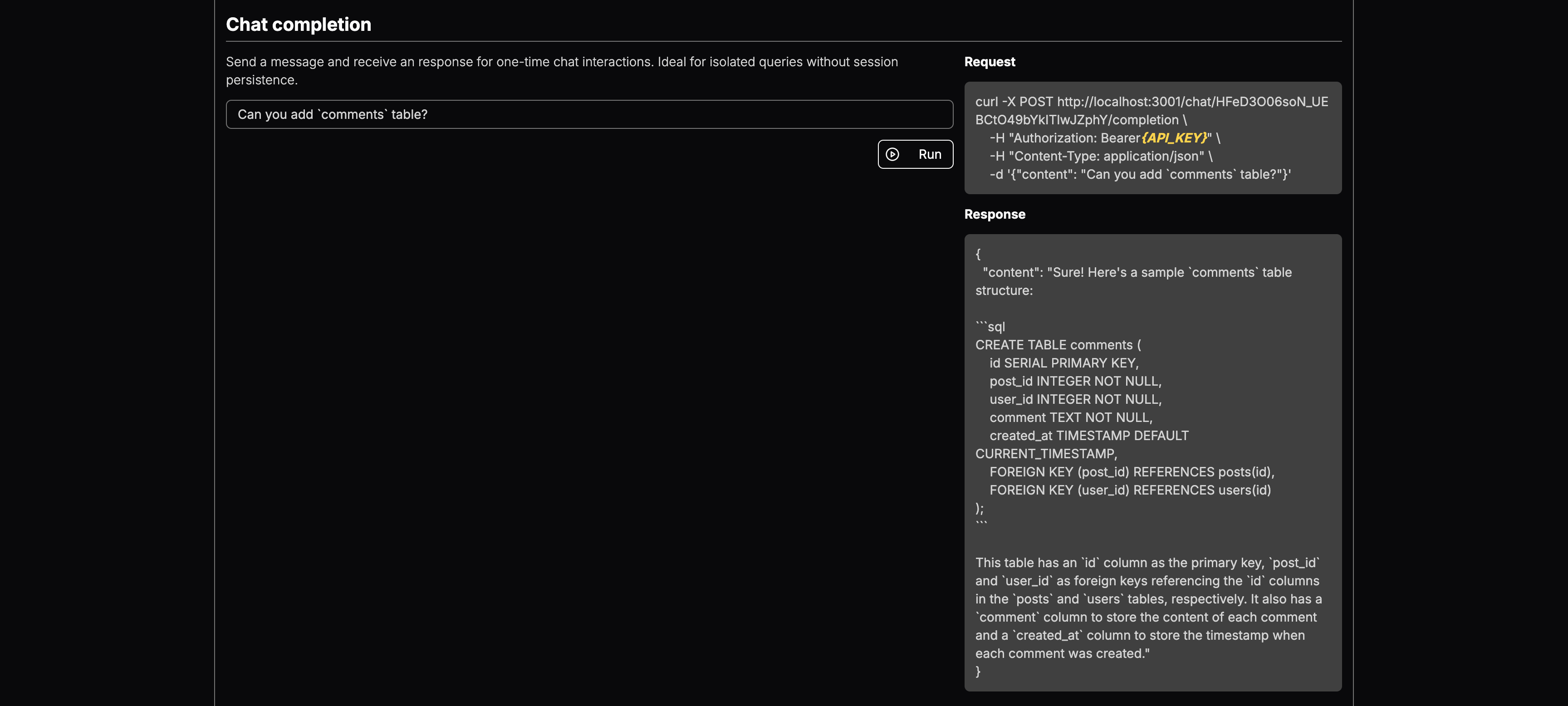

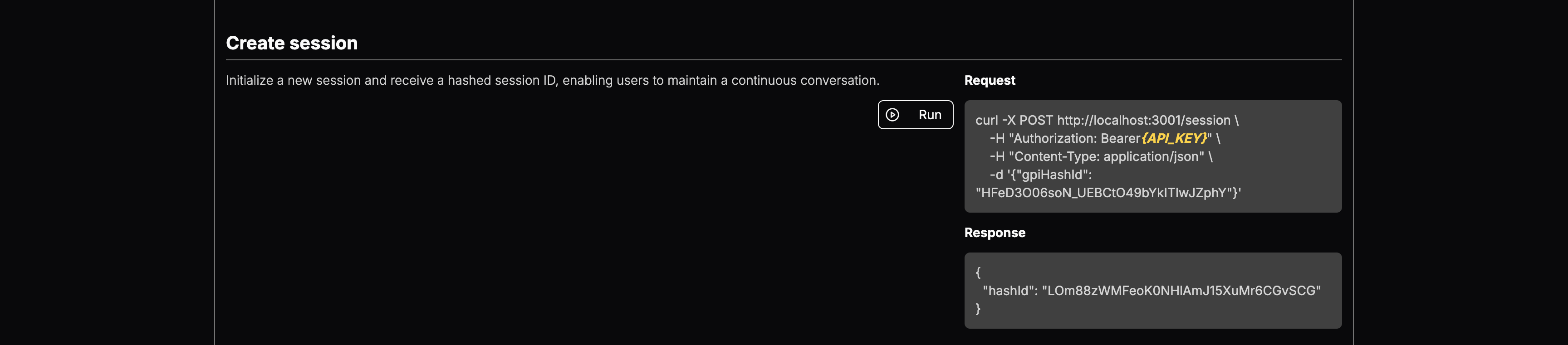

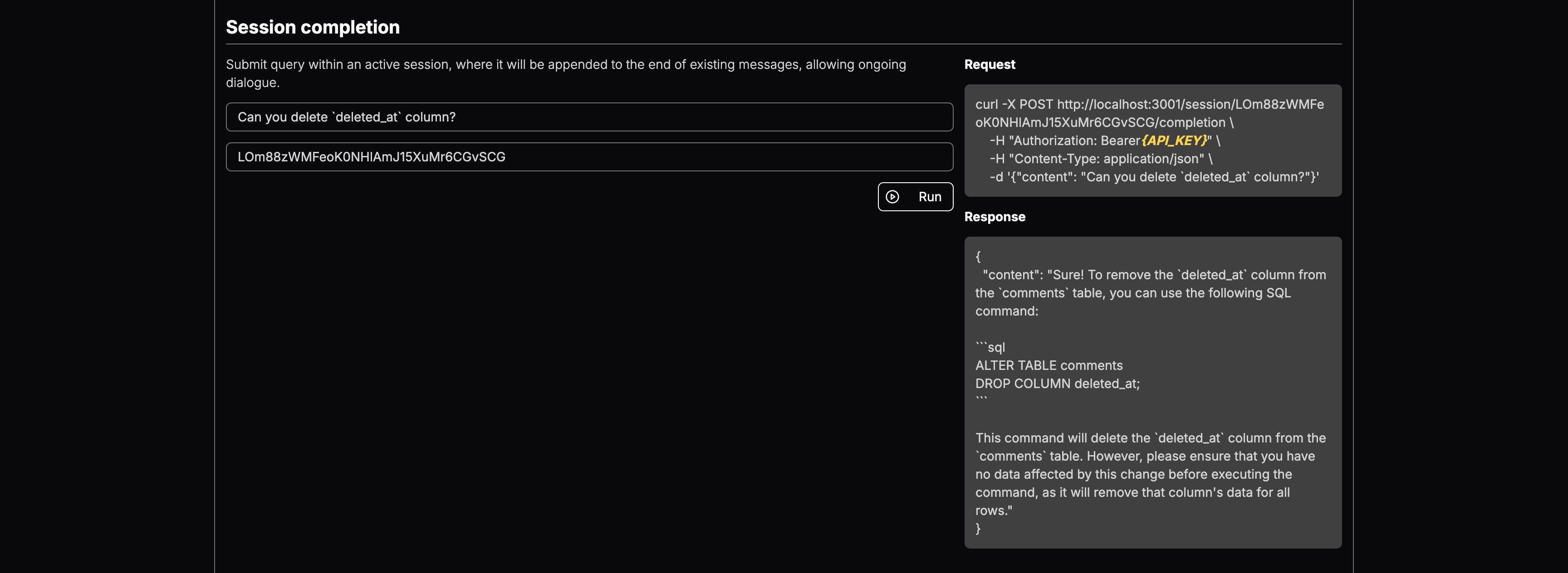

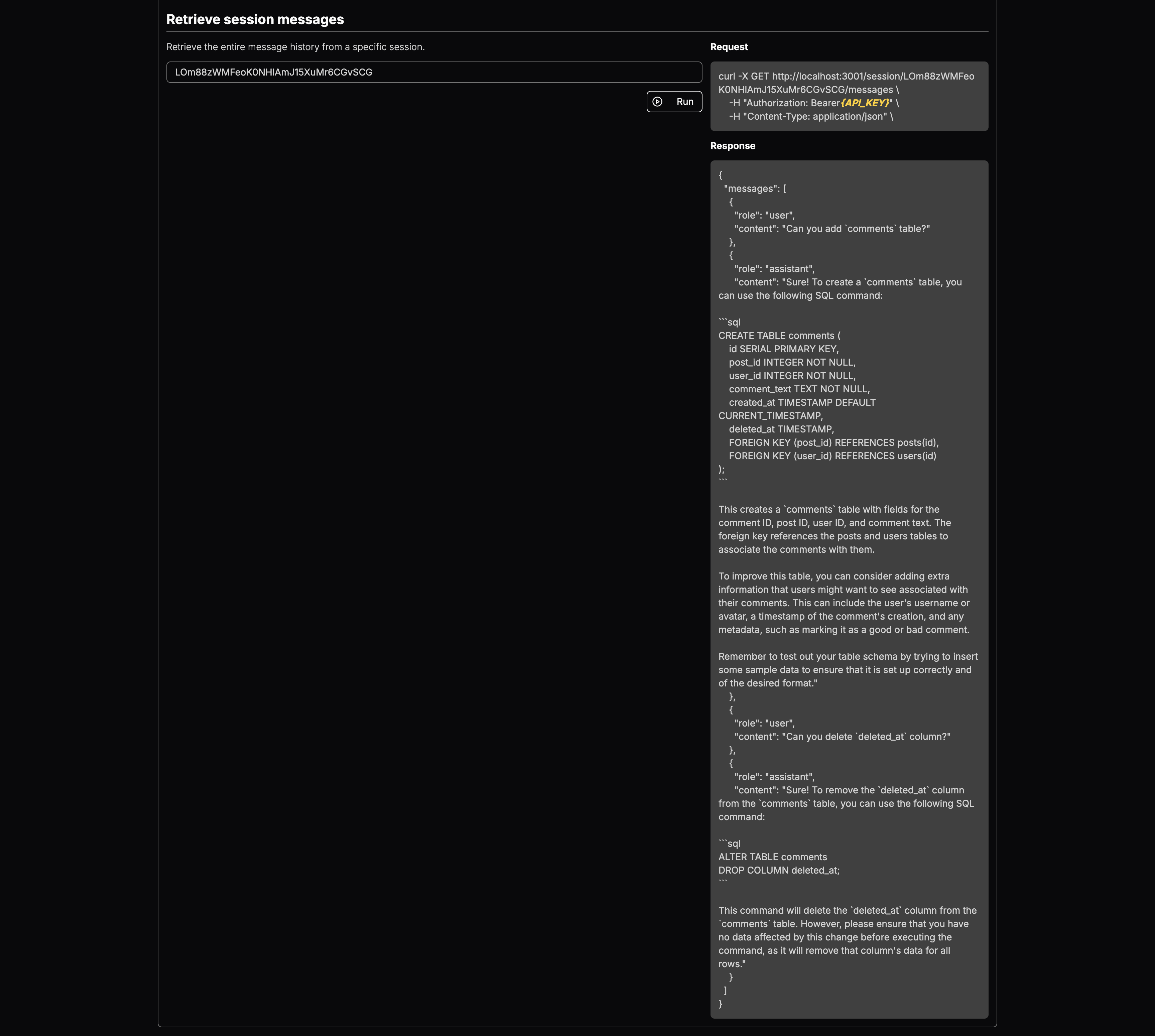

Voici quelques exemples spécifiques de ce que gpinterface peut faire:

Vous pouvez sélectionner le modèle LLM et ajouter un contexte. Une fois déployé, vous obtiendrez des points de terminaison pour:

Il s'agit d'un outil puissant conçu pour rationaliser les tests et le déploiement d'invites génératives sur plusieurs modèles de grande langue (LLM). Avec une interface Web facile à utiliser, gpinterface permet une configuration et une expérimentation rapides.

gpinterface prend actuellement en charge une variété de modèles de grande langue de premier plan, notamment:

Ce support diversifié vous permet de choisir le meilleur modèle pour vos besoins et exigences spécifiques.

Vous ne voyez pas votre modèle préféré? N'hésitez pas à ouvrir les relations publiques ou à me contacter!

L'application nécessite une base de données PostgreSQL. Démarrez la base de données à l'aide de Docker:

cd backend

docker-compose up -dLe backend utilise PRISMA pour gérer le schéma et les migrations de la base de données. Exécutez les commandes suivantes lors de l'initialisation de la base de données:

npm run prisma:migratePour semer la base de données avec les données initiales pour chaque modèle de grande langue pris en charge, exécutez les commandes suivantes:

npx ts-node prisma/seedBackend

Le backend nécessite le réglage des variables d'environnement suivantes:

CLIENT_URL= " http://localhost:3003 "

DATABASE_URL= " postgresql://postgres:[email protected]:5432/postgres " # can be replaced with your DB endpoint

AI21_API_KEY= " YOUR_AI21_API_KEY "

ANTHROPIC_API_KEY= " YOUR_ANTHROPIC_API_KEY "

COHERE_API_KEY= " YOUR_COHERE_API_KEY "

GOOGLE_API_KEY= " YOUR_GOOGLE_API_KEY "

MISTRAL_API_KEY= " YOUR_MISTRAL_API_KEY "

OPENAI_API_KEY= " YOUR_OPENAI_API_KEY "

AWS_ACCESS_KEY_ID= " AWS_ACCESS_KEY " # you need Llama model access in AWS Bedrock

AWS_SECRET_ACCESS_KEY= " AWS_SECRET_KEY " # you need Llama model access in AWS Bedrock

JWT_SECRET= " SECURE_RANDOM_STRING "

COOKIE_SECRET= " SECURE_RANDOM_STRING "

NODE_ENV= " development " # for development logging Assurez-vous que ces variables sont définies dans un fichier .env dans le répertoire backend avant de démarrer l'application.

l'extrémité avant

L'application Frontend nécessite les variables d'environnement suivantes:

NEXT_PUBLIC_API_ENDPOINT= " http://localhost:3000 "

NEXT_PUBLIC_CHAT_ENDPOINT= " http://localhost:3001 "

NEXT_PUBLIC_HOSTNAME= " http://localhost:3003 "

NEXT_PUBLIC_GOOGLE_OAUTH_CLIENT_KEY= " "Ceux-ci doivent être configurés pour correspondre aux points de terminaison où les services backend sont disponibles, garantissant que le frontend peut communiquer correctement avec le backend.

Pour exécuter les composants d'application séparément à des fins de développement:

Backend de course

cd backend && npm run devFonden de course

cd frontend && npm run devPour construire tous les composants pour le déploiement de la production, suivez ces étapes séquentiellement

cd shared

npm run build

cd ../backend

npm run build

cd ../frontend

npm run buildPour démarrer le serveur

Backend de course

cd backend && npm run startExécuter le serveur de chat (serveur API)

cd backend && npm run start:chatFonden de course

cd frontend && npm run start