Ce référentiel contient l'implémentation de ICLR2024 Paper LLCP: Apprentissage des processus causaux latents pour la question vidéo basée sur le raisonnement Réponse PDF

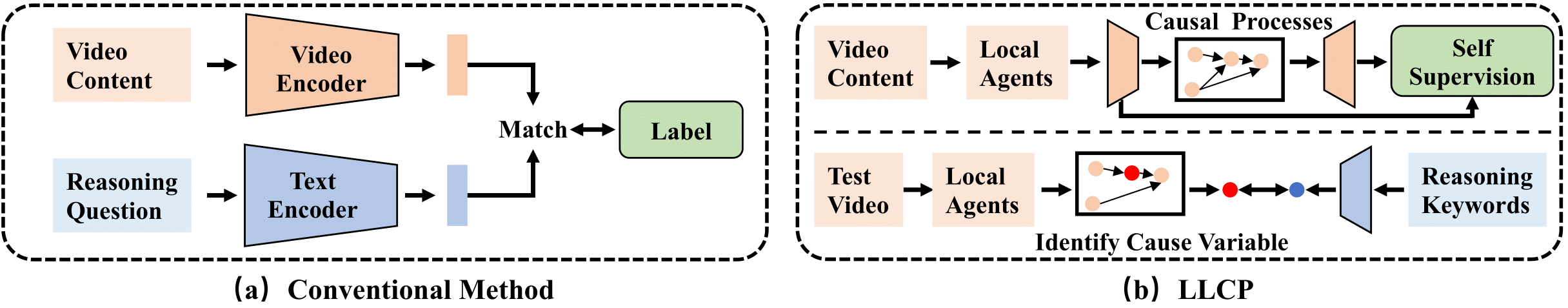

LLCP est un cadre causal conçu pour améliorer le raisonnement vidéo en se concentrant sur la dynamique spatiale-temporelle des objets dans les événements, sans avoir besoin d'annotations de données approfondies. En utilisant l'apprentissage auto-levé et en tirant parti de la modularité des mécanismes causaux, LLCP apprend un modèle génératif multivarié pour la dynamique spatiale-temporelle et permet ainsi une attribution accidentelle efficace et une prédiction contrefactuelle de la vidéo basée sur le raisonnement.

Tout d'abord, veuillez installer la version récente de Pytorch et TorchVision en tant que pip install torch torchvision . pip install -r requirements.txt , vous pouvez installer un autre pack

Nous fournissons les fonctionnalités traitées utilisées dans nos expériences. Veuillez télécharger les données et le modèle dans ce lien1 et ce lien2. Ensuite, veuillez décompresser les Floders en tant que ./data/ et ./results/ et remplacez les Floders d'origine comme ceux téléchargés.

La structure du répertoire devrait ressembler

LLCP_VQA/

|–– config.py

|–– configs/

|–– data/

| |–– object_test_feat/

| |–– object_train_feat/

| |–– appearance_feat_rn50.h5

| |–– test_questions.pt

| |–– train_questions.pt

| |–– video_noaccident_train.txt

|–– DataLoader.py

|–– models_cvae.py

|–– requirements.txt

|–– results/

| |–– .../model_cvae49.pt

|–– README.md

|–– train.py

|–– validate.py

Pour entraîner le modèle CVAE, vous pouvez exécuter cette commande:

python train.py --cfg configs/sutd-traffic_transition.yml

Pour évaluer le modèle formé, veuillez vous référer à:

python validate.py --cfg configs/sutd-traffic_transition.yml

Voir la simulation LLCP.

Si vous trouvez notre travail utile dans vos recherches, veuillez envisager de citer:

@inproceedings{chen2024llcp,

title={LLCP: Learning Latent Causal Processes for Reasoning-based Video Question Answer},

author={Chen, Guangyi and Li, Yuke and Liu, Xiao and Li, Zijian and Al Surad, Eman and Wei, Donglai and Zhang, Kun}

booktitle={ICLR},

year={2024}

}

Notre implémentation est principalement basée sur le SUTD-TRAFFICQA et TEM-Adapter, nous remercions les auteurs de publier leurs codes.