中文 Readme 请按此处

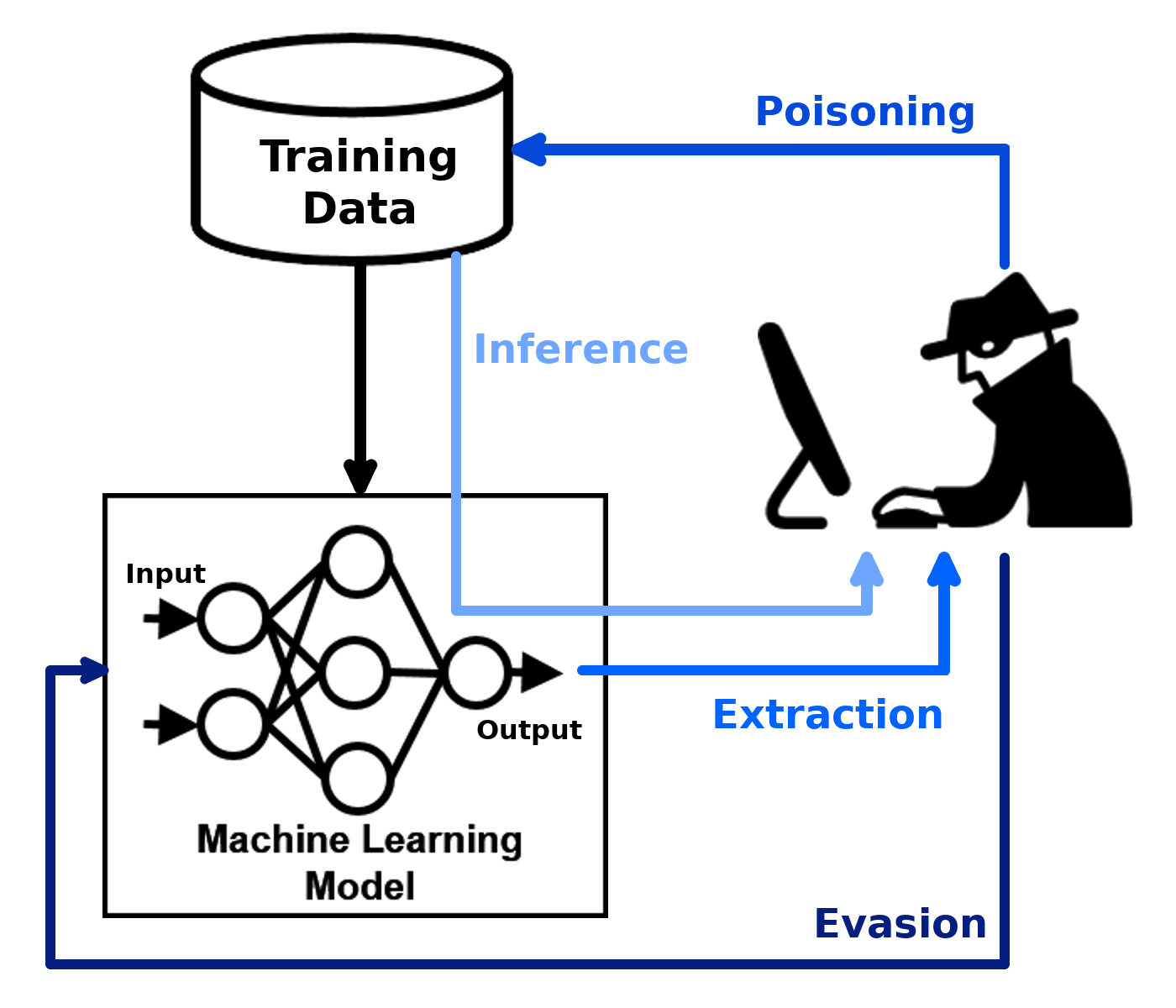

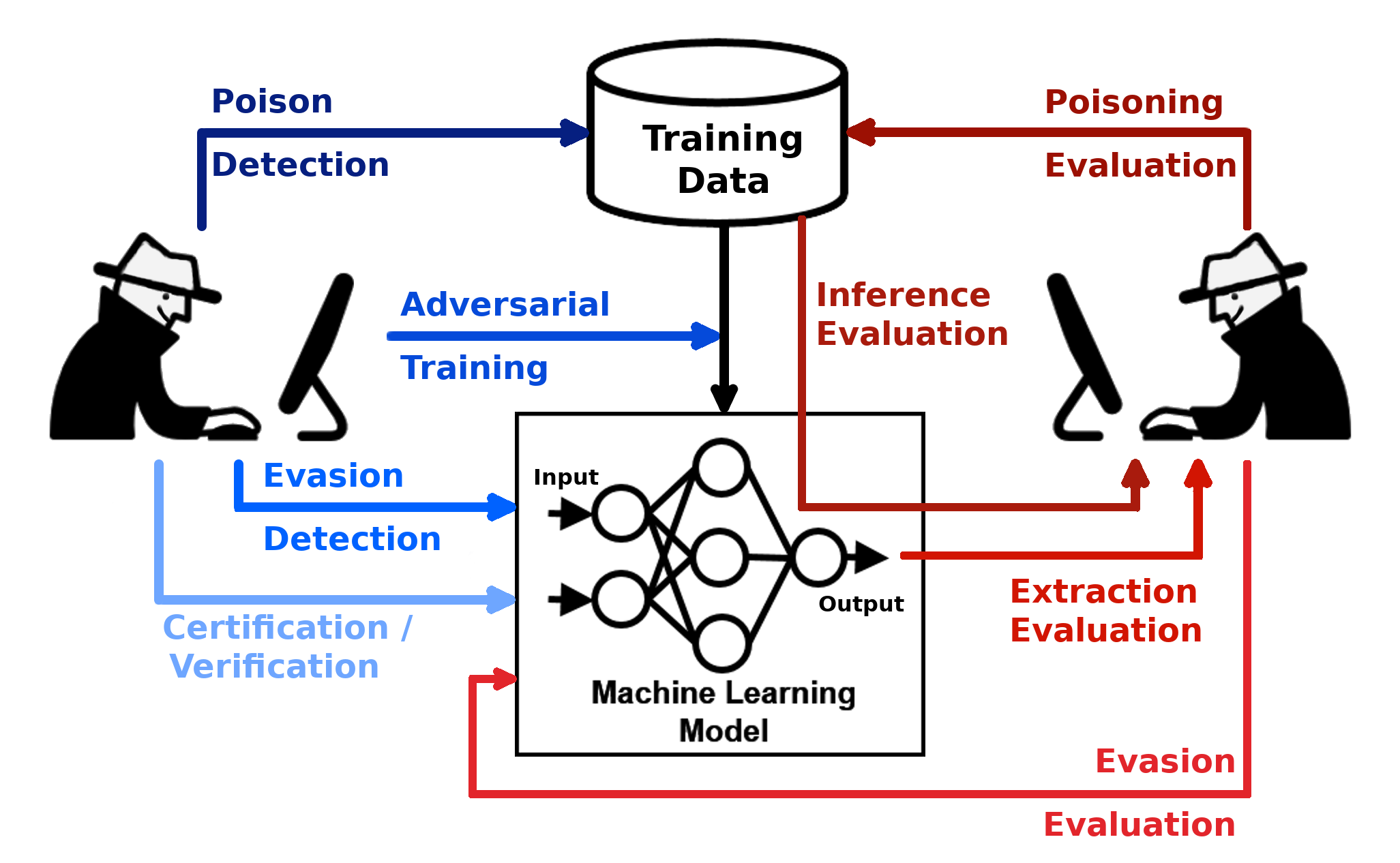

La boîte à outils de robustesse adversaire (ART) est une bibliothèque Python pour la sécurité de l'apprentissage automatique. L'art est hébergé par la Linux Foundation AI & Data Foundation (LF AI & Data). L'ART fournit des outils qui permettent aux développeurs et aux chercheurs de défendre et d'évaluer les modèles d'apprentissage automatique et les applications contre les menaces contradictoires d'évasion, d'empoisonnement, d'extraction et d'inférence. L'art prend en charge tous les cadres d'apprentissage automatique populaires (Tensorflow, Keras, Pytorch, Mxnet, Scikit-Learn, Xgboost, LightGBM, CatBoost, GPY, etc.), tous les types de données (images, tableaux, audio, vidéo, etc.) et l'apprentissage automatique Tâches (classification, détection d'objets, reconnaissance de la parole, génération, certification, etc.).

| Commencer | Documentation | Contributif |

|---|---|---|

| - Installation - Exemples - cahiers | - Attaques - défenses - estimateurs - Métriques - Documentation technique | - Slack, invitation - Contribution - Route de route - citant |

La bibliothèque est en cours de développement continu. Les commentaires, les rapports de bogues et les contributions sont les bienvenus!

Ce matériel est en partie basé sur les travaux soutenus par la Defense Advanced Research Projects Agency (DARPA) en vertu du contrat n ° HR001120C0013. Toutes les opinions, conclusions et conclusions ou recommandations exprimés dans ce matériel sont ceux des auteurs et ne reflètent pas nécessairement les vues de l'Agence de projets de recherche avancée de la défense (DARPA).