Il s'agit d'une liste organisée de papiers "Language-Model-As-A-Service (LMAAS), qui est principalement entretenu par Tianxiang Sun. Nous encourageons fortement les chercheurs de la PNL qui sont intéressés par ce sujet à faire une demande de traction pour ajouter ou mettre à jour les articles (voir contribution). Regardez ce référentiel pour les dernières mises à jour!

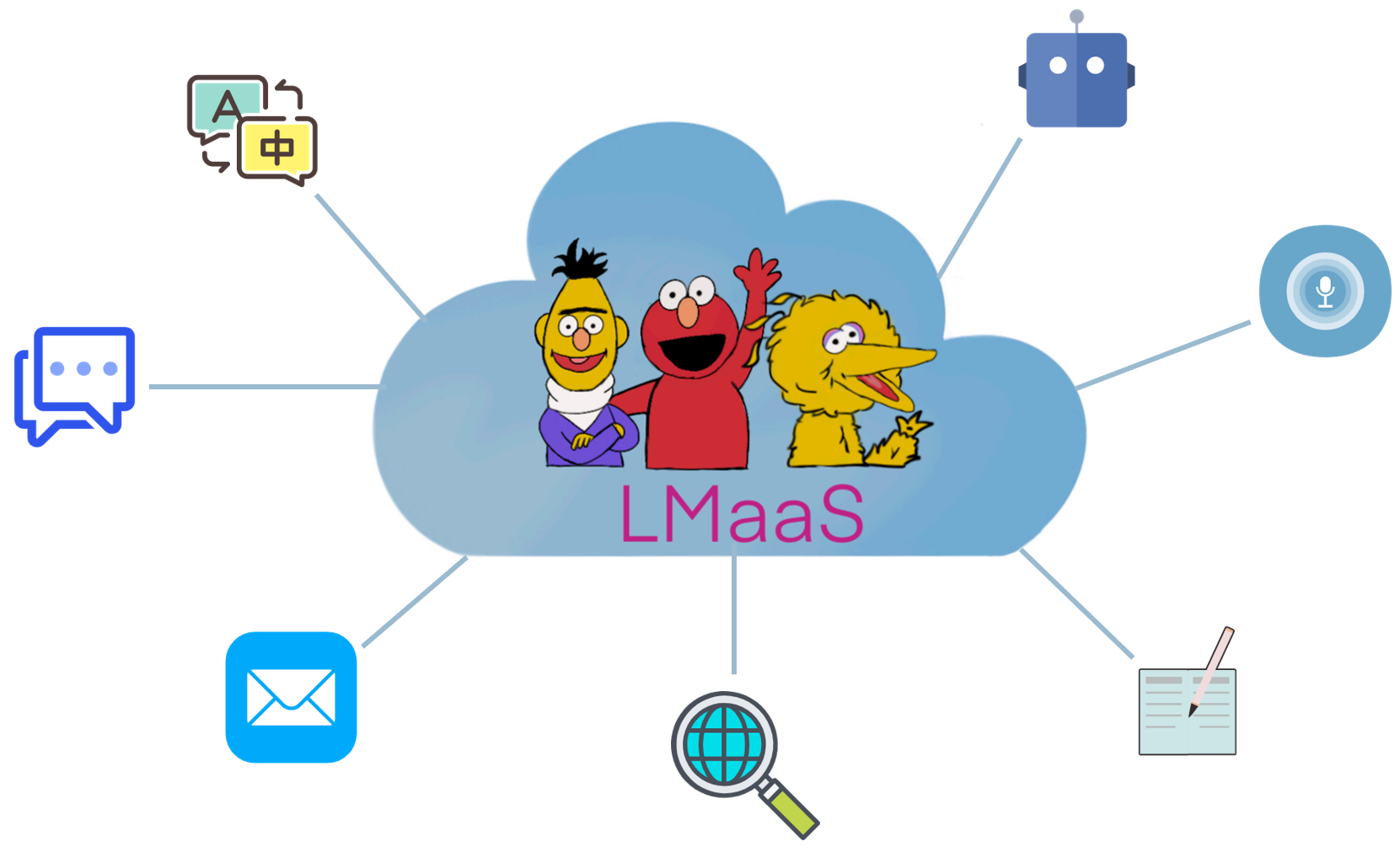

Pour des raisons commerciales et un coût de réglage coûteux, des modèles de langage prélevés pré-formés (LLM) tels que GPT-3 sont généralement libérés en tant que service au lieu de poids de modèle d'approvisionnement ouvert. Nous appelons ce scénario " Language-model-as-a-Service (LMAAS) " (le terme est initialement utilisé dans notre papier ICMl'2022). Dans un tel scénario, les utilisateurs peuvent accéder aux puissants LLM via leurs API d'inférence. Le service de LLMS a alimenté de nombreux cas d'utilisation (voir la démo GPT-3). Contrairement à un réglage fin, les LMAAs permettent à un seul usage général LLM de servir de nombreuses tâches de différence et est donc très économe en déploiement. Néanmoins, comment adapter les LLM pour cibler les tâches sans accès à leurs paramètres et gradients est un défi. Pour faire en sorte que les LLM bénéficient d'un public plus large, nous collectons des articles qui s'inscrivent dans ce scénario pour faciliter les recherches futures.

Quels papiers s'inscrivent dans le scénario des LMAA? Nous considérons principalement les articles qui adaptent les LLM aux tâches en aval sans accéder aux paramètres du modèle et aux gradients. Bien que les LLMs affinés puissent également être des services après le déploiement, ils sont limités pour résoudre une seule tâche pour un public limité. Dans notre portée, nous préférons servir des modèles à usage général pour une variété d'utilisateurs.

Dans la littérature existante, il existe plusieurs lignes de recherche qui s'adaptent aux LMAA:

La limite entre l'invite de texte et l'apprentissage dans le contexte est un peu floue. Dans ce dépôt, la catégorie d'invite de texte contient des articles qui n'utilisent pas d'échantillons étiquetés, tandis que la catégorie d'apprentissage en contexte est composée d'articles qui incluent des échantillons étiquetés dans les invites.

Remarque: Un sujet connexe (et partiellement chevauché) est un apprentissage basé sur une invite , qui vise à résoudre les tâches en aval en utilisant des LLM à des fins générales en convertissant l'entrée et la sortie avec un modèle et un verbin, respectivement. Cependant, la plupart des œuvres dans l'apprentissage basé sur une base nécessitent l'accès aux paramètres du modèle et aux gradients, et ne s'intègrent donc pas dans notre portée. Pour les documents d'apprentissage basés sur des bases qui ne conviennent pas aux LMAA, nous vous recommandons de contribuer à une autre liste de papier impressionnante: Invitepaper.

Par rapport aux LLM spécifiques à la tâche à réglage fin, LMAAS présente les avantages suivants:

L'abréviation de l'œuvre.

La caractéristique clé du travail.

Le principal cadre expérimental du travail.

Modèles linguistiques comme bases de connaissances? EMNLP 2019

Fabio Petroni, Tim Rocktäschel, Patrick Lewis, Anton Bakhtin, Yuxiang Wu, Alexander H. Miller, Sebastian Riedel . [pdf] [code]

Comment pouvons-nous savoir ce que les modèles de langue savent? Tacl 2020

Zhengbao Jiang, Frank F. Xu, Jun Araki, Graham Neubig . [pdf] [code]

Les modèles de langue sont des apprenants à quelques tirs. Neirips 2020

Tom B. Brown, Benjamin Mann, Nick Ryder, Melanie Subbiah, Jared Kaplan, Prafulla Dhariwal, Arvind Neelakantan, Pranav Shyam, Girish Sastry, Amanda Askel Ramesh, Daniel M. Ziegler, Jeffrey Wu, Clemens Winter, Christopher Hesse, Mark Chen, Eric Sigler, Mateusz Litwin, Scott Gray, Benjamin Chess, Jack Clark, Christopher Berner, Sam McCandlish, Alec Radford, Ilya Sutskever, Dario Amodei . [PDF]

Adapter les modèles de langage pour l'apprentissage zéro par méta-tuning sur l'ensemble de données et les collections rapides . Résultats de l'EMNLP 2021

Ruiqi Zhong, Kristy Lee, Zheng Zhang, Dan Klein . [pdf] [code]

Les modèles de langage à finet sont des apprenants à tirs zéro . ICLR 2022

Jason Wei, Maarten Bosma, Vincent Y. Zhao, Kelvin Guu, Adams Wei Yu, Brian Lester, Nan DU, Andrew M. Dai, Quoc V. LE . [pdf] [code]

La formation invitée à plusieurs tâches permet une généralisation des tâches zéro-shot . ICLR 2022

Victor Sanh, Albert Webson, Colin Raffel, Stephen H. Bach, Lintang Sutawika, Zaid Alyafai, Antoine Chaffin, Arnaud Stiegler, Teven Le Scao, Arun Raja, Manan Dey, M Saiful Bari, Canwen Xu, Urmish Thakker, Shanya Sharma Sharma, Eliza Szczechla, Taewoon Kim, Gunjan Chhablani, Nihal Nayak, Debajyoti Datta, Jonathan Chang, Mike Tian-Jian Jiang, Han Wang, Matteo Manica, Sheng Shen, Zheng Xin Yong, Harshit Pandey, Rachel Bawden, Thomas Wang, Trishala Neera, Jos Rozen, Abheesht , Andrea Santilli, Thibault Fevry, Jason Alan Fries, Ryan Teehan, Tali Bers, Stella Biderman, Leo Gao, Thomas Wolf, Alexander M. Rush . [pdf] [code]

Modèles de la langue de formation pour suivre les instructions avec les commentaires humains . Préimpression 2022.3

Long Oulang, Jeff Wu, Xu Jiang, Diogo Almeida, Carroll L. Wainwright, Pamela Mishkin, Chong Zhang, Sandhini Agarwal, Katarina Slama, Alex Ray, John Schulman, Jacob Hilton, Fraser Kelton, Luke Miller, Maddie Simens, Amanda Aska Peter Wellinder, Paul Christiano, Jan Leike, Ryan Lowe . [pdf] [code]

Les grands modèles de langue sont des raisonneurs à tirs zéro . Preprint 2022.6

Takeshi Kojima, Shixiang Shane Gu, Machel Reid, Yutaka Matsuo, Yusuke Iwasawa . [pdf] [code]

Question vidéo zéro-shot répondant via des modèles de langage bidirectionnel gelé . Preprint 2022.6

Antoine Yang, Antoine Miech, Josef Sivic, Ivan Laptev, Cordelia Schmid . [pdf] [code]

Les modèles de langue sont des interfaces à usage général . Preprint 2022.6

Yaru Hao, Haoyu Song, Li Dong, Shaohan Huang, Zewen Chi, Wenhui Wang, Shuming MA, Furu Wei . [pdf] [code]

Génération d'un invite au niveau du référentiel pour les modèles de code de grande langue. Preprint 2022.6

Disha Shrivastava, Hugo Larochelle, Daniel Tarlow [PDF] [Code], 2022.6

Ignorez l'invite précédente: Techniques d'attaque pour les modèles de langue. Best Paper Award @ Neirips ML Safety Workshop 2022.

Fábio Perez, Ian Ribeiro [PDF] [Projet], 2022.11

Les modèles de langue sont des apprenants à quelques tirs. Neirips 2020

Tom B. Brown, Benjamin Mann, Nick Ryder, Melanie Subbiah, Jared Kaplan, Prafulla Dhariwal, Arvind Neelakantan, Pranav Shyam, Girish Sastry, Amanda Askel Ramesh, Daniel M. Ziegler, Jeffrey Wu, Clemens Winter, Christopher Hesse, Mark Chen, Eric Sigler, Mateusz Litwin, Scott Gray, Benjamin Chess, Jack Clark, Christopher Berner, Sam McCandlish, Alec Radford, Ilya Sutskever, Dario Amodei . [PDF]

Calibrer avant utilisation: améliorer les performances à quelques coups des modèles de langage . ICML 2021

Tony Z. Zhao, Eric Wallace, Shi Feng, Dan Klein, Sameer Singh . [pdf] [code]

Une explication de l'apprentissage dans le contexte comme une inférence bayésienne implicite . ICLR 2022

Sang Michael Xie, Aditi Raghunathan, Percy Liang, Tengyu MA . [pdf] [code]

Chaîne de réflexion suscitant un raisonnement dans des modèles de grande langue . Preprint 2022.1

Jason Wei, Xuezhi Wang, Dale Schuurmans, Maarten Bosma, Brian Ichter, Fei Xia, Ed Chi, Quoc LE, Denny Zhou . [PDF]

Généralisation des tâches croisées via des instructions de crowdsourcing en langage naturel . ACL 2022

Swaroop Mishra, Daniel Khashabi, Chitta Baral, Hannaneh Hajishirzi . [pdf] [code]

Invites fantastiquement commandées et où les trouver: surmonter la sensibilité à quelques coups d'ordre invite . ACL 2022

Yao Lu, Max Bartolo, Alastair Moore, Sebastian Riede, Pontus Stenetorp . [PDF]

Modèle de langage de la canne bruyante Invitation pour la classification du texte à quelques coups . ACL 2022

Sewon Min, Mike Lewis, Hannaneh Hajishirzi, Luke Zettlemoyer . [pdf] [code]

Méta-apprentissage via le réglage du modèle de langue dans le contexte . ACL 2022

Yanda Chen, Ruiqi Zhong, Sheng Zha, George Karypis, il . [pdf] [code]

Qu'est-ce qui fait de bons exemples dans le contexte pour GPT-3? Deelio @ ACL 2022

Jichang Liu, Dinghan Shen, Yizhe Zhang, Bill Dolan, Lawrence Carin, Weizhu Chen . [PDF]

Apprendre à récupérer des invites à l'apprentissage dans le contexte . NAACL 2022

Ohad Rubin, Jonathan Herzig, Jonathan Berant . [pdf] [code]

Metaicl: Apprendre à apprendre dans le contexte . NAACL 2022

Sewon Min, Mike Lewis, Luke Zettlemoyer, Hannaneh Hajishirzi . [pdf] [code]

Amélioration de l'apprentissage à quelques tirs dans le contexte via une formation auto-supervisée . NAACL 2022

Mingda Chen, Jingfei Du, Ramakanth Pasunuru, Todor Mihaylov, Srini Iyer, Veselin Stoyanov, Zornitsa Kozareva . [PDF]

Apprentissage auto-généré dans le contexte: Tire en tirant des modèles de langage auto-régressifs en tant que générateur de démonstration . Lplm @ naacl 2022

Hyuhng Joon Kim, Hyunsoo Cho, Junyeob Kim, Taeuk Kim, Kang Min Yoo, Sang-Goo Lee . [PDF]

Repenser le rôle des démonstrations: qu'est-ce qui fait du travail d'apprentissage en contexte? Preprint 2022.2

Sewon Min, Xinxi Lyu, Ari Holtzman, Mikel Artetxe, Mike Lewis, Hannaneh Hajishirzi, Luke Zettlemoyer . [pdf] [code]

Apprentissage dans le contexte pour le suivi de l'état de dialogue à quelques coups. Préimpression 2022.3

Yushi Hu, Chia-Hsuan Lee, Tianbao Xie, Tao Yu, Noah A. Smith, Mari Ostendorf . [pdf] [code]

L'auto-cohérence améliore le raisonnement de la chaîne de pensée dans les modèles de langues . Préimpression 2022.3

Xuezhi Wang, Jason Wei, Dale Schuurmans, Quoc LE, Ed Chi, Denny Zhou . [PDF]

Star: Raisonnement de raisonnement autodidacte Raisonnement avec raisonnement . Préimpression 2022.3

Eric Zelikman, Yuhuai Wu, Noah D. Goodman . [PDF]

Benchmarking Generalization via des instructions en contexte sur plus de 1 600 tâches de langue . Préimpression 2022.4

Yizhong Wang, Swaroop Mishra, Pegah Alipoormolabashi, Yeganeh Kordi, Amirreza Mirzaei, Anjana Arunkumar, Arjun Ashok, Arut Selvan Dhanasekaran, Atharva Naik, David Stap, Eshaan Pathak, Giannis Karamanolakis, Haizhi Gary Lai, Ishan, Karamand Ishani Mondal, Jacob Anderson, Kirby Kuznia, Krima Doshi, Maitreya Patel, Kuntal Kumar Pal, Mehrad Moradshahi, Mihir Parmar, Mirali Purohit, Neeraj Varshney, Phani Rohitha Kaza, Pulki Verma, Ravsehaj Singh Purri, Rushang Karia, Shailaa Sampat, Savan Doshi, Siddhartha Mishra, Sujan Reddy, Sumanta Patro, Tanay Dixit, Xudong Shen, Chitta Baral, Yejin Choi, Noah A. Smith, Hannaneh Hajishirzi, Daniel Khashabi . [pdf] [code]

Les modèles linguistiques peuvent-ils apprendre des explications en contexte? . Préimpression 2022.4

Andrew K. Lampinen, Ishita Dasgupta, Stephanie Cy Chan, Kory Matthewson, Michael Henry Tessler, Antonia Creswell, James L. McClelland, Jane X. Wang, Felix Hill . [PDF]

Les étiquettes au sol sont importantes: un regard plus profond sur les démonstrations de marque-étiquette . Preprint 2022.5

Junyeob Kim, Hyuhng Joon Kim, Hyunsoo Cho, Hwiyeol Jo, Sang-woo Lee, Sang-Goo Lee, Kang Min Yoo, Taeuk Kim . [PDF]

Le manque de fiabilité des explications dans l'apprentissage en petit-contexte . Preprint 2022.5

Xi ye, Greg Durrett . [PDF]

La moindre incitation la plus importante permet un raisonnement complexe dans les modèles de grande langue . Preprint 2022.5

Denny Zhou, Nathanael Schärli, Le Hou, Jason Wei, Nathan Scales, Xuezhi Wang, Dale Schuurmans, Olivier Bousquet, Quoc Le, Ed Chi . [PDF]

Invite maieutique: raisonnement logiquement cohérent avec des explications récursives . Preprint 2022.5

Jaehun Jung, Lianhui Qin, Sean Welleck, Faeze Brahman, Chandra Bhagavatula, Ronan le Bras, Yejin Choi . [PDF]

À l'avance de faire de modèles de langue de meilleurs raisonneurs . Preprint 2022.6

Yifei Li, Zeqi Lin, Shizhuo Zhang, Qiang Fu, Bei Chen, Jian-Guang Lou, Weizhu Chen . [pdf] [code]

Capacités émergentes des modèles de grande langue . Preprint 2022.6

Jason Wei, Yi Tay, Rishi Bommasani, Colin Raffel, Barret Zoph, Sebastian Borgeaud, Dani Yogatama, Maarten Bosma, Denny Zhou, Donald Metzler, Ed H. Chi, Tatsunori Hashimoto, Oriol Vinyals, Percy Liang, Jeff Dean, William Fedus . [PDF]

Les modèles de langue sont des interfaces à usage général . Preprint 2022.6

Yaru Hao, Haoyu Song, Li Dong, Shaohan Huang, Zewen Chi, Wenhui Wang, Shuming MA, Furu Wei . [pdf] [code]

Que peuvent apprendre les transformateurs dans le contexte? Une étude de cas de classes de fonctions simples . Preprint 2022.8

Shivam Garg, Dimitris Tsipras, Percy Liang, Gregory Valiant . [pdf] [code]

Apprendre par le contexte distillant . Preprint 2022.9

Charlie Snell, Dan Klein, Ruiqi Zhong . [PDF]

Modèles de langue de liaison dans les langues symboliques . Preprint 2022.10

Zhoujun Cheng *, Tianbao Xie *, Peng Shi, Chengzu Li, Rahul Nadkarni, Yushi Hu, Caiming Xiong, Dragomir Radev, Mari Ostendorf, Luke Zettlemoyer, Noah A. Smith, Tao Yu . [PDF] [Code] [Site Web]

Préserver la capacité d'apprentissage dans le contexte dans le modèle de réglage du modèle de grande langue . Préimpression 2022.11

Yihan Wang, SI SI, DALIANG LI, Michal Lukasik, Felix Yu, Cho-Jui Hsieh, Inderjit S Dhillon, Sanjiv Kumar . [PDF]

Enseignement du raisonnement algorithmique via l'apprentissage en contexte . Préimpression 2022.11

Hattie Zhou, Azade Nova, Hugo LaRochelle, Aaron Courville, Behnam Neyshabur, Hanie Sedghi . [PDF]

Quel algorithme d'apprentissage est l'apprentissage en contexte? Investigations avec des modèles linéaires . Préimpression 2022.11

Ekin Akyürek, Dale Schuurmans, Jacob Andreas, Tengyu MA, Denny Zhou . [PDF]

Digne-boîte noire pour le modélisation de la langue en tant que service . ICML 2022

Tianxiang Sun, Yunfan Shao, Hong Qian, Xuanjing Huang, Xipeng Qiu. [pdf] [code]

Apprentissage rapide de la boîte noire pour les modèles de langue pré-formés . TMLR 2023.2

Shizhe Dioo, Xuechun Li, Yong Lin, Zhichao Huang, Tong Zhang . [PDF]

GRIPS: Recherche d'instructions sans gradient et basée sur l'édition pour inviter de grands modèles de langue . Préimpression 2022.3

Archiki Prasad, Peter Hase, Xiang Zhou, Mohit Bansal . [pdf] [code]

Invitant à quelques coups vers la génération de réponse contrôlable . Preprint 2022.6

Hsuan Su, Pohan Chi, Shih-Cheng Huang, Chung Ho Lam, Saurav Sahay, Shang-Tse Chen, Hung-Yi Lee . [PDF]

BBTV2: Vers un avenir sans dégradé avec de grands modèles de langue . EMNLP 2022

Tianxiang Sun, Zhengfu He, Hong Qian, Yunhua Zhou, Xuanjing Huang, Xipeng Qiu . [pdf] [code]

RLPrompt: Optimisation des invites de texte discrètes avec apprentissage par renforcement . EMNLP 2022

Mingkai Deng, Jianyu Wang, Cheng-Ping Hsieh, Yihan Wang, Han Guo, Tianmin Shu, Meng Song, Eric P. Xing, Zhiting Hu . [pdf] [code]

Taune à clip: vers un apprentissage rapide sans dérivé avec un mélange de récompenses . Résultats de l'EMNLP 2022

Yekun Chai, Shuohuan Wang, Yu Sun, Hao Tian, Hua Wu, Haifeng Wang . [PDF]

Tempera: Édition rapide du temps de test via l'apprentissage du renforcement . Préimpression 2022.11

Tianjun Zhang, Xuezhi Wang, Denny Zhou, Dale Schuurmans, Joseph E. Gonzalez. [pdf] [code]

PromptBoosting: Classification de texte noir avec dix passes avant . Preprint 2022.12

Bairu Hou, Joe O'Connor, Jacob Andreas, Shiyu Chang, Yang Zhang . [PDF]

Pré-formation multitâche de l'invite modulaire pour l'apprentissage chinois à quelques coups . ACL 2023

Tianxiang Sun, Zhengfu He, Qin Zhu, Xipeng Qiu, Xuanjing Huang . [PDF]

Lorsque la descente de gradient rencontre l'optimisation sans dérivée: une correspondance faite dans le scénario de la boîte noire . ACL 2023

Chengcheng Han, Liqing Cui, Renyu Zhu, Jianing Wang, Nuo Chen, Qiushi Sun, Xiang Li, Ming Gao . [PDF]

Faire un réglage de la boîte noire basée sur un coloré: augmentation de la généralisation du modèle à partir de trois perspectives orthogonales . LREC-COLING 2024

Qiushi Sun, Chengcheng Han, Nuo Chen, Renyu Zhu, Jingyang Gong, Xiang Li, Ming Gao . [PDF]

Pour régler ou ne pas régler? Adapter des représentations pré-étirées à diverses tâches . Rep4nlp @ ACL 2019

Matthew E. Peters, Sebastian Ruder, Noah A. Smith . [PDF]

Les explications peuvent-elles être utiles pour calibrer les modèles de boîtes noires? ACL 2022

Xi ye, Greg Durrett . [pdf] [code]

Le co-formation améliore l'apprentissage basé sur des modèles de grandes langues . ICML 2022

Hunter Lang, Monica Agrawal, Yoon Kim, David Sontag . [PDF]

Tuning y: un paradigme de réglage efficace pour les modèles pré-formés à grande échelle via l'apprentissage de la représentation d'étiquette . Preprint 2022.2

Yitao Liu, Chenxin AN, Xipeng Qiu . [PDF]

LST: échec de l'échelle pour le paramètre et l'apprentissage du transfert efficace de la mémoire . Neirips 2022

Yi-lin chanté, Jaemin Cho, Mohit Bansal . [pdf] [code]

Taponnage du décodeur: compréhension efficace du langage comme décodage . Preprint 2022.12

Ganqu Cui, Wentao Li, Ning Ding, Longtao Huang, Zhiyuan Liu, Maosong Sun. [PDF]

Génération d'ensembles de données avec des modèles de langue pré-étendue . EMNLP 2021

Timo Schick, Hinrich Schütze . [pdf] [code]

GPT3MIX: tirant parti des modèles de langue à grande échelle pour l'augmentation du texte . Résultats de l'EMNLP 2021

Kang Min Yoo, Dongju Park, Jaewook Kang, Sang-woo Lee, Woomyeong Park . [pdf] [code]

Généré des connaissances provoquant un raisonnement de bon sens . ACL 2022

Jiacheng Liu, Alisa Liu, Ximing Lu, Sean Wheleck, Peter West, Ronan Le Bras, Yejin Choi, Hannaneh Hajishirzi . [pdf] [code]

Zerogen: apprentissage efficace de tirs zéro via la génération de jeux de données . EMNLP 2022

Jiacheng Ye, JiaHui Gao, Qintong Li, Hang Xu, Jiangtao Feng, Zhiyong Wu, Tao Yu, Lingpeng Kong . [pdf] [code]

Zerogen +: Génération de données autoguidée de haute qualité dans un apprentissage zéro efficace . Preprint 2022.2

JiaHUi Gao, Renjie PI, Yong Lin, Hang Xu, Jiacheng Ye, Zhiyong Wu, Xiaodan Liang, Zhenguo Li, Lingpeng Kong . [PDF]

Auges: Augmentation du dialogue avec de grands modèles de langue pour la conversation de soutien émotionnel . Résultats de l'ACL 2023

Chujie Zheng, Sahand Sabour, Jiaxin Wen, Zheng Zhang, Minlie Huang . [PDF]

Génération de données de formation avec les modèles de langage: vers une compréhension du langage zéro-shot . Neirips 2022

Yu Meng, Jiaxin Huang, Yu Zhang, Jiawei Han [PDF] [Code]

?? Tout d'abord, merci d'avoir pris le temps de contribuer! ??

Étapes pour contribuer:

PaperNumber en haut de la page en conséquence et soumettez votre demande de traction. Nous vous recommandons d'expliquer une très brève explication pourquoi vous pensez qu'un article devrait être ajouté ou modifié.Ne vous inquiétez pas si vous mettez quelque chose de mal, nous les réparerons pour vous. Contribuez et faites la promotion de votre travail formidable ici!

En plus des contributeurs suivants qui ont soumis des demandes de traction, nous tenons également à remercier Ohad Rubin et Kang Min Yoo pour avoir recommandé des papiers.