Détection du texte généré à partir de modèles de grands langues (par exemple GPT-2).

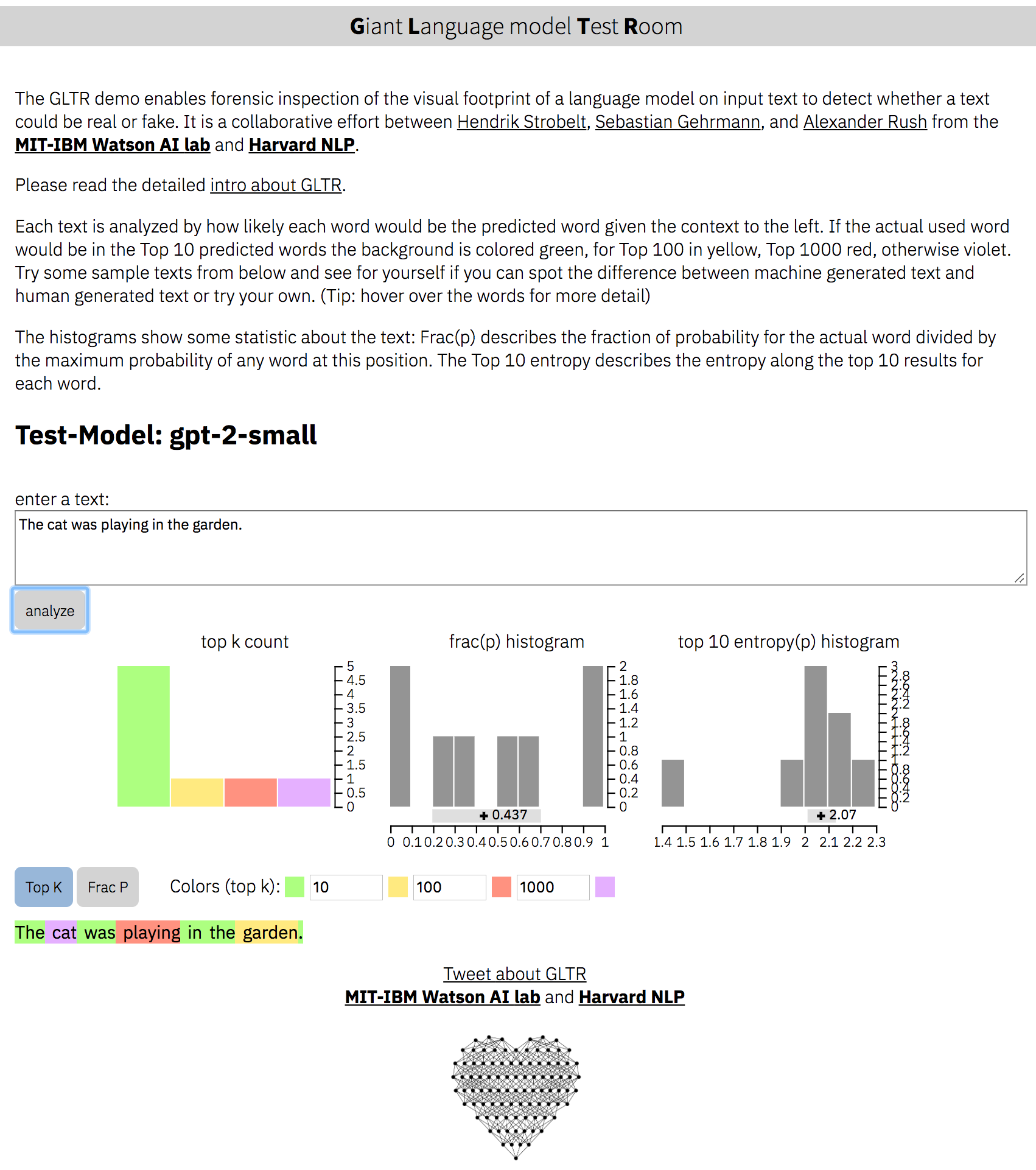

page Web: http://gltr.io

en ligne-démo: http://gltr.io/dist/index.html

Papier: https://arxiv.org/abs/1906.04043

Un projet de Hendrik Strobelt, Sebastian Gehrmann, Alexander M. Rush.

Collaboration de MIT-IBM Watson AI Lab et Harvardnlp

Installez les dépendances pour Python> 3,6:

pip install -r requirements.txt Exécutez le serveur pour gpt-2-small :

python server.py

L'instance de démonstration s'exécute maintenant sur http: // localhost: 5001 / client / index.html

Démarrez le serveur pour BERT :

python server.py --model BERT L'instance s'exécute maintenant sur http: // localhost: 5001 / client / index.html? nodemo. Astuce: nous ne fournissons que des textes de démonstration pour gpt2-small .

usage: server.py [-h] [--model MODEL] [--nodebug NODEBUG] [--address ADDRESS]

[--port PORT] [--nocache NOCACHE] [--dir DIR] [--no_cors]

optional arguments:

-h, --help show this help message and exit

--model MODEL choose either 'gpt-2-small' (default) or 'BERT' or your own

--nodebug NODEBUG server in non-debugging mode

--port PORT port to launch UI and API (default:5001)

--no_cors launch API without CORS support (default: False)

Le backend définit un certain nombre d'API modèle qui peut être invoqué par le serveur en le démarrant avec le --model NAME . Pour ajouter un modèle personnalisé, vous devez écrire votre propre API dans backend/api.py et ajouter le décorateur @register_api(name=NAME) .

Chaque API doit être une classe qui hérite de AbstractLanguageChecker , qui définit deux fonctions check_probabilities et postprocess . Veuillez suivre la documentation dans api.py lors de l'implémentation de la classe et des fonctions.

Le code source de la frontale est dans client/src .

Pour modifier, l'installation des dépendances de nœuds est nécessaire:

cd client/src ; npm install ; cd ../..Recompilation de la frontale:

> rm -rf client/dist ; cd client/src/ ; npm run build ; cd ../..Apache 2

(c) 2019 par Hendrik Strobelt, Sebastian Gehrmann, Alexander M. Rush