Avez-vous postulé à l'accès à l'API GPT-4, mais Openai est trop occupé pour répondre ? Moi aussi, c'est pourquoi j'ai créé ce package. Il utilise Selenium WebDriver pour imiter l'interaction des utilisateurs sur Chat.openai.com. Si le compte a ChatGPT Plus , le pilote utilisera GPT-4 , sinon il utilisera le GPT-3.5 par défaut.

Il prend en charge à la fois le navigateur GPT4, Dall-E 3 et les plugins en sélectionnant le modèle via GPT4OpenAI(token=token, model='gpt-4') , ou model='gpt-4-plugins' .

Remarque: Cette bibliothèque API non officielle n'est pas approuvée par OpenAI et viole leurs conditions de service. Utilisez-le à vos risques et périls; Le Créateur n'assume aucune responsabilité pour toute conséquence. Veuillez respecter les TO de Platform et faire preuve de prudence avec des ressources non officielles.

La logique de base a été tirée de l'intelligenzaartificiale / free-auto-gpt.

from gpt4_openai import GPT4OpenAI

# Token is the __Secure-next-auth.session-token from chat.openai.com

llm = GPT4OpenAI ( token = my_session_token , headless = False , model = 'gpt-4' )

# GPT3.5 will answer 8, while GPT4 should be smart enough to answer 10

response = llm ( 'If there are 10 books in a room and I read 2, how many books are still in the room?' )

print ( response )Ce code a été utilisé pour la démonstration GIF ci-dessus.

from gpt4_openai import GPT4OpenAI

llm = GPT4OpenAI ( token = my_session_token , headless = False ,

model = 'gpt-4' # DALL-E 3 only works with gpt-4

)

img_bytes = llm . generate_image ( 'Generate an isometric image of a cute doggo inside a house.' , image_path = './img_save_path.png' ) from gpt4_openai import GPT4OpenAI

# Token is the __Secure-next-auth.session-token from chat.openai.com

llm = GPT4OpenAI ( token = my_session_token , headless = False , model = 'gpt-4-browsing' )

# ChatGPT will first browse the web for the name/age of her boyfriend, then return the answer

response = llm ( 'What is the age difference between Dua Lipa and her boyfriend?' )

print ( response ) GPT4OpenAI étend en fait la classe LLM de langchain.llms.base . Vous pouvez donc facilement utiliser cette bibliothèque à l'intérieur de l'écosystème de Langchain. Exemple:

from gpt4_openai import GPT4OpenAI

from langchain import LLMChain

from langchain . prompts . chat import ( ChatPromptTemplate , SystemMessagePromptTemplate , AIMessagePromptTemplate , HumanMessagePromptTemplate )

template = "You are a helpful assistant that translates english to pirate."

system_message_prompt = SystemMessagePromptTemplate . from_template ( template )

example_human = HumanMessagePromptTemplate . from_template ( "Hi" )

example_ai = AIMessagePromptTemplate . from_template ( "Argh me mateys" )

human_message_prompt = HumanMessagePromptTemplate . from_template ( "{text}" )

chat_prompt = ChatPromptTemplate . from_messages ([ system_message_prompt , example_human , example_ai , human_message_prompt ])

# Token is the __Secure-next-auth.session-token from chat.openai.com

llm = GPT4OpenAI ( token = my_session_token )

chain = LLMChain ( llm = llm , prompt = chat_prompt )

print ( chain . run ( "My name is John and I like to eat pizza." ))La sortie sera:

AI: Ahoy, me name be John an' I be likin' ta feast on some pizza, arr!

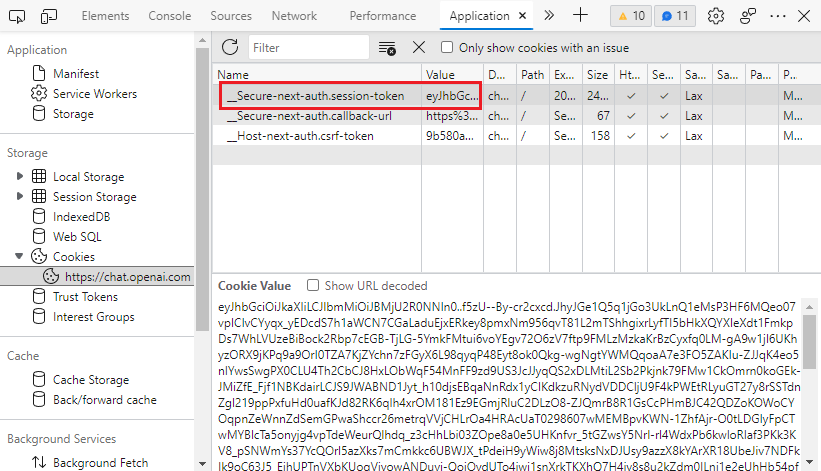

F12 .__Secure-next-auth.session-token dans Application > Storage > Cookies > https://chat.openai.com .Cookie Value .

Initialement, j'ai essayé Poe.com (API privée implémentée sur GPT4FREE), mais j'ai remarqué que la fenêtre de contexte d'entrée est plus petite que celle d'Openai Chatgpt. Et il en va de même pour le GPT4 de Bing.

Pour installer ce package Python, exécutez la commande suivante:

pip install gpt4-openai-apiCes dépendances sont téléchargées directement:

undetected-chromedriver (navigateur de sélénium)markdownifylangchain