L'éditeur de Downcodes a appris que Hugging Face a publié aujourd'hui SmolLM2, une série de modèles de langage compacts impressionnants en termes de performances et nécessitant beaucoup moins de ressources informatiques que les grands modèles. C'est sans aucun doute une bonne nouvelle pour les développeurs qui souhaitent déployer des applications d'IA sur des appareils aux ressources limitées. SmolLM2 est publié sous la licence Apache 2.0 et fournit trois modèles avec des tailles de paramètres différentes, qui peuvent être adaptées de manière flexible à divers scénarios d'application.

Hugging Face a publié aujourd'hui SmolLM2, un nouvel ensemble de modèles de langage compacts qui atteignent des performances impressionnantes tout en nécessitant beaucoup moins de ressources de calcul que les modèles plus grands. Le nouveau modèle est publié sous la licence Apache 2.0 et est disponible en trois tailles - paramètres 135M, 360M et 1,7B - adaptées au déploiement sur les smartphones et autres appareils Edge avec une puissance de traitement et une mémoire limitées.

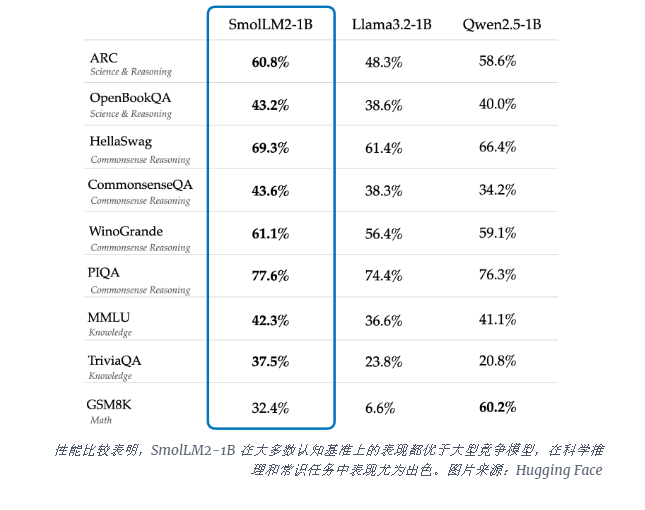

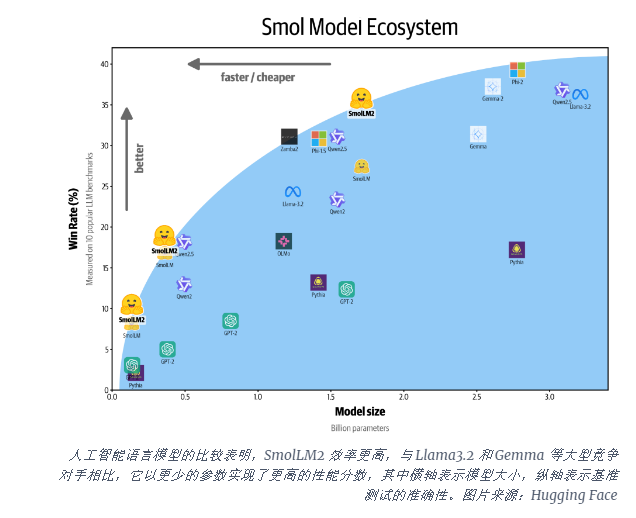

Le modèle SmolLM2-1B surpasse le modèle Llama1B de Meta dans plusieurs tests clés, particulièrement performant sur le raisonnement scientifique et les tâches de bon sens. Le modèle surpasse les grands modèles concurrents sur la plupart des critères cognitifs, en utilisant une combinaison diversifiée d'ensembles de données, notamment FineWeb-Edu et des ensembles de données spécialisés en mathématiques et en codage.

La sortie de SmolLM2 arrive à un moment critique alors que l'industrie de l'IA est aux prises avec les exigences informatiques liées à l'exécution de grands modèles de langage (LLM). Alors que des entreprises comme OpenAI et Anthropic continuent de repousser les limites de l’échelle des modèles, on reconnaît de plus en plus le besoin d’une IA efficace et légère, capable de s’exécuter de manière native sur l’appareil.

SmolLM2 propose une approche différente pour intégrer de puissantes capacités d'IA directement dans les appareils personnels, ouvrant la voie à un avenir où les outils d'IA avancés seront disponibles pour davantage d'utilisateurs et d'entreprises, et pas seulement pour les géants de la technologie dotés de centres de données massifs. Ces modèles prennent en charge une gamme d'applications, notamment la réécriture de texte, la synthèse et l'appel de fonctions, et conviennent au déploiement dans des scénarios où les contraintes de confidentialité, de latence ou de connectivité rendent les solutions d'IA basées sur le cloud peu pratiques.

Même si ces modèles plus petits présentent encore des limites, ils s’inscrivent dans une tendance plus large vers des modèles d’IA plus efficaces. La sortie de SmolLM2 montre que l'avenir de l'intelligence artificielle n'appartient peut-être pas seulement à des modèles de plus en plus grands, mais à des architectures plus efficaces capables de fournir des performances puissantes avec moins de ressources.

L'émergence de SmolLM2 offre de nouvelles possibilités pour le développement d'applications d'IA légères et indique également que la technologie d'IA deviendra plus populaire et profitera à davantage d'utilisateurs. L'éditeur de Downcodes estime que des modèles d'IA plus efficaces et à faible consommation de ressources apparaîtront à l'avenir pour promouvoir le développement de la technologie de l'intelligence artificielle.