Ini adalah daftar makalah "model-model-as-a-service (lmaaS)", yang terutama dikelola oleh Tianxiang Sun. Kami sangat mendorong para peneliti NLP yang tertarik dengan topik ini untuk membuat permintaan tarik untuk menambah atau memperbarui makalah (lihat Kontribusi). Tonton repositori ini untuk pembaruan terbaru!

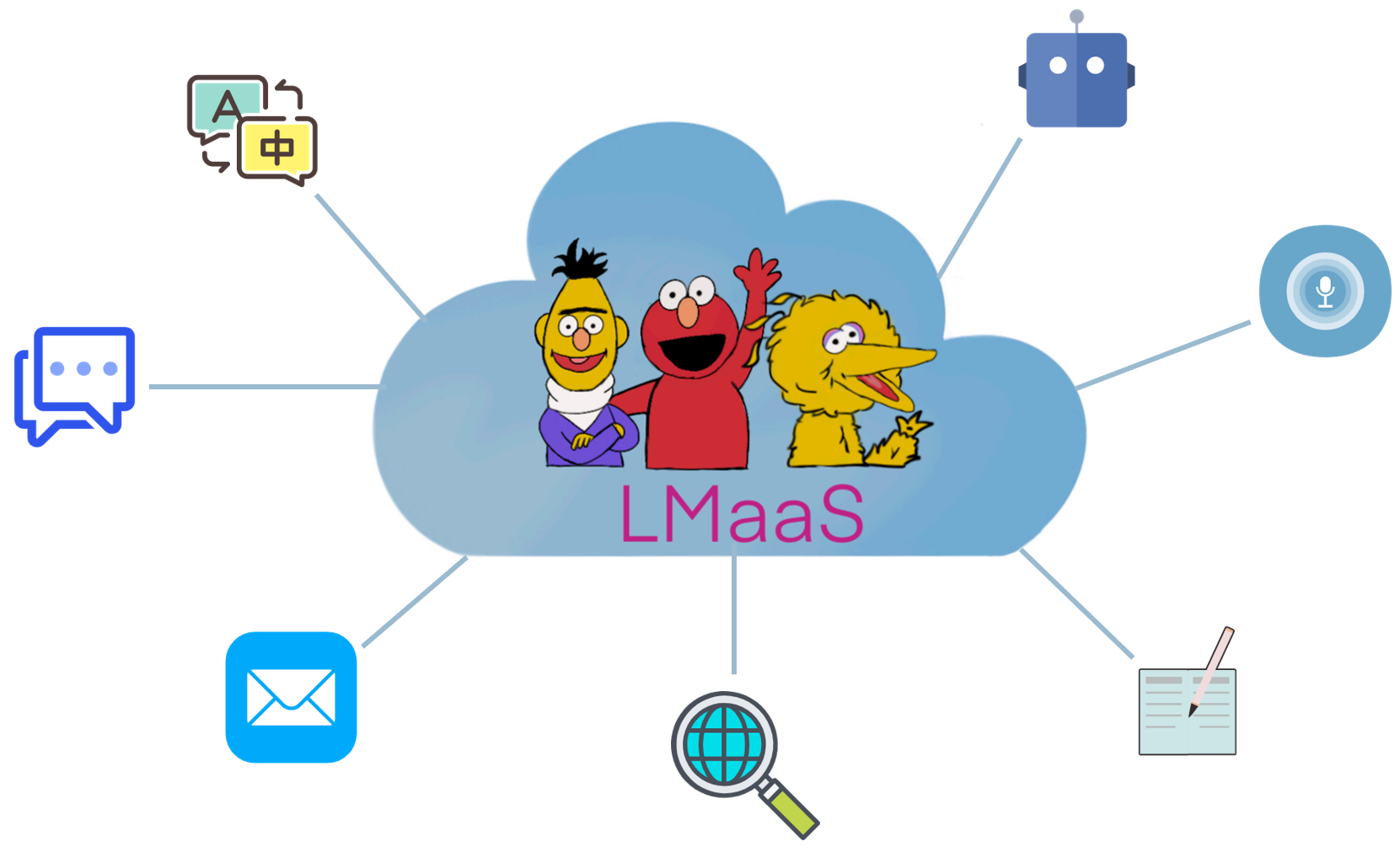

Karena alasan komersial dan biaya penyetelan yang mahal, model bahasa besar (LLM) pra-terlatih seperti GPT-3 biasanya dirilis sebagai layanan alih-alih bobot model sumber terbuka. Kami menyebut skenario ini " bahasa-model-as-a-service (LMAAS) " (istilah ini awalnya digunakan dalam kertas ICML'2022 kami). Dalam skenario seperti itu, pengguna dapat mengakses LLM yang kuat melalui API inferensi mereka. Layanan LLMS telah mendukung banyak kasus penggunaan (lihat demo GPT-3). Berbeda dengan penyempurnaan, LMAAS memungkinkan satu tujuan umum LLM untuk melayani berbagai tugas dan oleh karena itu sangat efisien penempatan. Namun demikian, cara mengadaptasi LLMS untuk menargetkan tugas tanpa akses ke parameter dan gradien mereka adalah sebuah tantangan. Untuk membuat LLM menguntungkan khalayak yang lebih luas, kami mengumpulkan makalah yang cocok dengan skenario ini untuk memfasilitasi penelitian di masa depan.

Makalah mana yang cocok dengan skenario LMAAS? Kami terutama mempertimbangkan makalah yang beradaptasi dengan tugas hilir tanpa mengakses parameter model dan gradien. Meskipun LLM yang disesuaikan juga dapat menjadi layanan setelah penyebaran, mereka terbatas untuk menyelesaikan satu tugas untuk audiens yang terbatas. Dalam ruang lingkup kami, kami lebih suka melayani model tujuan umum untuk berbagai pengguna.

Dalam literatur yang ada, ada beberapa jalur penelitian yang cocok dengan LMAAS:

Batas antara pembelajaran teks prompt dan in-context agak kabur. Dalam repo ini, kategori prompt teks berisi makalah yang tidak menggunakan sampel berlabel, sedangkan kategori pembelajaran dalam konteks terdiri dari makalah yang mencakup sampel berlabel dalam petunjuk.

Catatan: Topik terkait (dan tumpang tindih sebagian) adalah pembelajaran berbasis prompt , yang bertujuan untuk menyelesaikan tugas hilir menggunakan LLMs tujuan umum dengan mengonversi input dan output dengan beberapa templat dan verbalizer, masing-masing. Namun, sebagian besar pekerjaan dalam pembelajaran berbasis cepat memerlukan akses ke parameter model dan gradien, dan karenanya tidak cocok dengan ruang lingkup kami. Untuk kertas pembelajaran berbasis prompt yang tidak cocok untuk LMAAS, kami sarankan berkontribusi pada daftar kertas mengagumkan lainnya: promptpaper.

Dibandingkan dengan LLM khusus tugas yang menyempurnakan, LMAAS memiliki keunggulan berikut:

Singkatan dari pekerjaan.

Fitur utama dari karya tersebut.

Pengaturan eksperimental utama pekerjaan.

Model bahasa sebagai basis pengetahuan? EMNLP 2019

Fabio Petroni, Tim Rocktäschel, Patrick Lewis, Anton Bakhtin, Yuxiang Wu, Alexander H. Miller, Sebastian Riedel . [pdf] [kode]

Bagaimana kita bisa tahu model bahasa apa yang tahu? TACL 2020

Zhengbao Jiang, Frank F. Xu, Jun Araki, Graham Neubig . [pdf] [kode]

Model bahasa adalah pelajar beberapa shot. Neurips 2020

Tom B. Brown, Benjamin Mann, Nick Ryder, Melanie Subbiah, Jared Kaplan, Prafulla Dhariwal, Arvind Neelakantan, Pranav Shyam, Girish Sastry, Amanda Askell, Sandhini Agarwal, Ariel Herbert-Voss, Gretchen Krueger, Tom Henighan, Rewon Child, Aditya Ramesh, Daniel M. Ziegler, Jeffrey Wu, Clemens Winter, Christopher Hesse, Mark Chen, Eric Sigler, Mateusz Litwin, Scott Grey, Benjamin Chess, Jack Clark, Christopher Berner, Sam McCandlish, Alec Radford, Elya Sutskever, Dario Amodei . [PDF]

Mengadaptasi model bahasa untuk pembelajaran zero-shot dengan meta tuning pada dataset dan koleksi cepat . Temuan EMNLP 2021

Ruiqi Zhong, Kristy Lee, Zheng Zhang, Dan Klein . [pdf] [kode]

Model bahasa finetuned adalah pelajar zero-shot . ICLR 2022

Jason Wei, Maarten Bosma, Vincent Y. Zhao, Kelvin Guu, Adams Wei Yu, Brian Lester, Nan Du, Andrew M. Dai, Quoc V. Le . [pdf] [kode]

Multitask memicu pelatihan memungkinkan generalisasi tugas zero-shot . ICLR 2022

Victor Sanh, Albert Webson, Colin Raffel, Stephen H. Bach, Lintang Sutawika, Zaid Alyafeai, Antoine Chaffin, Arnaud Stiegler, Teven Le Scao, Arun Raja, Manan Dey, M Saiful Bari, Canwen Xu, Urmish Thakker, Shanya Sharma Sharma, Eliza Szczechla, Taewoon Kim, Gunjan Chhablani, Nihal Nayak, Debajyoti Datta, Jonathan Chang, Mike Tian-Jian Jiang, Han Wang, Matteo Manica, Sheng Shen, Zheng Xin Yong, Harshit Pandey, Rachel Bawden, Thomas Wang, Trishala Neeraj, Jos Rozen, Abheesht Sharma, Andrea Santilli, Thibault Fevry, Jason Alan Fries, Ryan Teehan, Tali Bers, Stella Biderman, Leo Gao, Thomas Wolf, Alexander M. Rush . [pdf] [kode]

Melatih model bahasa untuk mengikuti instruksi dengan umpan balik manusia . Pracetak 2022.3

Long Ouyang, Jeff Wu, Xu Jiang, Diogo Almeida, Carroll L. Wainwright, Pamela Mishkin, Chong Zhang, Sandhini Agarwal, Katarina Slama, Alex Ray, John Schulman, Jacob Hilton, Fraser Kelton, Luke Miller, Maddie Simens, Amanda Askell, Peter Welinder, Paul Christiano, Jan Leike, Ryan Lowe . [pdf] [kode]

Model bahasa besar adalah alasan nol-shot . Pracetak 2022.6

Takeshi Kojima, Shixiang Shane Gu, Machel Reid, Yutaka Matsuo, Yusuke Iwasawa . [pdf] [kode]

Pertanyaan video nol-shot menjawab melalui model bahasa dua kali lipat beku . Pracetak 2022.6

Antoine Yang, Antoine Miech, Josef Sivic, Ivan Laptev, Cordelia Schmid . [pdf] [kode]

Model bahasa adalah antarmuka tujuan umum . Pracetak 2022.6

Yaru Hao, Lagu Haoyu, Li Dong, Shaohan Huang, Zewen Chi, Wenhui Wang, Shuming Ma, Furu Wei . [pdf] [kode]

Generasi Prompt Tingkat Repositori untuk Model Kode Bahasa Besar. Pracetak 2022.6

Disha Shrivastava, Hugo Larochelle, Daniel Tarlow [PDF] [kode], 2022.6

Abaikan prompt sebelumnya: Teknik serangan untuk model bahasa. Penghargaan Kertas Terbaik @ Neurips ML Safety Workshop 2022.

Fábio Perez, Ian Ribeiro [PDF] [Proyek], 2022.11

Model bahasa adalah pelajar beberapa shot. Neurips 2020

Tom B. Brown, Benjamin Mann, Nick Ryder, Melanie Subbiah, Jared Kaplan, Prafulla Dhariwal, Arvind Neelakantan, Pranav Shyam, Girish Sastry, Amanda Askell, Sandhini Agarwal, Ariel Herbert-Voss, Gretchen Krueger, Tom Henighan, Rewon Child, Aditya Ramesh, Daniel M. Ziegler, Jeffrey Wu, Clemens Winter, Christopher Hesse, Mark Chen, Eric Sigler, Mateusz Litwin, Scott Grey, Benjamin Chess, Jack Clark, Christopher Berner, Sam McCandlish, Alec Radford, Elya Sutskever, Dario Amodei . [PDF]

Kalibrasi Sebelum digunakan: Meningkatkan beberapa kinerja model bahasa . ICML 2021

Tony Z. Zhao, Eric Wallace, Shi Feng, Dan Klein, Sameer Singh . [pdf] [kode]

Penjelasan pembelajaran dalam konteks sebagai inferensi Bayesian implisit . ICLR 2022

Sang Michael Xie, Aditi Raghunathan, Percy Liang, Tengyu MA . [pdf] [kode]

Rantai pemikiran yang mendorong memunculkan penalaran dalam model bahasa besar . Pracetak 2022.1

Jason Wei, Xuezhi Wang, Dale Schuurmans, Maarten Bosma, Brian Ichter, Fei Xia, Ed Chi, Quoc LE, Denny Zhou . [PDF]

Generalisasi silang melalui instruksi crowdsourcing bahasa alami . ACL 2022

Swaroop Mishra, Daniel Khashabi, Chitta Baral, Hananeh Hajishirzi . [pdf] [kode]

Permohonan yang dipesan secara fantastis dan di mana menemukannya: mengatasi sensitivitas pesanan cepat beberapa tembakan . ACL 2022

Yao Lu, Max Bartolo, Alastair Moore, Sebastian Riede, Pontus Stenetorp . [PDF]

Model bahasa saluran bising yang diminta untuk klasifikasi teks beberapa shot . ACL 2022

Sewon Min, Mike Lewis, Hananeh Hajishirzi, Luke Zettlemoyer . [pdf] [kode]

Meta-pembelajaran melalui model tuning dalam konteks . ACL 2022

Yanda Chen, Ruiqi Zhong, Sheng Zha, George Karypis, dia . [pdf] [kode]

Apa yang membuat contoh dalam konteks yang baik untuk GPT-3? Deelio@acl 2022

Jiachang Liu, Dinghan Shen, Yizhe Zhang, Bill Dolan, Lawrence Carin, Weizhu Chen . [PDF]

Belajar mengambil permintaan untuk pembelajaran dalam konteks . NAACL 2022

Ohad Rubin, Jonathan Herzig, Jonathan Berant . [pdf] [kode]

Metaicl: Belajar belajar dalam konteks . NAACL 2022

Sewon Min, Mike Lewis, Luke Zettlemoyer, Hananeh Hajishirzi . [pdf] [kode]

Meningkatkan pembelajaran beberapa tembakan dalam konteks melalui pelatihan yang di-swadaya . NAACL 2022

Mingda Chen, Jingfei Du, Ramakanth Pasunuru, Todor Mihaylov, Srini Iyer, Veselin Stoyanov, Zornitsa Kozareva . [PDF]

Pembelajaran dalam konteks yang dihasilkan sendiri: Memanfaatkan model bahasa regresif otomatis sebagai generator demonstrasi . LPLM@NAACL 2022

Hyuhng Joon Kim, Hyunsoo Cho, Junyeob Kim, Taeuk Kim, Kang Min Yoo, Sang-Goo Lee . [PDF]

Memikirkan kembali peran demonstrasi: Apa yang membuat pembelajaran dalam konteks bekerja? Pracetak 2022.2

Sewon Min, Xinxi Lyu, Ari Holtzman, Mikel Artetxe, Mike Lewis, Hananeh Hajishirzi, Luke Zettlemoyer . [pdf] [kode]

Pembelajaran in-context untuk pelacakan negara dialog beberapa-shot. Pracetak 2022.3

Yushi Hu, Chia-Hsuan Lee, Tianbao Xie, Tao Yu, Noah A. Smith, Mari Ostendorf . [pdf] [kode]

Konsistensi diri meningkatkan penalaran rantai pemikiran dalam model bahasa . Pracetak 2022.3

Xuezhi Wang, Jason Wei, Dale Schuurmans, Quoc LE, Ed Chi, Denny Zhou . [PDF]

Bintang: Penalaran penalaran penalar otodidak dengan alasan . Pracetak 2022.3

Eric Zelikman, Yuhuai Wu, Noah D. Goodman . [PDF]

Benchmarking Generalisasi melalui instruksi dalam konteks pada 1.600+ tugas bahasa . Pracetak 2022.4

Yizhong Wang, Swaroop Mishra, Pegah Alipoormolabashi, Yeganeh Kordi, Amirreza Mirzaei, Anjana Arunkumar, Arjun Ashok, Arut Selvan Dhanasekaran, Atharva Naik, David Stap, Eshean Pathak, Giannis Kariamis Mondal, Jacob Anderson, Kirby Kuznia, Krima Doshi, Maitreya Patel, Kuntal Kumar Pal, Mehrad Moradshahi, Mihir Parmar, Mirali Purohit, Neeraj Varshney, Phani Rohitha Kaza, Pulkit Verma, Ravsehaj Singh Puri, Rushang Karia, Shailaja Keyur Sampat, Savan Doshi, Siddhartha Mishra, Suhan Reddy, Sumanta Patro, Tanay Dixit, Xudong Shen, Chitta Baral, Yejin Choi, Noah A. Smith, Hananeh Hajishirzi, Daniel Khashabi . [pdf] [kode]

Dapatkah model bahasa belajar dari penjelasan dalam konteks? . Pracetak 2022.4

Andrew K. Lampinen, Ishita Dasgupta, Stephanie Cy Chan, Kory Matthewson, Michael Henry Tessler, Antonia Creswell, James L. McClelland, Jane X. Wang, Felix Hill . [PDF]

Label-truth label materi: Pandangan yang lebih dalam ke dalam demonstrasi label input . Pracetak 2022.5

JUNYEOB KIM, Hyuhng Joon Kim, Hyunsoo Cho, Hwiyeol Jo, Sang-Woo Lee, Sang-Goo Lee, Kang Min Yoo, Taeuk Kim . [PDF]

Tidak dapat diandalkannya penjelasan dalam pembelajaran dalam beberapa-konteks . Pracetak 2022.5

XI YE, Greg Durrett . [PDF]

Permintaan paling tidak paling penting memungkinkan penalaran kompleks dalam model bahasa besar . Pracetak 2022.5

Denny Zhou, Nathanael Schärli, Le Hou, Jason Wei, Nathan Scales, Xuezhi Wang, Dale Schuurmans, Olivier Bousquet, Quoc LE, Ed Chi . [PDF]

MAIEUTIC CONTEPTING: Penalaran yang konsisten secara logis dengan penjelasan rekursif . Pracetak 2022.5

Jaehun Jung, Lianhui Qin, Sean Welleck, Faeze Brahman, Chandra Bhagavatula, Ronan Le Bras, Yejin Choi . [PDF]

Di muka membuat model bahasa yang lebih baik . Pracetak 2022.6

Yifei Li, Zeqi Lin, Shizhuo Zhang, Qiang Fu, Bei Chen, Jian-Guang Lou, Weizhu Chen . [pdf] [kode]

Kemampuan yang muncul dari model bahasa besar . Pracetak 2022.6

Jason Wei, Yi Tay, Rishi Bommasani, Colin Raffel, Barret Zoph, Sebastian Borgeaud, Dani Yogatama, Maarten Bosma, Denny Zhou, Donald Metzler, Ed H. Chi, Tatsunori Hashimoto, Oriol Vinyal, Percy Lriang Liang, Jeff . [PDF]

Model bahasa adalah antarmuka tujuan umum . Pracetak 2022.6

Yaru Hao, Lagu Haoyu, Li Dong, Shaohan Huang, Zewen Chi, Wenhui Wang, Shuming Ma, Furu Wei . [pdf] [kode]

Apa yang dapat dipelajari oleh Transformers dalam konteks? Studi kasus kelas fungsi sederhana . Pracetak 2022.8

Shivam Garg, Dimitris Tsipras, Percy Liang, Gregory Valiant . [pdf] [kode]

Belajar dengan menyaring konteks . Pracetak 2022.9

Charlie Snell, Dan Klein, Ruiqi Zhong . [PDF]

Model bahasa yang mengikat dalam bahasa simbolik . Pracetak 2022.10

Zhoujun Cheng*, Tianbao Xie*, Peng Shi, Chengzu Li, Rahul Nadkarni, Yushi Hu, Caquiming Xiong, Dragomir Radev, Mari Ostendorf, Luke Zettlemoyer, Nuh A. Smith, Tao Yu . [PDF] [kode] [Situs Web]

Melestarikan kemampuan belajar dalam konteks dalam fine-tuning model bahasa besar . Pracetak 2022.11

Yihan Wang, Si Si, Daliang Li, Michal Lukasik, Felix Yu, Cho-Jui Hsieh, Dhillon Inderjit, Sanjiv Kumar . [PDF]

Pengajaran Algorithmic Reasoning melalui pembelajaran dalam konteks . Pracetak 2022.11

Hattie Zhou, Azade Nova, Hugo Larochelle, Aaron Courville, Behnam Neyshabur, Hanie Sedghi . [PDF]

Algoritma pembelajaran apa itu pembelajaran dalam konteks? Investigasi dengan model linier . Pracetak 2022.11

Ekin Akyürek, Dale Schuurmans, Jacob Andreas, Tengyu MA, Denny Zhou . [PDF]

Tuning kotak hitam untuk model bahasa-sebagai-layanan . ICML 2022

Tianxiang Sun, Yunfan Shao, Hong Qian, Xuanjing Huang, Xipeng Qiu. [pdf] [kode]

Black-Box Prompt Learning untuk model bahasa pra-terlatih . TMLR 2023.2

Shizhe Diao, Xuechun Li, Yong Lin, Zhichao Huang, Tong Zhang . [PDF]

GRIPS: Pencarian instruksi berbasis gradien-bebas, edit untuk mendorong model bahasa besar . Pracetak 2022.3

Archiki Prasad, Peter Hase, Xiang Zhou, Mohit Bansal . [pdf] [kode]

Beberapa tembakan meminta untuk menghasilkan respons yang dapat dikendalikan . Pracetak 2022.6

Hsuan Su, Pohan Chi, Shih-Cheng Huang, Chung Ho Lam, Saurav Sahay, Shang-Tse Chen, Hung-Yi Lee . [PDF]

BBTV2: Menuju masa depan bebas gradien dengan model bahasa besar . EMNLP 2022

Tianxiang Sun, Zhengfu He, Hong Qian, Yunhua Zhou, Xuanjing Huang, Xipeng Qiu . [pdf] [kode]

RLPROMPT: Mengoptimalkan permintaan teks diskrit dengan pembelajaran penguatan . EMNLP 2022

Mingkai Deng, Jianyu Wang, Cheng-Ping Hsieh, Yihan Wang, Han Guo, Tianmin Shu, Meng Song, Eric P. Xing, Zhiting Hu . [pdf] [kode]

CLIP-TUNING: Menuju pembelajaran cepat bebas turunan dengan campuran hadiah . Temuan EMNLP 2022

Yekun Chai, Shuohuan Wang, Yu Sun, Hao Tian, Hua Wu, Haifeng Wang . [PDF]

Tempera: Pengeditan cepat test-time melalui pembelajaran penguatan . Pracetak 2022.11

Tianjun Zhang, Xuezhi Wang, Denny Zhou, Dale Schuurmans, Joseph E. Gonzalez. [pdf] [kode]

PromptBoosting: Klasifikasi teks kotak hitam dengan sepuluh operan ke depan . Pracetak 2022.12

Bairu Hou, Joe O'Connor, Jacob Andreas, Shiyu Chang, Yang Zhang . [PDF]

Pra-pelatihan multitask prompt modular untuk pembelajaran beberapa tembakan Cina . ACL 2023

Tianxiang Sun, Zhengfu He, Qin Zhu, Xipeng Qiu, Xuanjing Huang . [PDF]

Ketika keturunan gradien memenuhi optimasi bebas turunan: kecocokan yang dibuat dalam skenario kotak hitam . ACL 2023

Chengcheng Han, Liqing Cui, Renyu Zhu, Jianing Wang, Nuo Chen, Qiushi Sun, Xiang Li, Ming Gao . [PDF]

Buat tuning kotak hitam berbasis prompt berwarna: meningkatkan generalisasi model dari tiga perspektif ortogonal . LREC-COLING 2024

Qiushi Sun, Chengcheng Han, Nuo Chen, Renyu Zhu, Jingyang Gong, Xiang Li, Ming Gao . [PDF]

Menyetel atau tidak untuk menyetel? Mengadaptasi representasi pretrained dengan beragam tugas . Repl4nlp@acl 2019

Matthew E. Peters, Sebastian Ruder, Noah A. Smith . [PDF]

Bisakah penjelasan berguna untuk mengkalibrasi model kotak hitam? ACL 2022

XI YE, Greg Durrett . [pdf] [kode]

Pelatihan bersama meningkatkan pembelajaran berbasis cepat untuk model bahasa besar . ICML 2022

Hunter Lang, Monica Agrawal, Yoon Kim, David Sontag . [PDF]

Y-Tuning: Paradigma tuning yang efisien untuk model pra-terlatih skala besar melalui pembelajaran representasi label . Pracetak 2022.2

Yitao Liu, Chenxin An, Xipeng Qiu . [PDF]

LST: Tangga-tuning untuk parameter dan pembelajaran transfer yang efisien memori . Neurips 2022

Yi-Lin Sung, Jaemin Cho, Mohit Bansal . [pdf] [kode]

Tuning decoder: pemahaman bahasa yang efisien sebagai decoding . Pracetak 2022.12

Ganqu Cui, Goao Li, Ning Ding, Longtao Huang, Zhiyuan Liu, Maosong Sun. [PDF]

Menghasilkan set data dengan model bahasa pretrained . EMNLP 2021

Timo Schick, Hinrich Schütze . [pdf] [kode]

GPT3MIX: Memanfaatkan model bahasa skala besar untuk augmentasi teks . Temuan EMNLP 2021

Kang Min Yoo, Taman Dongju, Jaewook Kang, Sang-Woo Lee, Woomyeong Park . [pdf] [kode]

Menghasilkan pengetahuan yang diminta untuk penalaran akal sehat . ACL 2022

Jiacheng Liu, Alisa Liu, Ximing Lu, Sean Welleck, Peter West, Ronan Le Bras, Yejin Choi, Hananeh Hajishirzi . [pdf] [kode]

Zerogen: Pembelajaran zero-shot yang efisien melalui pembuatan dataset . EMNLP 2022

Jiacheng Ye, Jiahui Gao, Qintong Li, Hang Xu, Jiangtao Feng, Zhiyong Wu, Tao Yu, Lingpeng Kong . [pdf] [kode]

Zerogen+: Pembuatan data berkualitas tinggi yang dipandu sendiri dalam pembelajaran nol-shot yang efisien . Pracetak 2022.2

Jiahui Gao, Renjie Pi, Yong Lin, Hang Xu, Jiacheng Ye, Zhiyong Wu, Xiaodan Liang, Zhenguo LI, Lingpeng Kong . [PDF]

Augesc: Augmentasi dialog dengan model bahasa besar untuk percakapan dukungan emosional . Temuan ACL 2023

Chujie Zheng, Sahand Sabour, Jiaxin Wen, Zheng Zhang, Minlie Huang . [PDF]

Menghasilkan Data Pelatihan dengan Model Bahasa: Menuju Pemahaman Bahasa Zero-Shot . Neurips 2022

Yu Meng, Jiaxin Huang, Yu Zhang, Jiawei Han [PDF] [Kode]

?? Pertama, terima kasih telah meluangkan waktu untuk berkontribusi! ??

Langkah untuk berkontribusi:

PaperNumber di bagian atas halaman yang sesuai dan kirimkan permintaan tarik Anda. Kami sarankan memberikan penjelasan yang sangat singkat mengapa menurut Anda sebuah makalah harus ditambahkan atau diubah.Jangan khawatir jika Anda salah, kami akan memperbaikinya untuk Anda. Cukup berkontribusi dan promosikan pekerjaan luar biasa Anda di sini!

Selain kontributor berikut yang mengajukan permintaan tarik, kami juga ingin mengucapkan terima kasih kepada Ohad Rubin dan Kang Min Yoo karena merekomendasikan kertas.