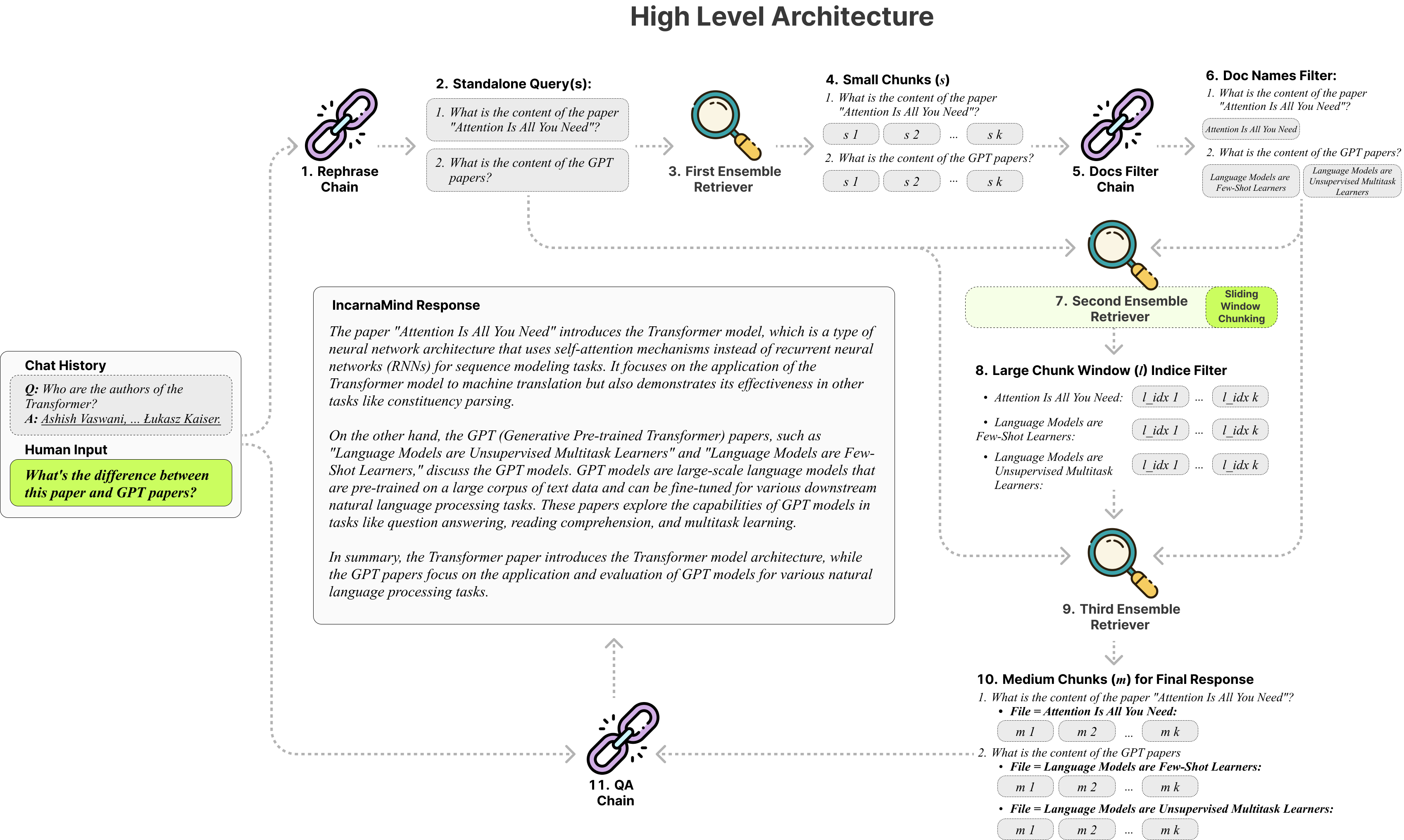

Incarnamind memungkinkan Anda untuk mengobrol dengan dokumen pribadi Anda? (Pdf, txt) Menggunakan model bahasa besar (LLM) seperti GPT (ikhtisar arsitektur). Sementara Openai baru-baru ini meluncurkan API yang menyempurnakan untuk model GPT, itu tidak memungkinkan model pretrained dasar untuk mempelajari data baru, dan tanggapannya dapat rentan terhadap halusinasi faktual. Memanfaatkan mekanisme pemotongan jendela geser kami dan retriever ensemble memungkinkan permintaan yang efisien dari informasi berbutir halus dan berbutir kasar dalam dokumen kebenaran tanah Anda untuk menambah LLM.

Jangan ragu untuk menggunakannya dan kami menyambut umpan balik dan saran fitur baru?

Berikut adalah tabel perbandingan dari berbagai model yang saya uji, hanya untuk referensi:

| Metrik | GPT-4 | GPT-3.5 | Claude 2.0 | Llama2-70b | Llama2-70b-gguf | Llama2-70b-API |

|---|---|---|---|---|---|---|

| Pemikiran | Tinggi | Sedang | Tinggi | Sedang | Sedang | Sedang |

| Kecepatan | Sedang | Tinggi | Sedang | Sangat rendah | Rendah | Sedang |

| RAM GPU | N/a | N/a | N/a | Sangat tinggi | Tinggi | N/a |

| Keamanan | Rendah | Rendah | Rendah | Tinggi | Tinggi | Rendah |

Fixed Chunking : Alat kain tradisional mengandalkan ukuran chunk tetap, membatasi kemampuan beradaptasi dalam menangani berbagai kompleksitas dan konteks data.

Precision vs. Semantik : Metode pengambilan saat ini biasanya berfokus pada pemahaman semantik atau pengambilan yang tepat, tetapi jarang keduanya.

Batasan Dokumen Tunggal : Banyak solusi hanya dapat menanyakan satu dokumen pada satu waktu, membatasi pengambilan informasi multi-dokumen.

Stabilitas : Incarnamind kompatibel dengan OpenAI GPT, Anthropic Claude, Llama2, dan LLMs sumber terbuka lainnya, memastikan penguraian yang stabil.

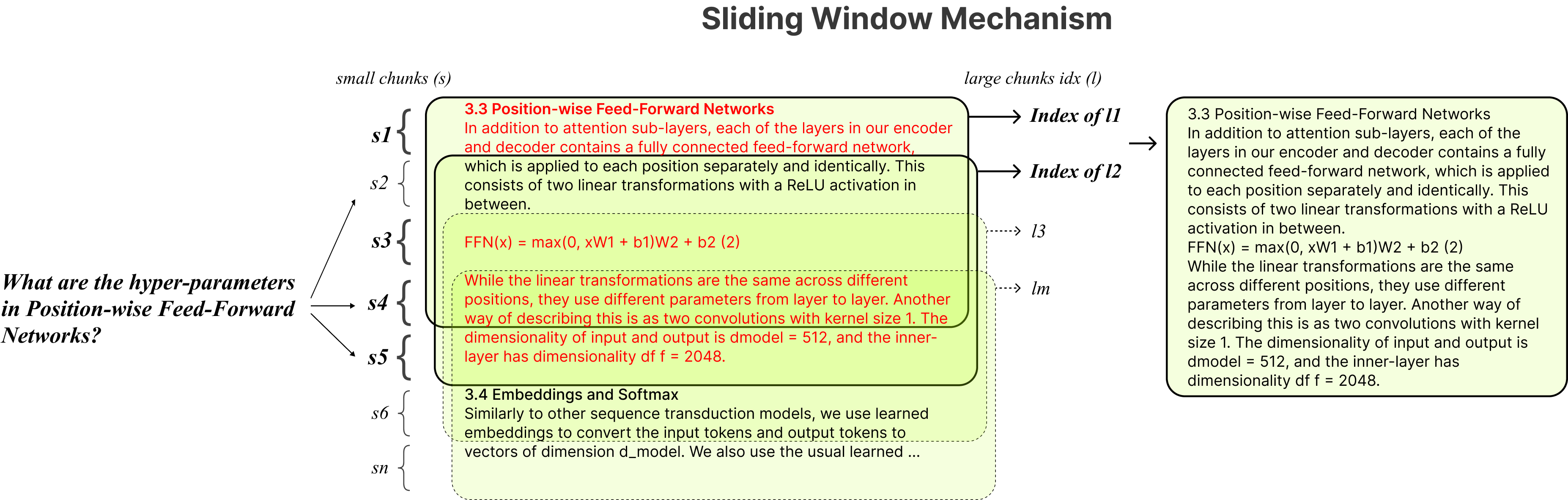

Adaptif Chunking : Teknik chunking jendela geser kami secara dinamis menyesuaikan ukuran dan posisi jendela untuk kain, menyeimbangkan akses data berbutir halus dan berbutir kasar berdasarkan kompleksitas dan konteks data.

Multi-Document Conversational QA : Mendukung kueri sederhana dan multi-hop di beberapa dokumen secara bersamaan, melanggar batasan dokumen tunggal.

Kompatibilitas File : Mendukung format file PDF dan TXT.

Kompatibilitas Model LLM : Mendukung OpenAI GPT, Anthropic Claude, LLAMA2 dan LLMS open-source lainnya.

Instalasi sederhana, Anda hanya perlu menjalankan beberapa perintah.

git clone https://github.com/junruxiong/IncarnaMind

cd IncarnaMindBuat lingkungan virtual conda:

conda create -n IncarnaMind python=3.10Mengaktifkan:

conda activate IncarnaMindInstal semua persyaratan:

pip install -r requirements.txtInstal llama-cpp secara terpisah jika Anda ingin menjalankan llms lokal terkuantisasi:

NVIDIA GPU, gunakan cuBLAS CMAKE_ARGS= " -DLLAMA_CUBLAS=on " FORCE_CMAKE=1 pip install llama-cpp-python==0.1.83 --no-cache-dirM1/M2 ), gunakan CMAKE_ARGS= " -DLLAMA_METAL=on " FORCE_CMAKE=1 pip install llama-cpp-python==0.1.83 --no-cache-dirSiapkan satu/semua tombol API di file configParser.ini :

[tokens]

OPENAI_API_KEY = (replace_me)

ANTHROPIC_API_KEY = (replace_me)

TOGETHER_API_KEY = (replace_me)

# if you use full Meta-Llama models, you may need Huggingface token to access.

HUGGINGFACE_TOKEN = (replace_me)(Opsional) Mengatur parameter khusus Anda di file configParser.ini :

[parameters]

PARAMETERS 1 = (replace_me)

PARAMETERS 2 = (replace_me)

...

PARAMETERS n = (replace_me)Masukkan semua file Anda (silakan beri nama setiap file dengan benar untuk memaksimalkan kinerja) ke dalam direktori /data dan jalankan perintah berikut untuk menelan semua data: (Anda dapat menghapus file contoh di direktori /data sebelum menjalankan perintah)

python docs2db.pyUntuk memulai percakapan, jalankan perintah seperti:

python main.pyTunggu skrip untuk meminta masukan Anda seperti di bawah ini.

Human:Saat Anda memulai obrolan, sistem akan secara otomatis menghasilkan file incarnamind.log . Jika Anda ingin mengedit logging, silakan edit di file configParser.ini .

[logging]

enabled = True

level = INFO

filename = IncarnaMind.log

format = %(asctime)s [%(levelname)s] %(name)s: %(message)sTerima kasih khusus kepada Langchain, Chroma DB, LocalGpt, Llama-CPP atas kontribusi mereka yang tak ternilai bagi komunitas open-source. Pekerjaan mereka telah berperan dalam mewujudkan proyek Incarnamind.

Jika Anda ingin mengutip pekerjaan kami, silakan gunakan entri Bibtex berikut:

@misc { IncarnaMind2023 ,

author = { Junru Xiong } ,

title = { IncarnaMind } ,

year = { 2023 } ,

publisher = { GitHub } ,

journal = { GitHub Repository } ,

howpublished = { url{https://github.com/junruxiong/IncarnaMind} }

}Lisensi Apache 2.0