Editor Downcodes mengetahui bahwa Hugging Face hari ini merilis SmolLM2, serangkaian model bahasa ringkas yang mengesankan dalam hal kinerja dan memerlukan sumber daya komputasi yang jauh lebih sedikit dibandingkan model besar. Tidak diragukan lagi, ini merupakan kabar baik bagi pengembang yang ingin menerapkan aplikasi AI pada perangkat dengan sumber daya terbatas. SmolLM2 dirilis di bawah lisensi Apache 2.0 dan menyediakan tiga model dengan ukuran parameter berbeda, yang dapat secara fleksibel disesuaikan dengan berbagai skenario aplikasi.

Hugging Face hari ini merilis SmolLM2, serangkaian model bahasa ringkas baru yang mencapai performa mengesankan sekaligus memerlukan sumber daya komputasi yang jauh lebih sedikit dibandingkan model yang lebih besar. Model baru ini dirilis di bawah lisensi Apache 2.0 dan hadir dalam tiga ukuran - parameter 135M, 360M, dan 1,7B - cocok untuk diterapkan pada ponsel cerdas dan perangkat edge lainnya dengan daya pemrosesan dan memori terbatas.

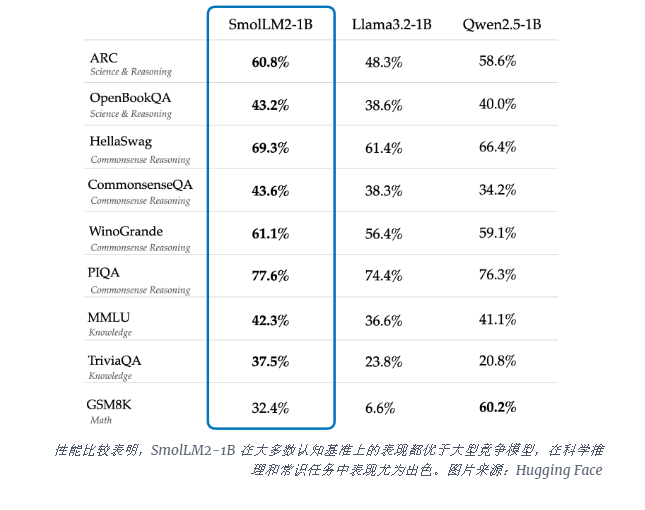

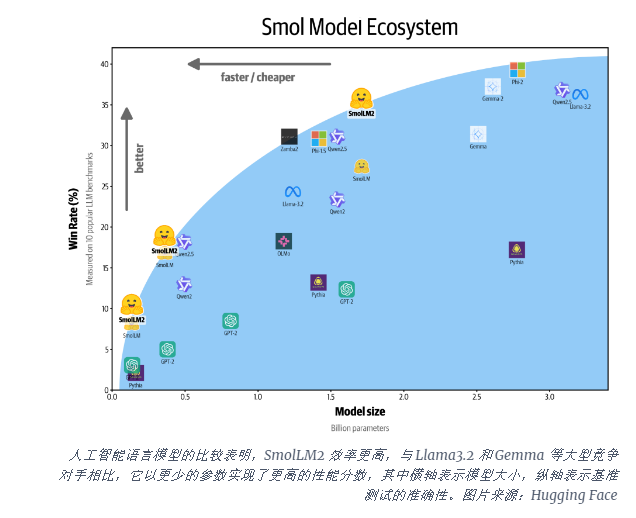

Model SmolLM2-1B mengungguli model Llama1B Meta dalam beberapa tolok ukur utama, khususnya berkinerja baik pada penalaran ilmiah dan tugas-tugas akal sehat. Model ini mengungguli model pesaing besar pada sebagian besar tolok ukur kognitif, menggunakan beragam kombinasi kumpulan data termasuk FineWeb-Edu dan kumpulan data matematika dan pengkodean khusus.

Peluncuran SmolLM2 terjadi pada saat yang kritis ketika industri AI bergulat dengan tuntutan komputasi untuk menjalankan model bahasa besar (LLM). Meskipun perusahaan seperti OpenAI dan Anthropic terus mendorong batas-batas skala model, terdapat peningkatan kesadaran akan kebutuhan akan AI yang efisien dan ringan yang dapat berjalan secara native di perangkat.

SmolLM2 menawarkan pendekatan berbeda untuk menghadirkan kemampuan AI yang kuat langsung ke perangkat pribadi, menunjuk ke masa depan di mana alat AI canggih tersedia untuk lebih banyak pengguna dan perusahaan, bukan hanya raksasa teknologi yang memiliki pusat data besar. Model-model ini mendukung berbagai aplikasi, termasuk penulisan ulang teks, peringkasan, dan pemanggilan fungsi, serta cocok untuk diterapkan dalam skenario di mana terdapat kendala privasi, latensi, atau konektivitas yang membuat solusi AI berbasis cloud menjadi tidak praktis.

Meskipun model-model kecil ini masih memiliki keterbatasan, model-model tersebut mewakili tren yang lebih luas menuju model AI yang lebih efisien. Peluncuran SmolLM2 menunjukkan bahwa masa depan kecerdasan buatan mungkin tidak hanya dimiliki oleh model yang semakin besar, namun juga oleh arsitektur yang lebih efisien yang dapat memberikan kinerja hebat dengan sumber daya yang lebih sedikit.

Kemunculan SmolLM2 memberikan kemungkinan baru bagi pengembangan aplikasi AI yang ringan, dan juga menunjukkan bahwa teknologi AI akan menjadi lebih populer dan menguntungkan lebih banyak pengguna. Editor Downcodes percaya bahwa model AI yang lebih efisien dan konsumsi sumber daya rendah akan muncul di masa depan untuk mendorong pengembangan teknologi kecerdasan buatan.