リンニン・シュー·ヴァス・アグラワル·ウィリアム・レイニー·トニー・ガルシア·アーユシュ・バンサル

チャンイル・キム、サミュエル・ロタ・ブロー、ロレンツォ・ポルツィ、ペーター・コンシーダー

アルヤシュ・ボジッチ·ダーファ・リン · ミヒャエル・ツォルヘファー·クリスチャン・リヒャルト

ACM SIGGRAPH アジア 2023

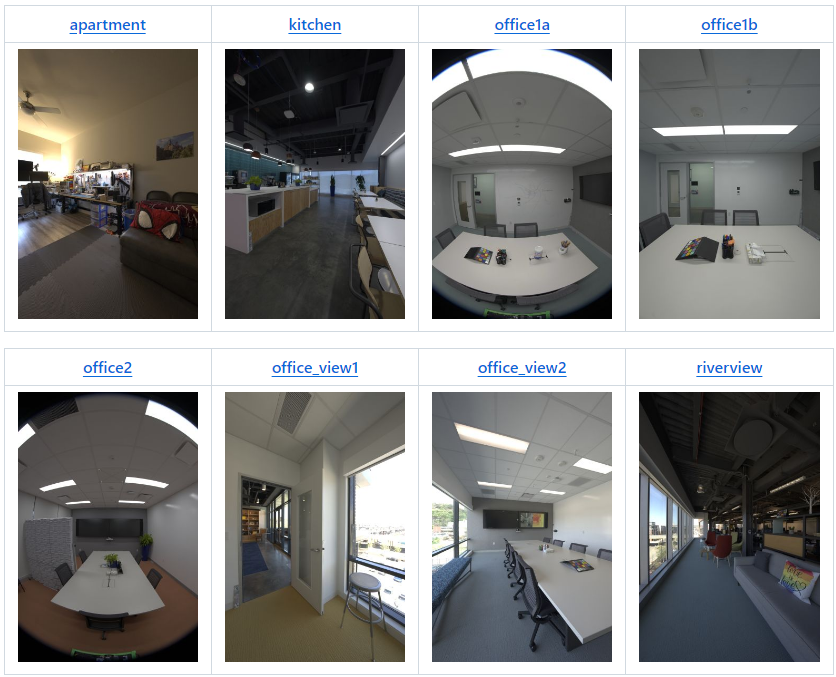

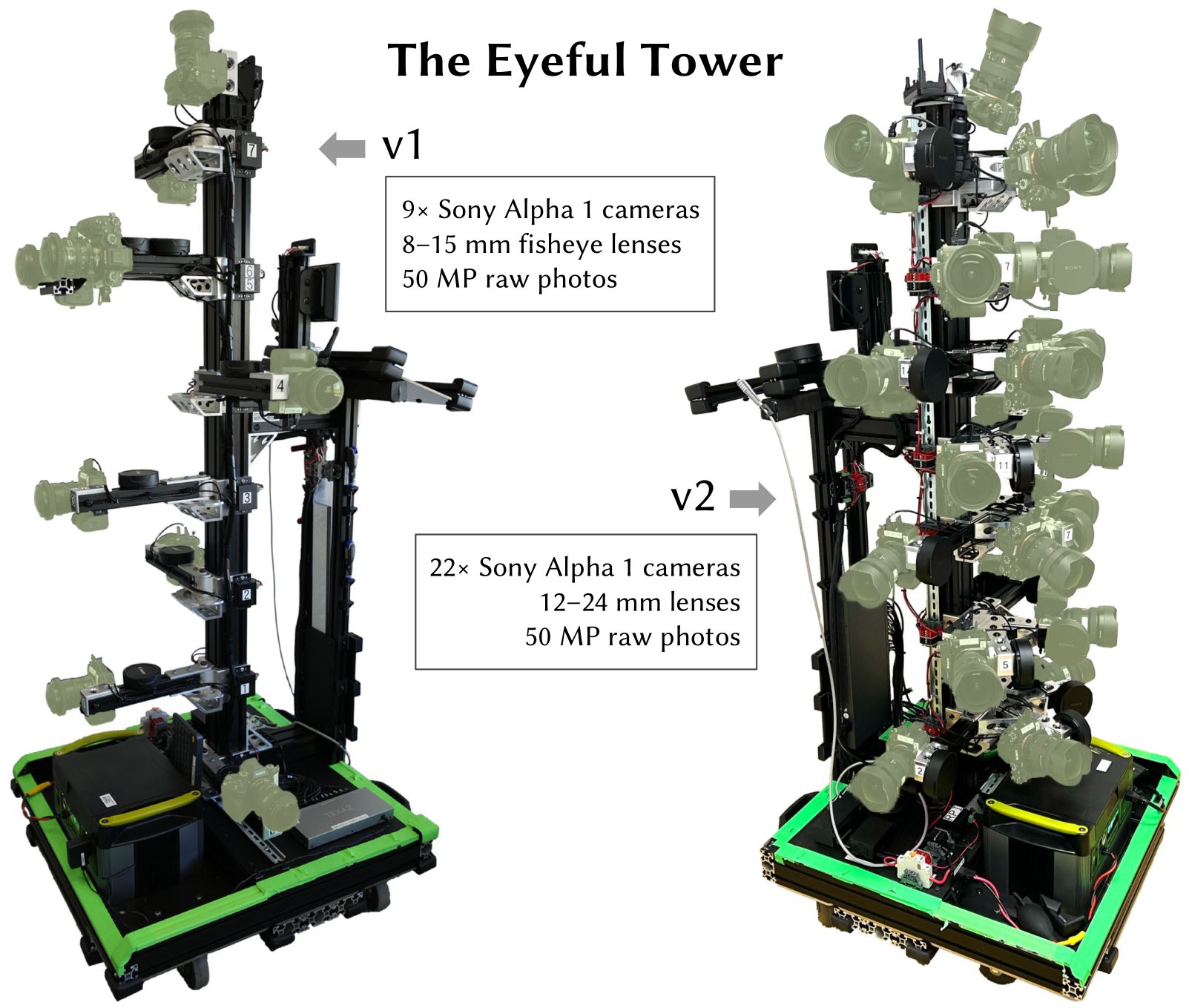

| シーン | バージョン | カム | 位置 | 画像 | 2K EXR | 1K EXR | 8K+ JPEG | 4K JPEG | 2K JPEG | 1K JPEG |

|---|---|---|---|---|---|---|---|---|---|---|

| アパート | v2 | 22 | 180 | 3,960 | 123GB | 31GB | 92GB | 20GB | 5GB | 1.2GB |

| 台所 | v2* | 19 | 318 | 6,024 | 190GB | 48GB | 142GB | 29GB | 8GB | 1.9GB |

| オフィス1a | v1 | 9 | 85 | 765 | 24GB | 6GB | 15GB | 3GB | 1GB | 0.2GB |

| オフィス1b | v2 | 22 | 71 | 1,562 | 49GB | 13GB | 35GB | 7GB | 2GB | 0.4GB |

| オフィス2 | v1 | 9 | 233 | 2,097 | 66GB | 17GB | 46GB | 9GB | 2GB | 0.5GB |

| オフィスビュー1 | v2 | 22 | 126 | 2,772 | 87GB | 22GB | 63GB | 14GB | 4ギガバイト | 0.8GB |

| オフィスビュー2 | v2 | 22 | 67 | 1,474 | 47GB | 12GB | 34GB | 7GB | 2GB | 0.5GB |

| リバービュー | v2 | 22 | 48 | 1,008 | 34GB | 8GB | 24GB | 5GB | 2GB | 0.4GB |

| 座席エリア | v1 | 9 | 168 | 1,512 | 48GB | 12GB | 36GB | 8GB | 2GB | 0.5GB |

| テーブル | v1 | 9 | 134 | 1,206 | 38GB | 9GB | 26GB | 6GB | 2GB | 0.4GB |

| ワークショップ | v1 | 9 | 700 | 6,300 | 198GB | 50GB | 123GB | 27GB | 8GB | 2.1GB |

| raf_emptyroom | v2 | 22 | 365 | 8,030 | 252GB | 63GB | 213GB | 45GB | 12GB | 2.5GB |

| raf_家具付き部屋 | v2 | 22 | 154 | 3,388 | 106GB | 27GB | 90GB | 19GB | 5GB | 1.1GB |

| 合計 | 1,262GB | 318GB | 939GB | 199GB | 54GB | 12.5GB |

* 標準構成よりも 3 台少ないカメラ、つまり 19 台のカメラのみを備えた v2。

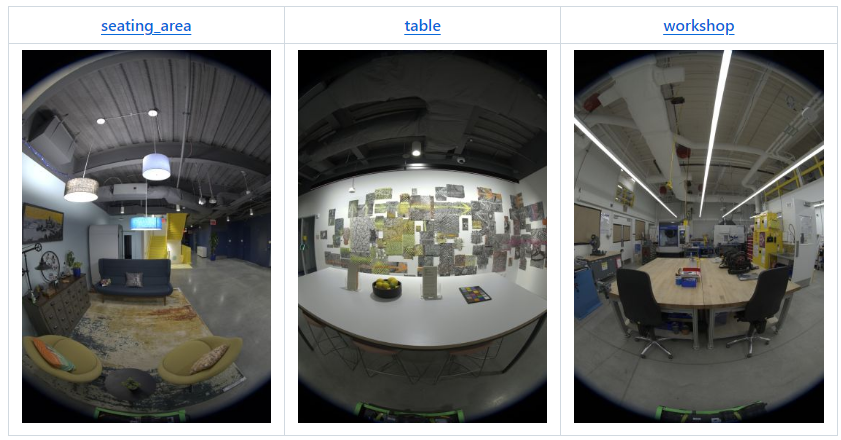

2024 年 4 月:次の 2 つのシーンが、私たちの論文 Real Acoustic Fields (CVPR 2024) に付属しています。

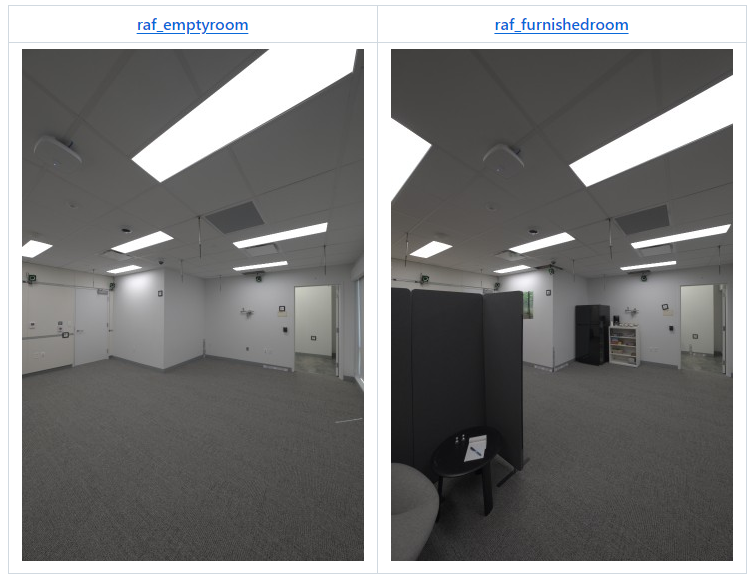

データセット内のすべての画像は、Eyeful Tower v1 または v2 (概要表で指定されているとおり) で撮影されました。 Eyeful Tower v1 は 9 台の魚眼カメラで構成されますが、Eyeful Tower v2 は 22 台のピンホール カメラ (「キッチン」の場合は 19 台) で構成されます。

Eyeful Tower データセットは AWS S3 でホストされており、任意のブラウザで探索したり、wget やcurl などの標準ソフトウェアでダウンロードしたりできます。

ただし、最も速く、最も信頼性の高いダウンロードを行うには、AWS コマンドライン インターフェイス (AWS CLI) を使用することをお勧めします。AWS CLI のインストール手順を参照してください。

オプション:同時ダウンロード数を 10 から 100 に増やして、ダウンロードを高速化します。

aws configure set default.s3.max_concurrent_requests 100

aws s3 cp --recursive --no-sign-request s3://fb-baas-f32eacb9-8abb-11eb-b2b8-4857dd089e15/EyefulTower/apartment/images-jpeg-1k/ apartment/images-jpeg-1k/

あるいは、「 sync 」を使用して、既存のファイルの転送を回避します。

aws s3 sync --no-sign-request s3://fb-baas-f32eacb9-8abb-11eb-b2b8-4857dd089e15/EyefulTower/apartment/images-jpeg-1k/ apartment/images-jpeg-1k/

特定のカメラを試してみたい方は、まずコラージュ ビデオをご覧になることをお勧めします。これは、どのカメラ ビューを利用したいかを特定するのに役立ちます。たとえば、v2 キャプチャ リグを使用したこのアパートのシーンでは、同じ高さに配置されたカメラ ID 19、20、21 を検討できます。

アパート キッチン オフィス 1a オフィス 1b オフィス 2 オフィス ビュー 1 オフィス ビュー 2 リバービュー シーティング エリア テーブル ワークショップのデータセット用。する mkdir -p $dataset/images-jpeg-1k; aws s3 cp --recursive --no-sign-request s3://fb-baas-f32eacb9-8abb-11eb-b2b8-4857dd089e15/EyefulTower/$dataset/images-jpeg-1k/ $dataset/images-jpeg-1k /;終わり

aws s3 sync --no-sign-request s3://fb-baas-f32eacb9-8abb-11eb-b2b8-4857dd089e15/EyefulTower/ .

各シーンは次の構造に従って構成されています。

apartment │ ├── apartment-final.pdf # Metashape reconstruction report ├── cameras.json # Camera poses in KRT format (see below) ├── cameras.xml # Camera poses exported from Metashape ├── colmap # COLMAP reconstruction exported from Metashape │ ├── images # Undistorted images (full resolution) │ ├── images_2 # Undistorted images (1/2 resolution) │ ├── images_4 # Undistorted images (1/4 resolution) │ ├── images_8 # Undistorted images (1/8 resolution) │ └── sparse # COLMAP reconstruction (for full-res images) ├── images-1k # HDR images at 1K resolution │ ├── 10 # First camera (bottom-most camera) │ │ ├── 10_DSC0001.exr # First image │ │ ├── 10_DSC0010.exr # Second image │ │ ├── [...] # More images │ │ └── 10_DSC1666.exr # Last image │ ├── 11 # Second camera │ │ ├── 11_DSC0001.exr │ │ ├── 11_DSC0010.exr │ │ ├── [...] │ │ └── 11_DSC1666.exr │ ├── [...] # More cameras │ └── 31 # Last camera (top of tower) │ ├── 31_DSC0001.exr │ ├── 31_DSC0010.exr │ ├── [...] │ └── 31_DSC1666.exr ├── images-2k [...] # HDR images at 2K resolution ├── images-jpeg [...] # Full-resolution JPEG images ├── images-jpeg-1k [...] # JPEG images at 1K resolution ├── images-jpeg-2k # JPEG images at 2K resolution │ ├── [10 ... 31] │ ├── [10 ... 31].mp4 # Camera visualization │ └── collage.mp4 # Collage of all cameras ├── images-jpeg-4k [...] # JPEG images at 4K resolution ├── mesh.jpg # Mesh texture (16K×16K) ├── mesh.mtl # Mesh material file ├── mesh.obj # Mesh in OBJ format └── splits.json # Training/testing splits

images-1k/{camera}/*.exrおよびimages-2k/{camera}/*.exr )9 枚の写真の RAW 露出ブラケットからマージされたハイ ダイナミック レンジ画像。

「1K」(684×1024ピクセル)または「2K」解像度(1368×2048ピクセル)にダウンサンプリングされます。

色空間: DCI-P3 (リニア)

非圧縮の 32 ビット浮動小数点数を含む EXR イメージとして保存されます。

すべての画像ファイル名には、カメラ名が接頭辞として付けられます (例: 17_DSC0316.exr 。

ファイル名が同じ番号で終わる画像は同時にキャプチャされます。

一部の画像が欠落している可能性があります。たとえば、ぼやけた画像やキャプチャ オペレータが削除された画像が原因です。

import os, cv2, numpy as np# OpenCV で OpenEXR サポートを有効にする (https://github.com/opencv/opencv/issues/21326).# この環境変数は、最初の EXR イメージが開かれる前に定義する必要があります。os environ["OPENCV_IO_ENABLE_OPENEXR"] = "1"# OpenCV.img を使用して EXR イメージを読み取ります = cv2.imread("apartment/images-2k/17/17_DSC0316.exr", cv2.IMREAD_UNCHANGED)# ホワイトバランス スケーリングを適用します (注: OpenCV は BGR カラーを使用します).coeffs = np.array([0.726097, 1.0, 1.741252] ) # アパート [RGB]img = np.einsum("ijk,k->ijk", img, coeffs[::-1])# sRGB を使用したトーンマップcurve.linear_part = 12.92 * imgexp_part = 1.055 * (np.maximum(img, 0.0) ** (1 / 2.4)) - 0.055img = np.where(img <= 0.0031308, Linear_part, exp_part)# 結果の画像を JPEG.img = np.clip(255 * img, 0.0, 255.0).astype(np.uint8)cv2.imwrite("apartment-17_DSC0316.jpg", img, params= として書き込みます[cv2.IMWRITE_JPEG_QUALITY, 100])images-jpeg*/{camera}/*.jpg )JPEG 画像は 4 つの解像度レベルで提供されます。

images-jpeg/ : 5784 × 8660 = 50 メガピクセル — オリジナル画像のフル解像度

images-jpeg-4k/ : 2736 × 4096 = 11.2 メガピクセル

images-jpeg-2k/ : 1368 × 2048 = 2.8 メガピクセル

images-jpeg-1k/ : 684 × 1024 = 0.7 メガピクセル

JPEG 画像は、HDR 画像のホワイト バランスが調整され、トーン マップされたバージョンです。詳細については、上記のコードを参照してください。

各シーンは ColorChecker から派生したホワイト バランス設定を使用し、次のように RGB チャネルを個別にスケーリングします。

| シーン | RGB スケール係数 |

|---|---|

| アパート | 0.726097, 1.0, 1.741252 |

| 台所 | 0.628143, 1.0, 2.212346 |

| オフィス1a | 0.740846, 1.0, 1.750224 |

| オフィス1b | 0.725535, 1.0, 1.839938 |

| オフィス2 | 0.707729, 1.0, 1.747833 |

| オフィスビュー1 | 1.029089, 1.0, 1.145235 |

| オフィスビュー2 | 0.939620, 1.0, 1.273549 |

| リバービュー | 1.077719, 1.0, 1.145992 |

| 座席エリア | 0.616093, 1.0, 2.426888 |

| テーブル | 0.653298, 1.0, 2.139514 |

| ワークショップ | 0.709929, 1.0, 1.797705 |

| raf_emptyroom | 0.718776, 1.0, 1.787020 |

| raf_家具付き部屋 | 0.721494, 1.0, 1.793423 |

cameras.json )この JSON ファイルの基本構造は{"KRT": [<one object per image>]}で、各画像オブジェクトには次のプロパティがあります。

width : 画像の幅、ピクセル単位 (通常は 5784)

height : 画像の高さ (ピクセル単位) (通常は 8660)

cameraId : この画像のファイル名コンポーネント (例: "0/0_REN0001" );完全なパスを取得するには、 "{scene}/{imageFormat}/{cameraId}.{extension}"を次のように使用します。

scene : 11 個のシーン名のいずれか、

imageFormat : "images-2k" 、 "images-jpeg-2k" 、 "images-jpeg-4k" 、または"images-jpeg"のいずれか

extension : ファイル拡張子、JPEG の場合はjpg 、EXR 画像 (HDR) の場合はexr

K : フル解像度画像用の 3×3 固有カメラ行列 (列優先)

T : 4×4 ワールドからカメラへの変換行列 (列優先)

distortionModel : 使用されるレンズ歪みモデル:

魚眼画像用の"Fisheye" (Eyeful v1)

ピンホール画像用の"RadialAndTangential" (Eyeful v2)

distortion : OpenCV のcv2.undistort関数で使用するレンズ歪み係数

注:投影モデルは理想的な (等距離) 魚眼モデルです。

魚眼画像 (Eyeful v1): [k1, k2, k3, _, _, _, p1, p2]

ピンホール画像 (Eyeful v2): [k1, k2, p1, p2, k3] ( cv2.undistortと同じ順序)

frameId : キャプチャ時の位置インデックス(連続する整数)

同時に撮影されたすべての画像は同じframeIdを共有します

sensorId : この画像の Metashape センサー ID (別名カメラ)

同じカメラで撮影されたすべての画像は同じsensorIdを共有します

cameraMasterId (オプション): この位置/フレームのマスター カメラ (リグ キャリブレーション内) の Metashape カメラ ID

同時に撮影されたすべての画像は同じcameraMasterIdを共有します

sensorMasterId (オプション): リグ キャリブレーションのマスター カメラの Metashape センサー ID

マスター カメラを除くすべてのカメラで同じ値にする必要があります (通常、Eyeful v1 の場合は"6" 、Eyeful v2 の場合は"13" )。

世界座標系: 右手、y 上、 y=0は地平面、単位はメートルです。

cameras.xml )カメラ キャリブレーション データは、独自のファイル形式を使用して Metashape から直接エクスポートされます。

mesh.* )Metashape からエクスポートされ、フル解像度の JPEG 画像から作成された OBJ 形式のテクスチャ メッシュ。

世界座標系: 右手、y 上、 y=0は地平面、単位はメートルです。

colmap/ )これらの COLMAP 再構築は、Metashape 2.1.3 をデフォルトのパラメータで使用して、元の再構築からエクスポートされます。

colmap/imagesの下の画像はimages-jpegの画像から画像中心に主点を持つピンホール投影まで自動的に歪みが解消されました。

この歪みを解消すると、魚眼画像が大幅にトリミングされ、カメラごとに異なる画像サイズが生成される傾向があることに注意してください。

colmap/images-*の画像は、Mip-NeRF 360 データセット形式と同様に、フル解像度の歪みのない画像のダウンサンプリング バージョンです。

splits.json )トレーニング ( "train" ) およびテスト ( "test" ) 用のイメージのリストが含まれます。

1 台のカメラのすべての画像がテスト用に保持されます。Eyeful v1 の場合はカメラ5 、Eyeful v2 の場合はカメラ17です。

2023 年 11 月 3 日– 初期データセットのリリース

2024 年 1 月 18 日– 小規模実験用に「1K」解像度 (684×1024 ピクセル) EXR と JPEG を追加しました。

2024 年 4 月 19 日– Real Acoustic Fields (RAF) データセットから 2 つの部屋を追加しました: raf_emptyroomとraf_furnishedroom 。

2024 年 10 月 9 日– Mip-NeRF 360 形式 (例: gsplat と互換性) で歪みのない画像を含むエクスポートされた COLMAP 再構成を追加しました。

このデータセットのデータまたはこのリポジトリでリリースされたコードを使用する場合は、VR-NeRF 論文を引用してください。

@InProceedings{VRNeRF、著者 = {Linning Xu、Vasu Agrawal、William Laney、Tony Garcia、Aayush Bansal、Changil Kim、Rota Bulò、Samuel、Lorenzo Porzi、Peter Kontschieder、Aljaž Božič、Dahua Lin、Michael Zollhöfer、Christian Richardt}、 title = {{VR-NeRF}: 高忠実度仮想化された歩行可能なスペース}、書籍名 = {SIGGRAPH アジア会議議事録}、年 = {2023}、doi = {10.1145/3610548.3618139}、URL = {https://vr-nerf.github.io}、

}クリエイティブ・コモンズ表示 - 非営利 (CC BY-NC) 4.0 (LICENSE ファイルに記載)。

【利用規約】 【プライバシーポリシー】