Kai Li 1 、 Wendi Sang 1 、 Chang Zeng 2 、 Runxuan Yang 1 、 Guo Chen 1 、 Xiaolin Hu 1

1清華大学、中国

2国立情報学研究所

紙 |デモ

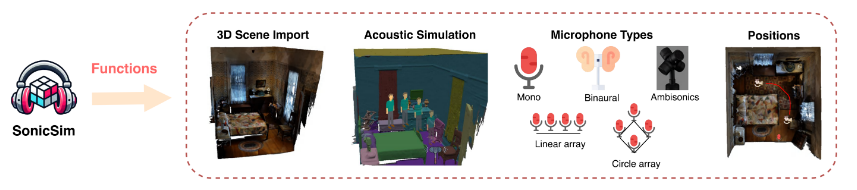

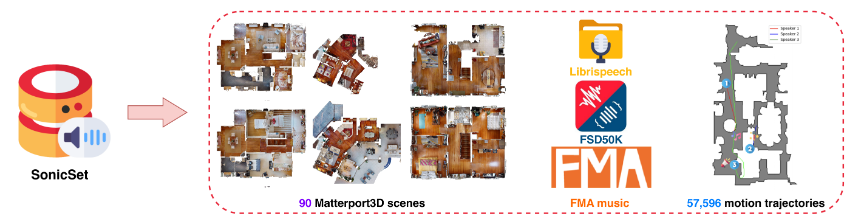

移動音源用に高度にカスタマイズ可能なデータを生成するように設計された合成ツールキットである SonicSim を紹介します。 SonicSim は、身体化された AI シミュレーション プラットフォームである Habitat-sim に基づいて開発されており、シーン レベル、マイク レベル、ソース レベルを含むマルチレベルのパラメーター調整をサポートし、それによってより多様な合成データを生成します。 SonicSim を活用して、LibriSpeech データセット、Freesound Dataset 50k (FSD50K) および Free Music Archive (FMA)、および Matterport3D の 90 シーンを使用して、移動音源ベンチマーク データセット SonicSet を構築し、音声の分離および強化モデルを評価しました。

[2024-10-30] 環境のインストールに関するバグを修正し、SonicSet データセット上の音声分離および拡張モデルのトレーニング コードを更新しました。

[2024-10-23] SonicSet データセット上の音声分離および強調モデルのtraining codeリリースしました。

[2024-10-03] arxiv で論文を公開しました

[2024-10-01] 現実世界のシナリオにおける音声分離モデルのパフォーマンスを評価することを目的とした、現実世界の音声分離データセットをリリースします。

[2024-07-31] 音声分離および拡張タスクを含むSonicSim datasetをリリースします。

[2024-07-24] dataset construction用のスクリプトとspeech separation and enhancement用の事前トレーニング済みモデルをリリースしました。

3D シーンのインポート: Matterport3D などのデータセットからのさまざまな 3D アセットのインポートをサポートし、複雑な音響環境の効率的かつスケーラブルな生成を可能にします。

音響環境シミュレーション:

屋内音響モデリングと双方向パス トレーシング アルゴリズムを使用して、部屋の形状内での音の反射をシミュレートします。

3D シーンのセマンティック ラベルをマテリアル プロパティにマッピングし、表面の吸収係数、散乱係数、透過係数を設定します。

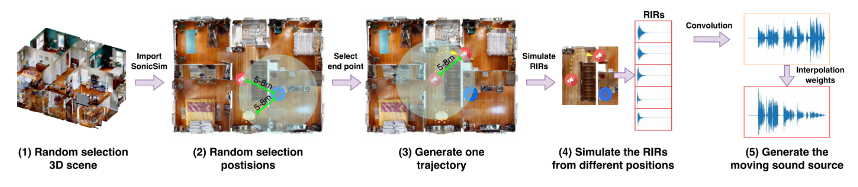

ソースパスに基づいて移動音源データを合成し、現実世界の状況に対する高い忠実度を保証します。

マイク構成: モノラル、バイノーラル、アンビソニックスを含む幅広いマイク セットアップを提供し、カスタムの線形および円形マイク アレイもサポートします。

ソースとマイクの位置設定: 音源とマイクの位置をカスタマイズまたはランダム化します。移動音源シミュレーションのモーション軌跡をサポートし、動的な音響シナリオにリアリズムを追加します。

事前に構築されたデータセットは、次のリンクからダウンロードできます。

| データセット名 | ワンドライブ | 百度ディスク |

|---|---|---|

| train フォルダー (分割 rar ファイル 40 個、377G) | [ダウンロードリンク] | [ダウンロードリンク] |

| val.rar (4.9G) | [ダウンロードリンク] | [ダウンロードリンク] |

| テスト.rar (2.2G) | [ダウンロードリンク] | [ダウンロードリンク] |

| 9月ベンチマークデータ(8.57G) | [ダウンロードリンク] | [ダウンロードリンク] |

| 拡張ベンチマーク データ (7.70G) | [ダウンロードリンク] | [ダウンロードリンク] |

| データセット名 | ワンドライブ | 百度ディスク |

|---|---|---|

| 現実世界のデータセット (1.0G) | [ダウンロードリンク] | [ダウンロードリンク] |

RealMAN データセット: RealMAN

データセットを自分で構築するには、 SonicSim-SonicSet/data-scriptフォルダーにある README を参照してください。このドキュメントでは、データセットを生成するために提供されているスクリプトの使用方法について詳しく説明します。

トレーニングと推論のための環境をセットアップするには、提供されている YAML ファイルを使用します。

conda create -n SonicSim-Train python=3.10 conda は SonicSim-Train をアクティブにします pip install Cython==3.0.10 numpy==1.26.4 pip install torch==2.0.1 torchvision==0.15.2 torchaudio==2.0.2 --index-url https://download.pytorch.org/whl/cu118 pip install -rrequirements.txt -i https://mirrors.tuna.tsinghua.edu.cn/pypi/web/simple

separationディレクトリに移動し、次のスクリプトを実行して固定検証セットを生成します。

CDの分離 pythongenerate_fixed_validation.py --raw_dir=../SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/val --save_dir=../SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/val-sep-2 --is_mono pythongenerate_fixed_test.py --raw_dir=/home/pod/SonicSim/SonicSim/SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/test --is_mono

enhancementディレクトリに移動し、次のスクリプトを実行して、修正された検証セットを生成します。

CD エンハンスメント pythongenerate_fixed_validation.py --raw_dir=../SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/val --save_dir=../SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/val-enh-noise --is_mono pythongenerate_fixed_test.py --raw_dir=/home/pod/SonicSim/SonicSim/SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/test --is_mono

separationディレクトリに移動し、指定された構成ファイルを使用してトレーニング スクリプトを実行します。

CDの分離 python train.py --conf_dir=configs/afrcnn.yaml

enhancementディレクトリに移動し、指定された構成ファイルを使用してトレーニング スクリプトを実行します。

CD エンハンスメント python train.py --conf_dir=config/dccrn.yaml

sep-checkpoints および enh-checkpoints フォルダー内の README.md の内容を確認し、適切な事前トレーニング済みモデルを Release でダウンロードし、適切なフォルダーに解凍してください。

separationディレクトリに移動し、指定された構成ファイルを使用して推論スクリプトを実行します。

CDの分離 python inference.py --conf_dir=../sep-checkpoints/TFGNet-Noise/config.yaml

enhancementディレクトリに移動し、指定された構成ファイルを使用して推論スクリプトを実行します。

CD エンハンスメント python inference.py --conf_dir=../enh-checkpoints/TaylorSENet-Noise/config.yaml

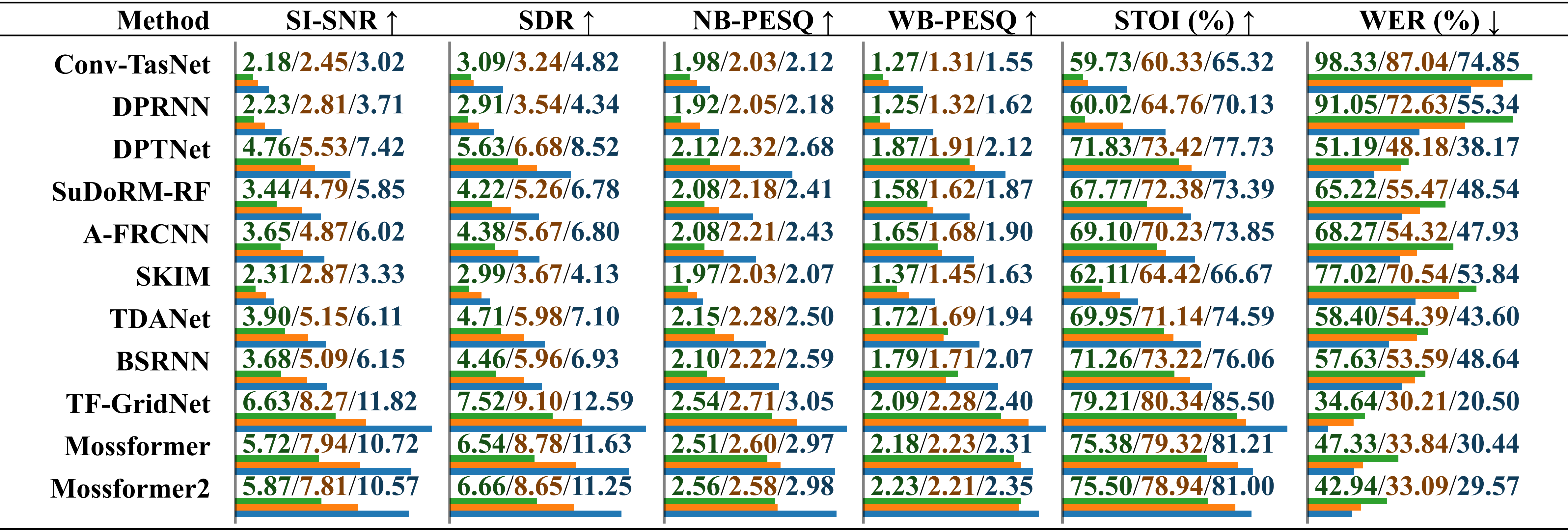

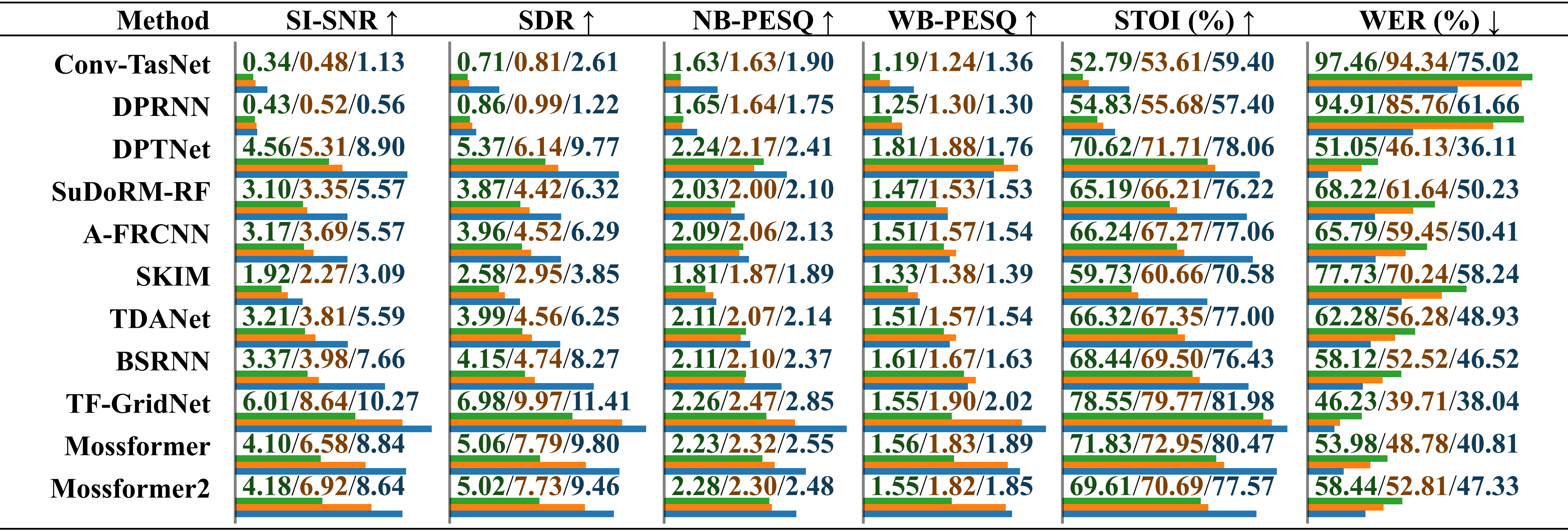

環境ノイズのある実際に録音された音声を使用して、さまざまなデータセットでトレーニングされたモデルのパフォーマンスの比較評価。結果は、「LRS2-2Mix でトレーニング」、「Libri2Mix でトレーニング」、および「SonicSet でトレーニング」について個別にレポートされ、スラッシュで区別されます。相対的な長さは値の下に水平バーで示されます。

音楽的なノイズを含む実際に録音されたオーディオを使用して、さまざまなデータセットでトレーニングされたモデルのパフォーマンスの比較評価。結果は、「LRS2-2Mix でトレーニング」、「Libri2Mix でトレーニング」、および「SonicSet でトレーニング」について個別にレポートされ、スラッシュで区別されます。

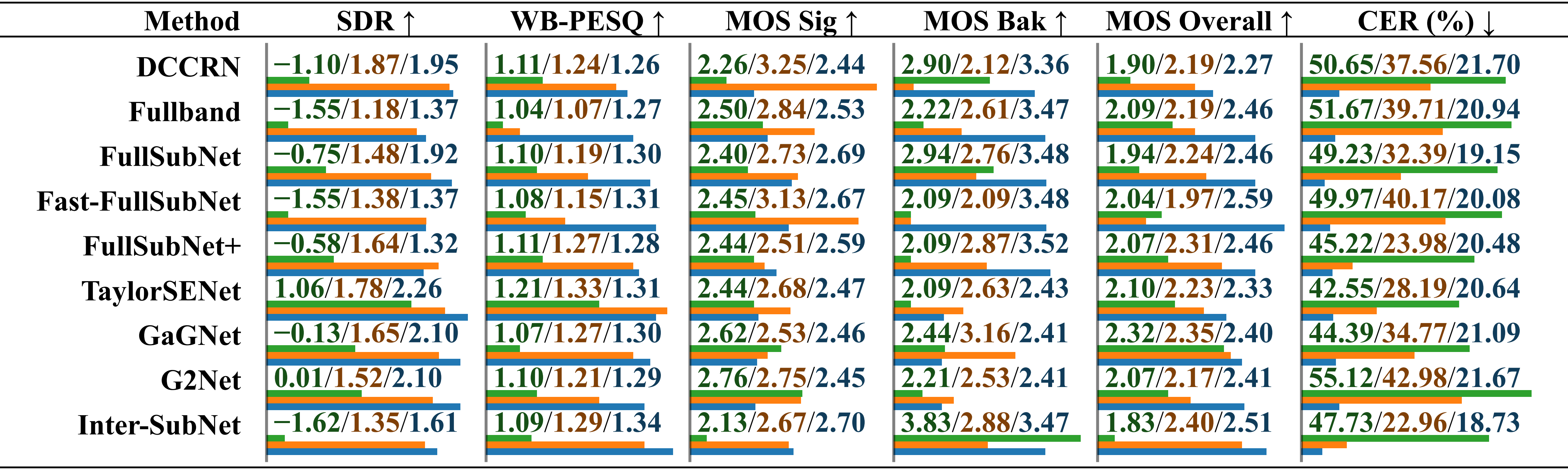

RealMAN データセットを使用して、さまざまなデータセットでトレーニングされたモデルのパフォーマンスの比較評価。結果は、「VoiceBank+DEMAND でトレーニング」、「DNS Challenge でトレーニング」、および「SonicSet でトレーニング」に分けてレポートされ、スラッシュで区別されます。

SonicSet データセットで分離モデルと拡張モデルをトレーニングしました。結果は次のとおりです。

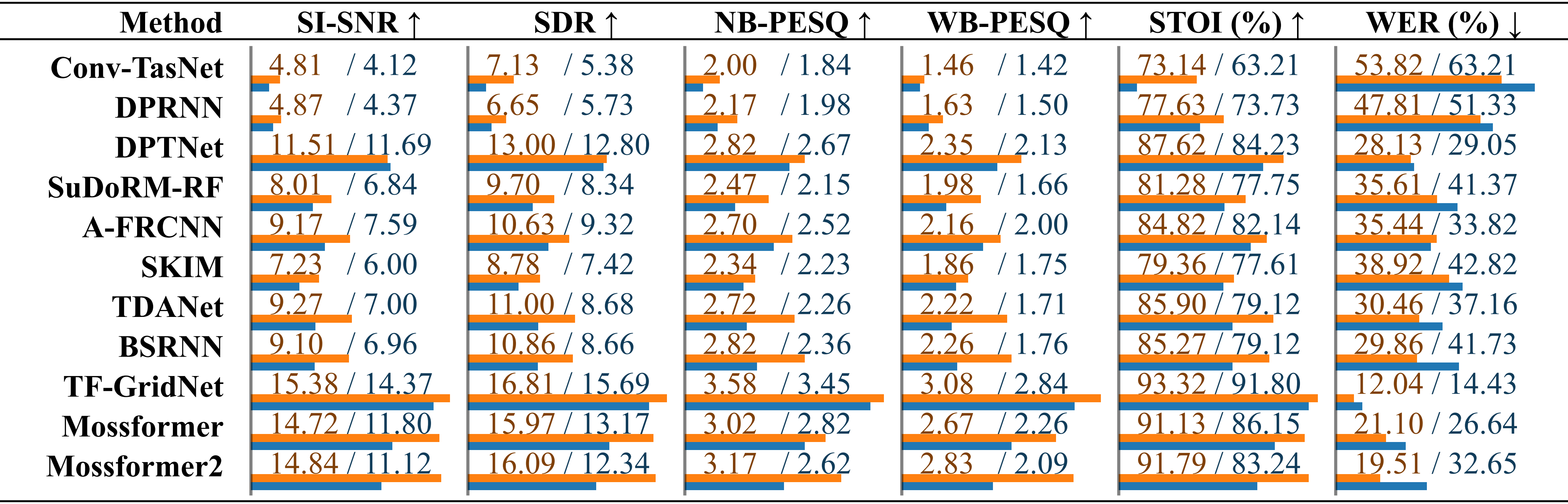

SonicSet データセット上の既存の音声分離方法の比較。各モデルの性能は、「環境騒音」と「音楽騒音」の結果ごとにスラッシュで区別して記載されています。

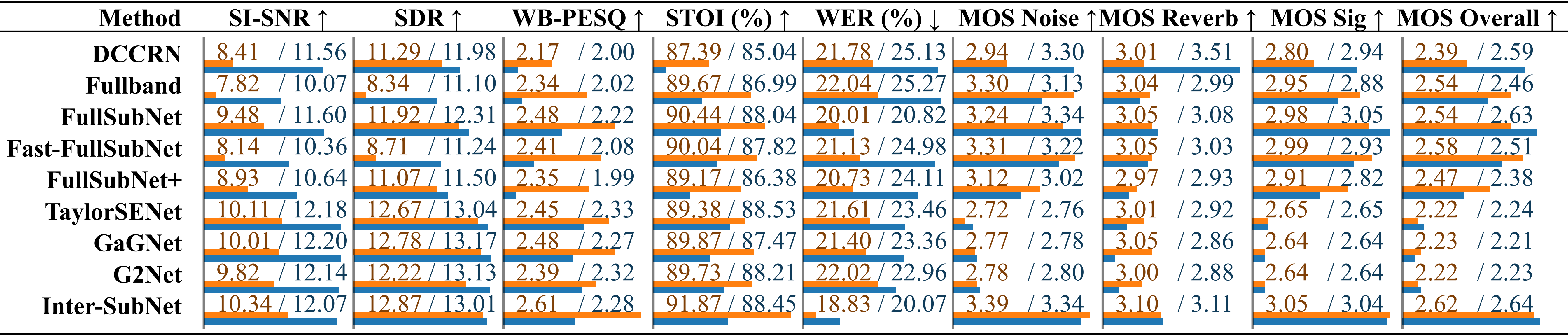

既存の音声強調方法の比較SonicSet テスト セットを使用した音声強調方法の比較。指標は「環境ノイズ」と「音楽ノイズ」の下にスラッシュで区別されて個別にリストされています。

以下の方々に感謝の意を表します。

音声データを提供するLibriSpeech。

シミュレーション環境用の SoundSpaces。

Apple は動的オーディオ合成スクリプトを提供しています。

この作品は、クリエイティブ コモンズ表示 - 継承 4.0 国際ライセンスに基づいてライセンスされています。