· 論文 · ベンチマーク · ホームページ · ドキュメント ·

✅ [2024/07/25] Visual PEFT Benchmark がデータセット、コード等の公開を開始します。

✅ [2024/06/20] Visual PEFT Benchmark ホームページを作成しました。

✅ [2024/06/01] Visual PEFT Benchmark リポジトリを作成しました。

導入

はじめる

コード構造

クイックスタート

結果とチェックポイント

コミュニティと連絡先

引用

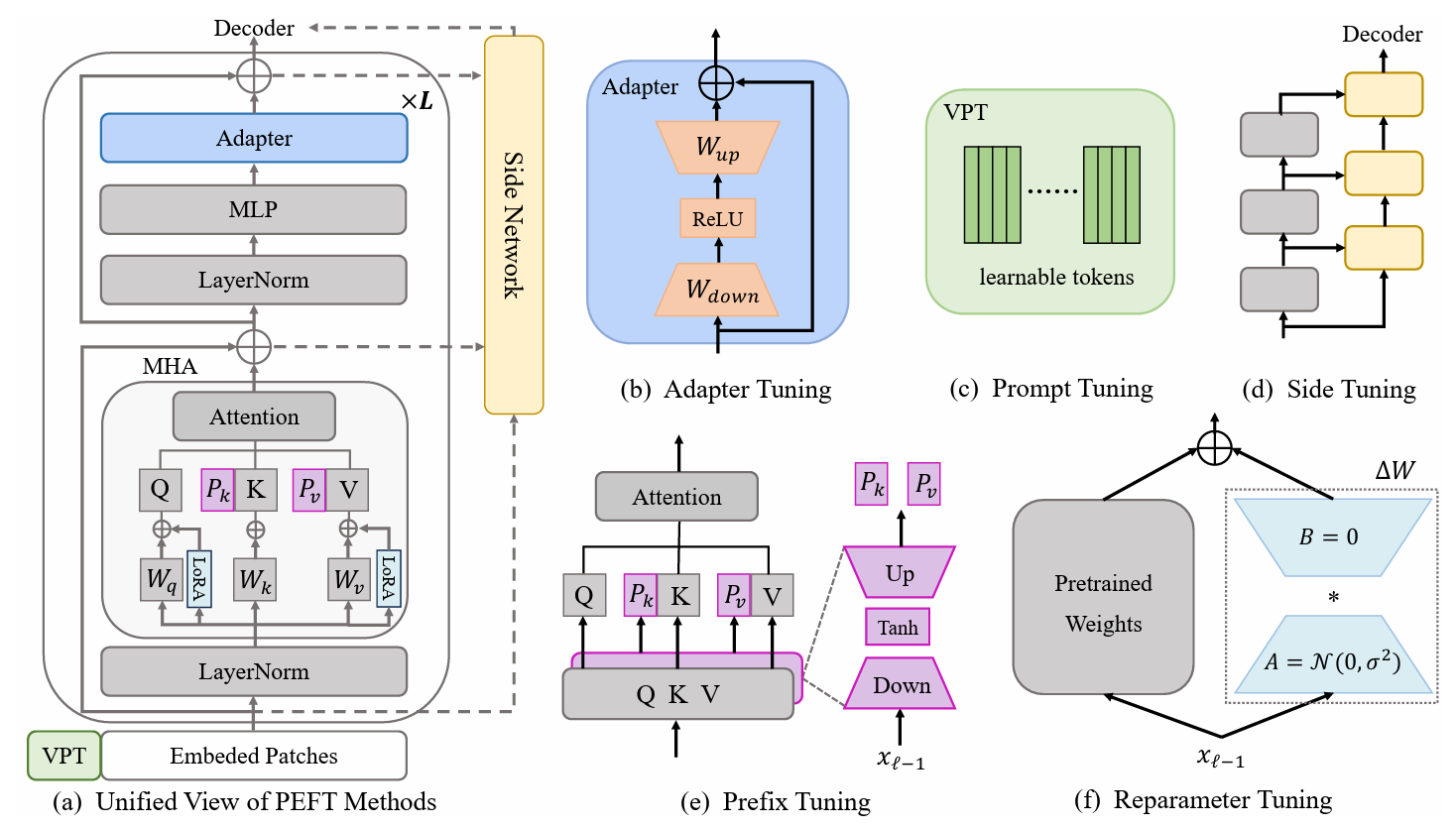

パラメーター効率の高い転移学習 (PETL) 手法は、少数のパラメーターのみをトレーニングしながら、事前トレーニングされたモデルをさまざまな下流タスクに適応させることができる可能性を示しています。コンピュータ ビジョン (CV) 領域では、多数の PETL アルゴリズムが提案されていますが、それらを直接使用したり比較したりするのは依然として不便です。この課題に対処するために、画像認識、ビデオ アクション認識、および高密度予測タスクから 30 個の多様で挑戦的かつ包括的なデータセットを選択することにより、CV ドメインの統合ビジュアル PETL ベンチマーク (V-PETL ベンチ) を構築しました。これらのデータセットについて、私たちは25 の主要な PETL アルゴリズムを体系的に評価し、これらのアルゴリズムを公正に評価するためにモジュール式で拡張可能なコードベースをオープンソースにしています。

詳細な視覚的分類タスク (FGVC)

FGVC は 5 つのきめの細かい視覚的分類データセットで構成されます。データセットは公式リンクからダウンロードできます。公開検証セットが利用できない場合は、トレーニング データを分割します。分割されたデータセットは、ダウンロード リンクにあります。

カブ200 2011

NA鳥

オックスフォードの花

スタンフォード・ドッグス

スタンフォードカーズ

ビジュアル タスク アダプテーション ベンチマーク (VTAB)

VTAB は 19 の多様な視覚分類データセットで構成されています。すべてのデータセットは処理済みで、データはここからダウンロードできます: ダウンロード リンク。具体的な処理手順とヒントについては、VTAB_SETUP を参照してください。

キネティクス-400

ダウンロード リンクまたはダウンロード リンクからデータセットをダウンロードします。

ビデオの短辺のサイズを320pxに変更して、データセットを前処理します。 MMAction2 データ ベンチマークを参照してください。

データローダーに必要なアノテーションを生成します (アノテーション内の「<video_id> <video_class>」)。通常、アノテーションにはtrain.csv 、 val.csv 、 test.csvが含まれます。 *.csvファイルの形式は次のとおりです。

video_1.mp4 label_1 video_2.mp4 label_2 video_3.mp4 label_3 ... video_N.mp4 label_N

何か-何か V2 (SSv2)

ダウンロード リンクからデータセットをダウンロードします。

ビデオ拡張子をwebmから元の高さ240pxの.mp4に変更して、データセットを前処理します。 MMAction2 データ ベンチマークを参照してください。

データローダーに必要なアノテーションを生成します (アノテーション内の「<video_id> <video_class>」)。通常、アノテーションにはtrain.csv 、 val.csv 、 test.csvが含まれます。 *.csvファイルの形式は次のとおりです。

video_1.mp4 label_1 video_2.mp4 label_2 video_3.mp4 label_3 ... video_N.mp4 label_N

MS-ココ

MS-COCO は、このダウンロード リンクから入手できます。

ADE20K

ADE20K のトレーニングおよび検証セットは、このダウンロード リンクからダウンロードできます。ダウンロード リンクからテスト セットをダウンロードすることもできます。

パスカルVOC

Pascal VOC 2012 は、ダウンロード リンクからダウンロードできます。さらに、Pascal VOC データセットに関する最近の研究では、通常、追加の拡張データが活用されており、ダウンロード リンクから見つけることができます。

ViT-B/16 事前トレーニング済みモデルをダウンロードして/path/to/pretrained_modelsに配置します。

mkdir pretrained_models wget https://storage.googleapis.com/vit_models/imagenet21k/ViT-B_16.npz

または、Swin-B 事前トレーニング済みモデルをダウンロードすることもできます。ダウンロードした Swin-B ckpt の名前をswin_base_patch4_window7_224_22k.pthからSwin-B_16.pthに変更する必要があることにも注意してください。

mkdir pretrained_models wget https://github.com/SwinTransformer/storage/releases/download/v1.0.0/swin_base_patch4_window7_224_22k.pth mv swin_base_patch4_window7_224_22k.pth Swin_B_16.pth

もう 1 つの方法は、以下のリンクから事前トレーニング済みモデルをダウンロードし、 /path/to/pretrained_modelsに配置することです。

| 事前トレーニングされたバックボーン | 事前トレーニングされた目標 | 事前トレーニングされたデータセット | チェックポイント |

|---|---|---|---|

| ヴィット-B/16 | 監督あり | イメージネット-21K | ダウンロードリンク |

| ヴィット-L/16 | 監督あり | イメージネット-21K | ダウンロードリンク |

| ViT-H/16 | 監督あり | イメージネット-21K | ダウンロードリンク |

| スイングB | 監督あり | イメージネット-22K | ダウンロードリンク |

| スウィンL | 監督あり | イメージネット-22K | ダウンロードリンク |

| ViT-B (VideoMAE) | 自己監視型 | キネティクス-400 | ダウンロードリンク |

| ビデオスウィンB | 監督あり | キネティクス-400 | ダウンロードリンク |

ImageClassification/configs : 実験の構成パラメータを処理します。

ImageClassification/config/vtab/cifar100.yaml : 実験用の主要な設定と各データセットの説明。

……

ImageClassification/dataloader : 入力データセットのロードとセットアップ。

ImageClassification/dataloader/transforms : 画像変換。

ImageClassification/dataloader/loader : 指定されたデータセットのデータローダーを構築します。

ImageClassification/models : さまざまな微調整プロトコルのバックボーン アーチとヘッドを処理します。

ImageClassification/models/vision_transformer_adapter.py : フォルダーには、アダプターに指定されたvit_backbonesフォルダー内の同じバックボーンが含まれています。

ImageClassification/models/vision_transformer_sct.py : フォルダーには、SCT に指定されたvit_backbonesフォルダーと同じバックボーンが含まれています。

……

ImageClassification/train : training fileフォルダーが含まれるフォルダー、

ImageClassification/train/train_model_adapter.py : これをトレーニング用に呼び出し、アダプターに指定された指定された転送タイプでモデルを評価します。

ImageClassification/train/train_model_sct.py : SCT に指定された、指定された転送タイプでモデルをトレーニングおよび評価するためにこれを呼び出します。

……

ImageClassification/scripts : scripts fileフォルダーが含まれるフォルダー、

ImageClassification/scripts/run_vit_adapter.sh : すべてのデータセットに対してアダプター メソッドを一度に実行できます。

ImageClassification/scripts/run_vit_sct.sh : すべてのデータセットに対してアダプター メソッドを一度に実行できます。

……

ImageClassification/Visualize : 視覚化ツール。

ImageClassification/Visualize/AttentionMap.py : アテンション マップの視覚化。

ImageClassification/Visualize/TSNE.py : T-SNE の視覚化。

ImageClassification/utils : ロガーの作成、シードの設定など。

❗️注意❗️: 独自の PETL アルゴリズムを作成したい場合は、`ImageClassification/models` に注意してください。

これは、V-PETL Bench をローカルにセットアップする方法の例です。

ローカル コピーを取得するには、次の簡単な手順例に従って実行します。

git clone https://github.com/synbol/Parameter-Efficient-Transfer-Learning-Benchmark.git

V-PETL Bench は、torchvision、torchaudio、timm などを備えた pytorch 上に構築されています。

必要なパッケージをインストールするには、conda 環境を作成します。

conda create --name v-petl-bench python=3.8

conda環境をアクティブ化します。

conda は v-petl-bench をアクティブ化します

pip を使用して必要なパッケージをインストールします。

cd パラメータ効率的な転送学習ベンチマーク pip install -r 要件.txt

VTAB Cifar100 上の LoRA を例として、具体的なトレーニングと評価のデモを提供します。

インポートシステム

sys.path.append("パラメータ効率的な転送学習ベンチマーク")

輸入トーチ

ImageClassification インポート ユーティリティから

ImageClassification.dataloader インポート vtab から

from ImageClassification.train import train# get lora メソッドfrom timm.scheduler.cosine_lr import CosineLRScheduler

ImageClassification.models からのインポートvision_transformer_lora

import timm# モデルと logsexp_base_path を保存するパス = '../output'utils.mkdirss(exp_base_path)# create loggerlogger = utils.create_logger(log_path=exp_base_path, log_name='training')# dataset config paramparamconfig = utils.get_config('モデル_lora'、'vtab'、'cifar100')# get vtab datasetdata_path = '/home/ma-user/work/haozhe/synbol/vtab-1k'train_dl, test_dl = vtab.get_data(data_path, 'cifar100', logger,evaluate=False, train_aug=config['train_aug'] 、batch_size=config['batch_size'])# 事前トレーニングされたモデルを取得model = timm.models.create_model('vit_base_patch16_224_in21k_lora'、checkpoint_path='./release_models/ViT-B_16.npz'、drop_path_rate=0.1、tuning_mode='lora')

model.reset_classifier(config['class_num'])# trainingparameterstrainable = []for n, p in model.named_parameters(): if 'linear_a' in n or 'linear_b' in n or 'head' in n:

trainable.append(p)

logger.info(str(n))

それ以外:

p.requires_grad = False

opt = torch.optim.AdamW(訓練可能、lr=1e-4、weight_decay=5e-2)

スケジューラ = CosineLRScheduler(opt, t_initial=config['epochs'], Warmup_t=config['warmup_epochs'], lr_min=1e-5, Warmup_lr_init=1e-6,cycle_decay = 0.1)#crossEntropyLoss functioncriterion = torch.nn.CrossEntropyLoss( )# トレーニングモデル = train.train(config,model,criterion,train_dl,opt,scheduler,logger,config['epochs'],'vtab','cifar100')#evaluationeval_acc = train.test(model, test_dl, 'vtab')データセットに対して PETL アルゴリズムを使用してトレーニングできます。

python python train/train_model_sct.py --dataset cifar100 --task vtab --lr 0.012 --wd 0.6 --eval True --dpr 0.1 --tuning_mode $tuning_mode --model_type $model_type --model $model --model_checkpoint $モデルチェックポイント

または、すべてのデータセットに対して PETL アルゴリズムを使用してトレーニングすることもできます

bash スクリプト/run_model_sct.sh

ImageNet-21K で事前トレーニングされた ViT-B/16 モデルを使用して、5 つのデータセットで 13 の PETL アルゴリズムを評価します。

チェックポイントを取得するには、ダウンロード リンクからダウンロードしてください。

| 方法 | CUB-200-2011 | NA鳥 | オックスフォードの花 | スタンフォード・ドッグス | スタンフォードカーズ | 平均 | パラムス。 | パワーポイント |

|---|---|---|---|---|---|---|---|---|

| 完全な微調整 | 87.3 | 82.7 | 98.8 | 89.4 | 84.5 | 88.54 | 85.8M | - |

| リニアプロービング | 85.3 | 75.9 | 97.9 | 86.2 | 51.3 | 79.32 | 0分 | 0.79 |

| アダプタ | 87.1 | 84.3 | 98.5 | 89.8 | 68.6 | 85.66 | 0.41M | 0.84 |

| アダプトフォーマー | 88.4 | 84.7 | 99.2 | 88.2 | 81.9 | 88.48 | 0.46M | 0.87 |

| プレフィックスチューニング | 87.5 | 82.0 | 98.0 | 74.2 | 90.2 | 86.38 | 0.36M | 0.85 |

| Uチューニング | 89.2 | 85.4 | 99.2 | 84.1 | 92.1 | 90.00 | 0.36M | 0.89 |

| ビットフィット | 87.7 | 85.2 | 99.2 | 86.5 | 81.5 | 88.02 | 0.10M | 0.88 |

| VPT-浅型 | 86.7 | 78.8 | 98.4 | 90.7 | 68.7 | 84.66 | 0.25M | 0.84 |

| VPT-ディープ | 88.5 | 84.2 | 99.0 | 90.2 | 83.6 | 89.10 | 0.85M | 0.86 |

| SSF | 89.5 | 85.7 | 99.6 | 89.6 | 89.2 | 90.72 | 0.39M | 0.89 |

| LoRA | 85.6 | 79.8 | 98.9 | 87.6 | 72.0 | 84.78 | 0.77M | 0.82 |

| GPS | 89.9 | 86.7 | 99.7 | 92.2 | 90.4 | 91.78 | 0.66M | 0.90 |

| HST | 89.2 | 85.8 | 99.6 | 89.5 | 88.2 | 90.46 | 0.78M | 0.88 |

| 最後 | 88.5 | 84.4 | 99.7 | 86.0 | 88.9 | 89.50 | 0.66M | 0.87 |

| SNF | 90.2 | 87.4 | 99.7 | 89.5 | 86.9 | 90.74 | 0.25M | 0.90 |

VTAB でのベンチマーク結果。 ImageNet-21K で事前トレーニングされた ViT-B/16 モデルを使用して、19 のデータセットで 18 の PETL アルゴリズムを評価します。

チェックポイントを取得するには、ダウンロード リンクからダウンロードしてください。

| 方法 | CIFAR-100 | カリフォルニア工科大学101 | DTD | 花102 | ペット | SVHN | サン397 | パッチキャメリヨン | ユーロSAT | レジスク45 | 網膜症 | 賢さ/カウント | 賢さ/距離 | DMラボ | キティ/距離 | dスプライト/loc | dスプライト/オリ | SmallNORB/アジ | SmallNORB/エレ | 平均 | パラムス。 | パワーポイント |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 完全な微調整 | 68.9 | 87.7 | 64.3 | 97.2 | 86.9 | 87.4 | 38.8 | 79.7 | 95.7 | 84.2 | 73.9 | 56.3 | 58.6 | 41.7 | 65.5 | 57.5 | 46.7 | 25.7 | 29.1 | 65.57 | 85.8M | - |

| リニアプロービング | 63.4 | 85.0 | 63.2 | 97.0 | 86.3 | 36.6 | 51.0 | 78.5 | 87.5 | 68.6 | 74.0 | 34.3 | 30.6 | 33.2 | 55.4 | 12.5 | 20.0 | 9.6 | 19.2 | 52.94 | 0分 | 0.53 |

| アダプタ | 69.2 | 90.1 | 68.0 | 98.8 | 89.9 | 82.8 | 54.3 | 84.0 | 94.9 | 81.9 | 75.5 | 80.9 | 65.3 | 48.6 | 78.3 | 74.8 | 48.5 | 29.9 | 41.6 | 71.44 | 0.16M | 0.71 |

| VPT-浅型 | 77.7 | 86.9 | 62.6 | 97.5 | 87.3 | 74.5 | 51.2 | 78.2 | 92.0 | 75.6 | 72.9 | 50.5 | 58.6 | 40.5 | 67.1 | 68.7 | 36.1 | 20.2 | 34.1 | 64.85 | 0.08M | 0.65 |

| VPT-ディープ | 78.8 | 90.8 | 65.8 | 98.0 | 88.3 | 78.1 | 49.6 | 81.8 | 96.1 | 83.4 | 68.4 | 68.5 | 60.0 | 46.5 | 72.8 | 73.6 | 47.9 | 32.9 | 37.8 | 69.43 | 0.56M | 0.68 |

| ビットフィット | 72.8 | 87.0 | 59.2 | 97.5 | 85.3 | 59.9 | 51.4 | 78.7 | 91.6 | 72.9 | 69.8 | 61.5 | 55.6 | 32.4 | 55.9 | 66.6 | 40.0 | 15.7 | 25.1 | 62.05 | 0.10M | 0.61 |

| LoRA | 67.1 | 91.4 | 69.4 | 98.8 | 90.4 | 85.3 | 54.0 | 84.9 | 95.3 | 84.4 | 73.6 | 82.9 | 69.2 | 49.8 | 78.5 | 75.7 | 47.1 | 31.0 | 44.0 | 72.25 | 0.29M | 0.71 |

| アダプトフォーマー | 70.8 | 91.2 | 70.5 | 99.1 | 90.9 | 86.6 | 54.8 | 83.0 | 95.8 | 84.4 | 76.3 | 81.9 | 64.3 | 49.3 | 80.3 | 76.3 | 45.7 | 31.7 | 41.1 | 72.32 | 0.16M | 0.72 |

| SSF | 69.0 | 92.6 | 75.1 | 99.4 | 91.8 | 90.2 | 52.9 | 87.4 | 95.9 | 87.4 | 75.5 | 75.9 | 62.3 | 53.3 | 80.6 | 77.3 | 54.9 | 29.5 | 37.9 | 73.10 | 0.21M | 0.72 |

| ノア | 69.6 | 92.7 | 70.2 | 99.1 | 90.4 | 86.1 | 53.7 | 84.4 | 95.4 | 83.9 | 75.8 | 82.8 | 68.9 | 49.9 | 81.7 | 81.8 | 48.3 | 32.8 | 44.2 | 73.25 | 0.43M | 0.72 |

| SCT | 75.3 | 91.6 | 72.2 | 99.2 | 91.1 | 91.2 | 55.0 | 85.0 | 96.1 | 86.3 | 76.2 | 81.5 | 65.1 | 51.7 | 80.2 | 75.4 | 46.2 | 33.2 | 45.7 | 73.59 | 0.11M | 0.73 |

| 事実 | 70.6 | 90.6 | 70.8 | 99.1 | 90.7 | 88.6 | 54.1 | 84.8 | 96.2 | 84.5 | 75.7 | 82.6 | 68.2 | 49.8 | 80.7 | 80.8 | 47.4 | 33.2 | 43.0 | 73.23 | 0.07M | 0.73 |

| レップアダプター | 72.4 | 91.6 | 71.0 | 99.2 | 91.4 | 90.7 | 55.1 | 85.3 | 95.9 | 84.6 | 75.9 | 82.3 | 68.0 | 50.4 | 79.9 | 80.4 | 49.2 | 38.6 | 41.0 | 73.84 | 0.22M | 0.72 |

| ヒドラ | 72.7 | 91.3 | 72.0 | 99.2 | 91.4 | 90.7 | 55.5 | 85.8 | 96.0 | 86.1 | 75.9 | 83.2 | 68.2 | 50.9 | 82.3 | 80.3 | 50.8 | 34.5 | 43.1 | 74.21 | 0.28M | 0.73 |

| LST | 59.5 | 91.5 | 69.0 | 99.2 | 89.9 | 79.5 | 54.6 | 86.9 | 95.9 | 85.3 | 74.1 | 81.8 | 61.8 | 52.2 | 81.0 | 71.7 | 49.5 | 33.7 | 45.2 | 71.70 | 238万 | 0.65 |

| DTL | 69.6 | 94.8 | 71.3 | 99.3 | 91.3 | 83.3 | 56.2 | 87.1 | 96.2 | 86.1 | 75.0 | 82.8 | 64.2 | 48.8 | 81.9 | 93.9 | 53.9 | 34.2 | 47.1 | 74.58 | 0.04M | 0.75 |

| HST | 76.7 | 94.1 | 74.8 | 99.6 | 91.1 | 91.2 | 52.3 | 87.1 | 96.3 | 88.6 | 76.5 | 85.4 | 63.7 | 52.9 | 81.7 | 87.2 | 56.8 | 35.8 | 52.1 | 75.99 | 0.78M | 0.74 |

| GPS | 81.1 | 94.2 | 75.8 | 99.4 | 91.7 | 91.6 | 52.4 | 87.9 | 96.2 | 86.5 | 76.5 | 79.9 | 62.6 | 55.0 | 82.4 | 84.0 | 55.4 | 29.7 | 46.1 | 75.18 | 0.22M | 0.74 |

| 最後 | 66.7 | 93.4 | 76.1 | 99.6 | 89.8 | 86.1 | 54.3 | 86.2 | 96.3 | 86.8 | 75.4 | 81.9 | 65.9 | 49.4 | 82.6 | 87.9 | 46.7 | 32.3 | 51.5 | 74.15 | 0.66M | 0.72 |

| SNF | 84.0 | 94.0 | 72.7 | 99.3 | 91.3 | 90.3 | 54.9 | 87.2 | 97.3 | 85.5 | 74.5 | 82.3 | 63.8 | 49.8 | 82.5 | 75.8 | 49.2 | 31.4 | 42.1 | 74.10 | 0.25M | 0.73 |

SSv2とHMDB51でのベンチマーク結果。 VideoMAE の ViT-B と Video Swin Transformer を使用して 5 つの PETL アルゴリズムを評価します。

チェックポイントを取得するには、ダウンロード リンクからダウンロードしてください。

| 方法 | モデル | 事前トレーニング | パラムス。 | SSv2 (トップ1) | SSv2 (PPT) | HMDB51 (トップ1) | HMDB51 (PPT) |

|---|---|---|---|---|---|---|---|

| 完全な微調整 | ViT-B | キネティクス 400 | 85.97メートル | 53.97% | - | 46.41% | - |

| 凍った | ViT-B | キネティクス 400 | 0分 | 29.23% | 0.29 | 49.84% | 0.50 |

| アダプトフォーマー | ViT-B | キネティクス 400 | 1.19メートル | 59.02% | 0.56 | 55.69% | 0.53 |

| バパット | ViT-B | キネティクス 400 | 2.06メートル | 57.78% | 0.53 | 57.18% | 0.53 |

| 完全な微調整 | ビデオスウィンB | キネティクス 400 | 87.64メートル | 50.99% | - | 68.07% | - |

| 凍った | ビデオスウィンB | キネティクス 400 | 0分 | 24.13% | 0.24 | 71.28% | 0.71 |

| LoRA | ビデオスウィンB | キネティクス 400 | 0.75メートル | 38.34% | 0.37 | 62.12% | 0.60 |

| ビットフィット | ビデオスウィンB | キネティクス 400 | 1.09メートル | 45.94% | 0.44 | 68.26% | 0.65 |

| アダプトフォーマー | ビデオスウィンB | キネティクス 400 | 1.56メートル | 40.80% | 0.38 | 68.66% | 0.64 |

| プレフィックスチューニング | ビデオスウィンB | キネティクス 400 | 6.37メートル | 39.46% | 0.32 | 56.13% | 0.45 |

| バパット | ビデオスウィンB | キネティクス 400 | 6.18メートル | 53.36% | 0.43 | 71.93% | 0.58 |

COCO でのベンチマーク結果。 ImageNet-22K で事前トレーニングされた Swin-B モデルを使用して 9 つの PETL アルゴリズムを評価します。

チェックポイントを取得するには、Coming Soon からダウンロードしてください。

| スイングB | パラムス。 | メモリ | ココ( | ココ (PPT) | ココ( | ココ (PPT) |

|---|---|---|---|---|---|---|

| 完全な微調整 | 86.75メートル | 17061MB | 51.9% | - | 45.0% | - |

| 凍った | 0.00M | 7137MB | 43.5% | 0.44 | 38.6% | 0.39 |

| ビットフィット | 0.20M | 13657MB | 47.9% | 0.47 | 41.9% | 0.42 |

| LNチューン | 0.06M | 12831MB | 48.0% | 0.48 | 41.4% | 0.41 |

| 部分-1 | 12.60メートル | 7301MB | 49.2% | 0.35 | 42.8% | 0.30 |

| アダプタ | 3.11メートル | 12557MB | 50.9% | 0.45 | 43.8% | 0.39 |

| LoRA | 3.03メートル | 11975MB | 51.2% | 0.46 | 44.3% | 0.40 |

| アダプトフォーマー | 3.11メートル | 13186MB | 51.4% | 0.46 | 44.5% | 0.40 |

| ロランド | 1.20メートル | 13598MB | 51.0% | 0.49 | 43.9% | 0.42 |

| E$^3$VA | 1.20メートル | 7639MB | 50.5% | 0.48 | 43.8% | 0.42 |

| モナ | 4.16メートル | 13996MB | 53.4% | 0.46 | 46.0% | 0.40 |

PASCAL VOC と ADE20K のベンチマーク結果。 ImageNet-22K で事前トレーニングされた Swin-L モデルを使用して 9 つの PETL アルゴリズムを評価します。

チェックポイントを取得するには、Coming Soon からダウンロードしてください。

| スウィンL | パラムス。 | メモリー(VOC) | パスカル VOC ( | パスカル VOC (PPT) | ADE20K ( | ADE20K (PPT) |

|---|---|---|---|---|---|---|

| 完全な微調整 | 198.58メートル | 15679MB | 83.5% | - | 52.10% | - |

| 凍った | 0.00M | 3967MB | 83.6% | 0.84 | 46.84% | 0.47 |

| ビットフィット | 0.30メートル | 10861MB | 85.7% | 0.85 | 48.37% | 0.48 |

| LNチューン | 0.09M | 10123MB | 85.8% | 0.86 | 47.98% | 0.48 |

| 部分-1 | 28.34メートル | 3943MB | 85.4% | 0.48 | 47.44% | 0.27 |

| アダプタ | 4.66メートル | 10793MB | 87.1% | 0.74 | 50.78% | 0.43 |

| LoRA | 4.57メートル | 10127MB | 87.5% | 0.74 | 50.34% | 0.43 |

| アダプトフォーマー | 4.66メートル | 11036MB | 87.3% | 0.74 | 50.83% | 0.43 |

| ロランド | 1.31メートル | 11572MB | 86.8% | 0.82 | 50.76% | 0.48 |

| E$^3$VA | 1.79メートル | 4819MB | 86.5% | 0.81 | 49.64% | 0.46 |

| モナ | 5.08メートル | 11958MB | 87.3% | 0.73 | 51.36% | 0.43 |

V-PETL Bench コミュニティは以下によって維持されています。

Yi Xin ([email protected])、南京大学。

Siqi Luo ([email protected])、上海交通大学。

私たちの調査とリポジトリがあなたの研究に役立つと思われる場合は、以下に引用してください。

@article{xin2024bench、title={V-PETL ベンチ: 統一されたビジュアル パラメーター効率的な転移学習ベンチマーク}、author={Yi Xin、Siqi Luo、Xuyang Liu、Haodi Zhou、Xinyu Cheng、Christina Luoluo Lee、Junlong Du、Yuntao Du.、Haozhe Wang、MingCai Chen、Ting Liu、Guimin Hu、Zhongwei Wan、Rongchao Zhang、Aoxue Li、Mingyang Yi、Xiaohong Liu}、year={2024}}